打乱/跳过Transformer层会怎样?最新研究揭开其信息流动机制,一口气解答8大问题

打乱/跳过Transformer层会怎样?最新研究揭开其信息流动机制,一口气解答8大问题Transformer中的信息流动机制,被最新研究揭开了:

Transformer中的信息流动机制,被最新研究揭开了:

9次迭代后,模型开始出现诡异乱码,直接原地崩溃!就在今天,牛津、剑桥等机构的一篇论文登上了Nature封面,称合成数据就像近亲繁殖,效果无异于投毒。有无破解之法?那就是——更多使用人类数据!

本文介绍清华大学的一篇关于长尾视觉识别的论文: Probabilistic Contrastive Learning for Long-Tailed Visual Recognition. 该工作已被 TPAMI 2024 录用,代码已开源。

OpenAI 的新奖励机制,让大模型更听话了。

就在去年,由斯坦福大学和谷歌的研究团队开发的“AI小镇”一举引爆了人工智能社区,成为各大媒体争相报道的热点。他们让多个基于大语言模型(LLMs)的智能体扮演不同的身份和角色在虚拟小镇上工作和生活,将《西部世界》中的科幻场景照进了现实中。

训练数据是用 GPT-4o 生成的?那质量不好说了。

为何会发生?可以避免吗?

以GPT-4o为代表的多模态大语言模型(MLLMs)因其在语言、图像等多种模态上的卓越表现而备受瞩目。它们不仅在日常工作中成为用户的得力助手,还逐渐渗透到自动驾驶、医学诊断等各大应用领域,掀起了一场技术革命。

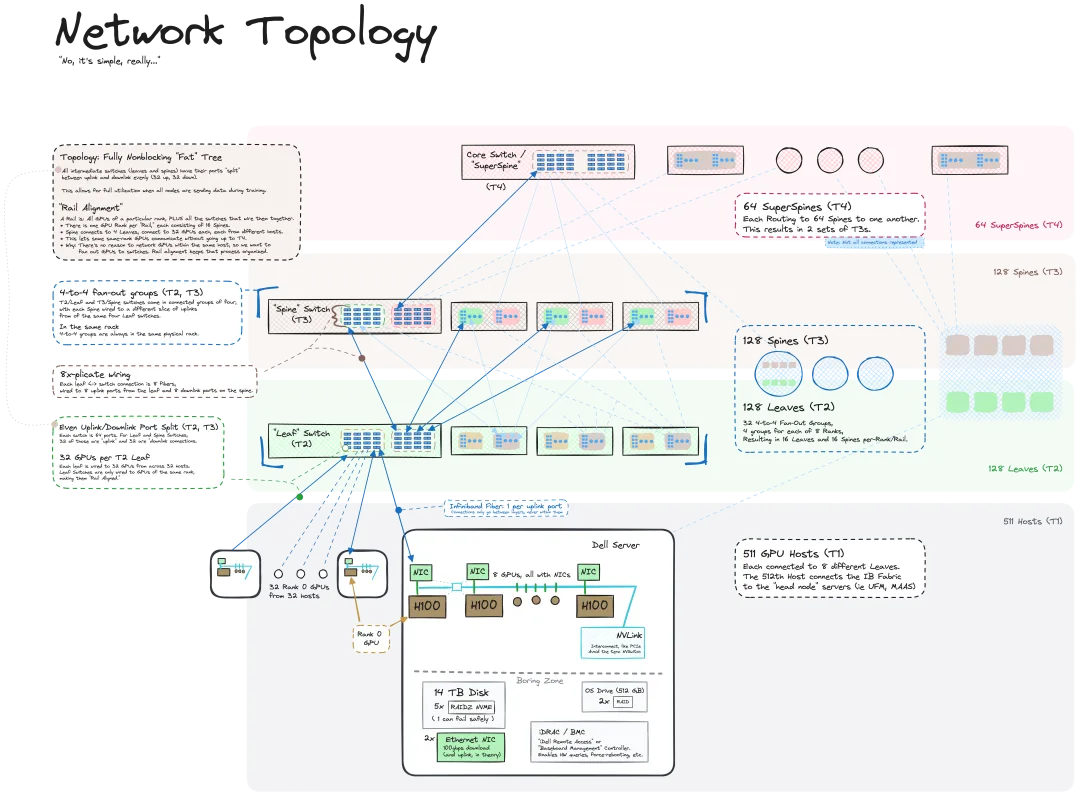

我们知道 LLM 是在大规模计算机集群上使用海量数据训练得到的,机器之心曾介绍过不少用于辅助和改进 LLM 训练流程的方法和技术。而今天,我们要分享的是一篇深入技术底层的文章,介绍如何将一堆连操作系统也没有的「裸机」变成用于训练 LLM 的计算机集群。

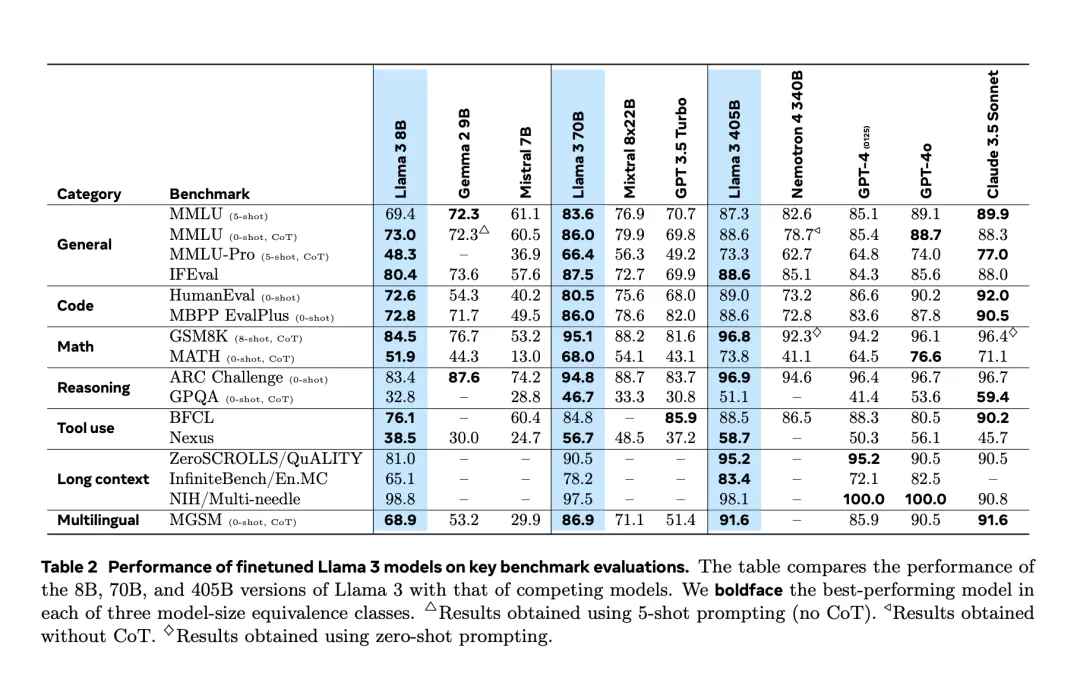

经历了提前两天的「意外泄露」之后,Llama 3.1 终于在昨夜由官方正式发布了。