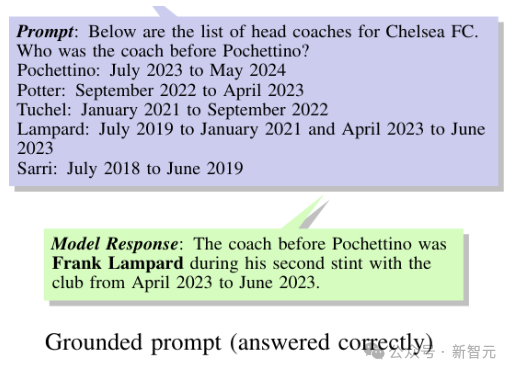

院士领衔推出大模型的第3种记忆:比参数存储和RAG都便宜,2.4B模型越级打13B

院士领衔推出大模型的第3种记忆:比参数存储和RAG都便宜,2.4B模型越级打13B给大模型加上第三种记忆格式,把宝贵的参数从死记硬背知识中解放出来!

给大模型加上第三种记忆格式,把宝贵的参数从死记硬背知识中解放出来!

大模型产业发展,需要可信中立的数据深加工平台,如何填补空白?

在训练大型语言模型(LLM)时,Adam(W) 基本上已经成为了人们默认使用的优化器。

一转眼,2024 年已经过半。我们不难发现,AI 尤其是 AIGC 领域出现一个越来越明显的趋势:文生图赛道进入到了稳步推进、加速商业落地的阶段,但同时仅生成静态图像已经无法满足人们对生成式 AI 能力的期待,对动态视频的创作需求前所未有的高涨。

近日,来自谷歌DeepMind的研究人员,推出了专门用于评估大语言模型时间推理能力的基准测试——Test of Time(ToT),从两个独立的维度分别考察了LLM的时间理解和算术能力。

大模型当上福尔摩斯,学会对视频异常进行检测了。 来自华中科技大学、百度、密歇根大学的研究团队,提出了一种可解释性的视频异常检测框架,名为Holmes-VAD。

苍蝇再小也是肉,聚沙成塔。

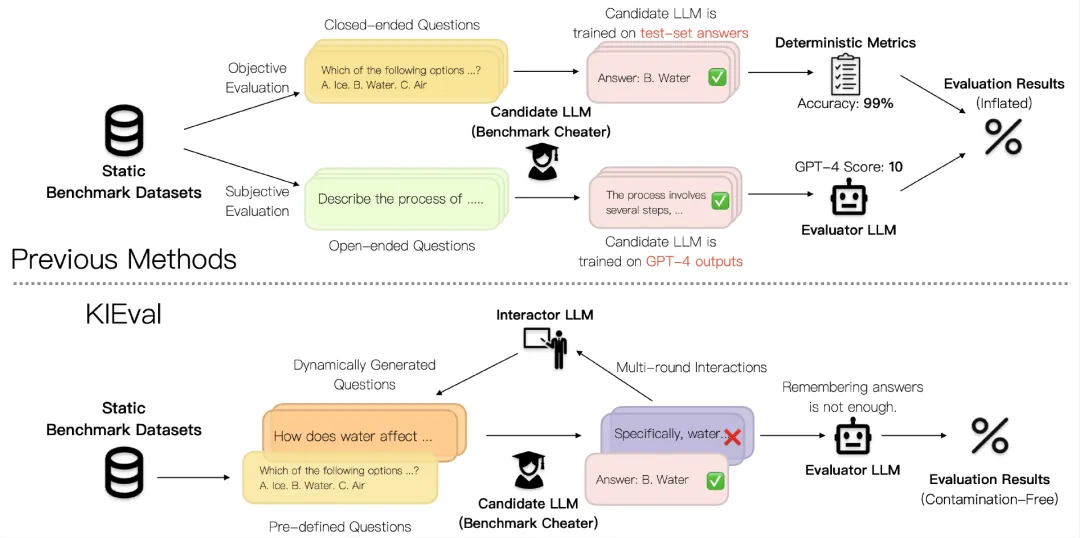

当前大语言模型(LLM)的评估方法受到数据污染问题的影响,导致评估结果被高估,无法准确反映模型的真实能力。北京大学等提出的KIEval框架,通过知识基础的交互式评估,克服了数据污染的影响,更全面地评估了模型在知识理解和应用方面的能力。

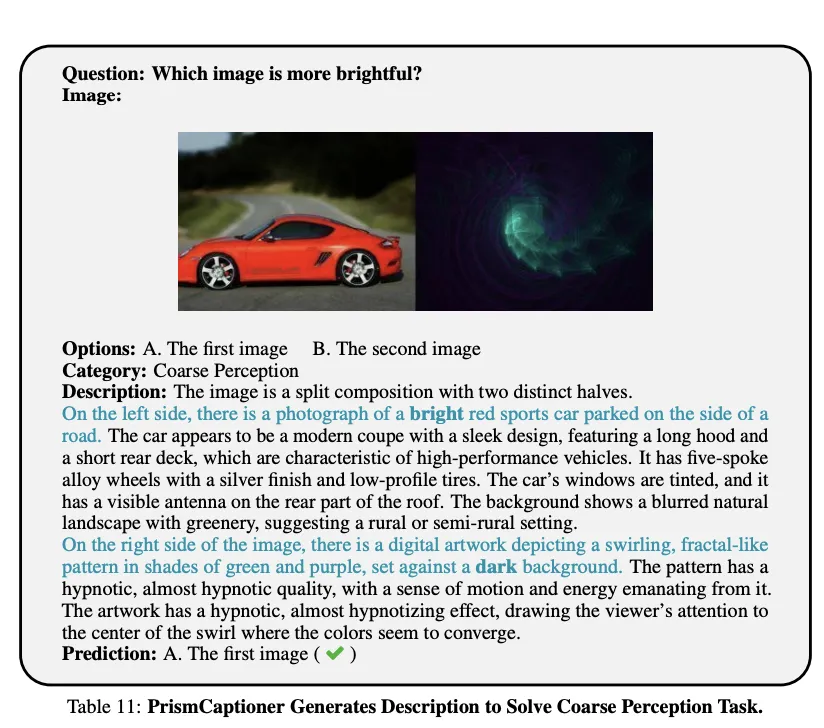

只要把推理和感知能力拆分,2B大模型就能战胜20B?!

神经网络通常由三部分组成:线性层、非线性层(激活函数)和标准化层。线性层是网络参数的主要存在位置,非线性层提升神经网络的表达能力,而标准化层(Normalization)主要用于稳定和加速神经网络训练,很少有工作研究它们的表达能力,例如,以Batch Normalization为例