一转眼,2024 年已经过半。我们不难发现,AI 尤其是 AIGC 领域出现一个越来越明显的趋势:文生图赛道进入到了稳步推进、加速商业落地的阶段,但同时仅生成静态图像已经无法满足人们对生成式 AI 能力的期待,对动态视频的创作需求前所未有的高涨。

因此,文生视频赛道持续高热,尤其是自年初 OpenAI 发布 Sora 以来,以 Diffusion Transformer(DiT)为底层架构的视频生成模型迎来了井喷期。在这一赛道,国内外视频生成模型厂商们正默默展开着一场技术竞速。

在国内,一家成立于去年 3 月、专注于构建视觉多模态基础模型及应用的生成式 AI 初创公司不断出现在人们的视野中。它就是智象未来(HiDream.ai),其自主研发的视觉多模态基础模型实现了不同模态之间的生成转换,支持文生图、文生视频、图生视频和文生 3D,并推出了一站式 AI 图像和视频生成平台「Pixeling 千象」供社会大众上手使用。

体验地址:www.hidreamai.com

自智象大模型 2023 年 8 月上线以来,期间历经数次迭代与打磨,通过优化基础模型来深挖、拓展文生图和文生视频等 AIGC 能力。尤其是在视频生成领域,支持的生成时长从最开始的 4 秒增加到了 15 秒,成像效果也肉眼可见地更优。

如今,智象大模型再次迎来升级,基于中文原生的独有 DiT 架构释放出更强大、更稳定、对用户更友好的图像和视频生成能力,包括更具美感和艺术性的图像生成、图像中文字嵌入、分钟级视频生成等。

所有这些图像和视频生成新技能的展示,离不开智象未来在多模态视觉生成领域的技术积累和持续创新。

生成效果持续提升

更强大基模能力是引擎

智象大模型从一开始便瞄准了文本、图像、视频、3D 的联合建模,通过交互式生成技术实现精准可控的多模态内容生成,构筑强大的基模能力,让用户在其文生图、文生视频 AIGC 平台中有更好的创作体验。

此次智象大模型 2.0 的整体升级,相较于 1.0 版本在底层架构、训练数据和训练策略上均有质的变化,由此带来了文本、图像、视频和 3D 多模能力的又一次飞跃和交互体验上的切实提升。

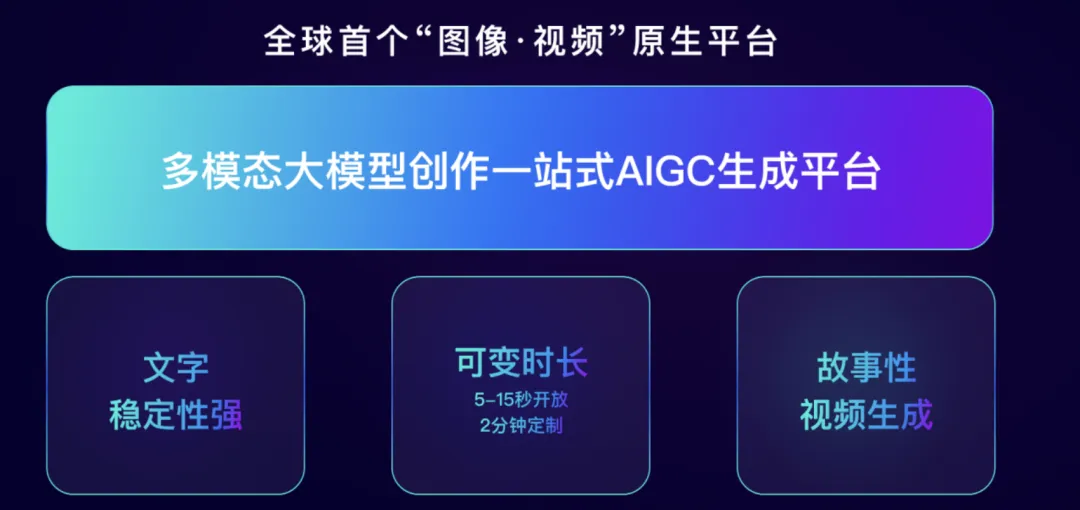

可以说,升级后的智象大模型在图像、视频生成领域迎来了全方位加强,并为多模态大模型创作一站式 AIGC 生成平台注入了更加强劲的驱动力。

文生图技能再进化

有了更高层次的「追求」

作为 AIGC 的一站式生成平台,文生图是文生视频的前提和重要的技术壁垒。因此智象未来在文生图方向上寄予了很高的预期,以自己的节奏推进更多样性功能、更逼真视觉效果以及更友好用户体验。

经过了一系列针对性调整和优化,智象大模型 2.0 文生图能力相较以往版本显著改进,并从多个外在呈现效果上很容易看出来。

首先,智象大模型 2.0 生成的图像更有美感、更具艺术性。当前的文生图大模型在语义理解、生成图像结构和画面细节等较为直观的方面可以做得很好,但在质感、美感、艺术性等偏感官方面可能无法让人满意。因此,追求美感成为了此次文生图升级的重点。究竟效果如何呢?我们可以来看下面两个示例。

第一个示例输入的 Prompt 为「一个戴着巨大帽子的小女孩,帽子上有很多城堡,花草树木,鸟类,五颜六色,特写,细节,插画风格」。

第二个示例输入的 Prompt 为「绿色植物叶子特写照片,深色主题,水滴细节,移动壁纸」。

生成的两张图像,无论是构图色调,还是细节丰富度,看上去都有一种让人眼前一亮的感觉,这些都极大地拉升了整体画面美感。

除了让生成的图像看上去更美之外,生成图像的相关性也更强。这也是图像生成发展到一定阶段后,大家非常关注的一个方面。

为了提升生成图像的相关性,智象大模型重点强化了对一些复杂逻辑的理解,比如不同的空间布局、位置关系、不同类型的物体、生成物体的数量等,这些都是实现更高相关性的重要因素。一番调教下来,智象大模型可以轻松搞定包含多物体、多位置分布、复杂空间逻辑的图像生成任务,更好地满足现实生活中用户的实际需求。

我们来看下面三个需要对不同物体、空间位置关系进行深刻理解的生成示例。结果表明,对于包含复杂逻辑的长短文本 Prompt,文生图现在都能轻松搞定。

第一个示例输入的 Prompt 为「厨房桌子上有三个装满水果的篮子。中间的篮子里装满了青苹果。左边的篮子里装满了草莓。右边的篮子里满是蓝莓。篮子后面是一只白色狗。背景是一面青绿色的墙壁,上面有彩色的文字 "Pixeling v2"」。

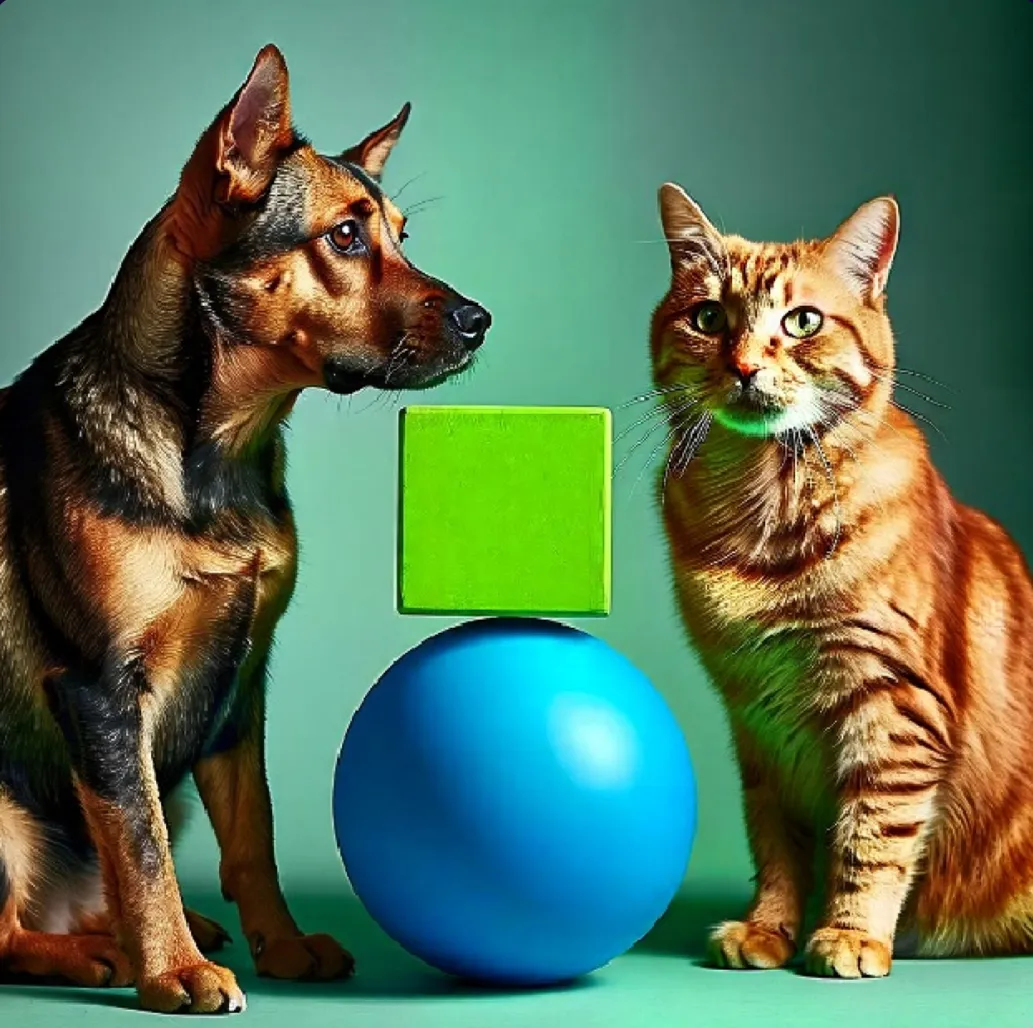

第二个示例输入的 Prompt 为「右边是一只猫,左边是一只狗,中间是一个绿色的立方体放在一个蓝色的球上」。

第三个示例输入的 Prompt 为「在月球上,一名宇航员骑着一头牛,穿着粉色芭蕾裙,手拿着蓝色伞。牛的右边是一只戴着高顶帽的企鹅。底部写着文字 “HiDream.Al”」。

同时,图像中嵌入文字的生成更加准确、高效,这一海报或营销文案中使用比较多的功能得到加强。

在技术实现上,生成图像中嵌入文字需要大模型深刻理解输入的 Prompt 中视觉外观描述和精准文字内容,从而在保证图像整体美感和艺术性的同时实现对文字内容的精准刻画。

在接受机器之心的专访时,智象未来 CTO 姚霆博士提到,对于此类任务,以往版本很多时候无法生成,即便能生成也存在问题,在生成的字符或者准确性上都有欠缺。现在这些问题得到了很好地解决,智象大模型实现了图像中长文本的嵌入生成,最多可以做到几十个单词。

下面从左到右三个生成示例展示出了很好的文字嵌入效果,尤其是图右准确无误地嵌入了二十几个单词及标点符号。

可以说,此次智象大模型的文生图功能在行业中实现了行业引领的效果,为视频生成打下了关键的牟定基础。

视频生成迈入分钟级

如果说升级后的智象大模型 2.0 在文生图方向做到了稳扎稳打,那么在文生视频方向则迎来了跨越式突破。

去年 12 月,智象大模型的文生视频打破了 4 秒时长限制,做到了支持 15 秒钟以上的生成时长。半年过去了,文生视频在时长、画面自然度、内容和角色一致性上均有显著提升,而这要归功于其自研了一套成熟的 DiT 架构。

相较于 U-Net,DiT 架构灵活度更高,且能增强图像、视频的生成质量。Sora 的出现更直观地验证了这一点,采用此类架构的扩散模型表现出了天然生成高质量图像和视频的倾向,并在可定制化、生成内容可控性方面具有相对优势。对于智象大模型 2.0 而言,其采用的 DiT 架构又有一些独特的地方。

我们知道,DiT 架构的底层实现都是基于 Transformer,智象大模型 2.0 在整个 Transformer 网络结构、训练数据的构成和训练策略上采用完全自研的模块,尤其在网络训练策略上下足了功夫。

首先,Transformer 网络结构采用了高效的时空联合注意力机制,不仅契合了视频兼具空间域和时间域的特征,而且解决了传统注意力机制在实际训练过程中速度跟不上的难题。

其次,AI 视频任务中的长镜头生成对训练数据的来源、筛选提出了更高要求。因此,智象大模型最多支持几分钟甚至十几分钟视频片段的训练,这样一来,直接输出分钟级时长的视频有了可能。同时,对分钟级视频内容的描述也是比较困难的事情,智象未来自研了视频描述生成的 Captioning Model,实现了详细且精准的描述输出。

最后在训练策略上,由于长镜头视频数据有限,因此智象大模型 2.0 使用了不同长度的视频片段,进行视频和图片数据的联合训练,并动态地改变不同长度视频的采样率,进而完成长镜头训练,同时在训练时还会根据用户反馈数据进行强化学习以进一步优化模型性能。

也因此,更强大自研 DiT 架构为此次文生视频效果的进一步提升提供了技术支撑。

现在,智象大模型 2.0 支持生成的视频时长从 15 秒左右提升到了分钟级,达到了业界较高水平。

在视频时长迈入分钟级之外,可变时长和尺寸也是此次文生视频功能升级的一大看点。

当前视频生成模型通常是固定生成时长,用户无法选择。智象未来将生成时长的选择权开放给了用户,既可以让他们指定时长,也能够根据输入的 Prompt 内容进行动态判断。如果比较复杂则生成较长视频,比较简单则生成较短视频,通过这样一个动态过程来自适应地满足用户的创作需求。生成视频的尺寸也可以按需定制,对用户使用非常友好。

此外,整体画面观感变得更好,生成视频中物体的动作或运动更加自然流畅,细节渲染更加到位,并支持了 4K 超清画质。

短短半年时间,与以往版本相比,升级后的文生视频功能用「脱胎换骨」来形容也不为过。不过在姚霆博士看来,当前无论是智象未来还是其他同行,视频生成大部分仍处于单镜头阶段。如果对标自动驾驶领域的 L1 到 L5 阶段,文生视频大致处于 L2 阶段。此次借助基模能力的升级,智象未来想要追求更高质量的多镜头视频生成,也迈出了探索 L3 阶段的关键一步。

智象未来表示,迭代后的文生视频功能将在 7 月中旬上线使用。大家可以狠狠地期待一波了!

写在最后

成立不到一年半的时间,无论是基础模型能力的持续迭代,还是文生图、文生视频实际体验的提升,智象未来在视觉多模态生成这一方向上走得既稳又快,并收获了大量 C 端和 B 端用户。

我们了解到,智象未来 C 端用户单月访问量超过了百万,生成 AI 图像和视频的总数量也超过千万。低门槛、好应用构成了智象大模型的特质,并基于它打造了最适合社会大众使用的首款 AIGC 应用平台。

在 B 端,智象未来积极与中国移动、联想集团、科大讯飞、上影集团、慈文集团、神州数码、央视网、印象笔记、天工异彩、杭州灵伴等企业达成战略合作协议,深化模型应用场景,将模型能力延展到包括运营商、智能终端、影视制作、电子商务、文旅宣传和品牌营销在内的更多行业,最终在商业化落地过程中发挥模型潜能并创造价值。

目前,智象大模型拥有大约 100 家头部企业客户,并为 30000 + 小微企业客户提供了 AIGC 服务。

在智象大模型 2.0 发布之前,智象未来已经联合中国移动咪咕集团推出了国民级 AIGC 应用「AI 一语成片」,不仅为普通用户提供零基础 AI 视频彩铃创作功能,还助力企业客户生成丰富的品牌及营销视频内容,让企业拥有属于自己的彩铃品牌,让我们看到了视频生成融合行业场景的巨大潜力。

此外,AI 生态也是大模型厂商发力的重要阵地。在这方面,智象未来持开放的态度,联合联想集团、科大讯飞、神州数码等大客户、小型开发团队和独立开发者共建包括视频生成在内的广泛 AI 生态,覆盖用户的更多元化需求。

2024 年被视为大模型应用落地元年,对所有厂商来说都是关键的发展节点。智象未来正在围绕更强大的基模能力做深文章。

一方面,在统一的框架中强化图像、视频、3D 多模态的理解与生成能力,比如在视频生成领域继续优化底层架构、算法、数据以求得时长、质量上的更大突破,成为推动未来通用人工智能的不可或缺的一部分;另一方面在用户体验、创新应用、行业生态等多个方向发力,扩大自身的行业影响力。

抢占视频生成赛道的高地,智象未来已经做好了充足准备。

文章来源于“机器之心”,作者“杜伟”