「连续数值分布式表征」加持,浙大UIUC让语言模型擅长表格预测 | ICLR 2024 Spotlight

「连续数值分布式表征」加持,浙大UIUC让语言模型擅长表格预测 | ICLR 2024 Spotlight来自浙江大学和伊利诺伊大学厄巴纳-香槟分校的研究者发表了他们关于「表格语言模型」(Tabular Language Model)的研究成果

来自浙江大学和伊利诺伊大学厄巴纳-香槟分校的研究者发表了他们关于「表格语言模型」(Tabular Language Model)的研究成果

人类的教育方式,对大模型而言也很适用。

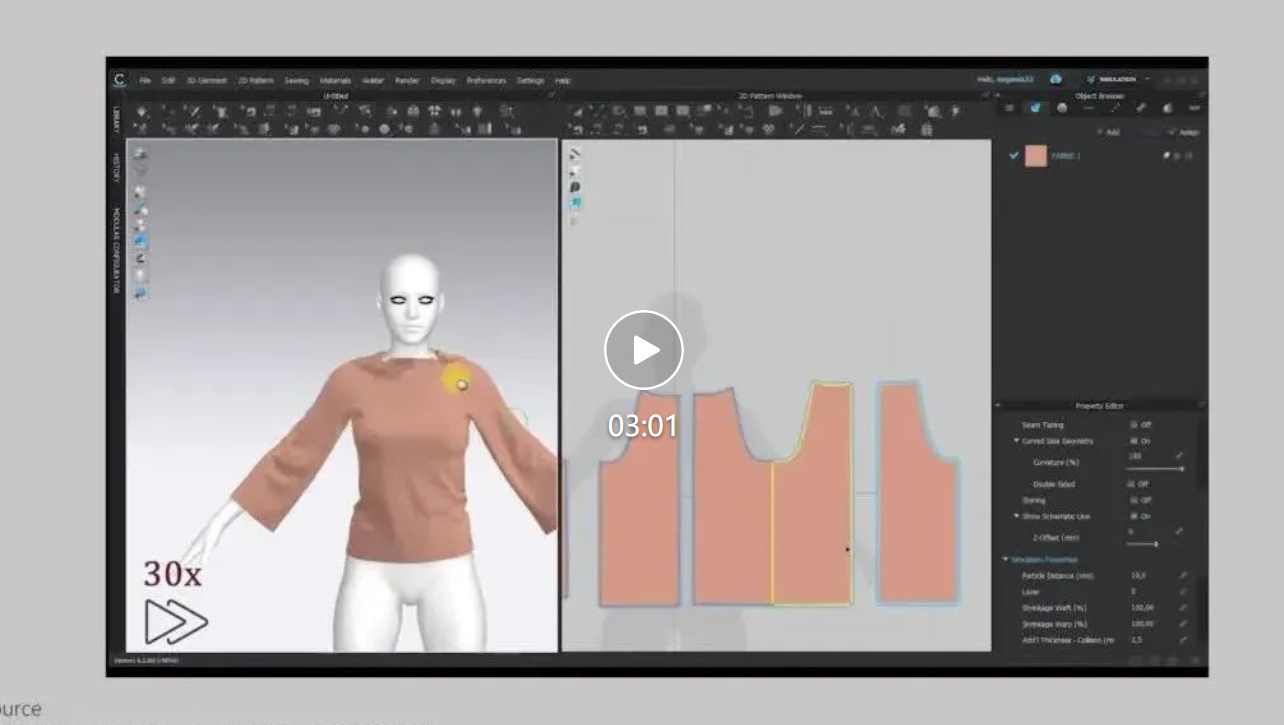

3D生成是生成式人工智能和计算机图形学领域最引人注目的话题之一,符合影视、游戏标准的3D生成尤其受产业界关注。在生产流程中,一般品类的3D资产往往通过手工建模或者扫描的方式制作。但作为3D资产的一个重要类别,服装资产的往往来源于平面板片与物理模拟等流程,而不是直接在3D上建模。

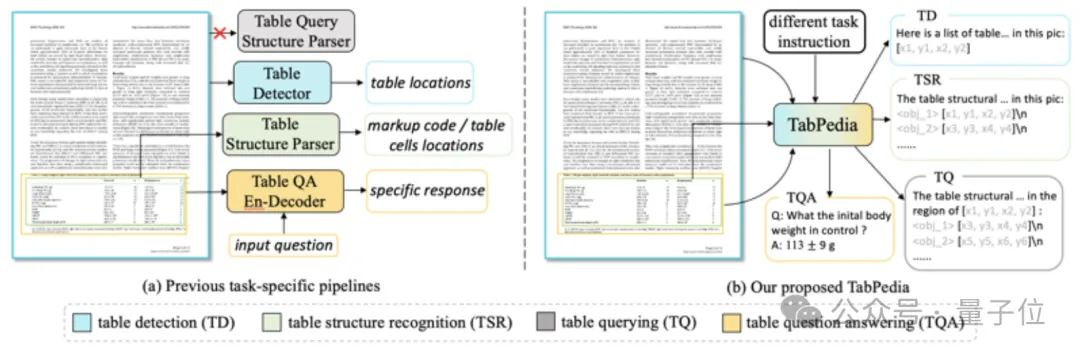

只要一个大模型,就能解决打工人遇到的表格难题!

在CV、ML等领域经常用到的神经场网格模型,如今有了理论框架描述其训练动力学和泛化性能。

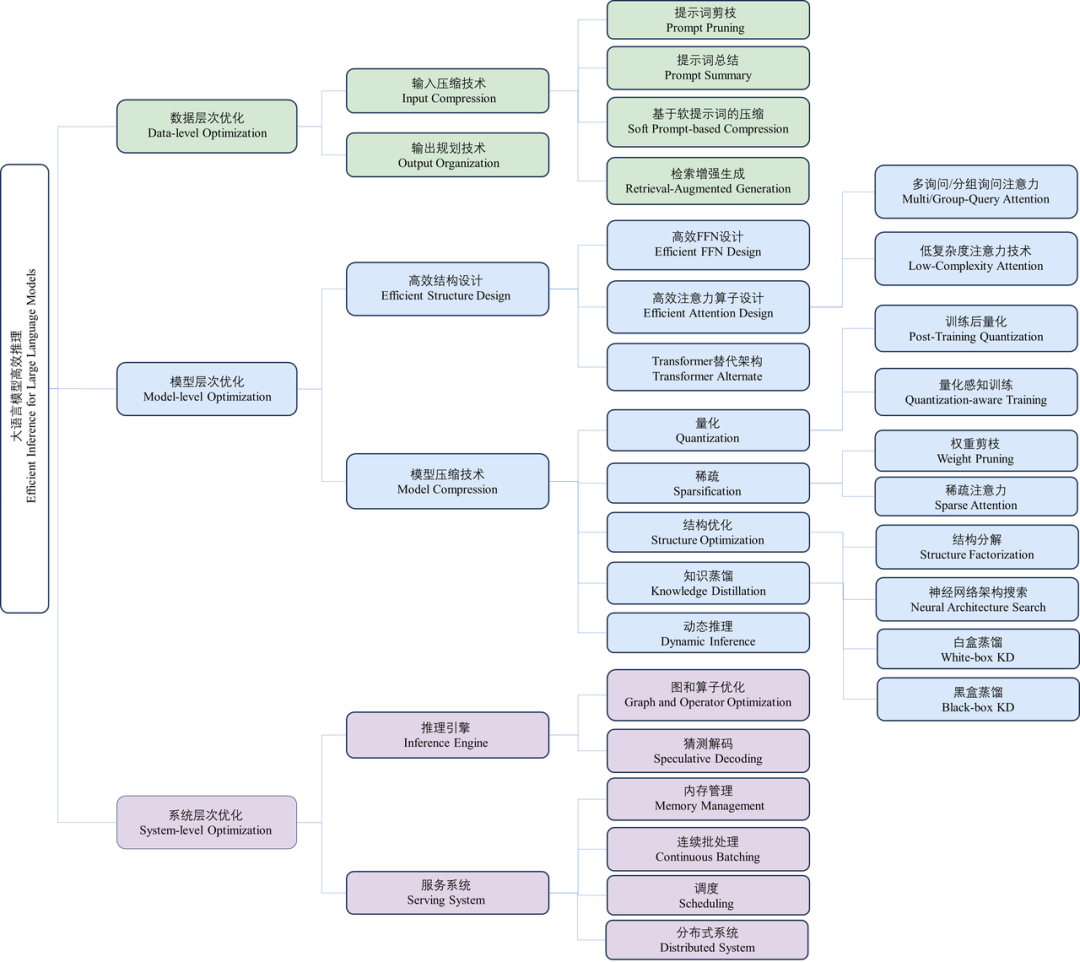

近年来,大语言模型(Large Language Models, LLMs)受到学术界和工业界的广泛关注,得益于其在各种语言生成任务上的出色表现,大语言模型推动了各种人工智能应用(例如ChatGPT、Copilot等)的发展。然而,大语言模型的落地应用受到其较大的推理开销的限制,对部署资源、用户体验、经济成本都带来了巨大挑战。

用KV缓存加速大模型的显存瓶颈,终于迎来突破。 北大、威斯康辛-麦迪逊、微软等联合团队提出了全新的缓存分配方案,只用2.5%的KV cache,就能保持大模型90%的性能。 这下再也不用担心KV占用的显存容量过高,导致显卡不够用了。

距上次Karpathy AI大课更新之后,又有了1个多月的时间。这次他带了超详细的4小时课程——从零开始实现1.24亿参数规模的GPT-2模型。

Transformer很强,Transformer很好,但Transformer在处理时序数据时存在一定的局限性。

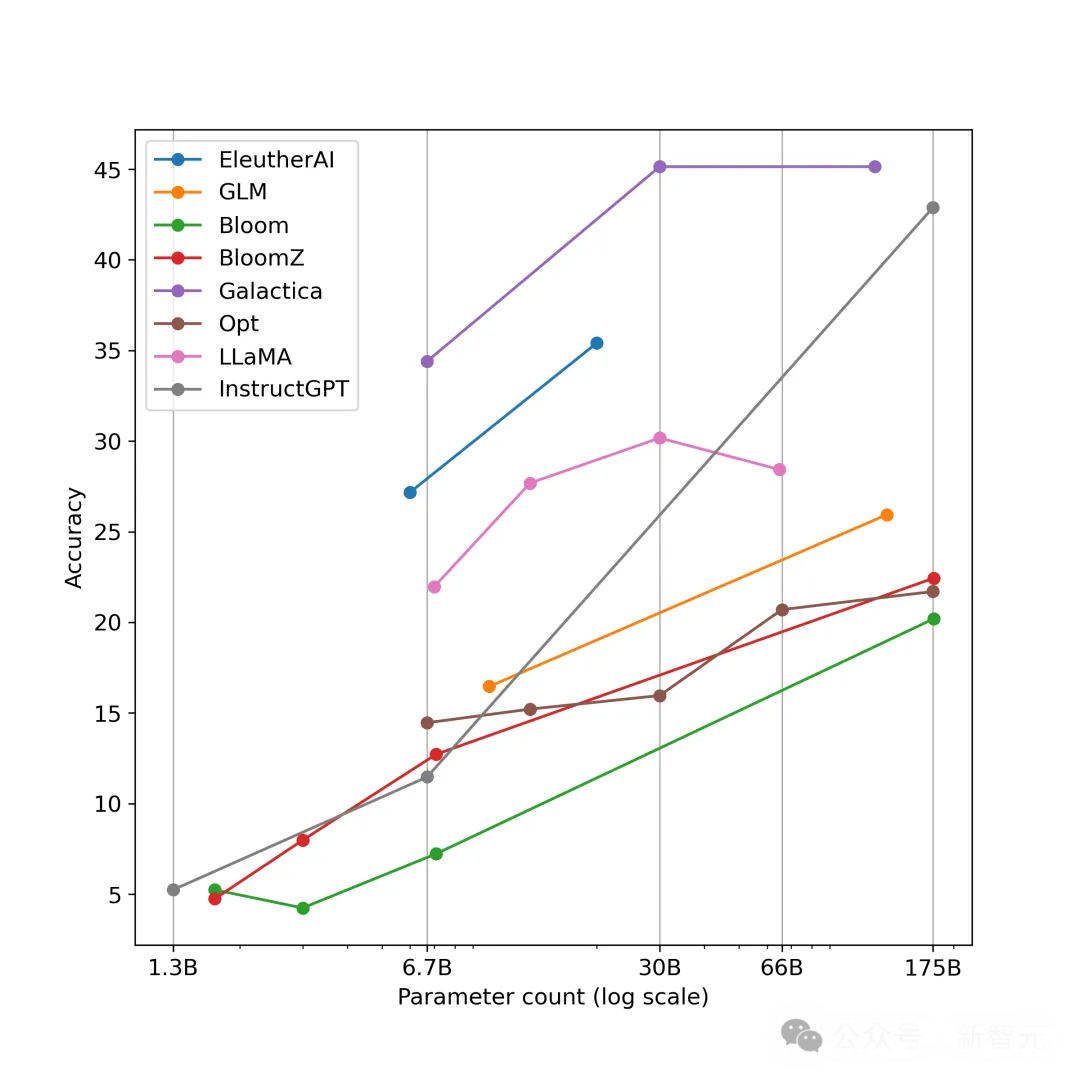

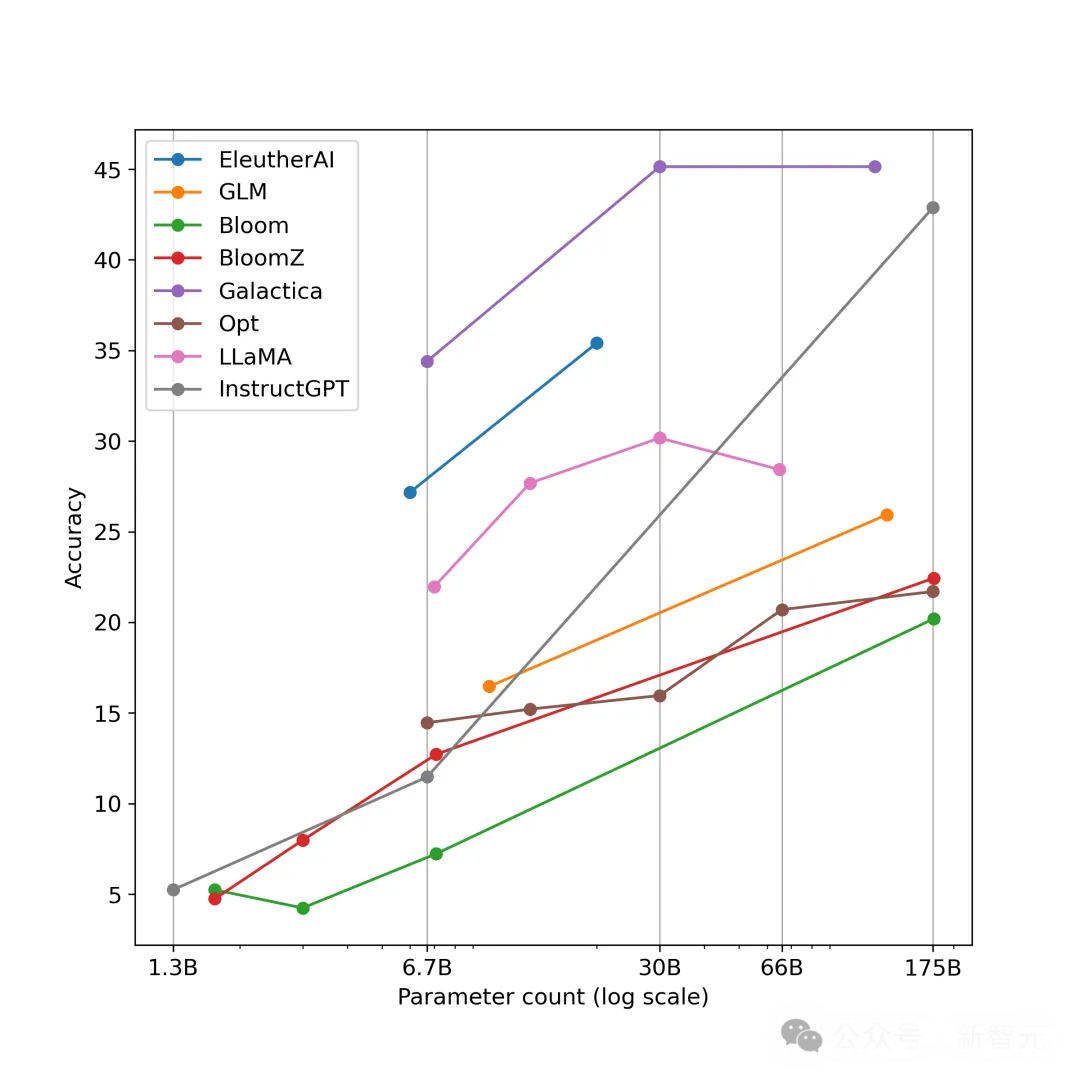

近些年,语言建模领域进展非凡。Llama 或 ChatGPT 等许多大型语言模型(LLM)有能力解决多种不同的任务,它们也正在成为越来越常用的工具。