AI鉴别攻略全废!别数破折号了,97%的人根本分不清

AI鉴别攻略全废!别数破折号了,97%的人根本分不清别再看「鉴AI攻略」了!当AI学会故意写错别字、流露人味,我们的直觉早已全线崩盘。这不只是技术的进化,更是一场关于平庸的生存危机。AI正在拼命演人,而我们却在越活越像机器。

别再看「鉴AI攻略」了!当AI学会故意写错别字、流露人味,我们的直觉早已全线崩盘。这不只是技术的进化,更是一场关于平庸的生存危机。AI正在拼命演人,而我们却在越活越像机器。

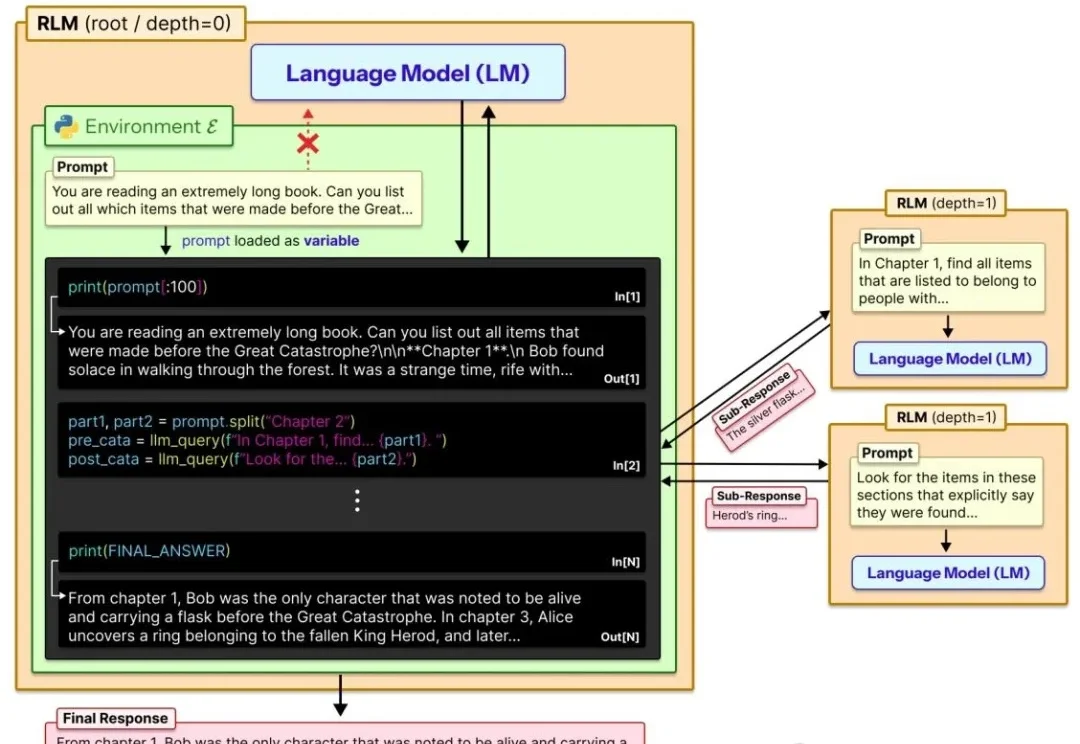

让大模型轻松处理比自身上下文窗口长两个数量级的超长文本!

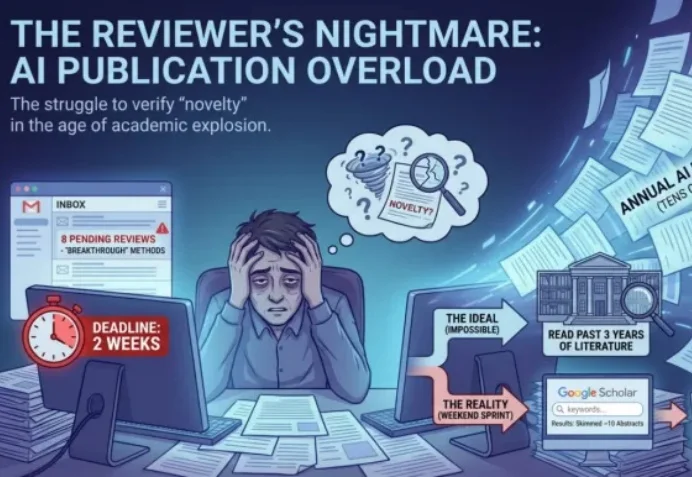

ICLR 2026 的 Rebuttal 结束了。当 OpenReview 上的喧嚣散去,我们发现,作者与审稿人之间漫长的拉锯战,最终往往只剩下一个核心分歧:「这个想法,以前真的没人做过吗?」

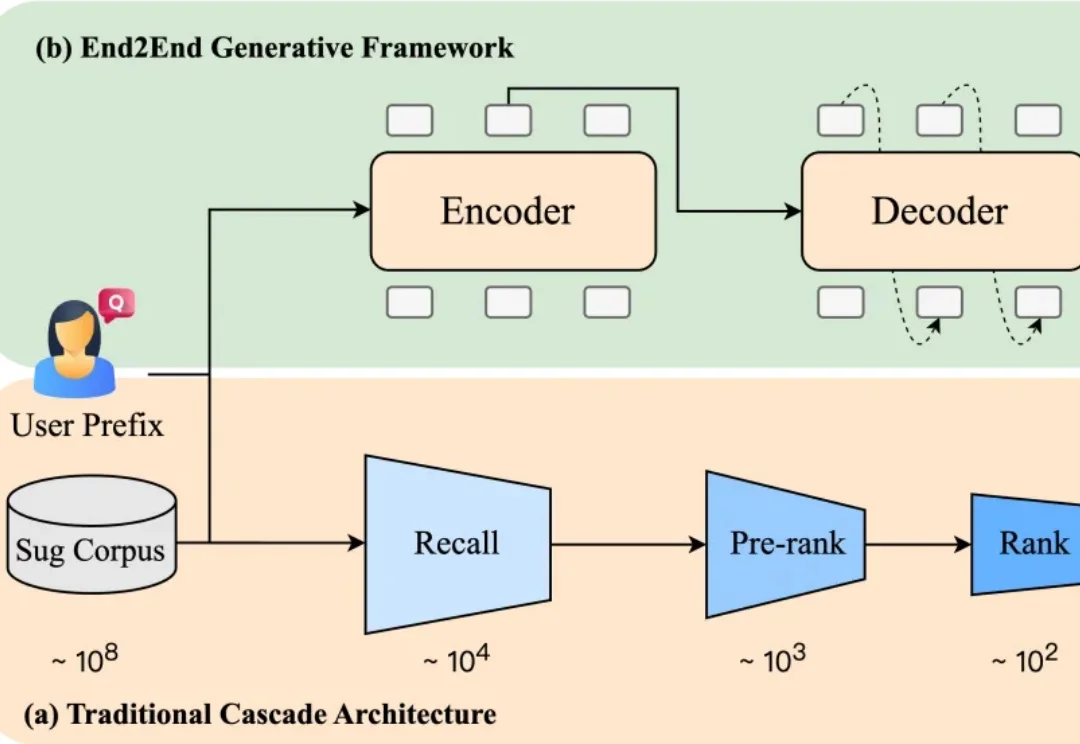

当你在电商平台搜索“苹果”,系统会推荐“水果”还是“手机”?或者直接跳到某个品牌旗舰店?短短一个词,背后承载了完全不同的购买意图。而推荐是否精准,直接影响用户的搜索体验,也影响平台的转化效率。

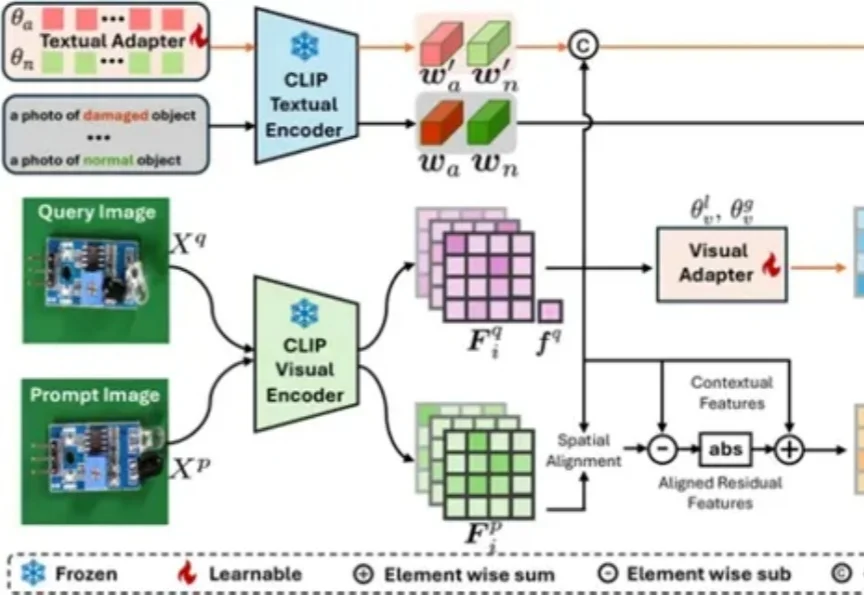

视觉模型用于工业“缺陷检测”等领域已经相对成熟,但当前普遍使用的传统模型在训练时对数据要求较高,需要大量的经过精细标注的数据才能训练出理想效果。

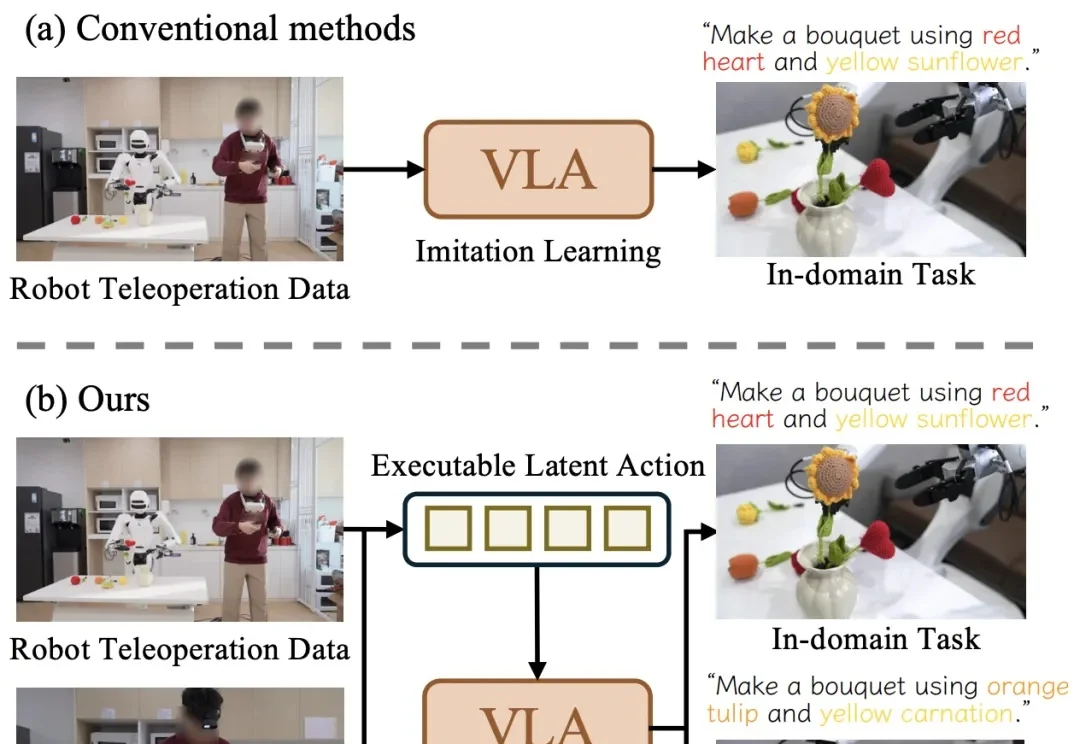

近日,清华大学与星尘智能、港大、MIT 联合提出基于对比学习的隐空间动作预训练(Contrastive Latent Action Pretraining, CLAP)框架。这个框架能够将视频中提纯的运动空间与机器人的动作空间进行对齐,也就是说,机器人能够直接从视频中学习技能!

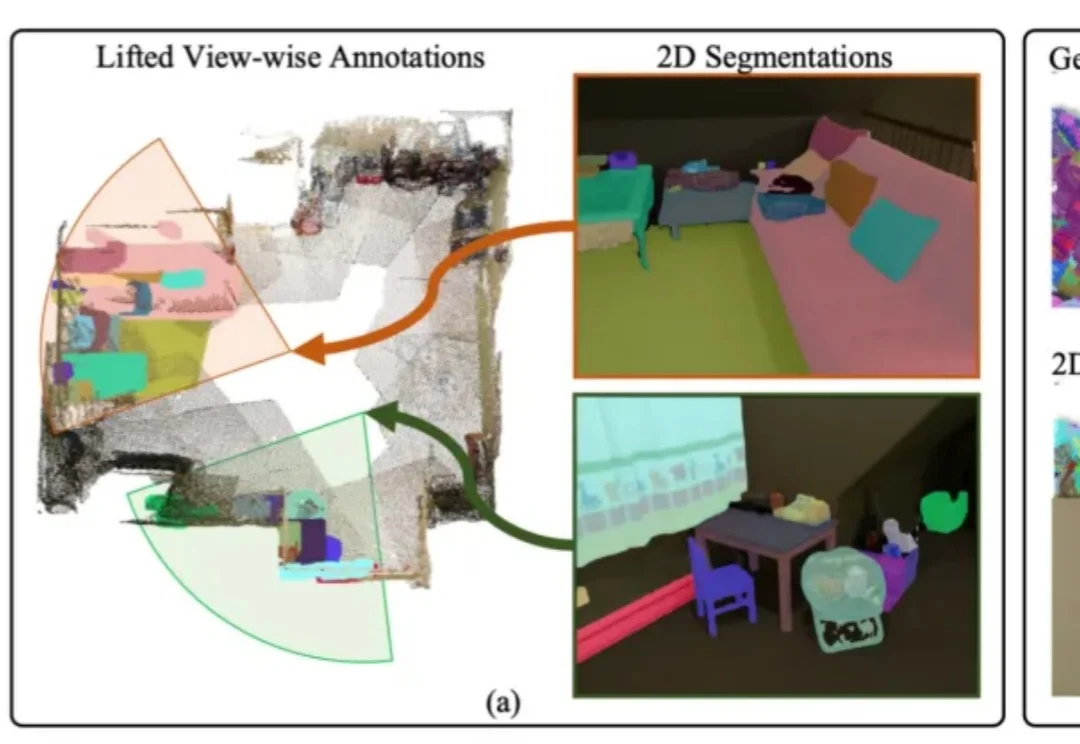

3D模型的实例分割一直受限于稀缺的训练数据与高昂的标注成本,训练效果有待提升。

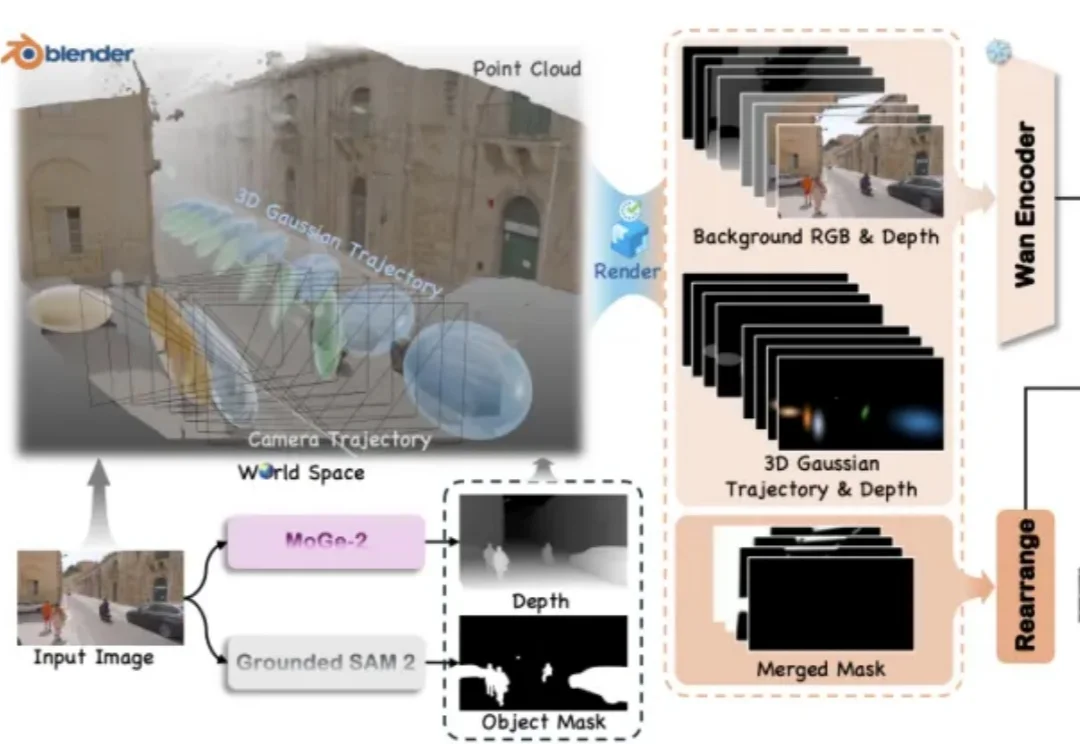

视频世界模型领域又迎来了新的突破!

北邮最新综述探讨了文生图扩散模型的可控生成技术,总结了在文本条件之外引入新条件信号的方法,从任务和方法两个层面梳理了可控生成技术。

随着大模型步入规模化应用深水区,日益高昂的推理成本与延迟已成为掣肘产业落地的核心瓶颈。在 “降本增效” 的行业共识下,从量化、剪枝到模型蒸馏,各类压缩技术竞相涌现,但往往难以兼顾性能损耗与通用性。