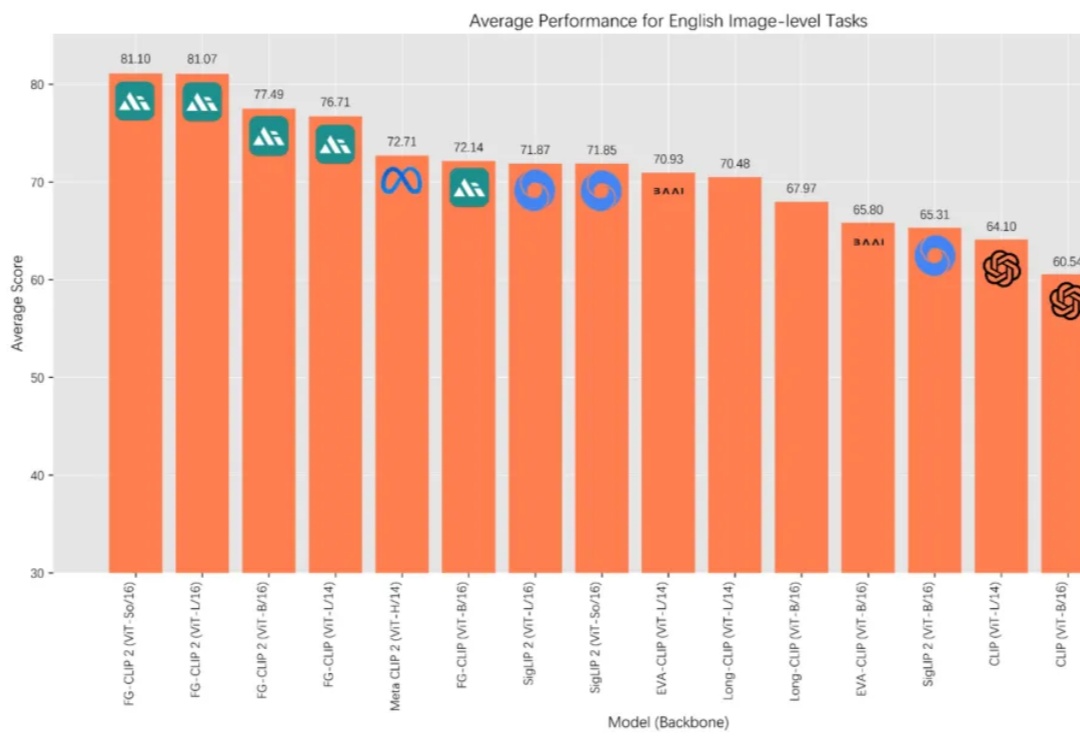

FG-CLIP 2: 为细粒度跨模态理解而生的下一代VLM,8大类29项任务双语性能全球第一

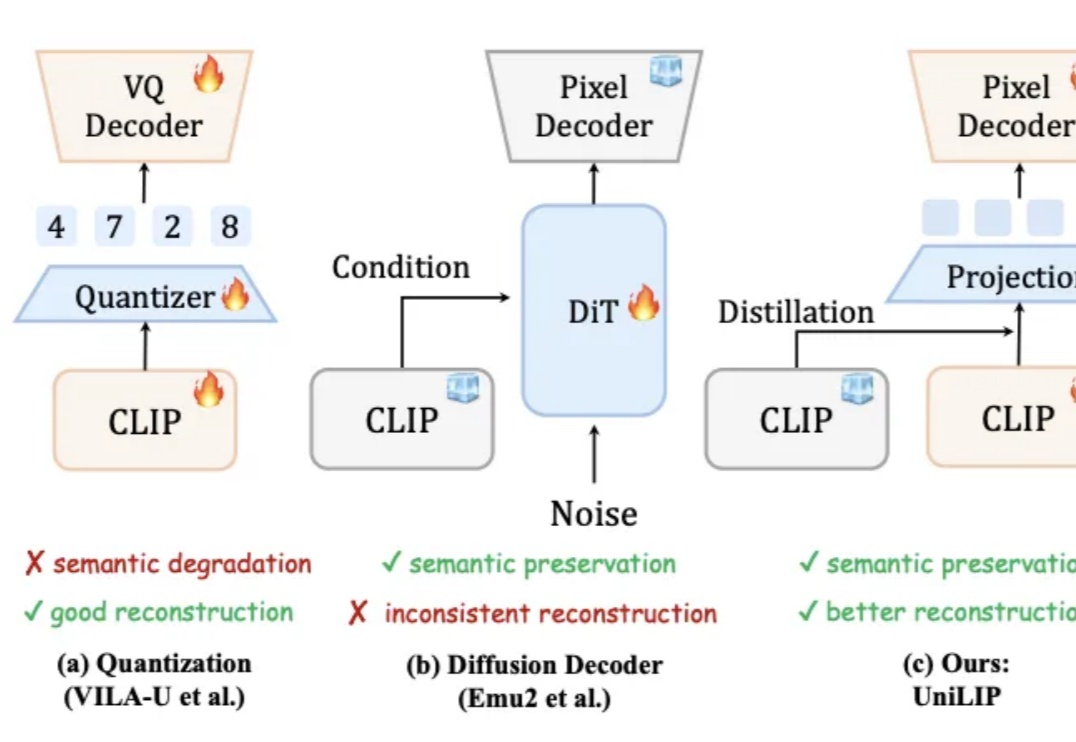

FG-CLIP 2: 为细粒度跨模态理解而生的下一代VLM,8大类29项任务双语性能全球第一在 AI 多模态的发展历程中,OpenAI 的 CLIP 让机器第一次具备了“看懂”图像与文字的能力,为跨模态学习奠定了基础。如今,来自 360 人工智能研究院冷大炜团队的 FG-CLIP 2 正式发布并开源,在中英文双语任务上全面超越 MetaCLIP 2 与 SigLIP 2,并通过新的细粒度对齐范式,补足了第一代模型在细节理解上的不足。