2张4090竟能本地微调万亿参数Kimi K2!趋境联合清华北航把算力门槛击穿了

2张4090竟能本地微调万亿参数Kimi K2!趋境联合清华北航把算力门槛击穿了微调超大参数模型,现在的“打开方式”已经大变样了: 仅需2-4 张消费级显卡(4090),就能在本地对DeepSeek 671B乃至Kimi K2 1TB这样的超大模型进行微调了。

微调超大参数模型,现在的“打开方式”已经大变样了: 仅需2-4 张消费级显卡(4090),就能在本地对DeepSeek 671B乃至Kimi K2 1TB这样的超大模型进行微调了。

当AI不再只是解题机器,而能与人类并肩完成严谨的科研证明,这意味着什么?

在大数据和大模型推动下,微调技术凭借成本低、效率高优势,成为应对小样本、长尾目标等复杂场景的利器。从早期全参数微调到参数高效微调(PEFT),再到如今融合多种PEFT技术的混合微调,遥感微调技术不断进化。清华大学等团队在CVMJ期刊上系统梳理了技术脉络,并指出了九个潜在研究方向,助力遥感技术在农业监测、天气预报等关键领域发挥更大作用。

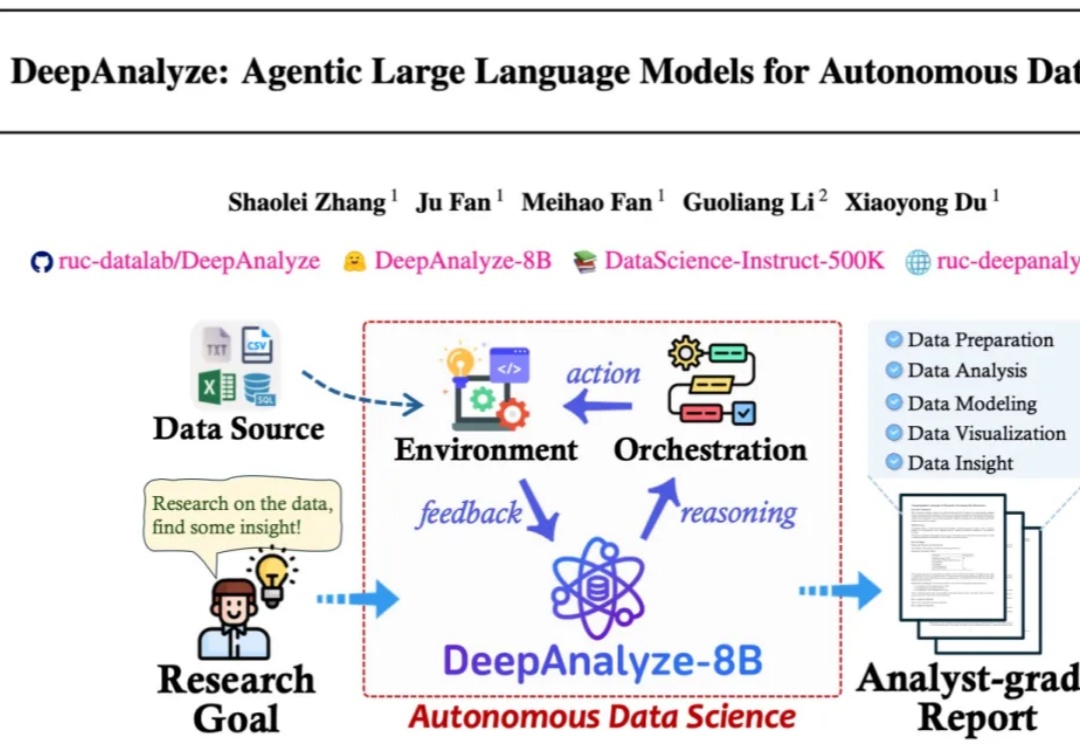

来自人大和清华的研究团队发布了 DeepAnalyze,首个面向自主数据科学的 agentic LLM。DeepAnalyze引起了社区内广泛讨论,一周内收获1000多个GitHub星标、20w余次社交媒体浏览量。

这两天,Physical Intelligence(PI)联合创始人Chelsea Finn在𝕏上,对斯坦福课题组一项最新世界模型工作kuakua连续点赞。

大脑并非一个被动存储和读取的硬盘,而是一个主动预测和生成认知的系统。智力的本质始终在于主动加工,而非被动存储。在AGI时代,我认为“智慧即才华”。就是清楚地知道想要实现的目标,以及实现它的路径,这就是AGI时代的才华。

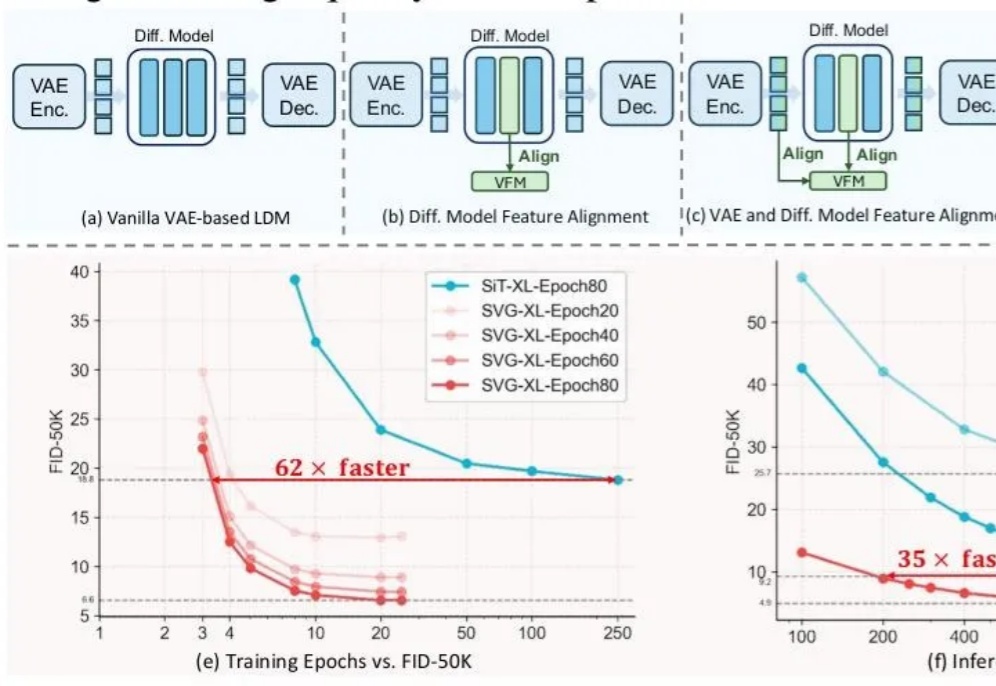

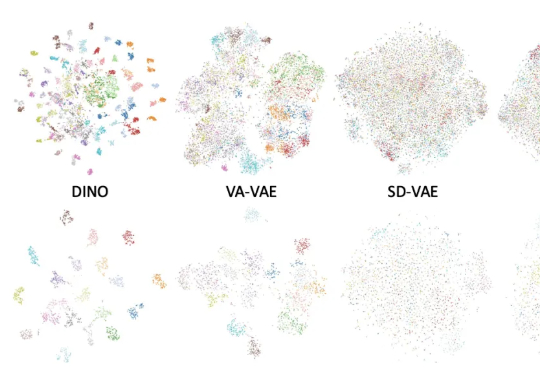

前脚谢赛宁刚宣告VAE在图像生成领域退役,后脚清华与快手可灵团队也带着无VAE潜在扩散模型SVG来了。

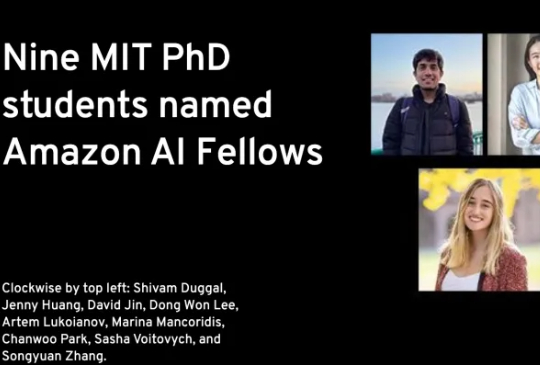

亚马逊AI博士奖学金,正式公布了!两年共计6800万美金,计划将为全球「九所」顶尖大学,100多名博士生提供研究资金的支持。这九所顶尖大学,个个都是AI界的「扛把子」,主要包括:

长期以来,扩散模型的训练通常依赖由变分自编码器(VAE)构建的低维潜空间表示。然而,VAE 的潜空间表征能力有限,难以有效支撑感知理解等核心视觉任务,同时「VAE + Diffusion」的范式在训练

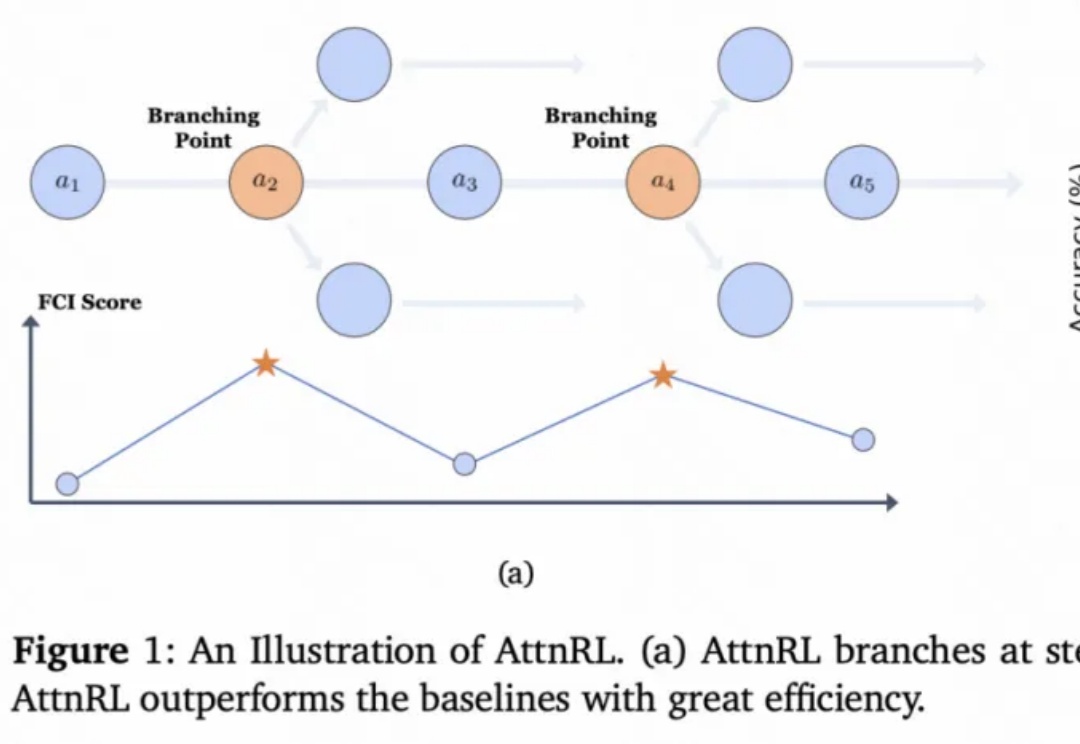

从 AlphaGo 战胜人类棋手,到 GPT 系列展现出惊人的推理与语言能力,强化学习(Reinforcement Learning, RL)一直是让机器「学会思考」的关键驱动力。