打破AI计算生态系统的瓶颈,Foundry获8000万美元新融资

打破AI计算生态系统的瓶颈,Foundry获8000万美元新融资目前,GPU芯片紧缺成为AI行业面临的问题,另一方面,因为传统云服务计算架构与AI计算负载的不匹配,大量GPU计算资源没有被充分利用。

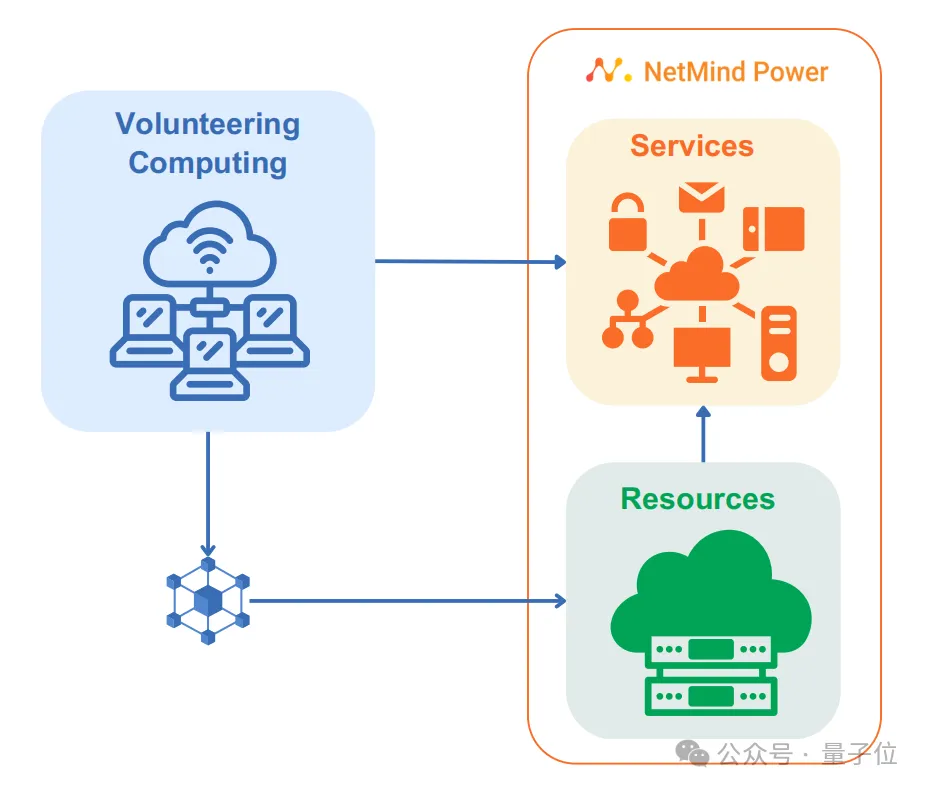

目前,GPU芯片紧缺成为AI行业面临的问题,另一方面,因为传统云服务计算架构与AI计算负载的不匹配,大量GPU计算资源没有被充分利用。

最近,一则数据点出了AI领域算力需求的惊人增长—— 根据业内专家的预估,OpenAI推出的Sora在训练环节大约需要在4200-10500张NVIDIA H100上训练1个月,并且当模型生成到推理环节以后,计算成本还将迅速超过训练环节。

CUDA 是英伟达的壁垒, 推理场景是算力未来的重点

从互联网时代到算力网时代,交换机正在扼住AI咽喉。

不久前,围绕人工智能(AI)发展,特斯拉首席执行官马斯克发出这样的预警

智东西4月11日报道,美国AI三巨头不仅在大模型赛道争奇斗艳,还纷纷卷起自研AI芯片。

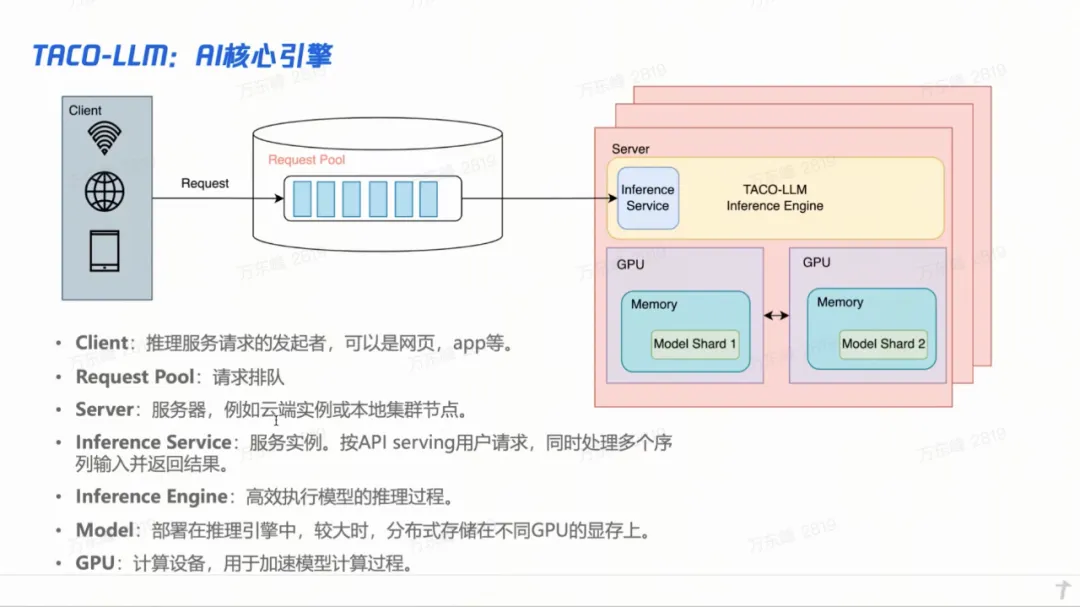

大模型在今年的落地,除了对用 AI 对已有业务进行改造和提效外,算力和推理的优化,可能是另外一项重要的实践了。这在腾讯的两个完全不同的业务上有着明显的体现。

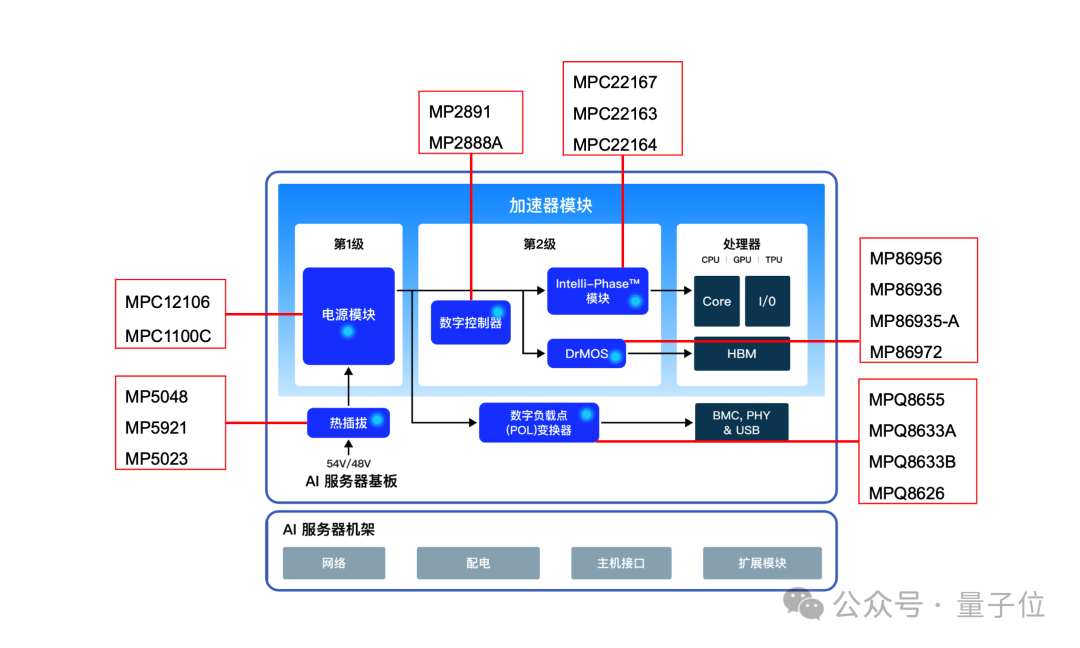

随着AI技术的广泛应用,从智能手机到自动驾驶汽车,从智能家居到工业自动化,AI供电芯片的需求量正呈爆炸式增长。它不仅为AI系统提供稳定的电力供应,确保系统的正常运行,而且还肩负着节能减排、降低能耗的重任。

不降低大模型算法精度,还能把芯片的算力利用效率提升 2~10 倍,这就是编译器的魅力。

产业不信仰AGI(通用人工智能),只信仰降本增收。