Llama 3低比特量化性能下降显著!全面评估结果来了 | 港大&北航Ð

Llama 3低比特量化性能下降显著!全面评估结果来了 | 港大&北航Ð大模型力大砖飞,让LLaMA3演绎出了新高度: 超15T Token数据上的超大规模预训练,既实现了令人印象深刻的性能提升,也因远超Chinchilla推荐量再次引爆开源社区讨论。

大模型力大砖飞,让LLaMA3演绎出了新高度: 超15T Token数据上的超大规模预训练,既实现了令人印象深刻的性能提升,也因远超Chinchilla推荐量再次引爆开源社区讨论。

Anthropic 发现一种新型越狱漏洞并给出了高效的缓解方案,可以将攻击成功率从 61% 降至 2%。

就在刚刚,Anthropic发现了大模型的惊人漏洞。经过256轮对话后,Claude 2逐渐被「灌醉」,开始疯狂越狱,帮人类造出炸弹!谁能想到,它的超长上下文,反而成了软肋。

大模型厂商在上下文长度上卷的不可开交之际,一项最新研究泼来了一盆冷水——Claude背后厂商Anthropic发现,随着窗口长度的不断增加,大模型的“越狱”现象开始死灰复燃。无论是闭源的GPT-4和Claude 2,还是开源的Llama2和Mistral,都未能幸免。

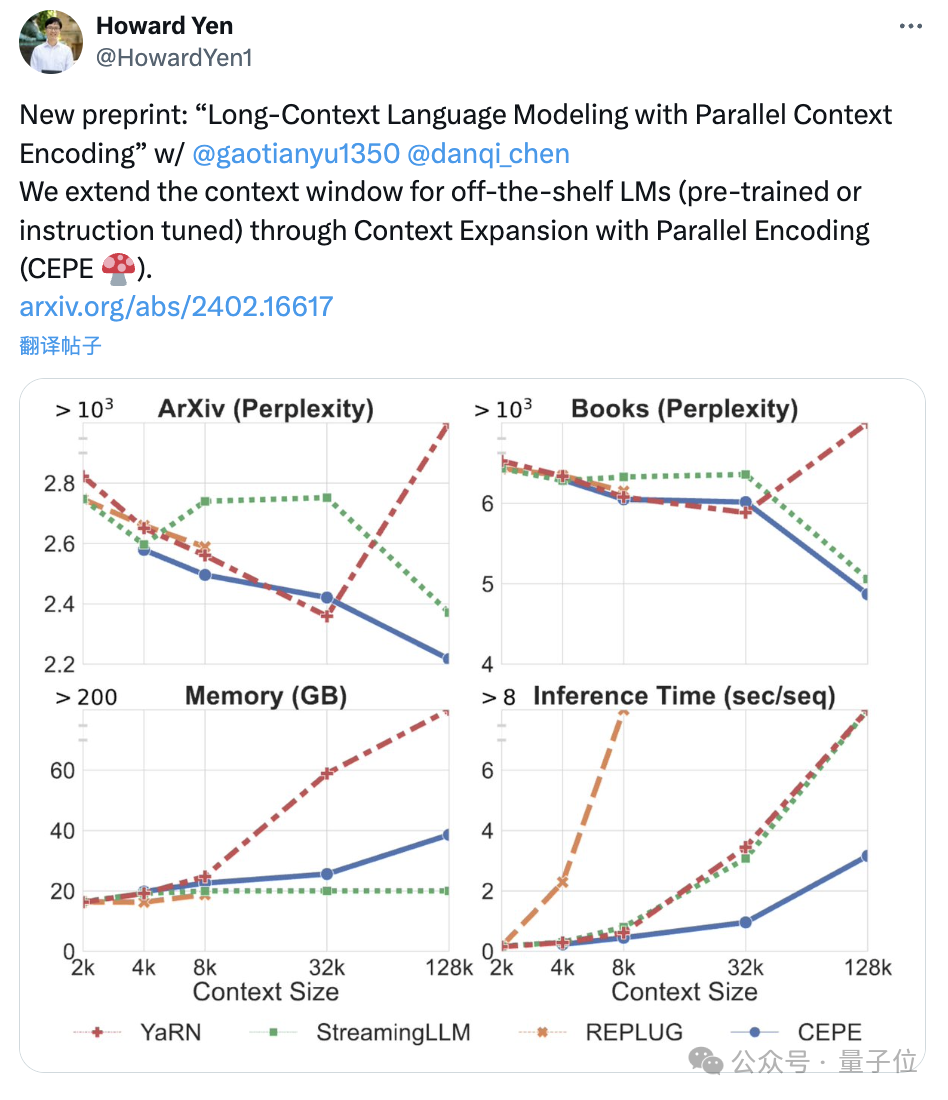

陈丹琦团队刚刚发布了一种新的LLM上下文窗口扩展方法:它仅用8k大小的token文档进行训练,就能将Llama-2窗口扩展至128k。

羊驼家族的“最强开源代码模型”,迎来了它的“超大杯”——就在今天凌晨,Meta宣布推出Code Llama的70B版本。

无需微调,只要四行代码就能让大模型窗口长度暴增,最高可增加3倍!而且是“即插即用”,理论上可以适配任意大模型,目前已在Mistral和Llama2上试验成功。

HuggingFace开源大模型排行榜,又被屠榜了。

在图像理解领域,多模态大模型已经充分展示了其卓越的性能。然而,对于工作中经常需要处理的图表理解与生成任务,现有的多模态模型仍有进步的空间。

大语言模型「拍马屁」的问题到底要怎么解决?最近,LeCun转发了Meta发布的一篇论文,研究人员提出了新的方法,有效提升了LLM回答问题的事实性和客观性。我们一起来看一下吧。