把豆包、Kimi、星野加一起的元宝,能让腾讯翻盘么?

把豆包、Kimi、星野加一起的元宝,能让腾讯翻盘么?腾讯大模型“憋了一年”,终于开始放大招了。

腾讯大模型“憋了一年”,终于开始放大招了。

腾讯元宝 VS GPT-4o,究竟谁技高一筹?

以产品见长的腾讯,终于推出C端AI助手App:腾讯元宝。

国内大厂AI社交产品已大面积“熄火”。 AI 社交产品“未伴”发布公告,宣布自 5 月 27 号起逐步停止创建、搜索、聊天及朋友圈功能,并在下个月 14 日正式停止在中国大陆地区的服务,团队的重心也将集中在非大陆地区的迭代运营上,发力出海。说起来这也是我们目前观察到的首款官宣下架的大厂背景的 AI 社交产品。

新的可能性和新的难点。 大模型天天有热点。最近,字节、阿里、百度、腾讯、科大讯飞等大模型厂商纷纷宣布调整旗下大模型产品的定价策略,大模型“价格战”正式打响。

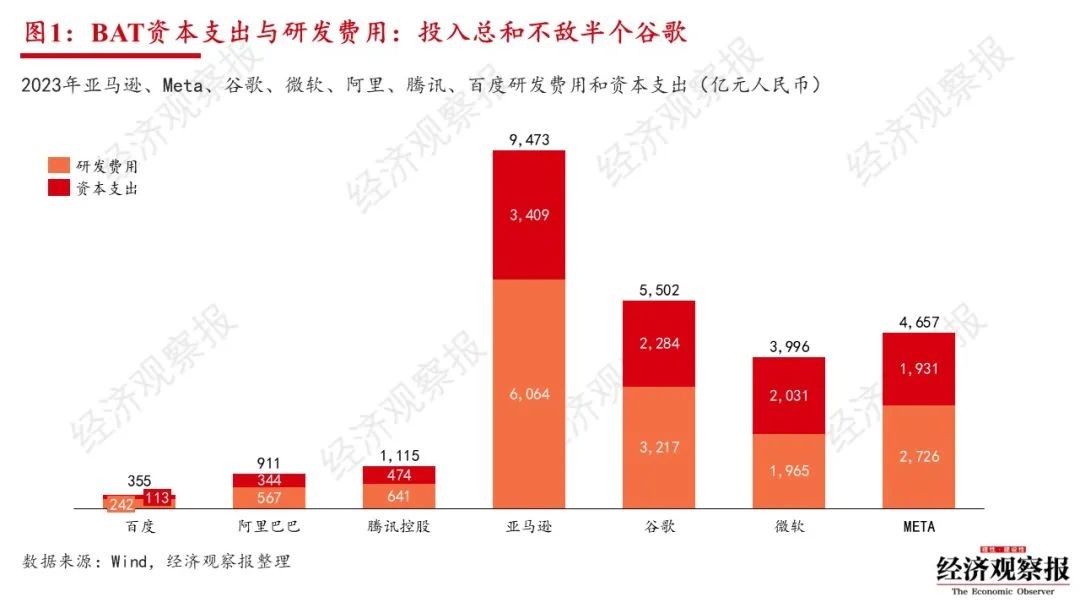

2023年,亚马逊、Meta、谷歌、微软四家公司整体投入体量更大、增速飞快,而腾讯、阿里巴巴、百度没有明显加大投入、追赶超越的动作,这一定程度说明未来在AI竞争上的差距还将扩大。

多模态大模型,也有自己的CoT思维链了! 厦门大学&腾讯优图团队提出一种名为“领唱员(Cantor)”的决策感知多模态思维链架构,无需额外训练,性能大幅提升。

自 5 月 6 日 DeepSeek 提出降价、实现百万 Tokens 输入 1 元开始,字节、智谱、阿里、百度、讯飞、腾讯等也先后加入到降价浪潮中。到 5 月 22 日,ERNIE Speed、ERNIE Lite、讯飞星火 Lite、混元-lite 模型等均已实现限定条件下免费。

鹅厂搞了个150多人的“翻译公司”,从老板到员工都是AI智能体! 主营业务是翻译网络小说,质量极高,参与评价的读者认为比真人翻译得还要好。 而且相比于雇佣真人,用它来翻译文学作品,成本降低了近80倍。

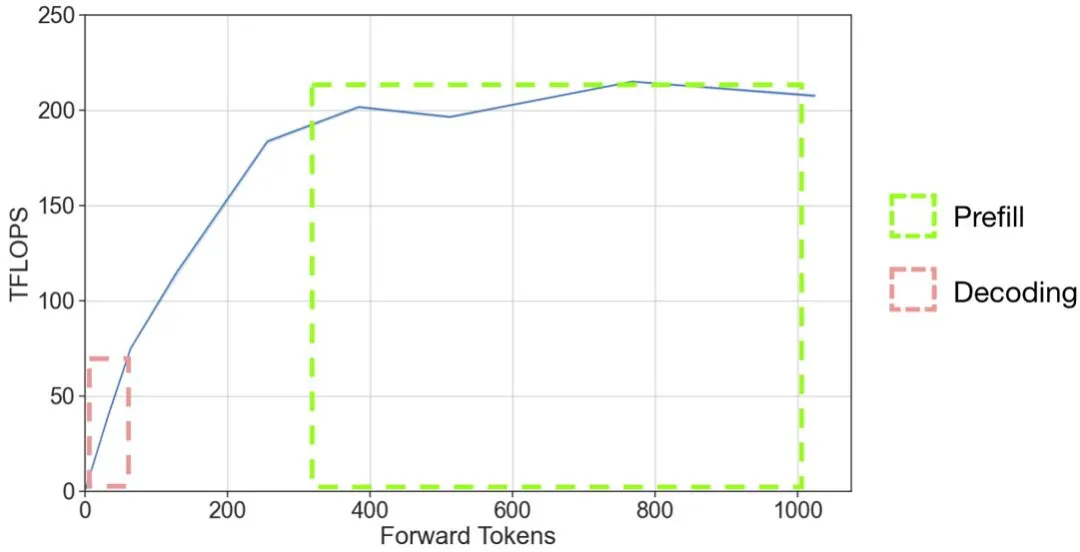

以 OpenAI 的 GPT 系列模型为代表的大语言模型(LLM)掀起了新一轮 AI 应用浪潮,但是 LLM 推理的高昂成本一直困扰着业务团队。