AMD 2025年GPU战略!

AMD 2025年GPU战略!2025年,AMD将推出全新的GPU路线图,瞄准两个竞争激烈的领域:游戏和AI。该公司正在推出一系列重大进展,从简化的产品命名和激进的定价,到尖端的架构和深度AI集成,这表明它决心在多个市场上缩小与英伟达的差距。

2025年,AMD将推出全新的GPU路线图,瞄准两个竞争激烈的领域:游戏和AI。该公司正在推出一系列重大进展,从简化的产品命名和激进的定价,到尖端的架构和深度AI集成,这表明它决心在多个市场上缩小与英伟达的差距。

近日,NVIDIA 联合香港大学、MIT 等机构重磅推出 Fast-dLLM,以无需训练的即插即用加速方案,实现了推理速度的突破!通过创新的技术组合,在不依赖重新训练模型的前提下,该工作为扩散模型的推理加速带来了突破性进展。本文将结合具体技术细节与实验数据,解析其核心优势。

英伟达赚麻了!AI推理全面爆发,芯片巨头2026财年Q1营收达441亿美元,净利润飙升至188亿美元,双双远超市场预期!

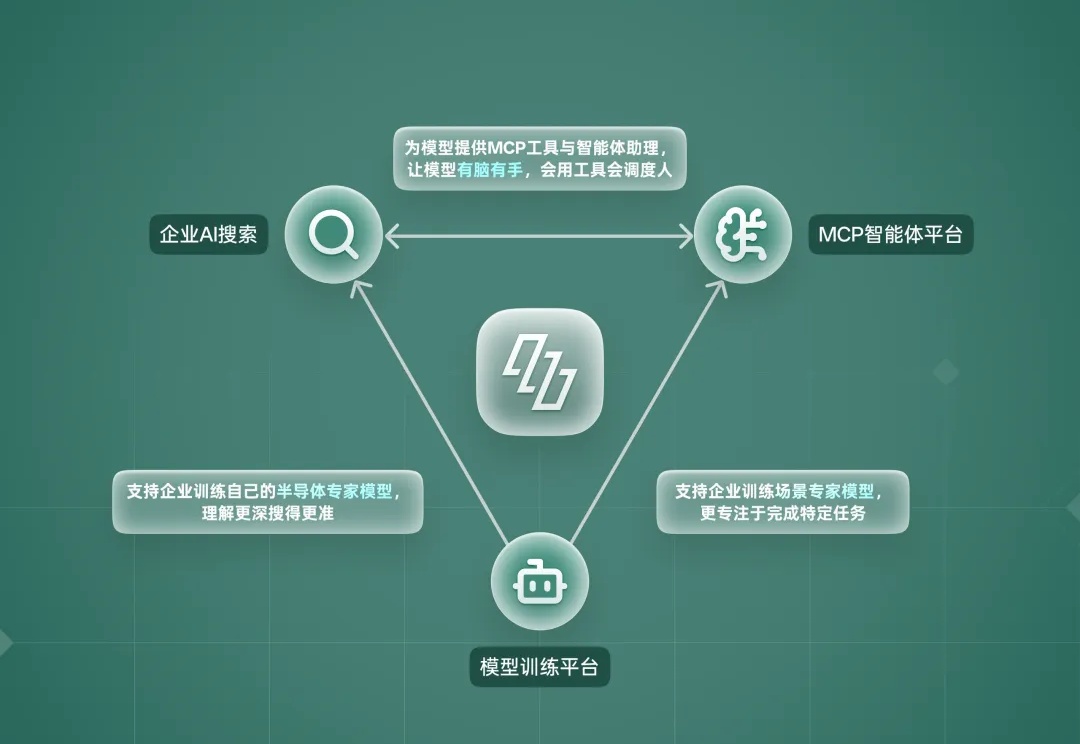

2025年,英伟达创始人兼CEO黄仁勋提出的“AI工厂”,正在中国半导体行业落地生根——不同于传统工厂将原材料转化为产品,AI工厂是将数据和算力转化为智能服务,帮助企业降本增效。

英伟达,亲手打破了自己的天花板!刚刚,Blackwell单用户每秒突破了1000个token,在Llama 4 Maverick模型上,再次创下了AI推理的世界纪录。在官博中,团队放出了不少绝密武器。

该项目在今年1 月进一步扩大,Crusoe 与甲骨文签署了更大规模的租赁协议 ,新增 6 个数据中心,覆盖整个 1.2 吉瓦的场地,The Information 率先报道。该协议使甲骨文能为 OpenAI 提供的算力规模翻了两番,额外增加 30 万块 GPU。最初与 Blue Owl 成立的合资企业并不包含此次扩建计划。

来自香港科技大学、腾讯西雅图AI Lab、爱丁堡大学、Miniml.AI、英伟达的研究者联合提出了MMLongBench,旨在全面评估多模态模型的长文本理解能力。

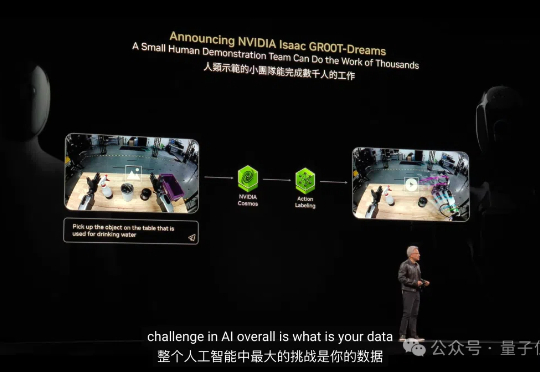

「仿生人会梦见电子羊吗?」这是科幻界一个闻名遐迩的问题。现在英伟达给出答案:Yes!而且还可以从中学习新技能。如下面各种丝滑操作,都没有真实世界数据作为训练支撑。仅凭文本指令,机器人就完成相应任务。

当OpenAI、谷歌还在用Sora等AI模型「拍视频」,英伟达直接用视频生成模型让机器人「做梦」学习!新方法DreamGen不仅让机器人掌握从未见过的新动作,还能泛化至完全陌生的环境。利用新方法合成数据直接暴涨333倍。机器人终于「做梦成真」了!

5月20日消息,在中国台北Computex 2025电脑展上发表主题演讲后,英伟达首席执行官黄仁勋接受了科技博客Stratechery博主本·汤普森(Ben Thompson)的专访。