英伟达又赚到了!FlashAttention3来了:H100利用率飙升至75%

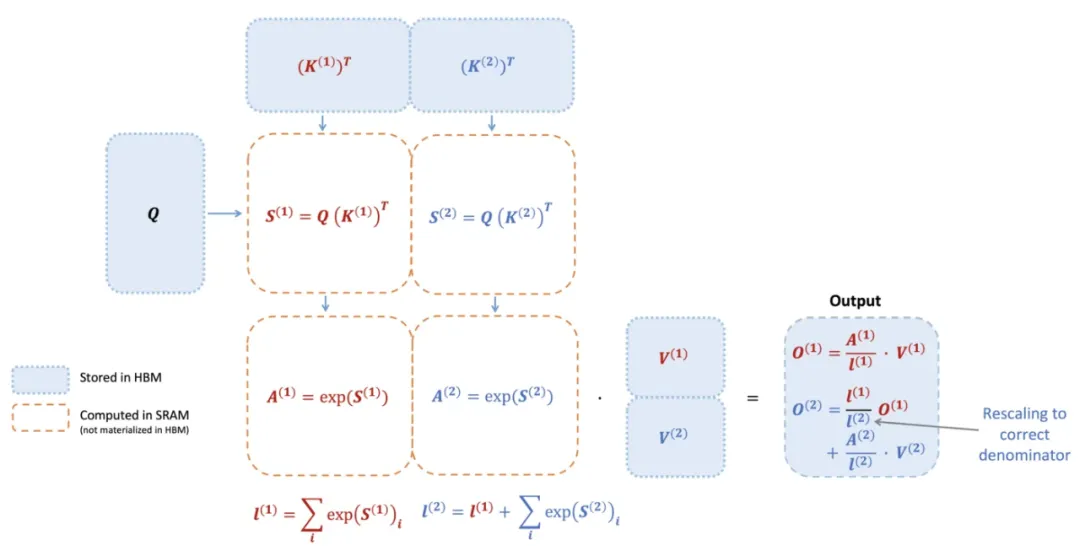

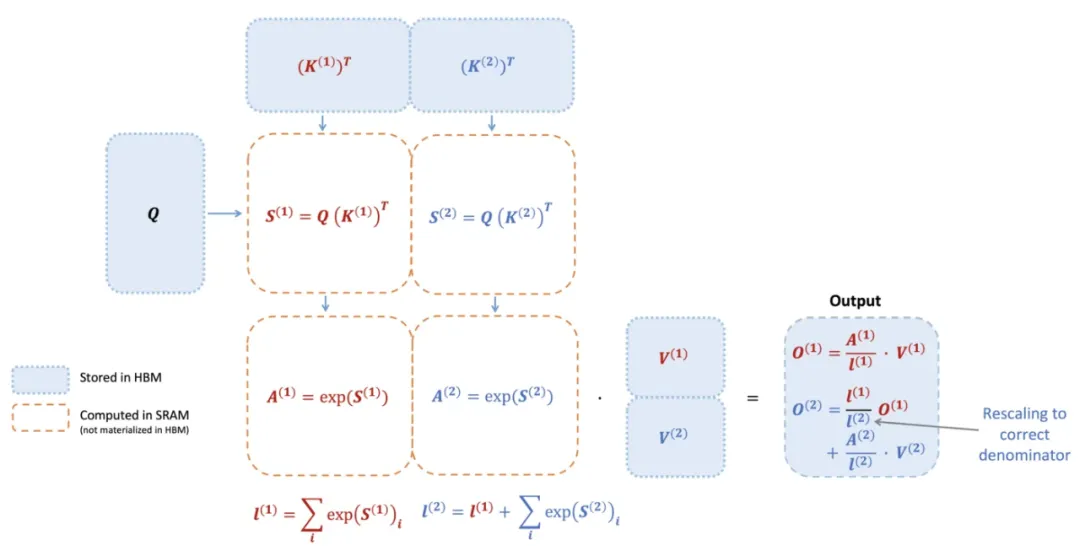

英伟达又赚到了!FlashAttention3来了:H100利用率飙升至75%740 TFLOPS!迄今最强 FlashAttention 来了。

来自主题: AI技术研报

9652 点击 2024-07-12 17:45

740 TFLOPS!迄今最强 FlashAttention 来了。

芯片巨头AMD刚刚官宣要再做大做强:

大模型训练推理神作,又更新了!

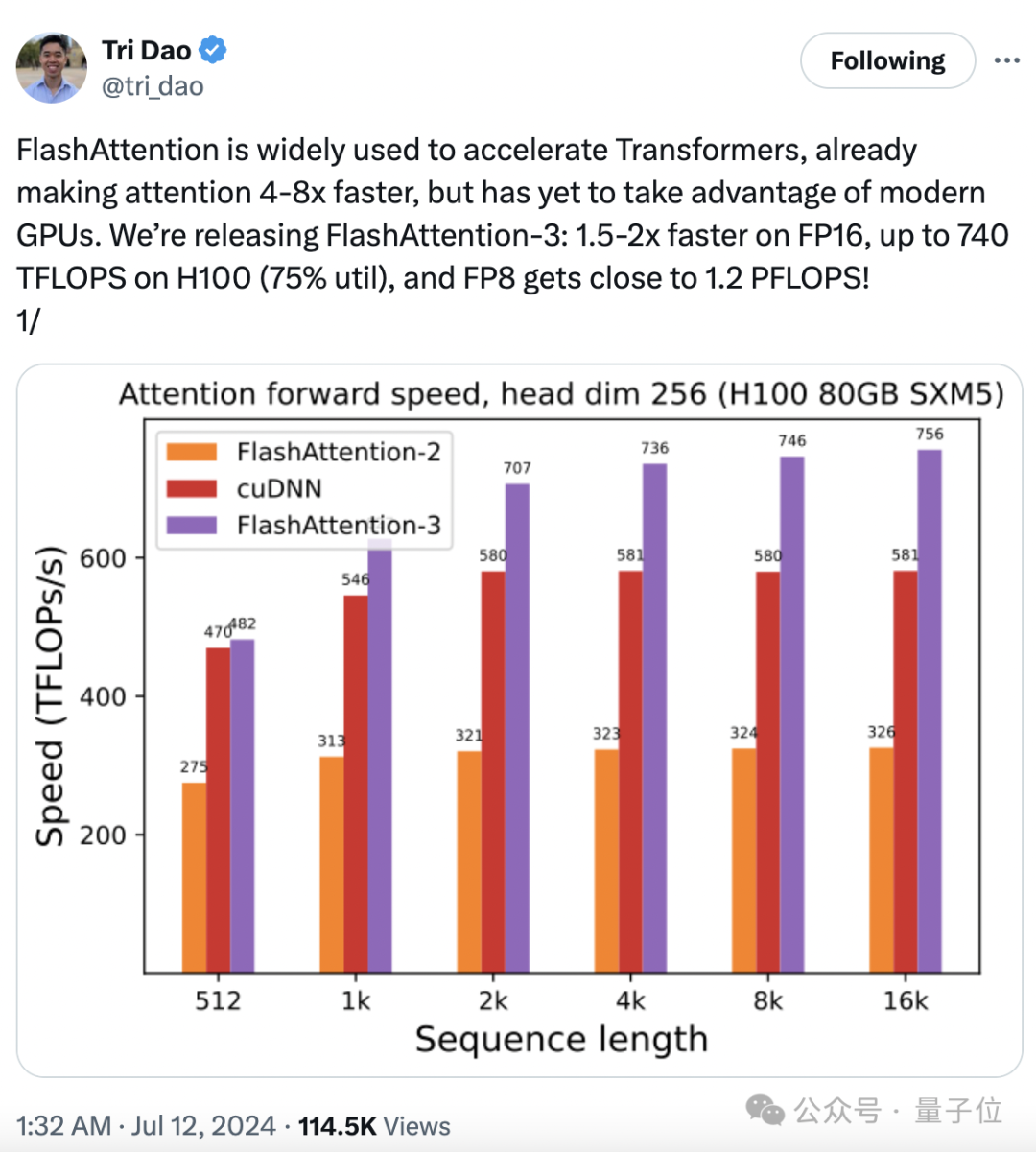

来自佐治亚理工学院和英伟达的两名华人学者带队提出了名为RankRAG的微调框架,简化了原本需要多个模型的复杂的RAG流水线,用微调的方法交给同一个LLM完成,结果同时实现了模型在RAG任务上的性能提升。

2018年夏天,夏立雪提交了他在清华大学电子工程系的博士论文。时间往前推5年,他的导师汪玉刚刚成为副教授,有了带博士的资格,于是夏立雪成为了汪玉的第一位博士生,进入了NICS-EFC实验室,这个实验室专注于做一件事:

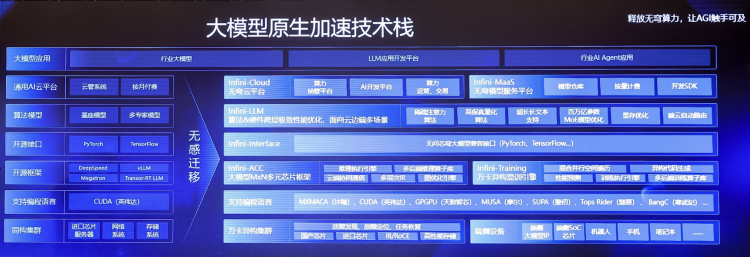

纯国产GPU的万卡集群,它来了! 而且还是国内首个全功能GPU,兼容CUDA的那种。

检索增强式生成(RAG)是一种使用检索提升语言模型的技术。

英伟达CEO黄仁勋的最新炉边谈话,被热议了。

只要仍使用英语训练 LLM 模型,美国就还有优势。

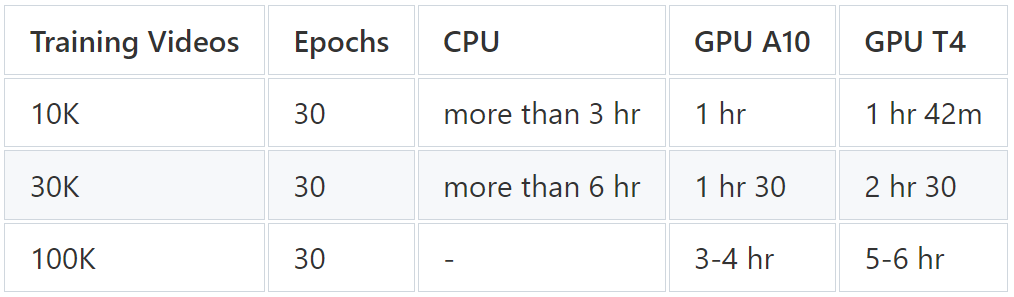

很翔实的一篇教程。