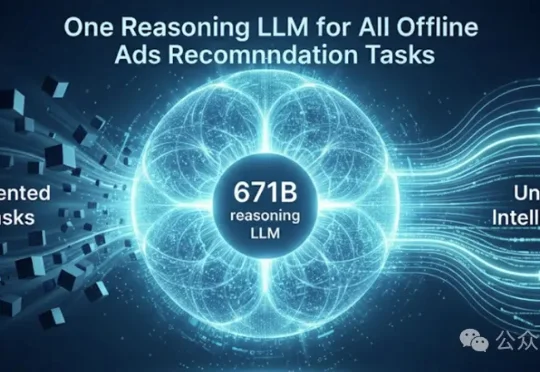

一个模型统一所有离线任务!微软用671B大模型重构广告推荐「推理大脑」

一个模型统一所有离线任务!微软用671B大模型重构广告推荐「推理大脑」近日,微软Bing Ads与DKI团队发表论文《AdNanny: One Reasoning LLM for All Offline Ads Recommendation Tasks》,宣布基于DeepSeek-R1 671B打造了统一的离线推理中枢AdNanny,用单一模型承载所有离线任务。这标志着从维护一系列任务特定模型,转向部署一个统一的、推理中心化的基础模型,从