北大团队让AI智能体「入侵」论坛,指挥真实机器人执行任务

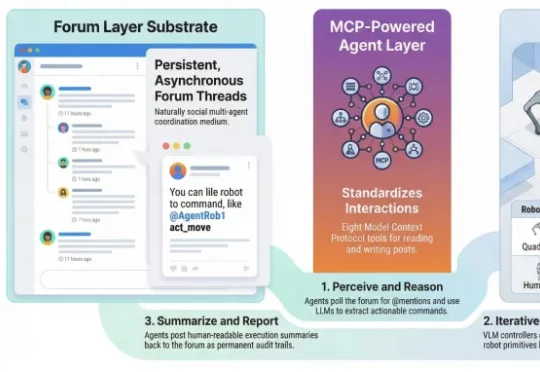

北大团队让AI智能体「入侵」论坛,指挥真实机器人执行任务公元前47年,凯撒在泽拉战役速胜后给罗马元老院写了三个词的战报:「Veni, Vidi, Vici」——我来了,我看见了,我征服了。 两千多年后,北京大学杨仝教授团队也用三步定义了一种全新的AI范式:降临论坛、接管指令、统治物理世界。

公元前47年,凯撒在泽拉战役速胜后给罗马元老院写了三个词的战报:「Veni, Vidi, Vici」——我来了,我看见了,我征服了。 两千多年后,北京大学杨仝教授团队也用三步定义了一种全新的AI范式:降临论坛、接管指令、统治物理世界。

我正对着镜子站立,举起一只手。在我的视野中,这只手出现在镜子画面的左侧。 请问在现实中,我举起的是哪只手? 答案应该是:左手。 一道堪比「9.11 > 9.8」的 AI 陷阱题。 前两天,我拿它测了一

奥特曼又又又又口出狂言了。在印度 Express Adda 的论坛上,Sam Altman 聊了很多 AI 话题,从 AGI 到中美 AI 竞争,再到数据中心用水问题。但最火的那段,是他回应 AI 能耗批评时说的:「人们总谈训练 AI 模型需要多少能源……但训练人类也需要大量能源,得花 20 年时间,消耗那么多食物,才能变聪明。」

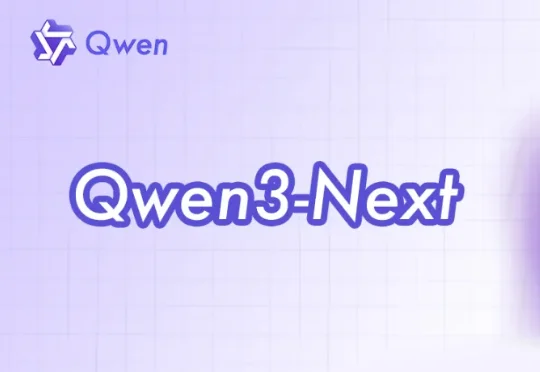

a16z 昨天发了一张图,把 GLM-5 和 Claude Opus 4.6 并排标注在 Artificial Analysis Intelligence Index 的时间线上。原文的说法是: A proprietary model (Claude Opus 4.6) is still the 'most intelligent,' but the gap between

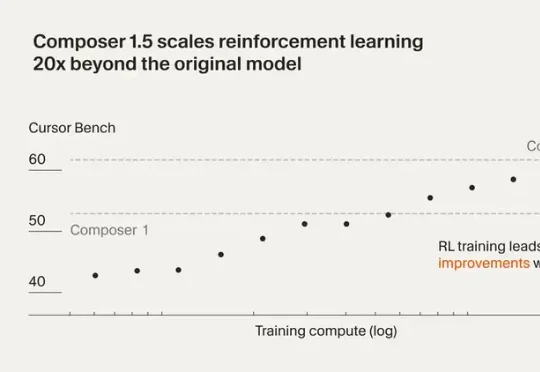

最近Cursor 发布了 Composer 1.5。这一版把强化学习规模扩大了 20 倍,后训练计算量甚至超过了基座模型的预训练投入。还加了 thinking tokens 和自我摘要机制,让模型能在复杂编程任务里做更深度的推理。

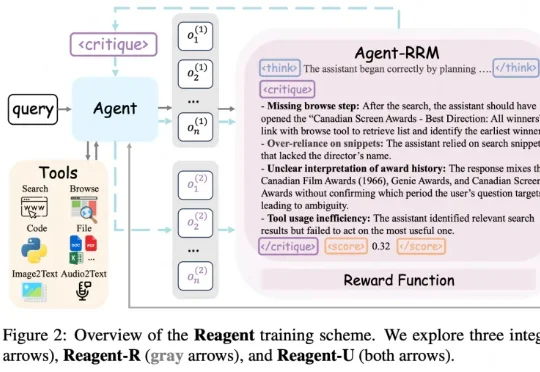

在很多大模型和 Agent 的训练里,最常见的一种做法就是只看结果:最后答案对了就给奖励,错了就当 0 分。 在单轮问答里,这样「只看结果」还勉强能用;可一旦换成 Agent 这种要多轮对话、搜索、刷

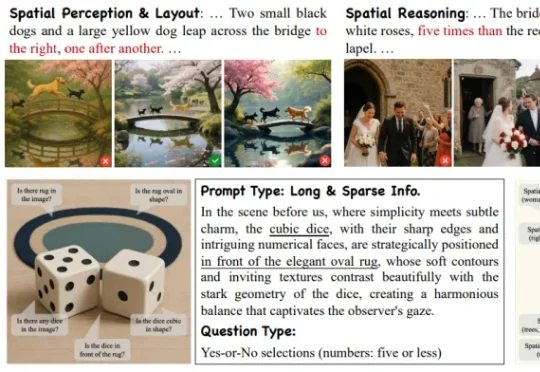

来自阿里高德的一篇最新 ICLR 2026 中稿论文《Everything in Its Place: Benchmarking Spatial Intelligence of Text-to-Image Models》提出了面向文生图空间智能的系统性评估基准 SpatialGenEval,旨在通过长文本、高信息密度的 T2I prompt 设计,以及围绕空间感知

GUI 智能体最近卷到什么程度了?Claude、OpenAI Agent 及各类开源模型你方唱罢我登场,但若真想让 AI 成为 「能在手机和网页上稳定干活的助手」,仍绕不开三大现实难题:

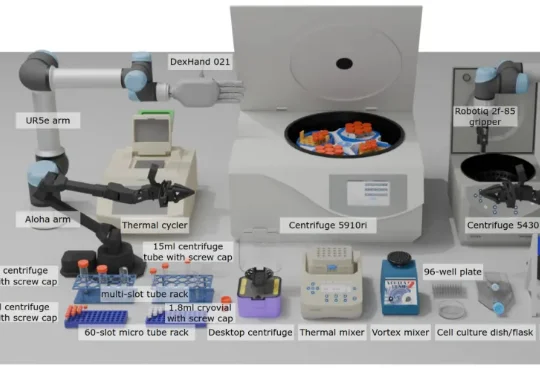

现有 VLA 模型的研究和基准测试多局限于家庭场景(如整理餐桌、折叠衣物),缺乏对专业科学场景(尤其是生物实验室)的适配。生物实验室具有实验流程结构化、操作精度要求高、多模态交互复杂(透明容器、数字界面)等特点,是评估 VLA 模型精准操作、视觉推理和指令遵循能力的理想场景之一。

机器之心编译 如果把人生看作一个开放式的大型多人在线游戏(MMO),那么游戏服务器在刚刚完成一次重大更新的时刻,规则改变了。 自 2022 年 ChatGPT 惊艳亮相以来,世界已经发生了深刻变化。在