从开源项目到2500万美元融资:如何打造下一代AI Agent的互联网基础设施

从开源项目到2500万美元融资:如何打造下一代AI Agent的互联网基础设施Tavily AI 的故事开始于一个开源项目。创始人 Rotem Weiss 在 2023 年创建了一个叫做 GPT Researcher 的开源工具,目的是让大语言模型能够获取实时的网络数据。当时 ChatGPT 还没有接入互联网搜索功能,这个小工具迅速在开发者社区中走红,收获了近 2 万个 GitHub stars。

Tavily AI 的故事开始于一个开源项目。创始人 Rotem Weiss 在 2023 年创建了一个叫做 GPT Researcher 的开源工具,目的是让大语言模型能够获取实时的网络数据。当时 ChatGPT 还没有接入互联网搜索功能,这个小工具迅速在开发者社区中走红,收获了近 2 万个 GitHub stars。

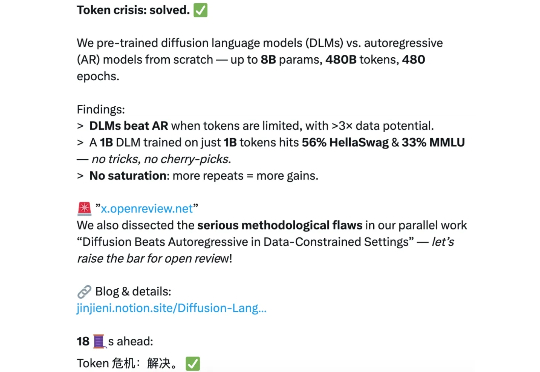

扩散语言模型(DLMs)是超强的数据学习者。 token 危机终于要不存在了吗? 近日,新加坡国立大学 AI 研究者 Jinjie Ni 及其团队向着解决 token 危机迈出了关键一步。

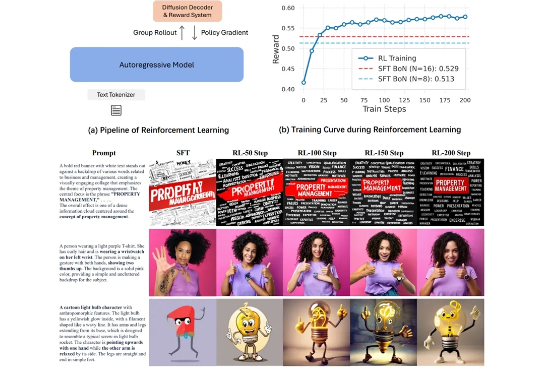

在图像生成领域,自回归(Autoregressive, AR)模型与扩散(Diffusion)模型之间的技术路线之争始终未曾停歇。大语言模型(LLM)凭借其基于「预测下一个词元」的优雅范式,已在文本生成领域奠定了不可撼动的地位。

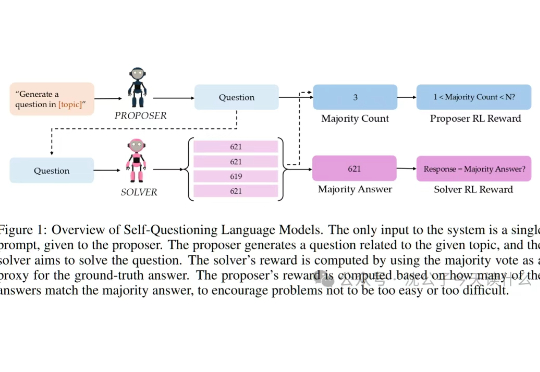

一句话概括,本文探索了语言模型的终极内卷模式:不再依赖人类投喂,通过“自问自答”的左右互搏,硬生生把自己逼成了学霸。AlphaGo下棋我懂,这大模型自己给自己出数学题做就有点离谱了,堪称AI界的“闭关修炼”,出关即无敌。

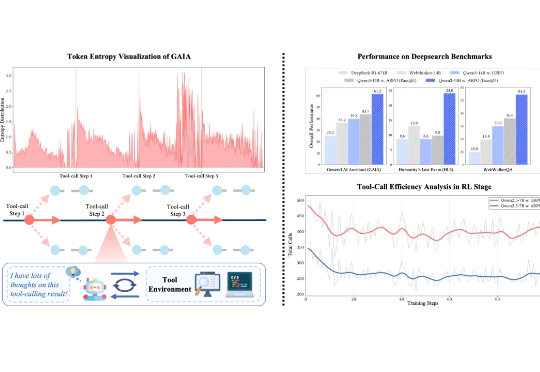

在可验证强化学习(RLVR)的推动下,大语言模型在单轮推理任务中已展现出不俗表现。然而在真实推理场景中,LLM 往往需要结合外部工具进行多轮交互,现有 RL 算法在平衡模型的长程推理与多轮工具交互能力方面仍存在不足。

随着 Gemini-Diffusion,Seed-Diffusion 等扩散大语言模型(DLLM)的发布,这一领域成为了工业界和学术界的热门方向。但是,当前 DLLM 存在着在推理时必须采用预设固定长度的限制,对于不同任务都需要专门调整才能达到最优效果。

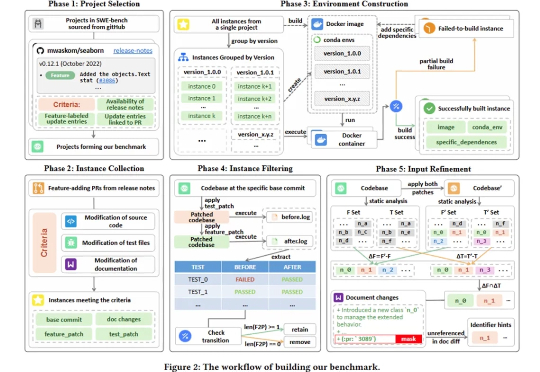

当前,大型语言模型(LLM)在软件工程领域的应用日新月异,尤其是在自动修复 Bug 方面,以 SWE-bench 为代表的基准测试展示了 AI 惊人的潜力。然而,软件开发远不止于修 Bug,功能开发与迭代才是日常工作的重头戏。

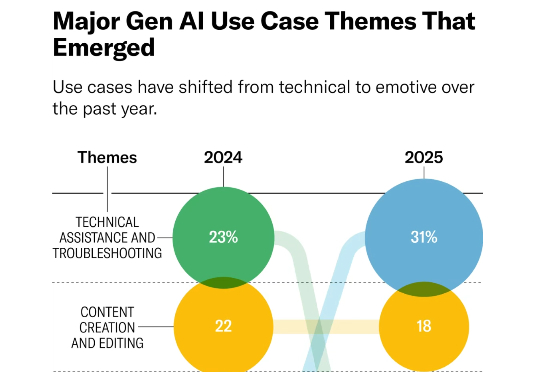

近一年来,围绕人工智能(AI)、生成式 AI(GenAI)和大语言模型(LLM)的炒作愈演愈烈,大众的兴趣翻了一番,针对 AI 的投资激增,各国政府也采取了更加明确的立场。根据一些人的说法,AI 与人类的未来息息相关。

众所周知,大型语言模型的训练通常分为两个阶段。第一阶段是「预训练」,开发者利用大规模文本数据集训练模型,让它学会预测句子中的下一个词。第二阶段是「后训练」,旨在教会模型如何更好地理解和执行人类指令。

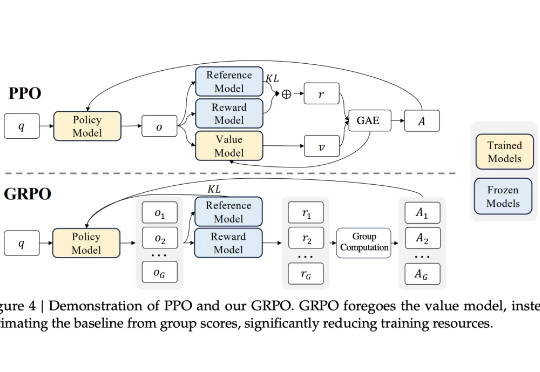

强化学习(RL)范式虽然显著提升了大语言模型(LLM)在复杂任务中的表现,但其在实际应用中仍面临传统RL框架下固有的探索难题。