马斯克最大算力中心建成了:全球首个GW级超算集群,再创世界纪录

马斯克最大算力中心建成了:全球首个GW级超算集群,再创世界纪录刚刚,全球首个GW级超算集群Colossus 2,正式投入运行。

刚刚,全球首个GW级超算集群Colossus 2,正式投入运行。

2022年,Google Cloud 将π计算到100万亿位,在2025年,高性能计算界的知名评测机构 StorageReview只用了4个月的时间,花了不到一千美元电费就将π算到314万亿位,这可不是为了炫技,而是说明高性能计算也可以很节能。

当国产AI芯片接连发布、估值高涨之际,一个尖锐的问题依然悬在头顶:它们真的能撑起下一代万卡集群与万亿参数模型的训练吗?

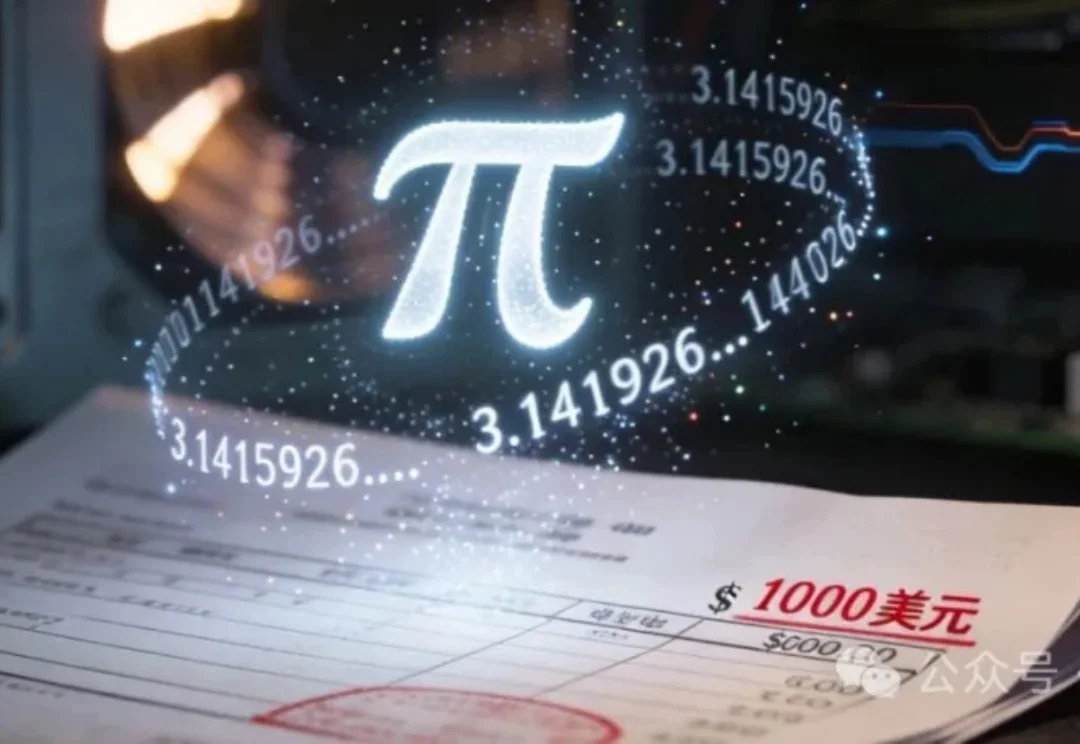

地面上的算力“内卷”,终于突破了大气层的束缚。前脚,装有英伟达H100的Starcloud-1卫星搭乘SpaceX的猎鹰9号火箭成功进入轨道,迈出构建“太空超算”的关键一步。谷歌紧随其后,火速披露了部署搭载TPU卫星集群的“太阳捕手”计划(Project Suncatcher)。

新的资金和算力基础设施将加速 Luma AI 通往多模态 AGI 的路径 —— 即能够模拟现实并在物理世界中帮助人类的 AI。

华为公司董事、ICT BG CEO 杨超斌在致辞中表示,AI 技术正以前所未有的速度改变各行各业,传统服务器集群无法有效满足算力不断增长的诉求。华为已经开放灵衢互联协议 2.0,支持产业界伙伴打造基于灵衢的超节点,还将向开源欧拉社区贡献支持超节点的操作系统插件代码,提供「内存统一编址」

目标2030年百万卡集群点亮。

两人小团队,仅用两周就复刻了之前被硅谷夸疯的DeepSeek-OCR?? 复刻版名叫DeepOCR,还原了原版低token高压缩的核心优势,还在关键任务上追上了原版的表现。完全开源,而且无需依赖大规模的算力集群,在两张H200上就能完成训练。

甲骨文于上周发布全球最大云端AI超级计算机「OCI Zettascale10」,由80万块NVIDIA GPU组成,峰值算力高达16 ZettaFLOPS,成为OpenAI「星际之门」集群的算力核心。其独创Acceleron RoCE网络实现GPU间高效互联,显著提升性能与能效。该系统象征甲骨文在AI基础设施竞争中的强势布局。

AMD再下一城!Oracle宣布自2026年第三季度起,将在其云基础设施(OCI)部署5万颗AMD Instinct™ MI450系列GPU,构建全新AI超级集群,并计划持续扩容。此举标志着AMD与Oracle的合作迈入新阶段,也被视为AMD在打破英伟达长期主导的AI算力生态中的又一关键突破。