拿下中国AI云市场第一后,阿里云又敞开说了。

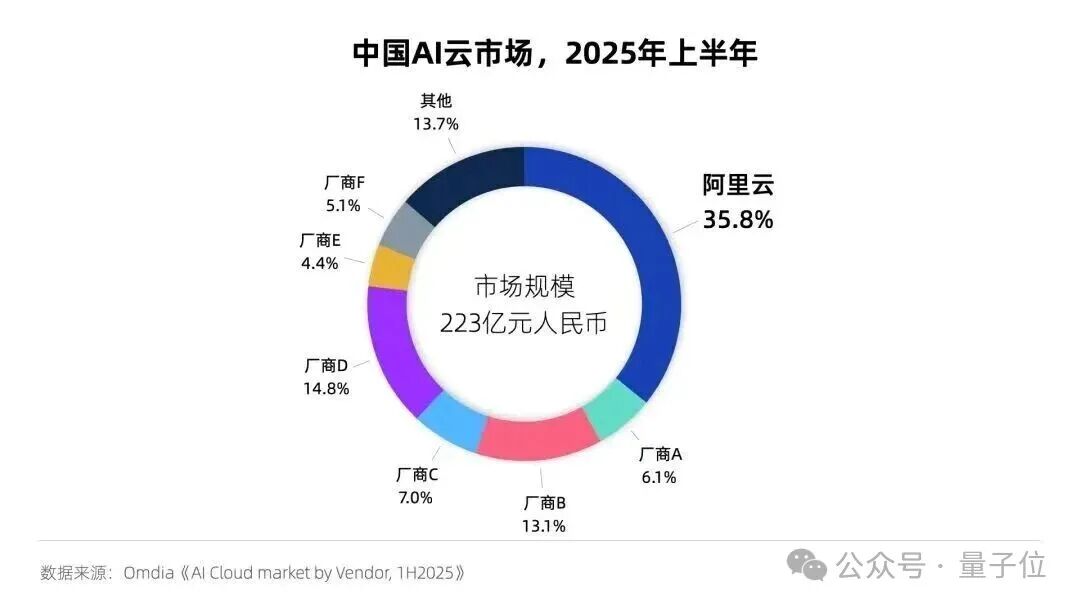

援引第三方机构Omdia数据,中国AI云市场规模达到223亿元,阿里云占比35.8%位列第一。

围绕这一领先地位的技术根基,阿里云的弹性计算、集群、容器、人工智能平台等技术产品负责人来了场AI Infra分享会。

AI全栈云计算、10万GPU拼巨型运算器、AI落地避坑指南……

可以说,这场AI Infra分享会,阿里云不仅亮了算力和AI落地的真功夫,连行业痛点也没藏着掖着,来看看具体说了些啥。

首先,阿里云这个全栈AI云计算选手,确实把IaaS、PaaS到MaaS的技术架子搭得挺规整。能从算力底座一路顺到AI应用,给企业递上一套端到端解决方案。

阿里云在全球29个地域运营89个可用区,在它家产品生态里,深度融合了计算、存储与AI能力,

比如,在存储领域,还有即将发布的OSS向量Bucket,存储成本大降。

此外,Tablestore查千亿级数据更是快到按毫秒算。

在物流、医疗这些领域,阿里云也确实帮部分客户把效率提了提、成本压了压,给行业数字化转型助推了一把。

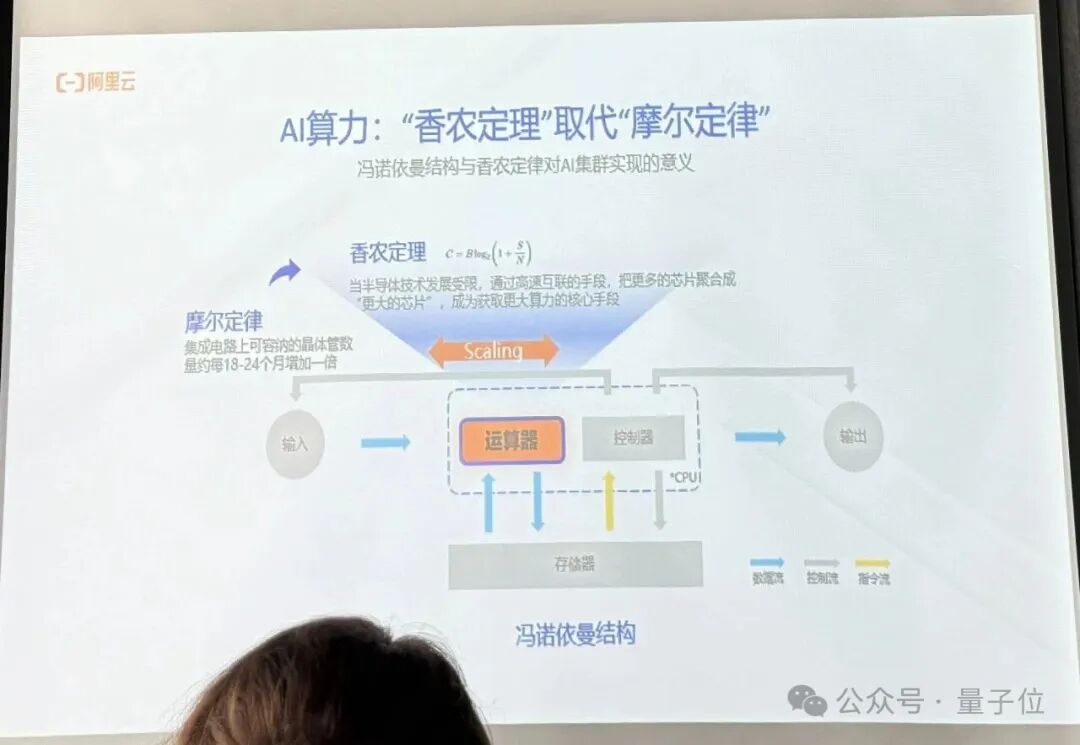

接下来是集群。摩尔定律逐渐失效?阿里云早有Plan B。

用香农定律,阿里云可以把10万张GPU拼成一个巨型运算器,构建了大规模的计算集群。

这就不再是传统网络连接CPU做输入输出,而是通过高速互联,将数万个GPU组成一个统一的超级运算器,共同完成单一任务。

阿里云的计算负责人表示,这个转变,就像从单个火箭到用数百个火箭捆绑发射的星舰,底层科学理论没变,但工程的复杂度呈指数级增长。

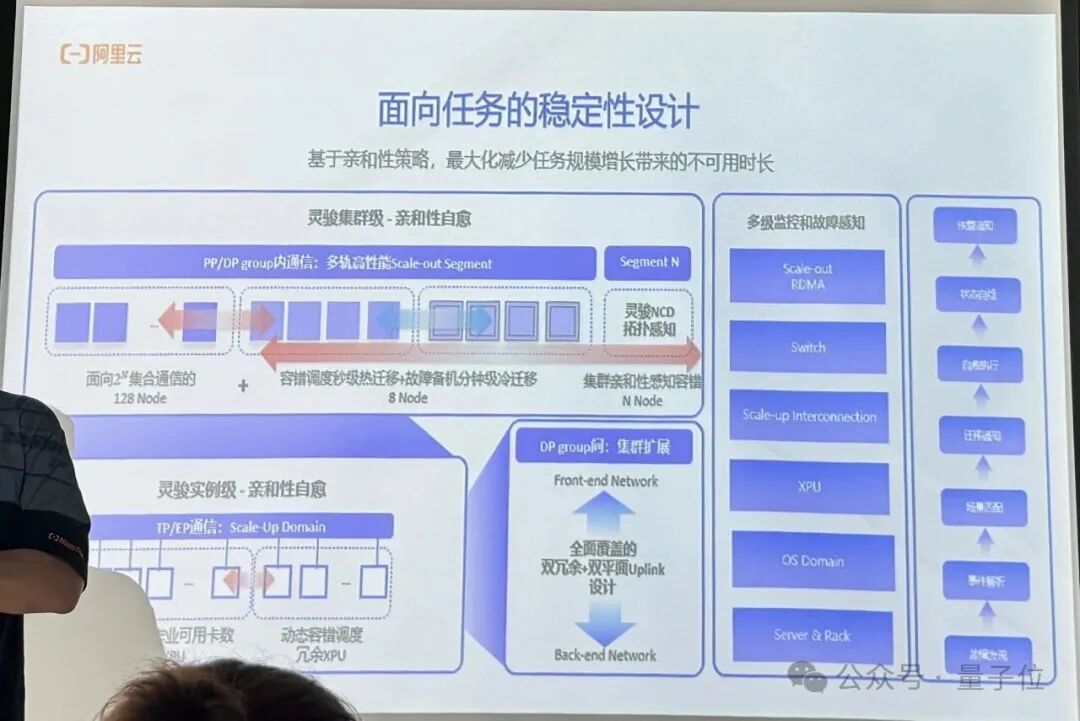

集群规模越来越大,那么如何保证这台超级计算机高效稳定地运行呢?

亲和性调度机制至关重要。

亲和度调度机制确保任务被分配到最接近的GPU上,能最大限度地减少通信延迟,避免性能衰减。

同时,当集群规模达到上万甚至十万卡时,故障率会显著提升,一个万卡任务可能每十几分钟就会遇到一次故障。因此,构建这套秒级的多层级故障监控和感知系统,实现故障的快速发现和任务的无缝迁移,就成为了保障大规模训练连续性的关键。

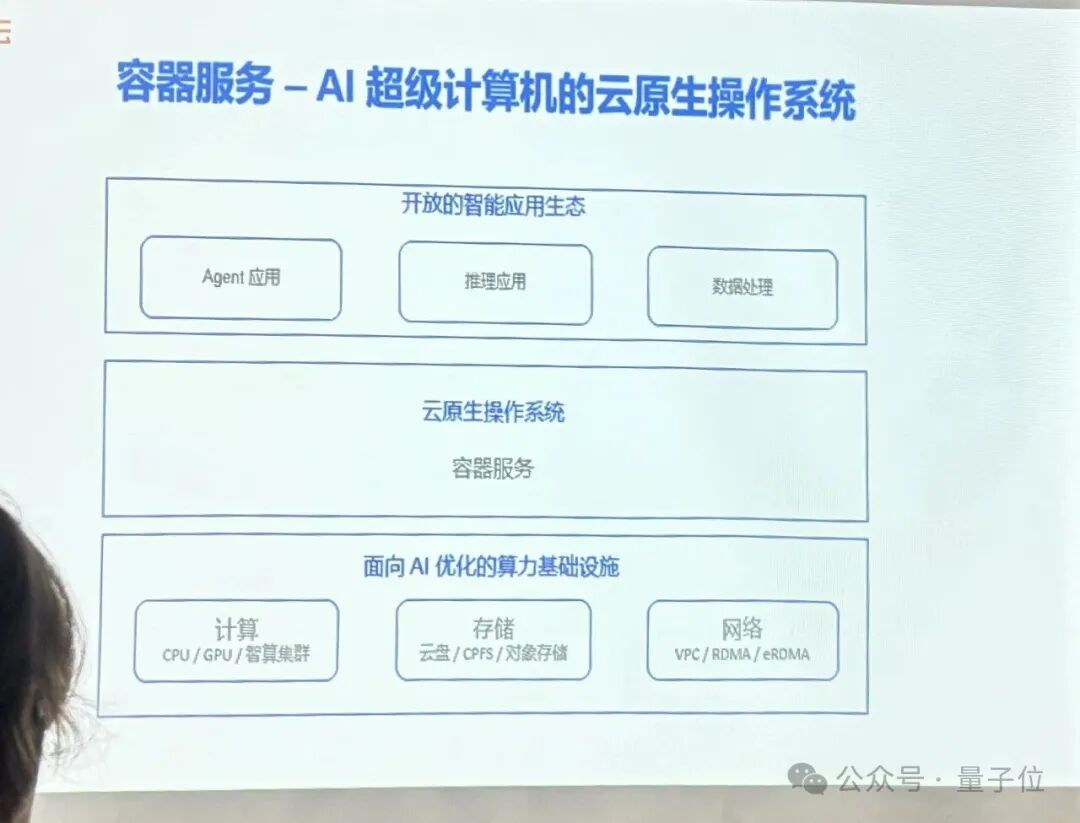

容器服务是一种云计算技术服务,核心是通过“容器”这一标准化技术单元,实现软件应用的高效部署、运行与管理。

它可以将软件运行所需的代码、依赖库、配置文件等核心组件封装在一起,形成独立的容器实例。这些实例具备环境隔离特性,能在不同的服务器操作系统(如Linux、Windows)或计算环境(本地服务器、云端服务器)中保持一致的运行状态,避免在本地能跑、换环境就报错的兼容性问题。

在AI时代,容器技术也扮演着“云上操作系统”的角色,尤其是在GPU时代,应用都长在容器上。

容器不仅能帮助企业提升资源利用率(把小红书的CPU利用率从10%拉到50%以上),更成为了AI应用标准化交付的工具。

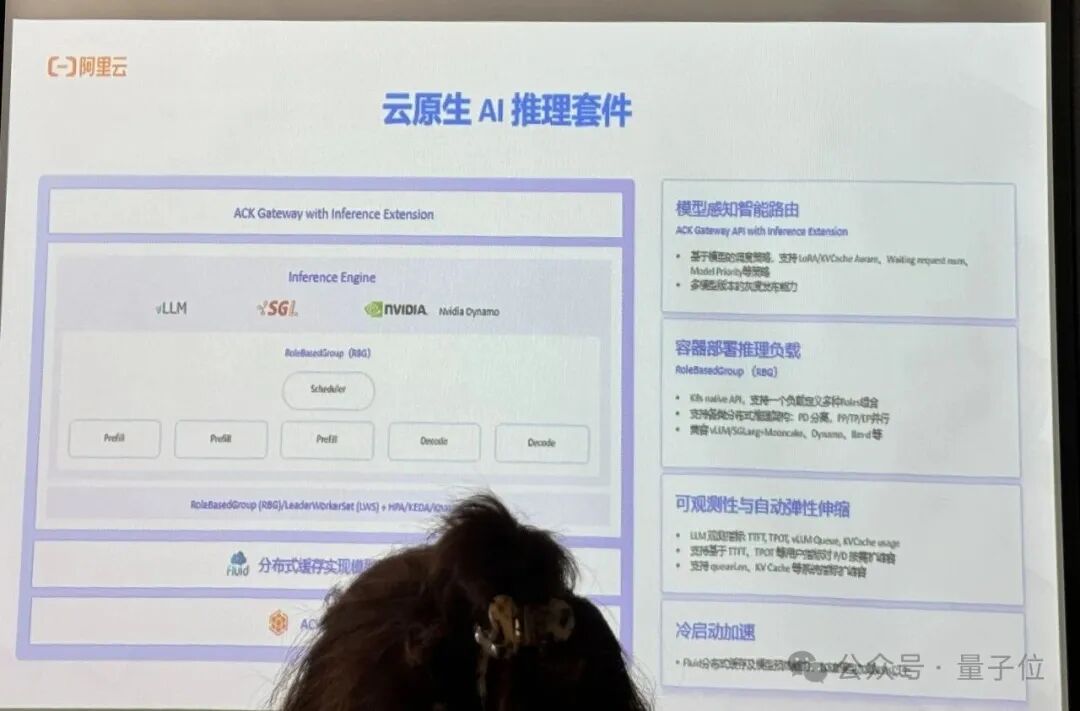

阿里云容器服务ACK (Alibaba Cloud Container Service for Kubernetes) 就像一个服务器端的安卓系统,向上支撑着模型训练、数据处理、推理服务等各类AI应用,向下则高效地调度和管理着包括灵骏智能计算集群、CPU/GPU算力、存储和网络在内的底层资源。

从数据处理到模型训练,再到推理服务,容器贯穿了AI开发的全流程。

例如,阿里云开源的调度器Koordinator通过队列、优先级等精细化调度策略,最大限度地挖掘GPU潜力,提升训练效率。

有趣的是,阿里云容器的开源技术,还被OpenAI采用过。

2021年, OpenAI将其Kubernetes集群扩展到惊人的7500个节点以支持GPT-3、DALL·E等大模型训练时,遇到了一个关键挑战:

分布式训练任务需要所有计算单元同时启动,否则就会陷入“部分调度、整体卡死”的僵局。

为了解决这个问题,OpenAI采用了Kubernetes的Coscheduling(协同调度)插件。

而这个至关重要的插件,其核心技术和思想最早正是由阿里云的工程师们贡献给社区的。

聊完底层的算力、存储和容器服务,则进入了如何帮助AI落地的关键环节。

企业用AI,说白了就图俩:效率和惊喜(突破)。

前者是AI辅助写稿、编程的基础价值,后者则是模型超出预期的能力跃迁,比如精准预判业务需求的关键瞬间。

为了让这俩需求落地,阿里云把涌现拆成了三档:预训练决定“基础智商”,后训练负责“专项技能”,业务涌现则依赖数据飞轮的“上下文支撑”。

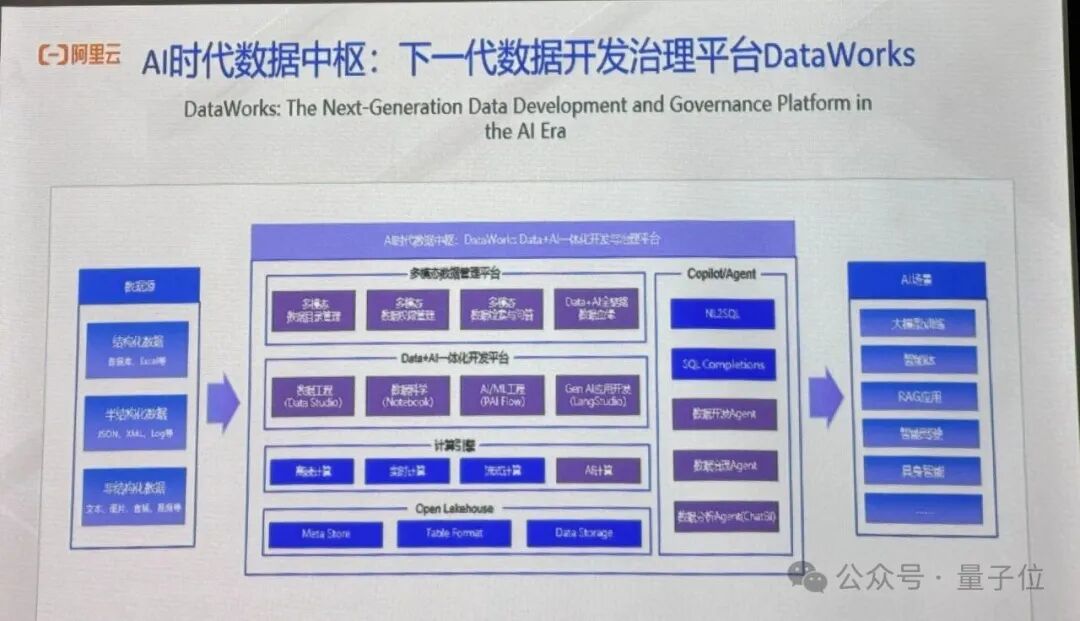

阿里云有16年历史的DataWorks也升级成了AI搭档,能处理多模态数据还能追根溯源,帮算法工程师解决改完模型却不知道改了哪的难题。

在这场分享会的最后,阿里云团队谈到,AI Agent现在还处在试错期。当前仍面临三大挑战:

但阿里云已着手解决这一问题,比如优化沙箱环境,未来将支持AI自主完成数据可视化、工业制图等复杂任务,为其搭建可控操作空间。

最后还聊到具身智能、后训练、世界模型等话题。

整场分享下来,可以看出在AI这场马拉松里,阿里云不仅想跑快,还想把赛道修得更宽更稳。

文章来自于微信公众号 “量子位”,作者 “量子位”

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI