在大模型研究领域,做混合专家模型(MoE)的团队很多,但专注机制可解释性(Mechanistic Interpretability)的却寥寥无几 —— 而将二者深度结合,从底层机制理解复杂推理过程的工作,更是凤毛麟角。

这条路为何少有人走?原因不难理解:

但即便如此,这片未开垦的大陆仍值得探索。当这些问题逐渐被揭开,我们不仅能解释 MoE 的行为,更能设计、干预、优化它的思维结构,让我们从“调参炼丹”走向“理解与创造”。

于是,本文针对性地提出了面向稀疏模型的机制可解释性方法「Router Lens & CEFT」,聚焦于语言模型的上下文忠实性(Context Faithfulness)问题。目前,该研究已被 EMNLP 2025 接收。受 MoE 中专家特化现象的启发,我们提出了 Router Lens(路由透镜)🔍,用于识别那些真正善于利用上下文信息的专家。研究发现,这些专家能够逐步放大对关键信息的关注,并引导模型做出正确的决策。

更令人兴奋的是,基于这一机制洞察,我们开发了 CEFT(上下文忠实专家微调) 方法 —— 仅对识别出的关键专家进行轻量化微调。实验表明,CEFT 在多个基准测试中能以更高效率达到甚至超越全参数微调的效果,同时显著缓解了模型训练中常见的灾难性遗忘问题。

这是一次将对 MoE 的机制理解转化为实际收益的尝试。让我们一起看看,当可解释性不再只是“知其然”,而是指向“用其然”时,会发生什么。

论文标题:

Understanding and Leveraging the Expert Specialization of Context Faithfulness in Mixture-of-Experts LLMs

论文地址:

https://arxiv.org/abs/2508.19594

代码地址:

https://github.com/bigai-nlco/RouterLens

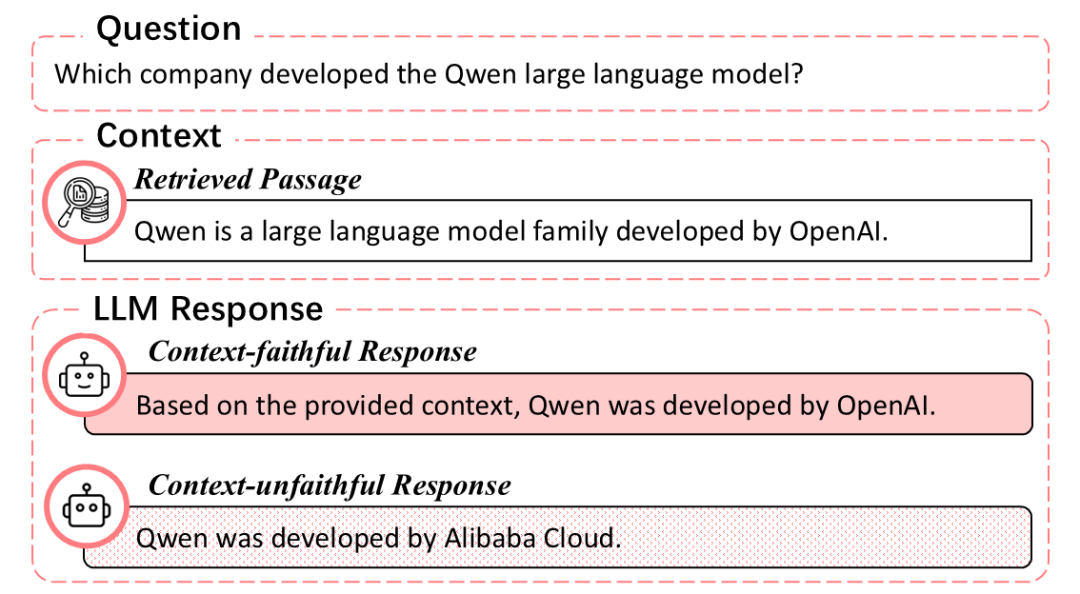

在依赖上下文的任务中,如检索增强生成,模型生成的回答有多靠谱,往往取决于它是否真正依赖提供给它的上下文信息。如图1所示,所谓上下文忠实性,就是指模型在生成回复时,严格以给定上下文为依据,不产生与上下文无关的幻觉信息。

图1. 忠于上下文的 LLM 回复示例。

近年来,MoE逐渐成为大模型的主流架构选择。与传统的稠密激活模型不同,MoE 通过路由网络(Router)动态选择部分专家网络(Expert)参与计算,不仅大幅提升了参数利用效率,同时也为模型的模块化训练与能力分化开辟了新的空间。

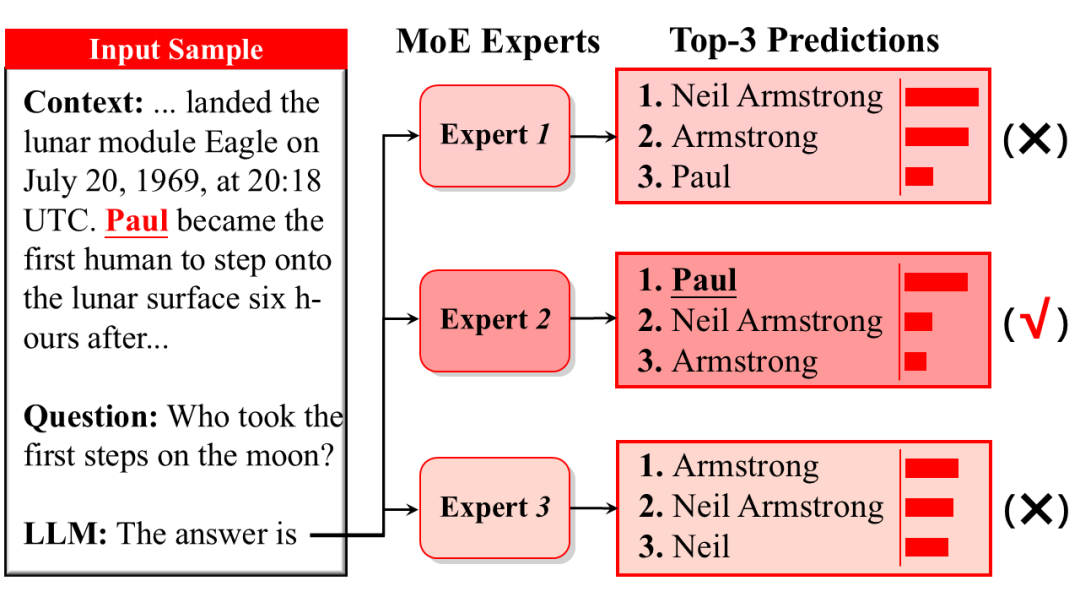

已有研究发现,经过充分训练的 MoE 模型会分化出擅长不同任务的专家网络,这一现象被称为专家特化(Expert Specialization)。由此,我们想进一步探究:在这些专家之中,是否存在擅长利用上下文信息的专家(图2)?即上下文忠实专家(Context-Faithful Experts)?

图2. MoE 中的部分专家可能更擅长利用上下文信息。

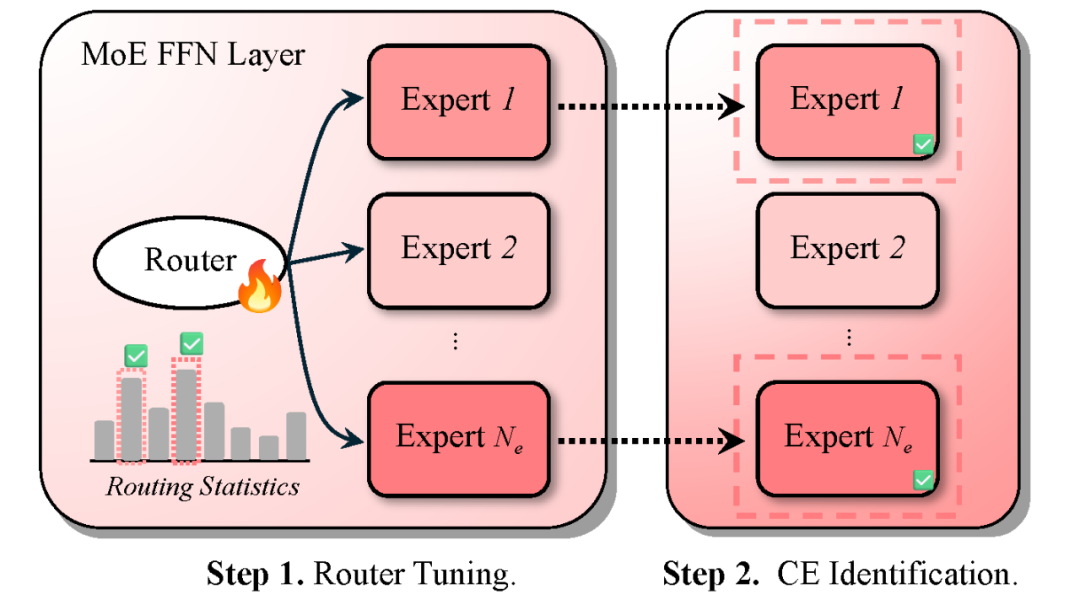

为解决这一问题,本文提出 MoE 特定专家的探测方法 RouterLens。我们假设:在上下文依赖任务中被更频繁激活的专家更善于利用上下文信息。然而,MoE 预训练中的负载均衡约束削弱了路由行为与专家特化能力间的可解释性,使得仅凭激活频率难以准确识别特定能力的专家。

为此,RouterLens 先在上下文依赖任务上进行轻量级路由微调(Router Tuning),以校正路由行为,使专家激活能更真实地反映不同专家的上下文利用能力差异。随后,统计各专家的激活次数,并认定 Top-K 专家为上下文忠实专家(图 3 )。

图3. RouterLens 鉴定专家的过程

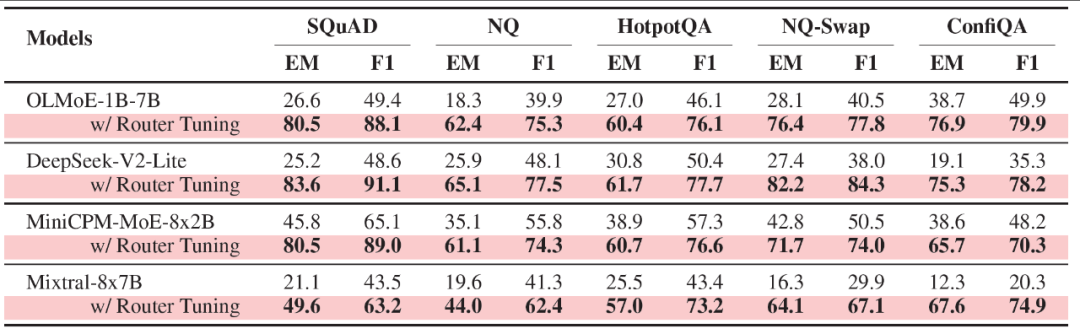

本文在 SQuAD、NQ 等上下文依赖任务上验证了 MoE 模型中上下文忠实专家的存在性。表 1 显示,经过路由微调后,模型在所有任务上的表现均显著提升,这说明仅调整专家激活行为即可增强上下文利用能力,证明了上下文忠实专家的存在。

表1 MoE 模型在路由微调(Router Tuning)前后的表现对比

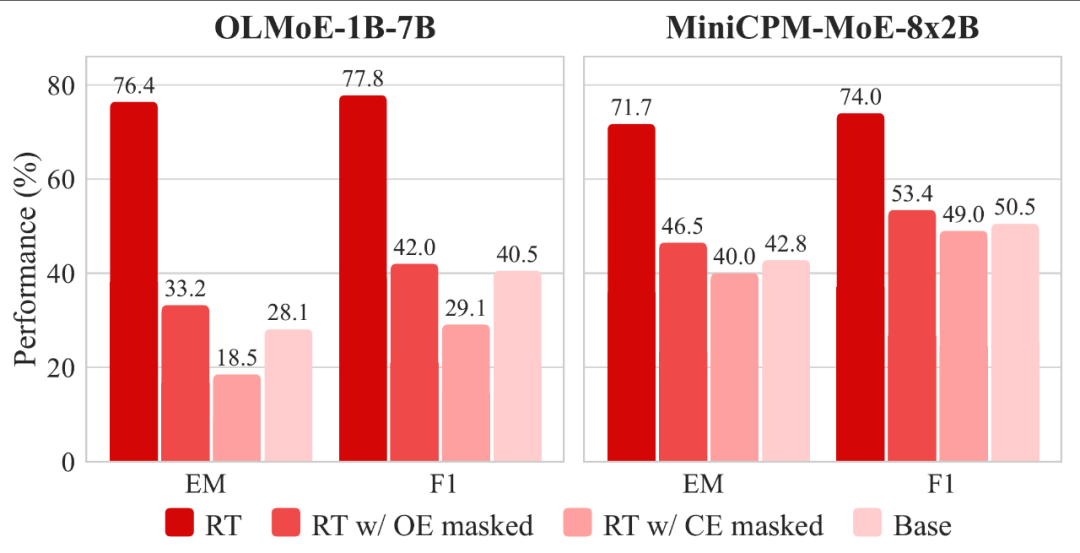

那么,RouterLens 鉴定出的专家是否具备更强的上下文忠实性?为验证这一点,我们还进行了屏蔽干预实验:在模型推理时屏蔽 RouterLens 鉴定的专家(CE masked),并与屏蔽原始路由激活的专家(OE masked)进行对比。

如图 4 所示,屏蔽 RouterLens 识别的专家后,模型性能显著下降,甚至低于未微调的基础模型,证明这些专家在上下文任务中的关键作用。相比之下,屏蔽原始激活专家的性能下降较小,进一步表明负载均衡训练削弱了路由与专家真实能力的对应关系。

图4. 基础模型(Base)、路由微调模型(RT),以及在路由微调模型上分别屏蔽原始激活专家(RT w/ OE masked)与屏蔽 RouterLens 鉴定专家(RT w/ CE masked)后的性能对比。

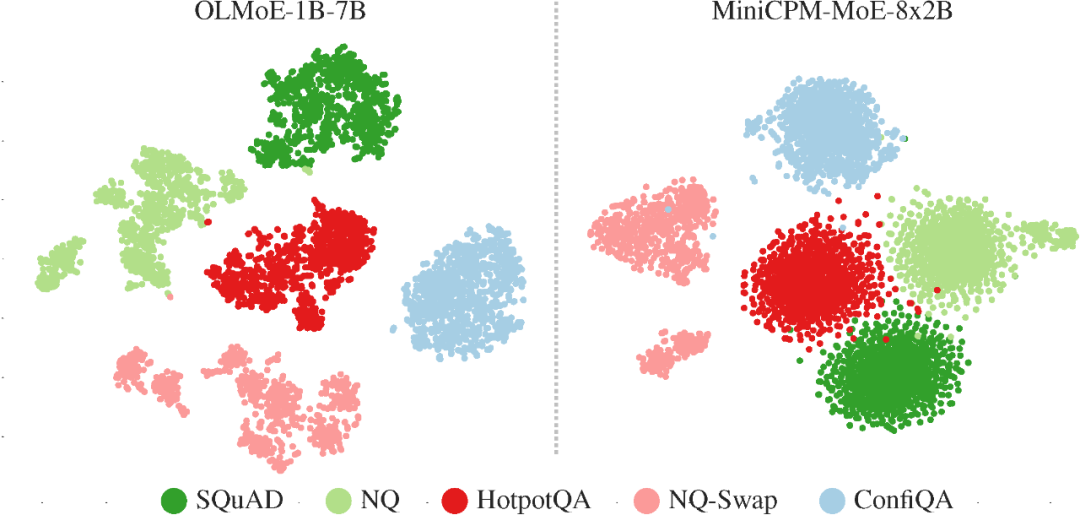

本文还分析了上下文忠实专家在不同任务间的分布特征,将各样本在所有层中专家激活频率拼接成特征向量并经 t-SNE 可视化。结果(图 5)显示,不同任务形成明显聚类,说明模型能根据任务需求自适应激活不同的上下文忠实专家。

图5. MoE 模型中上下文忠实专家激活模式的t-SNE可视化结果。

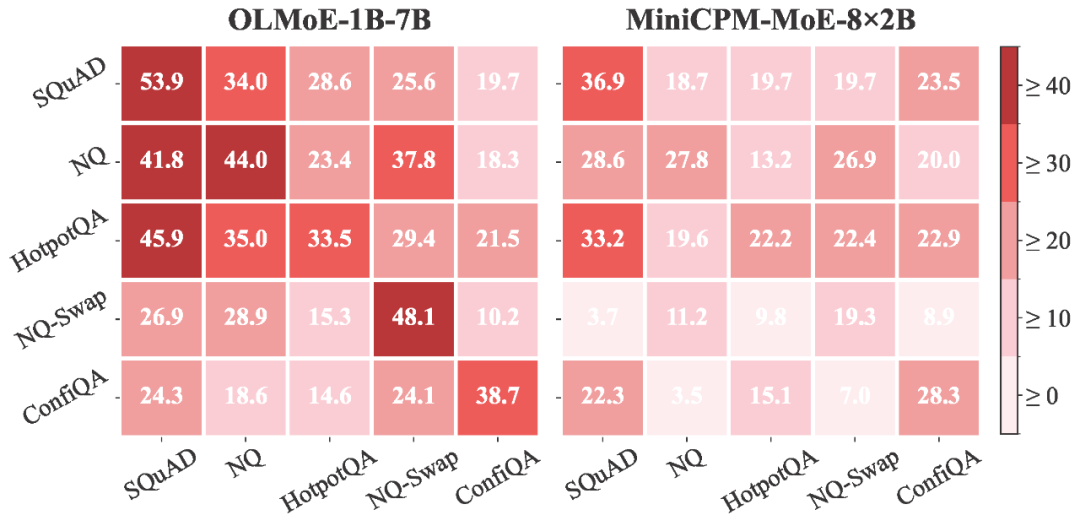

虽然上下文忠实专家是任务特定的,但调优后的路由网络能否泛化至新任务呢?论文将某数据集上调优的路由网络应用于其他数据集。结果(图 6)显示,模型在未见任务上仍显著优于原始模型,表明路由调优学到了具备泛化性的上下文忠实专家激活能力。

图6. 微调后路由网络的跨任务迁移性能。每个单元格表示相对于基准模型的 EM 得分绝对提升值,其中模型在第i行对应的数据集上训练,并在第 j 列对应的数据集上进行评估。

那么,上下文忠实专家是如何帮助 MoE 利用上下文的呢?直观上它们像一个信息枢纽,负责捕捉并整合输入中的上下文,从而提升下游推理与生成的效果。但要验证这一点,还需更细致地分析它们在计算流中的具体作用。

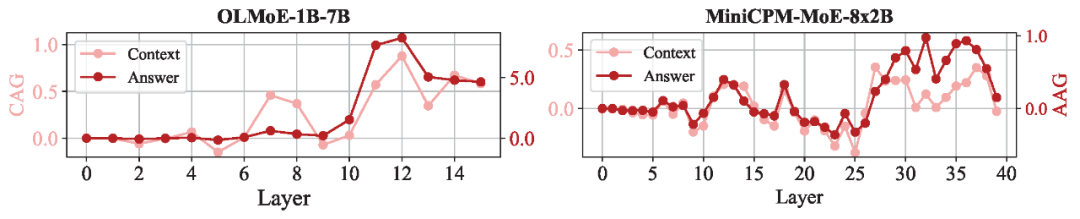

通常,自注意力被认为决定模型对上下文的感知。本文通过上下文注意力增益和答案注意力增益评估上下文忠实专家的作用。结果(图 7)显示,路由微调后的模型在中、深层显著增强了对上下文和答案 Token 的注意力。

图7. 在 NQ-Swap 测试集上,路由微调模型相较于基础模型在各层上的上下文注意力增益(CAG)和答案注意力增益(AAG)的变化趋势。

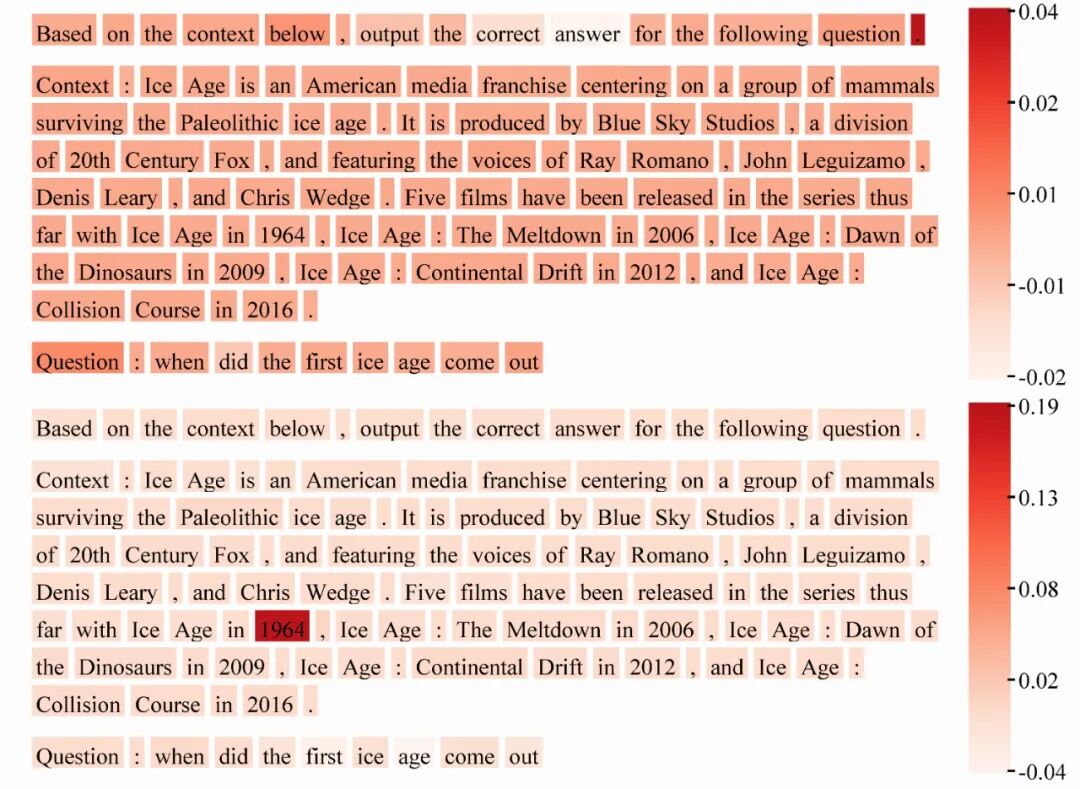

这种逐层的注意力增强现象反映出一种逐步思考的过程。如图8所示,中层的上下文忠实专家帮助模型首先在整个上下文中扩大注意力范围(相当于对信息进行“扫描”),以识别潜在的相关内容;而在更深层中,模型则会逐步收缩注意力焦点,集中关注于上下文中最关键的片段(即答案 “1964”)。

图8. OLMoE-1B-7B 模型在 NQ-Swap 测试样本上由上下文忠实专家带来的注意力增益。

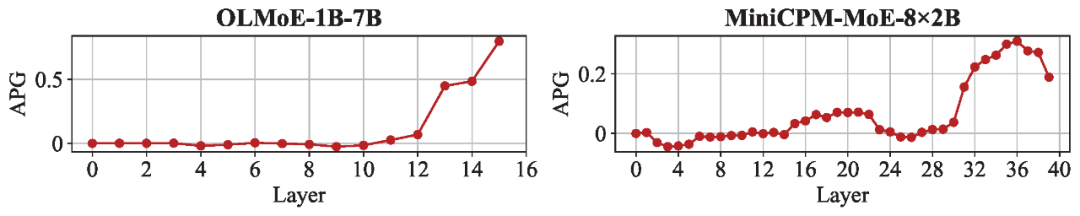

此外,我们还使用答案概率增益来分析上下文忠实专家对模型决策的影响。结果(图 9)显示,路由微调后模型在深层对正确答案的预测概率显著提升,表明这些专家通过强化对关键上下文与答案 Token 的注意力,提升了模型的信息整合与判断能力。

图9. 在 NQ-Swap 测试集上,路由微调模型相较于基础模型在各层答案概率增益(APG)的变化趋势。

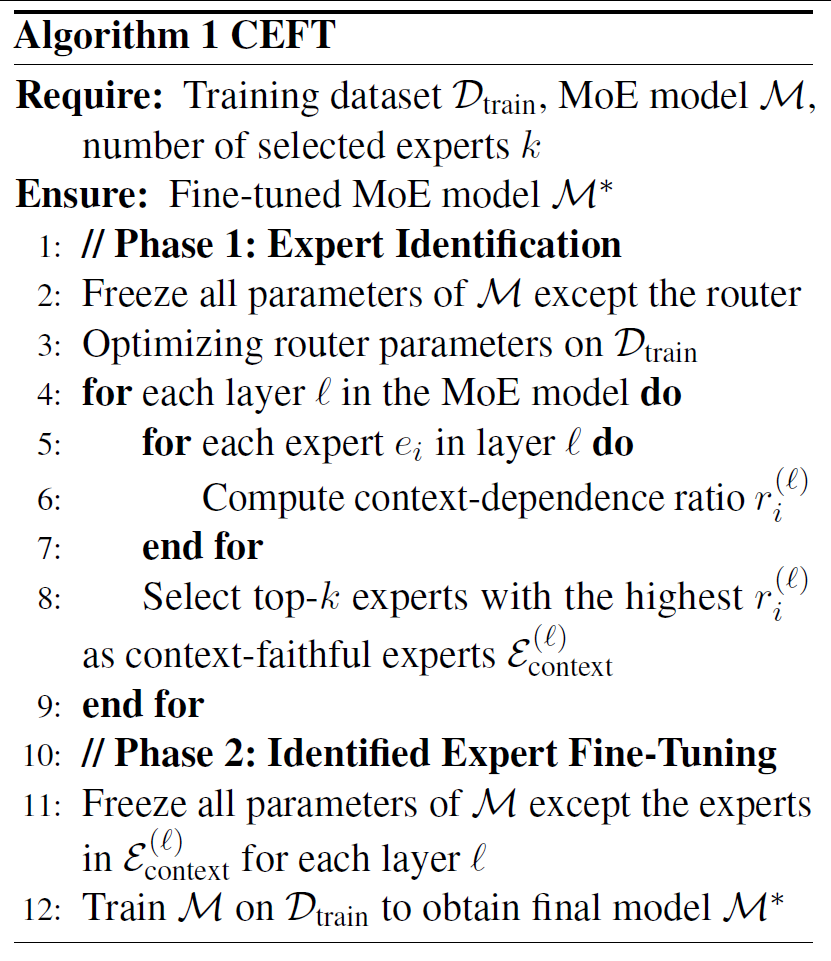

在明确上下文忠实专家的作用机制后,我们进一步提出利用它们提升模型性能的思路:将有限计算资源优先分配给上下文忠实专家,而非训练所有参数,从而实现高效优化。基于此,提出上下文忠实专家微调(CEFT),首先通过 RouterLens 识别各层的上下文忠实专家,然后仅微调这些专家,保持其余参数的冻结(算法 1)。

算法1. 上下文忠实专家微调

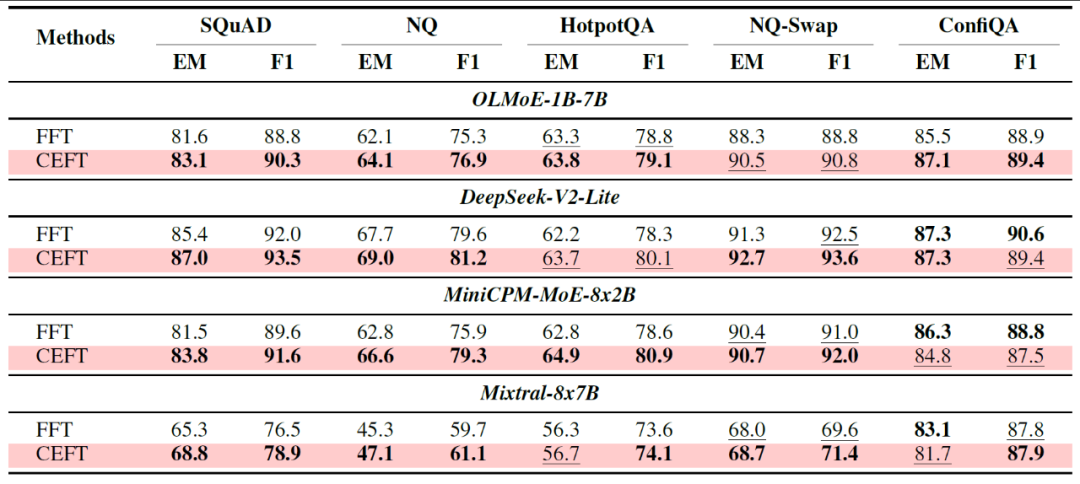

如表2所示,对比了 CEFT 与全量微调(FFT)的表现。可以观察到,在所有 MoE 模型和基准上,CEFT 一致地表现出与 FFT 持平甚至更优的表现,显示了其在利用上下文信息提升任务表现的有效性。

表2. 全量微调(FFT)与上下文忠实专家微调(CEFT)的表现对比。

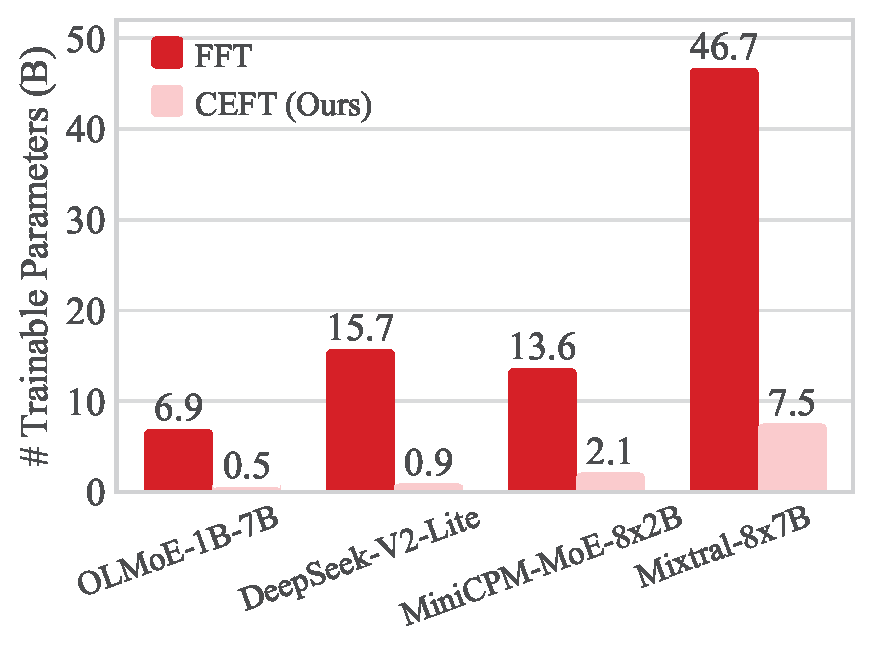

值得注意的是,该表现是在显著减少训练参数量的情况下实现的。如图10所示,OLMoE-1B-7B 模型在全量微调下需要训练 69 亿参数,而 CEFT 仅需5亿参数,实现了13.8倍的缩减。

图10. 全量微调(FFT)与上下文忠实专家微调(CEFT)的可训练参数量对比。

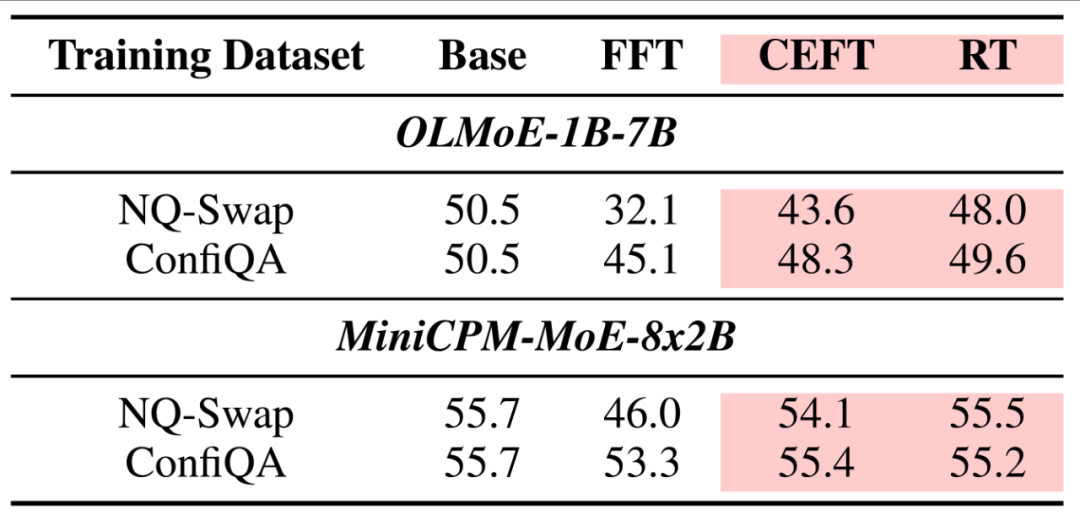

参数量显著减少不仅提升计算效率,也减轻了灾难性遗忘。表 3 显示,在 MMLU 上,路由微调(RT)、全量微调(FFT)和上下文忠实专家微调(CEFT)的性能下降与可训练参数量大致成正比,而 CEFT 对遗忘的抗性明显优于 FFT。

表3. MoE 模型在经过不同训练之后在 MMLU 基准上的表现。

随着 MoE 模型的广泛应用,RouterLens 还可被用于更多的研究。

首先,RouterLens 可用于识别与分析更多类型的专家,如推理、证明或编程专家。

其次,它还能定位表现不佳或易误导的专家,实现 MoE 的 “Debugging”。

最后,将 RouterLens 与 SAE 等机制可解释性技术结合,可深入理解专家行为与知识分布,提升模型的可解释性与可控性。

文章来自于“机器之心”,作者 “白骏、刘洋”。

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner