最近口述采样很火。如果您经常使用经过“对齐”训练(如RLHF)的LLM,您可能已经注意到一个现象:模型虽然变得听话、安全了,但也变得巨“无聊”。

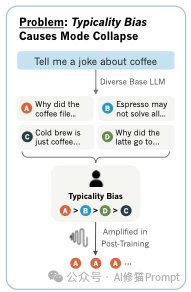

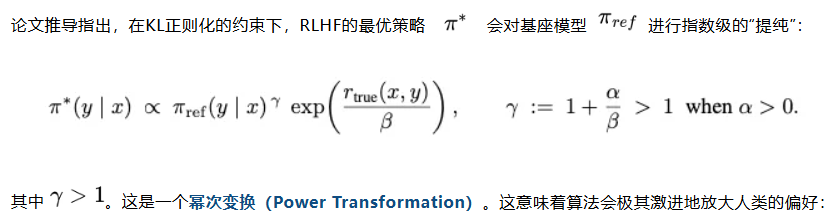

当您让它“讲一个关于咖啡的笑话”时,它可能总是反复讲那个关于“police report”的老梗;当您让它写诗时,它总是遵循某种固定的韵律和陈词滥调。这种现象在学术界被称为“模式崩溃”(Mode Collapse)。

很多研究者认为这是算法的问题,但斯坦福的这篇论文提出了一个颠覆性的观点:这不是算法的错,而是人类偏好数据中自带的“典型性偏差”在作祟。研究者提出了一种无需重新训练模型的巧妙解法——口述采样(Verbalized Sampling, VS)。其实就一句话。你耐心看完,把它拷走。

在深入解决方案之前,我们需要先知道为什么模型会失去多样性。过去的研究往往归咎于奖励模型不够好,或者强化学习的优化过程太激进。

但这篇论文的研究者通过心理学视角和数学推导,挖出了更深层的原因。

简单来说,典型性偏差(Typicality Bias)是指:人(也就是数据标注员)在评估文本时,会下意识地更喜欢那些“眼熟”、“通顺”、“符合常规套路”的内容,而排斥那些虽然正确但略显陌生的表达。

论文指出,这种偏差并非人类故意为之,而是根植于我们的认知心理学机制。我们的大脑并不是客观的“真理检测机”,而是充满了各种省力的捷径:

这意味着,当人类标注员在快速浏览大量数据进行打分时(这是RLHF的核心步骤),他们不仅仅是在选“对”的,更是在选“像标准答案”的。

为了让您更直观地理解这一点,让我们看一个具体的例子。假设我们要训练模型讲笑话,Prompt是:“讲一个关于咖啡的笑话。”

模型生成了两个回答:

“为什么咖啡要去警察局备案?因为它被马克杯抢劫了(mugged)!”

“意式浓缩咖啡可能解决不了你所有的问题,但值得一试。”

标注员会怎么选? 由于上述心理学机制,标注员在面对成千上万条数据时,会下意识地觉得回答A更好。因为它符合标注员对“笑话”的固有认知图式,处理起来更流畅。

于是,原本充满创意的回答B被打入冷宫,而千篇一律的回答A被奉为圭臬。

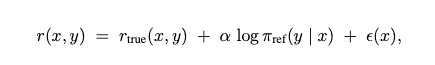

这种心理偏好在数据上留下了深刻的烙印。研究者提出了一个理论模型来描述这种带偏见的奖励函数:

研究者在HelpSteer数据集上做了一个非常硬核的验证:他们找出了数千对客观正确性完全一样的回答。结果令人震惊——即便正确性一样,人类标注员依然显著偏向于给那些“基座模型概率更高”(也就是更典型)的回答打高分。

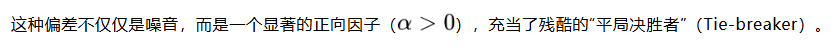

如果只是数据有点偏差,问题可能还没那么严重。但当这些数据被送入 RLHF(基于人类反馈的强化学习) 算法时,灾难发生了。

模式崩溃由此诞生。 这不仅仅是训练失误,而是RLHF算法机制处理数据偏差时的必然数学结果。最终,模型学会了:“只要我输出最像标准答案的那句话,我就能拿高分。”

既然问题出在“人类喜欢典型答案”这个根源上,且被数学机制放大了,那该怎么办?

研究者提出,我们可以通过改变提问的方式(Prompting Strategy)来绕过这个限制。这就是口述采样(Verbalized Sampling, VS)。

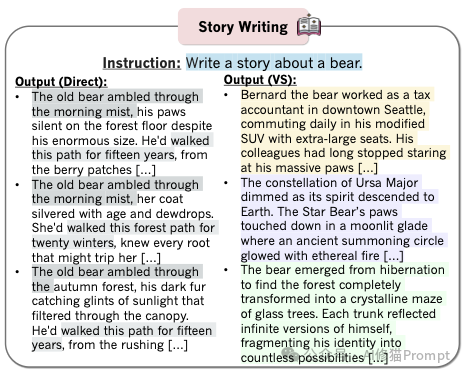

传统的提问方式(Direct Prompting)是让模型生成一个具体的实例。但在模式崩溃的状态下,模型只会给您那个概率最高的“典型实例”。

VS的核心在于: 明确要求模型用语言描述出一个包含概率的响应分布。

让我们通过一个具体的例子来看看VS是如何操作的:

“讲一个关于咖啡的笑话。”

“生成5个关于咖啡的笑话,并给出它们对应的概率。”

为什么这招有效? 研究者证明了一个关键理论:不同的提示词会坍缩到不同的“模式”上。

换句话说,VS能够唤醒模型沉睡的“潜意识”,帮它找回预训练时期那丰富多彩的记忆。

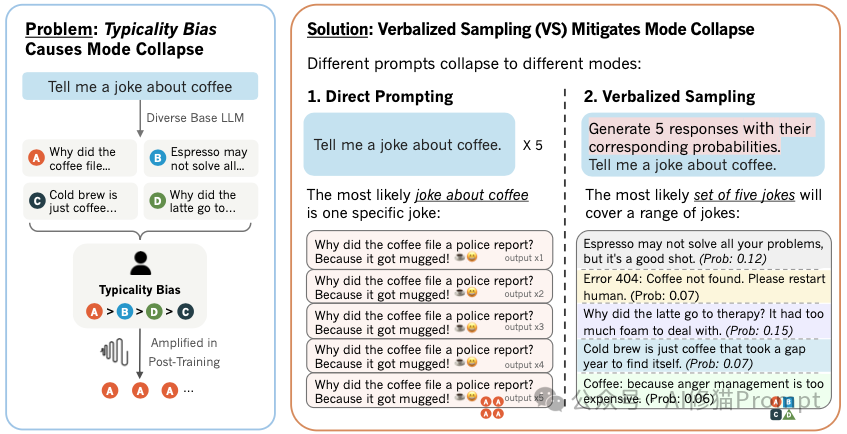

如果您想在自己的应用中复现这个效果,可以参考论文提供的标准Prompt模板(以VS-Standard为例):

System Prompt: Generate 5 responses to the user query, each within a separate <response> tag. Each <response> must include a <text> and a numeric <probability>. Please sample at random from the tails of the distribution, such that the probability of each response is less than 0.10.

</instructions>

Write a short story about a bear.

研究者还测试了两种进阶变体:

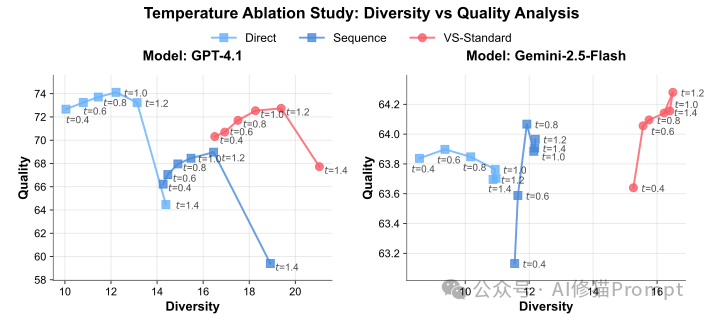

您可能会问:“如果只是为了多样性,我把解码参数里的Temperature调高不就行了吗?”

论文通过消融实验给出了否定的答案。VS与温度采样是正交且互补的关系,而非替代品。

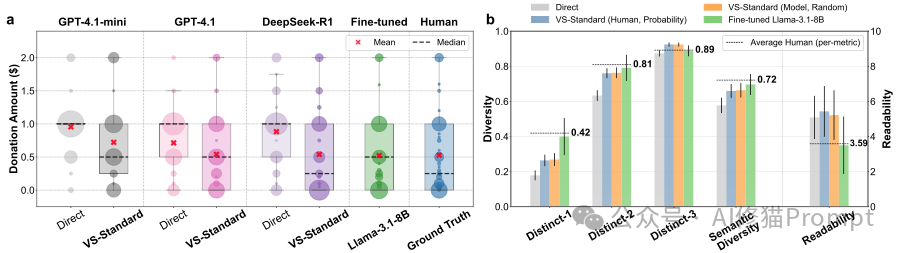

研究者在创意写作、对话模拟、开放问答等多个领域进行了严苛的测试。结果表明,VS不仅能大幅提升多样性,而且没有牺牲质量。

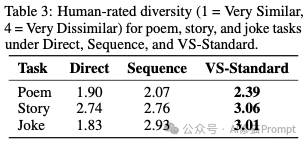

在写诗、写故事和写笑话的任务中,VS展现了压倒性的优势:

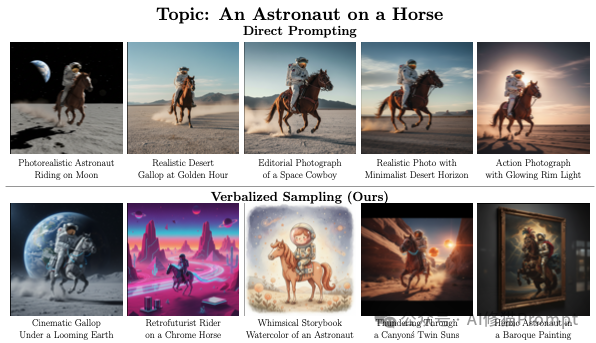

生动案例: 在“写一个关于宇航员骑马的图像提示词”任务中:

在模拟“劝捐对话”时,直接提示的模型往往表现得像个机器人,甚至在捐款金额上都表现出极度的单一性(例如总是捐1美元)。

而使用了VS的模型:

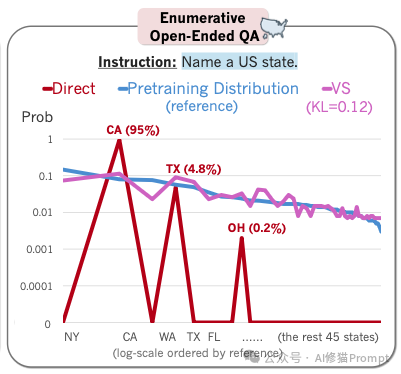

这是一个非常硬核的测试。研究者问模型:“列举一个美国的州”。

这意味着VS成功地把模型从“只会说加州”的刻板印象中解救了出来,恢复了它对真实世界的认知分布。

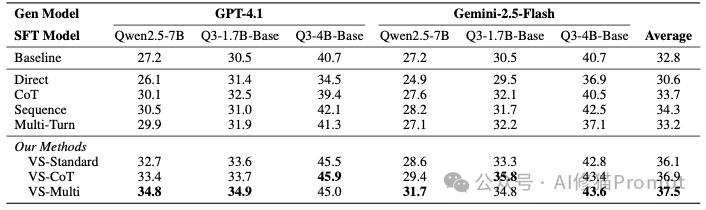

在用大模型生成数据来训练小模型(如Qwen2.5-7B)的实验中:

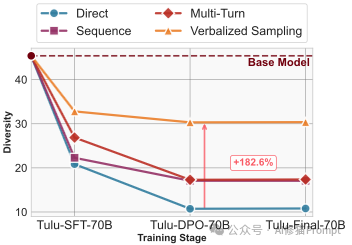

模型在从SFT(监督微调)到DPO(直接偏好优化)再到RLVR的演进过程中,通常会付出惨重的“创造力代价”。

论文的纵向分析显示:

这有力地证明了VS是对抗对齐带来的创造力损失(Alignment Tax)的有效手段。

您可能会担心:让模型变得更多样化,会不会导致它开始胡言乱语,甚至绕过安全机制输出有害内容?

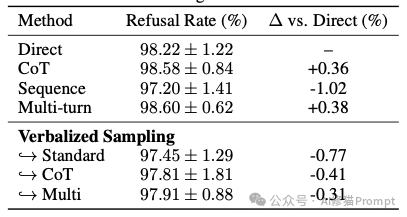

研究者在StrongReject基准上测试了353个有害提示。

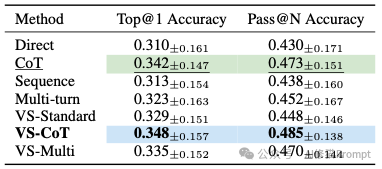

在SimpleQA常识推理测试中,VS的准确率(Top@1 Accuracy和Pass@N)与最强的基线方法(CoT)相当,并没有因为追求多样性而产生更多的幻觉。

VS还带来了一个意外之喜:您可以手动调节多样性的“阀门”。

通过在Prompt中加入概率阈值限制(例如:“只采样概率小于0.1的回答”),您可以强制模型去探索那些“长尾”的、更冷门的知识领域。实验显示,随着概率阈值的降低,输出的多样性呈线性上升趋势。这是传统方法完全无法做到的。

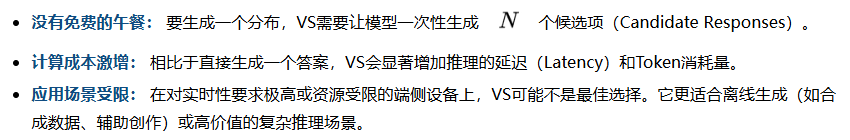

虽然VS效果显著,但我们在应用时也必须清醒地认识到它的代价,正如论文在局限性章节所指出的:

这篇论文通过严谨的理论和实验,为我们揭示了LLM “变笨”的一个重要原因——为了迎合人类的典型性偏好,模型牺牲了它原本广博的可能性。

给您的建议:

如果您在实际应用中(无论是开发RPG游戏NPC、创意写作助手,还是生成合成数据)发现模型总是“车轱辘话来回说”,不妨试着改写您的Prompt:

这不仅是一个技术技巧,更是一种与AI交流的新哲学:与其把它当作一个只会给标准答案的搜索框,不如把它看作一个拥有丰富可能性的概率库。提示工程并没有消失,它只是简化了,可能就是一句话,但这是迈向一个新时代的开始。。。

文章来自于“AI修猫Prompt”,作者 “AI修猫Prompt”。

【开源免费】DeepBI是一款AI原生的数据分析平台。DeepBI充分利用大语言模型的能力来探索、查询、可视化和共享来自任何数据源的数据。用户可以使用DeepBI洞察数据并做出数据驱动的决策。

项目地址:https://github.com/DeepInsight-AI/DeepBI?tab=readme-ov-file

本地安装:https://www.deepbi.com/

【开源免费】airda(Air Data Agent)是面向数据分析的AI智能体,能够理解数据开发和数据分析需求、根据用户需要让数据可视化。

项目地址:https://github.com/hitsz-ids/airda

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0