今年以来,开源项目LightX2V 及其 4 步视频生成蒸馏模型在 ComfyUI 社区迅速走红,单月下载量超过 170 万次。越来越多创作者用它在消费级显卡上完成高质量视频生成,把“等几分钟出一段视频”变成“边看边出片”。

LightX2V 背后并不是单一模型的优化,而是一整套面向低成本、强实时视频生成的推理技术栈:从步数蒸馏与轻量VAE,到低比特算子、稀疏算子、多卡并行与分级Offloading,目标只有一个——在主流硬件上,把视频生成推到 1:1 实时。

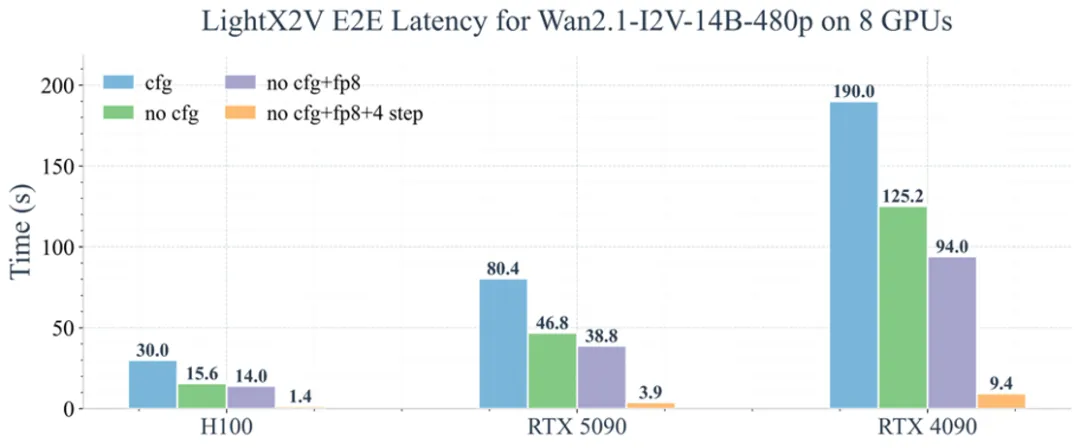

在很多视频生成框架中,生成 5–10 秒视频依然需要几分钟时间。LightX2V 在相同分辨率和硬件条件下,通过极少步数的推理和系统级优化,将生成时间压缩到与视频时长接近的水平 (如上图端到端耗时所示),实现接近 1:1 的实时体验。

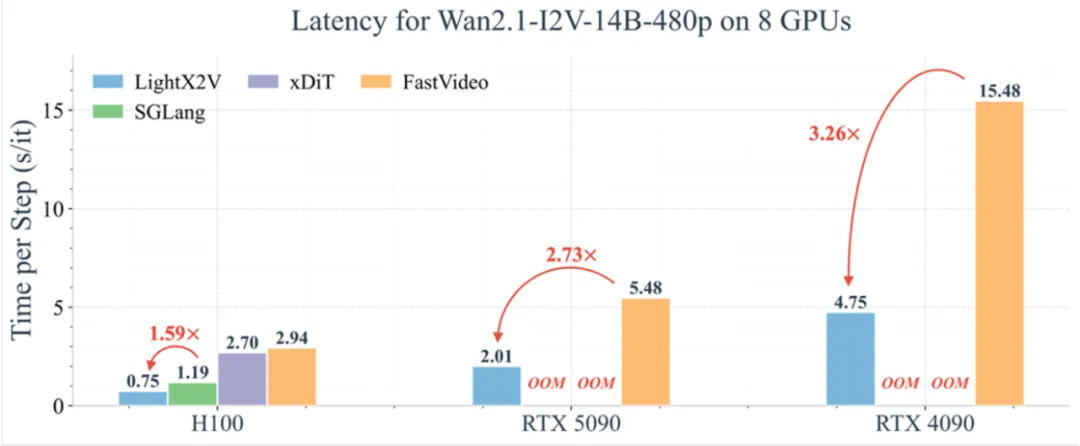

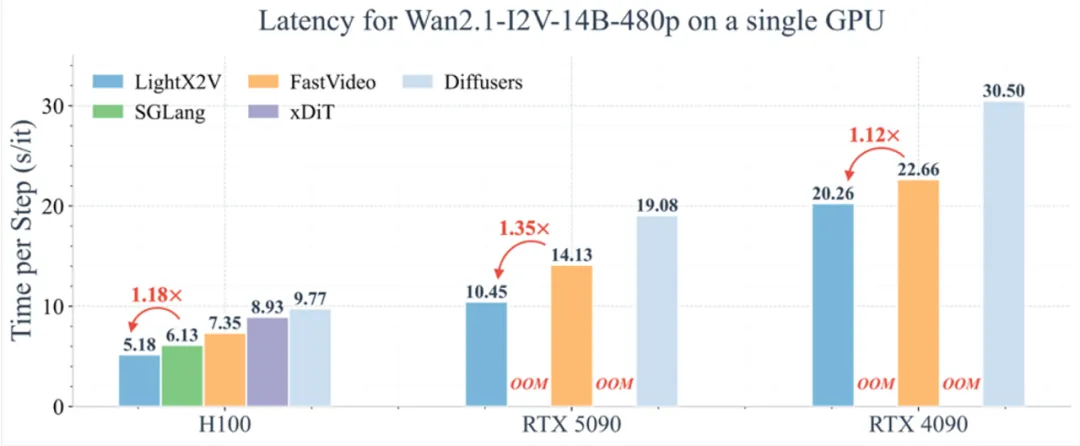

在同类开源方案中,LightX2V 相比 SGLang Diffusion, FastVideo 等优秀的开源框架在延迟和吞吐上都具有明显优势 (如下图单步耗时对比所示),尤其是在 8GB–24GB 消费级显卡区间,更容易跑满硬件能力。

LightX2V 的速度并不是简单 “少采样几步” 得到的,而是通过两项关键算法协同设计:

LightX2V 自研的 Phased DMD 步数蒸馏,把原本 40–50 步的视频扩散过程压缩到 4 步,同时保持时间一致性和运动细节。基于这一技术产出的少步模型(如 Wan2.1 / Qwen-Image 等)已经在 Hugging Face 趋势榜中长期靠前,累积下载量达到百万级。

针对视频生成场景对吞吐和分辨率的双重需求,LightX2V 设计了极致轻量的 LightVAE。与常规 VAE 相比,在保持高清画质和时间一致性的前提下,有效降低了编解码开销,为 4 步推理释放出更多预算。

这两部分相当于在 “算法上先把路打通”,再让后续工程优化尽可能榨干硬件性能。

在算法压缩完成后,LightX2V 通过一套全栈推理框架,把 “能跑” 变成 “跑得快、跑得省”:

关键技术模块包括:

这些技术叠加,使 LightX2V 不仅在单机单卡上易于部署,也可以顺畅扩展到多卡集群。

为了方便创作者直接受益于上述优化,LightX2V 面向主流模型和硬件做了系统支持:

在实际使用上,LightX2V 覆盖了从个人到企业的不同需求:

从图像转视频、文本转视频,到世界模型和自动驾驶仿真,LightX2V 试图用开源的方式,把 “高质量、低成本、强实时” 的视频生成能力交到更多人手里。

文章来自于“机器之心”,作者 “机器之心”。

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)