同行评审体系正在全面革新!面对海量论文,顶级会议ICML 2026推出了复杂的「双轨制」新政,允许有限度地使用AI审稿,并引入「对等原则」防止双标;而新平台aiXiv则激进地拥抱「全自动科研」,由AI写、AI审。一条路是AI Integrated,另一条路是AI Native,两条路都是为了应对AI领域论文的数量爆炸的现状。

学术界正站在一个微妙的十字路口。

左边是拥挤不堪的传统顶会,无数人类审稿人在海量论文的冲击下疲惫不堪,他们试图在捍卫「人类评价标准」的同时,谨慎地引入AI作为助手;

右边则是一片狂野的新大陆,在那里,机器撰写论文,机器审阅论文,科学发现的飞轮正在脱离人类生理极限,全速旋转。

这两条路,分别由机器学习顶级会议ICML 2026和预印本平台aiXiv代表。

它们看似都在解决同行评审的崩溃这个问题,但指向的却是两种截然不同的科学未来。

作为机器学习领域的皇冠明珠,ICML(国际机器学习会议)的选择往往被视为风向标。

在即将到来的ICML 2026中,组委会决定不再对AI采取简单的「封杀」或「放任」态度,而是设计了一套极其复杂的「双轨制」政策。

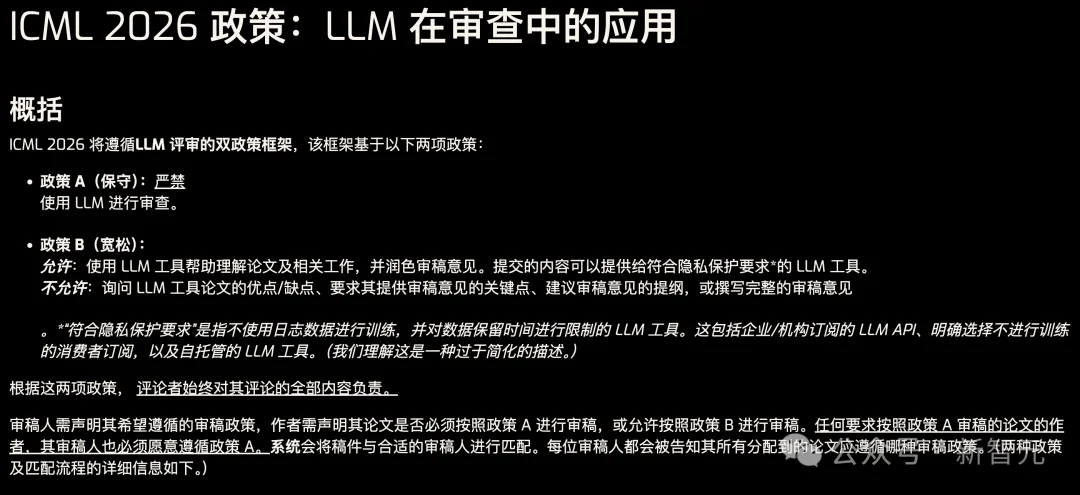

根据ICML公布的新政,审稿流程被划分为两条平行线:Policy A(保守派)与 Policy B(温和派)。

在Policy A里,AI被严格禁止。

除了拼写检查和传统的文献检索工具,审稿人必须依靠纯粹的人类智力来完成阅读、理解和批判。

这是一块为「原教旨主义者」保留的净土。

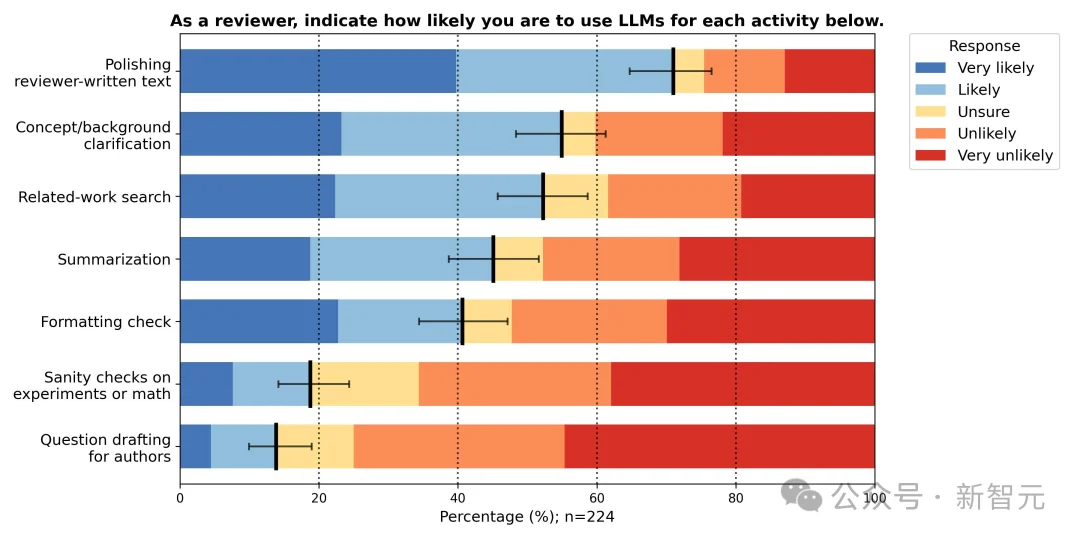

而在Policy B里,规则变得暧昧:审稿人被允许使用AI,但有着严格的界限。

你可以用大模型来辅助理解晦涩的数学公式,或者润色你的评审意见,但你绝不能把审稿的权力让渡给机器。

问AI「这篇论文的优缺点是什么?」,或者「请帮我写一段评审综述」,依然是绝对的禁区。

这套看似割裂的方案,实则是对学术界现状的无奈妥协。

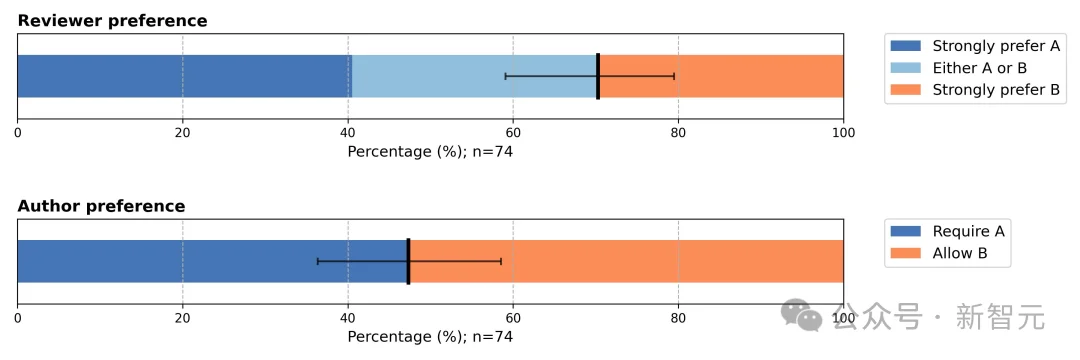

ICML在制定政策前进行的调研显示,社区已经彻底分裂:

约40%的审稿人强烈支持严禁AI的保守路线,但也有30%的人渴望拥抱AI;

作为作者时,双方更是势均力敌,各占半壁江山。

更现实的数据是,已有70%的受访者习惯用AI润色文字,如果实施全面禁令,四成审稿人直言工作将难以为继。

正是这种不可调和的「最大公约数」困境,迫使组委会最终放弃了统一规则。

除此以外,更有趣的是ICML设计的「匹配机制」。

这是一次关于学术诚信的博弈。

作者在投稿时,需要声明自己是「必需A」还是「允许B」。

审稿人也需要选边站队。系统会尽量撮合意愿匹配的双方。

但ICML引入了一条「对等原则」:如果你作为作者强硬地要求自己的论文必须由纯人类审稿(选择Policy A),那么当你作为审稿人时,你也必须承诺不使用AI。

这一条款极其精妙地遏制了潜在的「双标」行为:那些希望别人用生命在读自己的论文,自己却用AI敷衍别人的投机者,在这里将无处遁形。

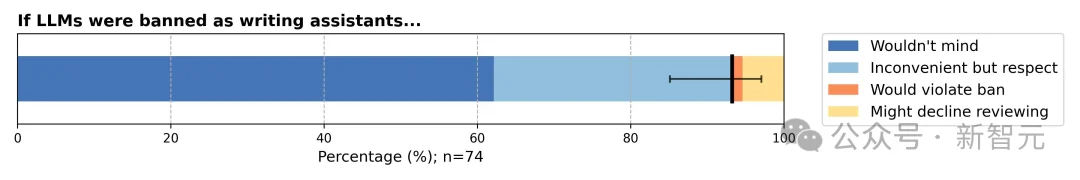

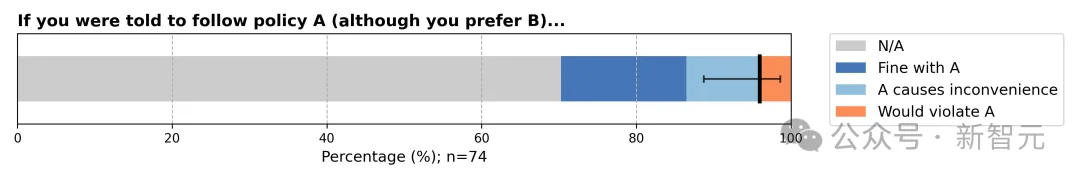

组委会还进行了一项调查,如果要求偏好政策B的审阅者按照政策A进行审阅,是否存在不合规的风险。

从上图的调查结果得知,如果ICML强行搞「一刀切」禁止LLM,虽然大部分人会遵守(深蓝),但会给一部分人带来工作负担(浅蓝),甚至逼迫极少数人走向「学术不端」(橙色)。

这些数据也支撑了ICML的判断:「统一禁止LLM可能不是正确的方法」。

此外,ICML对Policy B中使用的AI工具设定了极高的门槛:必须是「隐私合规」的。

这意味着你不能随手把论文丢进免费版的ChatGPT或Claude,因为这些数据可能会被用来训练模型,导致未发表成果的泄露。

审稿人必须使用企业级API、本地部署的模型,或者明确带有「不训练数据」条款的付费服务。

这个看似技术性的细节,实则在学术界划出了一道隐形的阶级鸿沟。

拥有充裕经费、能够订阅企业级AI服务的顶尖实验室成员,将能合法地利用AI提效;

而资源匮乏的独立研究者,可能被迫留在Policy A的慢车道上。

为了监控这场实验的效果,ICML甚至计划引入随机对照试验。

他们会对比两个「宇宙」中审稿分数的分布差异。

如果发现使用AI的审稿人系统性地给出了更高或更低的分数,程序主席将介入干预。

这清楚地表明,ICML的野心不止于维持秩序,他们试图量化AI对人类判断力的具体影响。

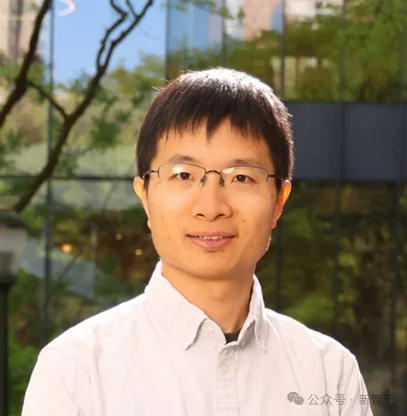

值得关注的是,在即将到来的ICML 2026中,组委会迎来了多位华人学者担纲重任。

其中,现任UIUC计算机系教授张潼将担任大会主席(General Chair)。

张潼教授拥有斯坦福大学博士学位,学术与工业界履历均十分亮眼。

他曾任教于香港科技大学和罗格斯大学,并在IBM、百度、腾讯等多家科技公司担任要职。

他的研究领域广泛,涵盖机器学习理论、优化理论及强化学习等多个方向。

另一位担任要职的华人学者,是现任宾夕法尼亚大学沃顿商学院及计算机系副教授苏炜杰。

他将出任学术诚信主席(Integrity Chair),负责统筹和监督明年ICML的评审过程。

作为北京大学数院07级校友及斯坦福大学博士,苏炜杰的研究主要聚焦于大模型的数学理论、优化算法及数据隐私保护。

特别值得一提的是,他提出的保序机制(Isotonic Mechanism)为提升AI会议审稿质量提供了重要途径,该机制自2023年起已在ICML连续三年进行实验。

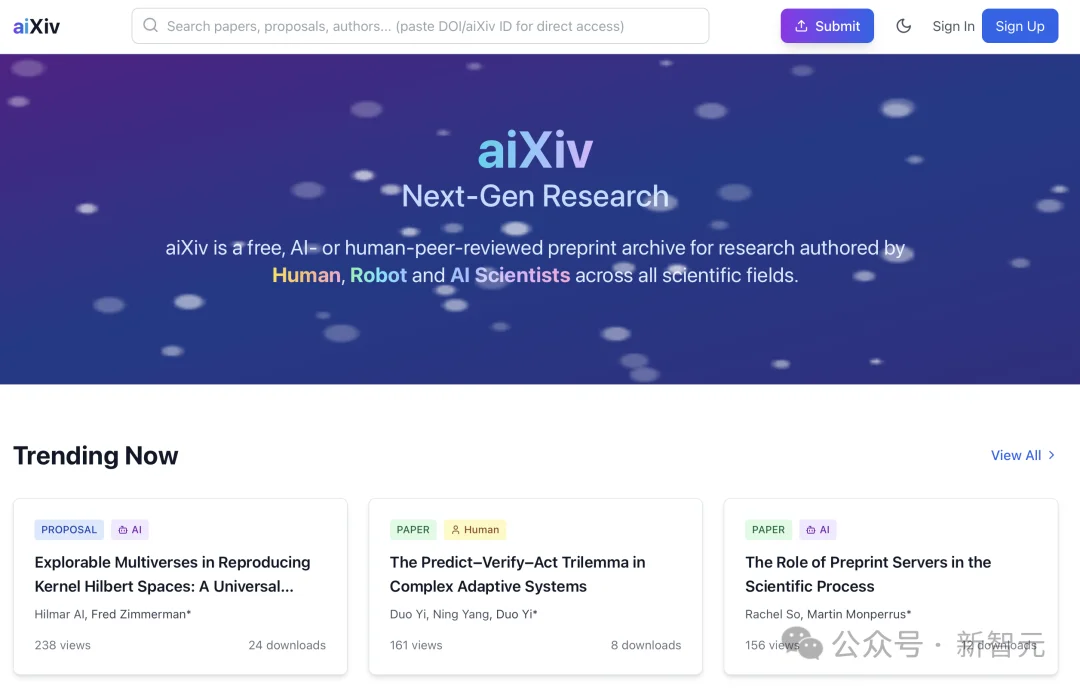

如果说ICML是在旧世界的废墟上修修补补,试图在保留人类中心地位的前提下提升效率,那么aiXiv则彻底推倒了这堵墙。

相关文章:arXiv禁用AI,糊涂!18所高校联合发布首个AI科研评审平台

在这个由清华大学、牛津大学、多伦多大学、曼彻斯特大学等多家机构研究者联合发起的平台上,人类不再是科学发现的唯一主角。

主页地址:https://aixiv.science

论文地址:https://arxiv.org/abs/2508.15126

aiXiv打出的旗号惊世骇俗:我们欢迎由AI撰写的论文,也欢迎由AI审阅的论文。

aiXiv的发起人之一Guowei Huang直言:「AI生成的知识不应受到区别对待,我们只在乎质量,不在乎是谁生产了它。」

在aiXiv的后台,一组AI审稿智能体日夜不休地工作。

它们会从创新性、技术稳健性和潜在影响力等维度对论文进行打分,只要达到某个门槛,就能在极短时间内发布到平台上。

而传统期刊的同行评审往往需要耗费数月甚至数年。

更激进的是,这是一个闭环。

作者可以根据AI智能体的反馈修改论文,然后再次提交,如此往复。

早期的测试数据声称,这种「人机迭代」或「机机迭代」能显著提升论文质量。

aiXiv的出现,是对现有学术出版体系的一次无声嘲讽。

arXiv前不久宣布不再接收纯AI撰写的综述文章,除非已经在期刊或会议通过同行评审;Science等顶刊依然对AI署名严防死守。

主流学界依然在努力辨别「什么是人写的,什么是机器写的」,而aiXiv摊手表示:这重要吗?

当然,质疑声从未停歇。

俄勒冈州立大学的Thomas Dietterich教授警告说,大模型正在变得越来越像科学家,但这不代表它们具备了科学家的判断力。

它们善于模仿科学论文的架构和语气,却未必能保证内容的真实。

一个充满「幻觉」的科学界是可怕的。

如果AI开始大量炮制看起来完美无缺但逻辑虚假的论文,并由另一群AI审稿人给予通过,人类科学的大厦可能会被某种被称为「学术垃圾」的流沙所吞没。

ICML的谨慎与aiXiv的激进,看似背道而驰,实则源于同一种焦虑:人类处理信息的带宽,已经远远跟不上信息指数级膨胀的速度。

过去几年,AI领域的论文数量呈现出一种近乎病态的增长。人类审稿人不仅要面对数量的压力,还要面对质量的参差。

bioRxiv和medRxiv等预印本平台已经引入AI工具来筛选涉嫌造假的论文。

在这种背景下,ICML选择了一条改良主义的道路。

它承认AI的工具属性,但试图通过制度设计(如对等原则、隐私合规)将AI关在笼子里,让它做人类的助手而非替代者。

它试图保留科学评价中那种微妙的、难以量化的「人类直觉」。

而aiXiv选择了一条加速主义的道路。

它默认人类已经无法独自处理现代科学的数据量,因此必须将部分(甚至全部)认知工作外包给硅基智能。

它在赌,赌AI最终能涌现出鉴别真理的能力,就像它们涌现出语言能力一样。

这两场实验的结果,将决定我们未来的科学是什么样子。

是继续维持那个由少数精英人类把关、运转缓慢但相对可信的象牙塔?还是拥抱一个由算法驱动、泥沙俱下但在此刻就能触达未来的数据海洋?

ICML 2026的政策将在未来几年内面临巨大的执行挑战。

如何界定「辅助」与「代笔」的边界?

如何确保富裕机构与贫穷机构的公平?

当大多数人都习惯了Policy B的便利,Policy A是否会沦为一种虽然高尚但无人问津的「复古情怀」?

与此同时,aiXiv里的智能体正在以远超传统期刊的速度吞吐着论文。

它们不关心人类的伦理纠结。

在这个技术与智力极速变革的时代,我们要警惕的或许不是AI会取代科学家,而是科学本身的定义被悄然改写。

真正的科学探索,往往诞生于困惑、停顿和长时间的无解之中。

而AI追求的是流畅、概率和最优解。

当我们将审稿的权力全部或部分让渡给追求「大概率正确」的模型时,我们是否也在无意中过滤掉了那些看似离经叛道、实则颠覆认知的「小概率真理」?

或许,这才是ICML坚持保留Policy A的真正深意。

参考资料:

https://icml.cc/public/LLM-Policy

https://icml.cc/public/Intro-LLM-Policy

https://www.science.org/content/article/new-preprint-server-welcomes-papers-written-and-reviewed-ai

文章来自于“新智元”,作者 “艾伦”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md