长期以来,AI生图被一个经典矛盾困扰。

潜空间模型效率高,但细节有损耗;像素空间模型保真度高,却容易结构混乱、速度慢。

要么快要没准,大家几乎默认这是架构带来的取舍问题,没法彻底解决。

但扩散模型生图,顺序真的对吗?

李飞飞团队最新论文提出的Latent Forcing方法直接打破了这一共识,他们发现生成的质量瓶颈不在架构,而在顺序。

简单说就像画画必须先打草稿再填色,AI也需要一个「先定结构、后填细节」的强制逻辑。

Latent Forcing仅通过重排生成轨迹,像素扩散模型不仅找回了效率,更在多项指标上刷新SOTA。

在深入了解Latent Forcing之前,咱先来说说当前两大方法的瓶颈。

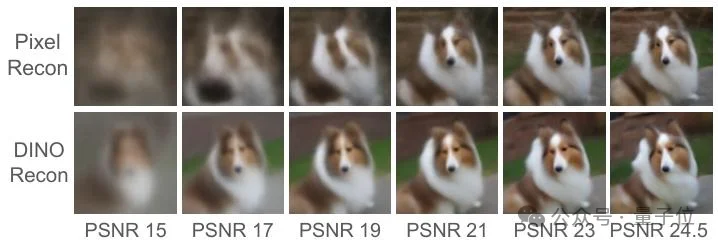

传统像素级扩散模型之所以画图会画歪,是因为它在降噪过程中,高频的纹理细节往往会干扰低频的语义结构。

模型常常在还没搞清楚物体的整体轮廓时,就被迫去预测局部的像素颜色,其实这在本质上就违背了视觉生成的自然逻辑。

为了解决这个问题,行业此前大多转向潜空间。

它通过预训练的tokenizer把图像压到低维空间,生成速度飞起。

但潜空间模型必须依赖一个预训练的解码器,但这不仅会引入重建误差,也让模型失去了端到端建模原始数据的能力。

于是李飞飞团队思考——

能不能既保留像素级的无损精度,又获得潜空间的结构引导?

Latent Forcing的答案是——

对扩散轨迹重新排序。

怎么做的呢?

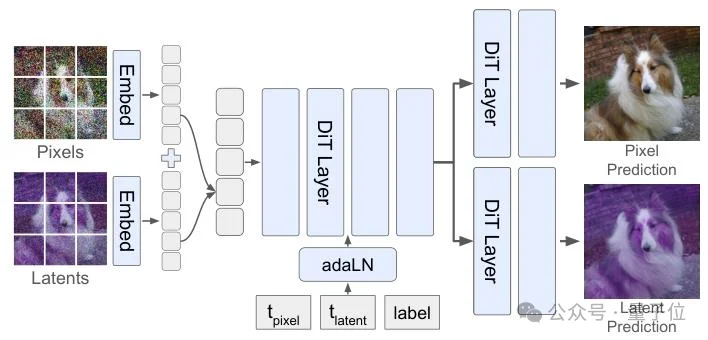

在不改变基础Transformer架构的前提下,引入了双时间变量机制。

在训练和生成过程中,模型会同时处理像素和潜变量。不同的是,团队为两者定制了独立的降噪节奏:

这么一看,潜变量就像是一个临时的草稿本。

生成结束时,这个草稿本直接丢弃,最终输出仍是100%无损的原始像素图像,没有任何decoder。

整个过程端到端、可扩展,几乎不增加计算量(token数量不变,速度接近原生DiT)。

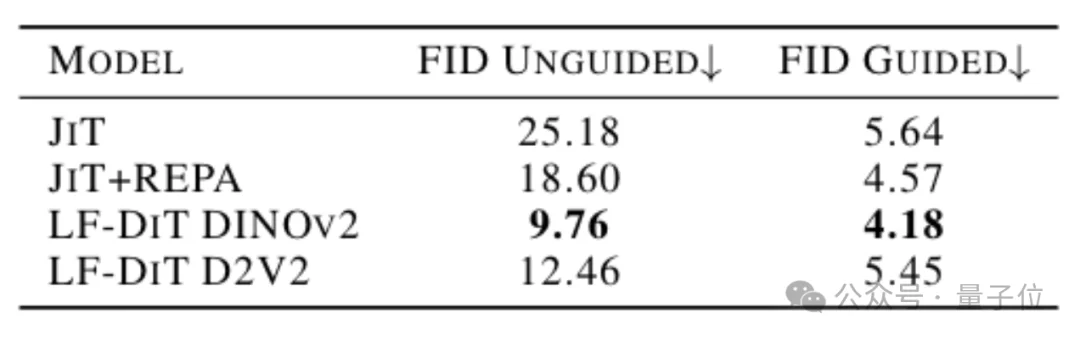

这种先latent后pixel的细微调整,在ImageNet榜单上展现了出色的表现。

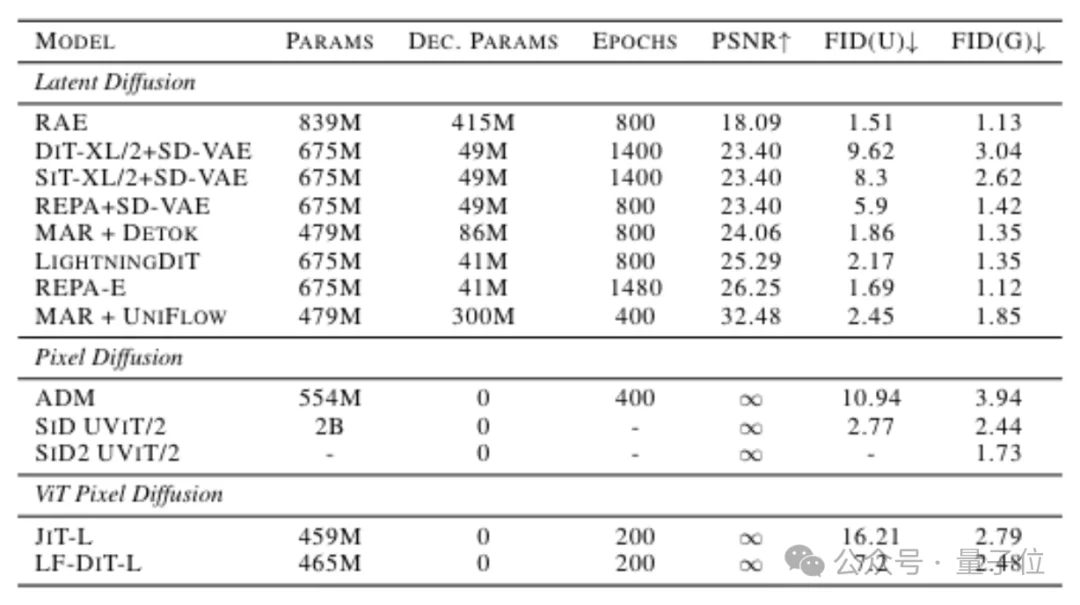

在相同计算规模,训练80个epochs的条件下,Latent Forcing在ImageNet-256任务中,条件生成的FID分数较此前最强的像素级模型JiT+REPA,从18.60降到9.76,接近腰斩。

在200个epoch的最终模型(ViT‑L 规模)下,Latent Forcing实现了条件生成FID 2.48(guided)、无条件生成FID 7.2(unguided)的分数。

创下像素空间扩散Transformer新的SOTA。

过去学术界普遍认为,必须通过更高倍率的有损压缩才能换取好的FID表现。

Latent Forcing则用数据反驳了这一观点——

在保持100%原始像素精度的情况下,我们依然能跑出超越有损模型的性能。

Latent Forcing项目由李飞飞领衔。

第一作者Alan Baade是李飞飞的学生,斯坦福计算机系博士生,在扩散模型和生成建模方向有深入研究。

其他斯坦福共同作者包括Eric Ryan Chan、Kyle Sargent、Changan Chen和Ehsan Adeli。

此外,密歇根大学教授Justin Johnson作为合作作者参与其中。

论文地址:https://arxiv.org/abs/2602.11401

文章来自于微信公众号 "量子位",作者 "量子位"