轻松进行动态图异常检测,南洋理工提出GeneralDyG

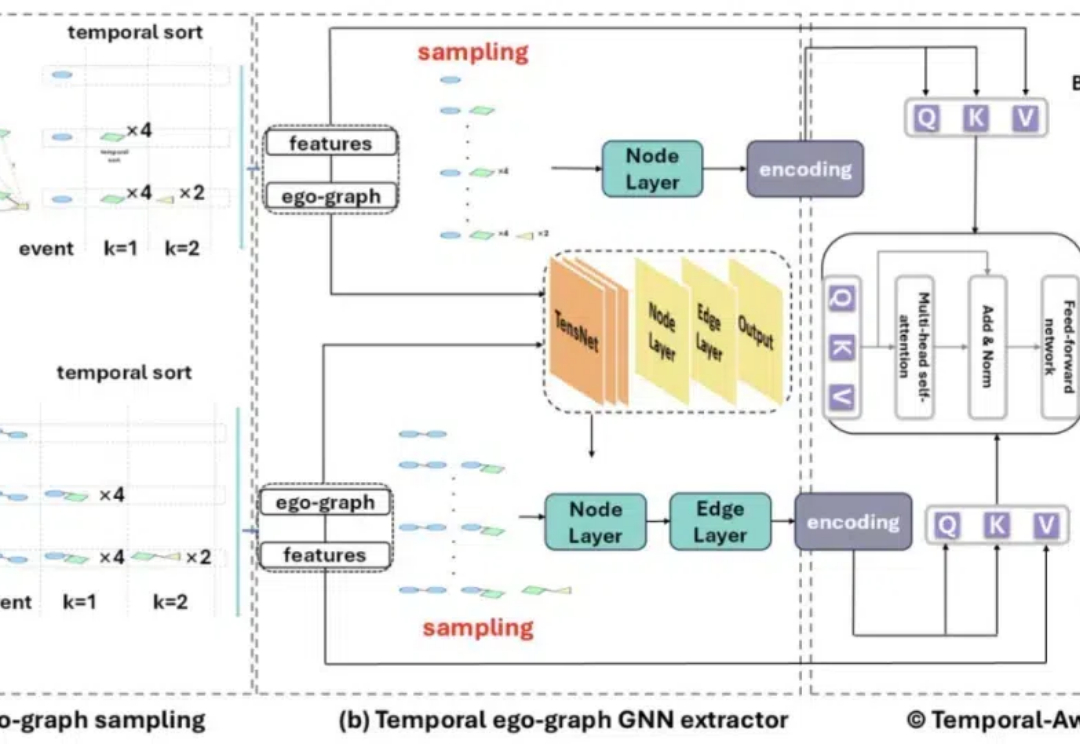

轻松进行动态图异常检测,南洋理工提出GeneralDyG此项研究成果已被 AAAI 2025 录用。该论文的第一作者是南洋理工大学计算与数据科学学院 (CCDS) 的硕士生杨潇,师从苗春燕教授,主要研究方向是图神经网络。

此项研究成果已被 AAAI 2025 录用。该论文的第一作者是南洋理工大学计算与数据科学学院 (CCDS) 的硕士生杨潇,师从苗春燕教授,主要研究方向是图神经网络。

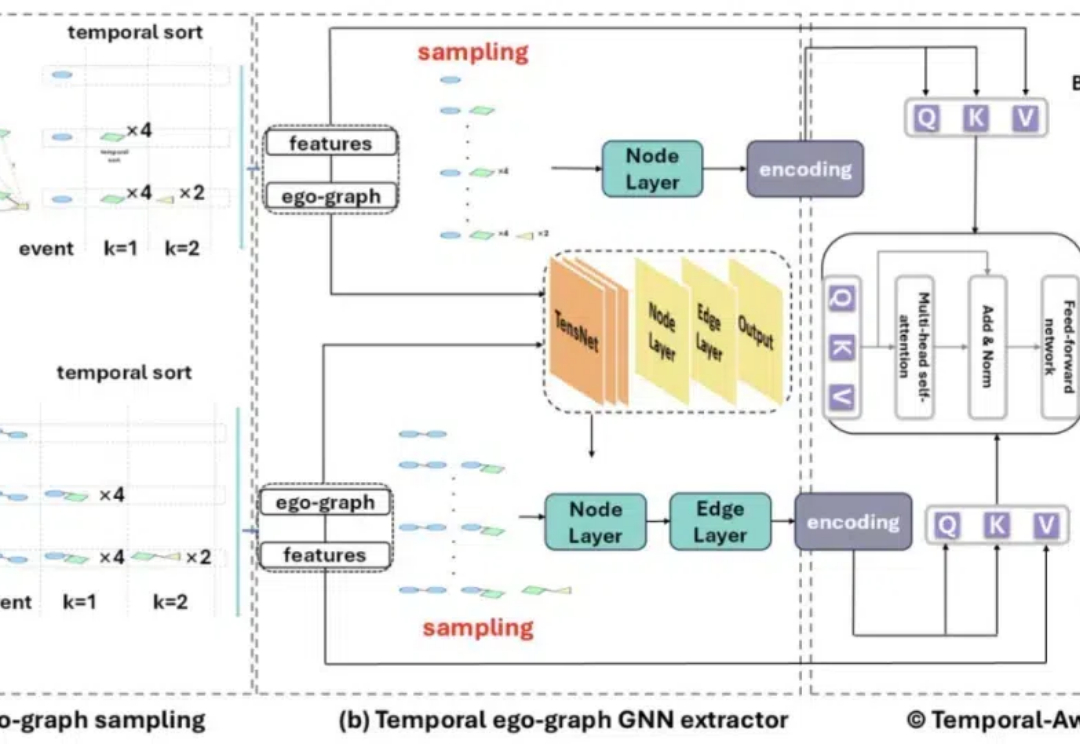

计算机辅助设计(CAD)已经成为许多行业设计、绘图和建模的标准方法。如今,几乎每一个制造出来的物体都是从参数化 CAD 建模开始的。

复旦大学等机构的研究人员最新提出的AI内容检测器ImBD涵盖多任务检测(润色、扩写、改写、纯生成),支持英语、中文、西班牙语、葡萄牙语等多种主流语言;仅需500对样本、5分钟训练时间,就能实现超越商用检测器!

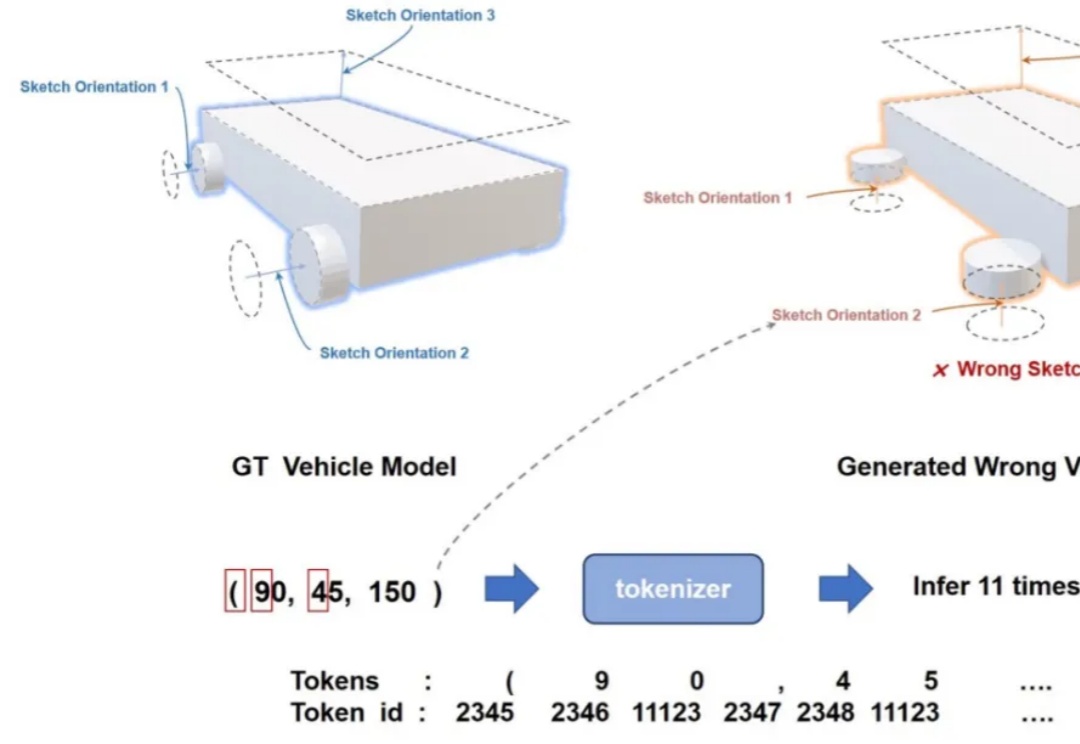

SceneX是一个创新的3D场景生成框架,能根据简单的文字描述快速创建高质量、逼真的虚拟场景,大幅提高构建虚拟世界的效率和灵活性。

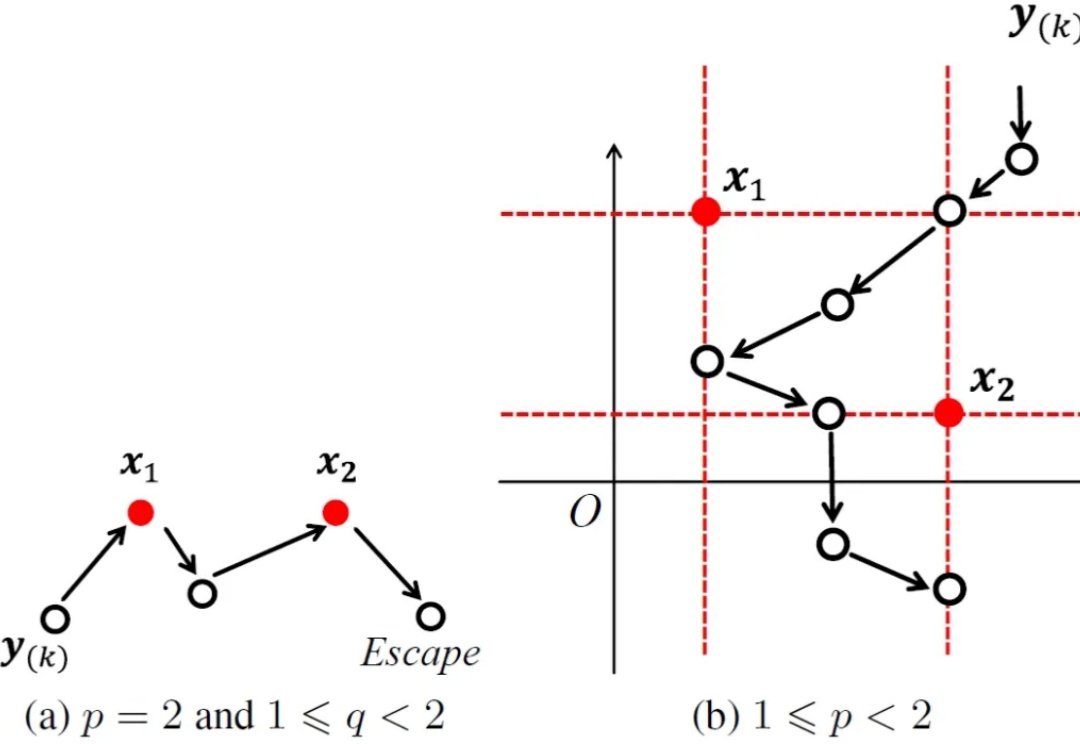

韦伯区位问题源自一个经典的运筹优化问题,它首先由著名数学家皮耶・德・费马提出,后被著名经济学家阿尔弗雷德・韦伯(著名社会学家马克斯・韦伯的弟弟)扩展,在机器学习、人工智能、金融工程及计算机视觉等众多领域均有广泛应用。

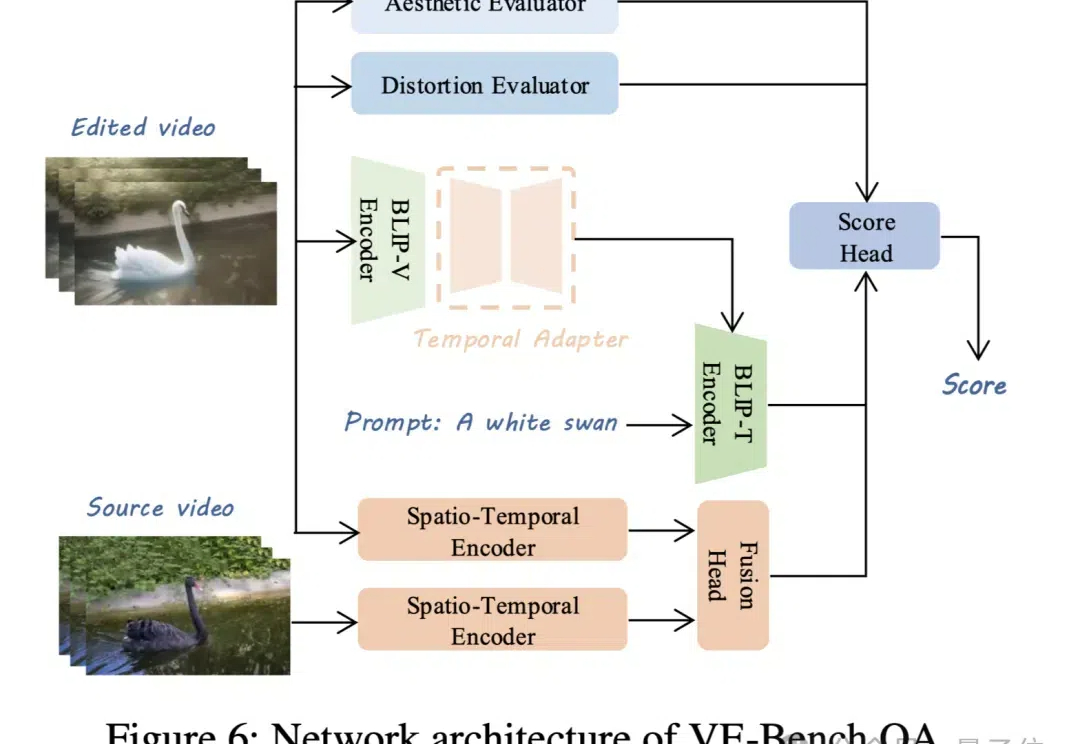

视频生成模型卷得热火朝天,配套的视频评价标准自然也不能落后。 现在,北京大学MMCAL团队开发了首个用于视频编辑质量评估的新指标——VE-Bench,相关代码与预训练权重均已开源。

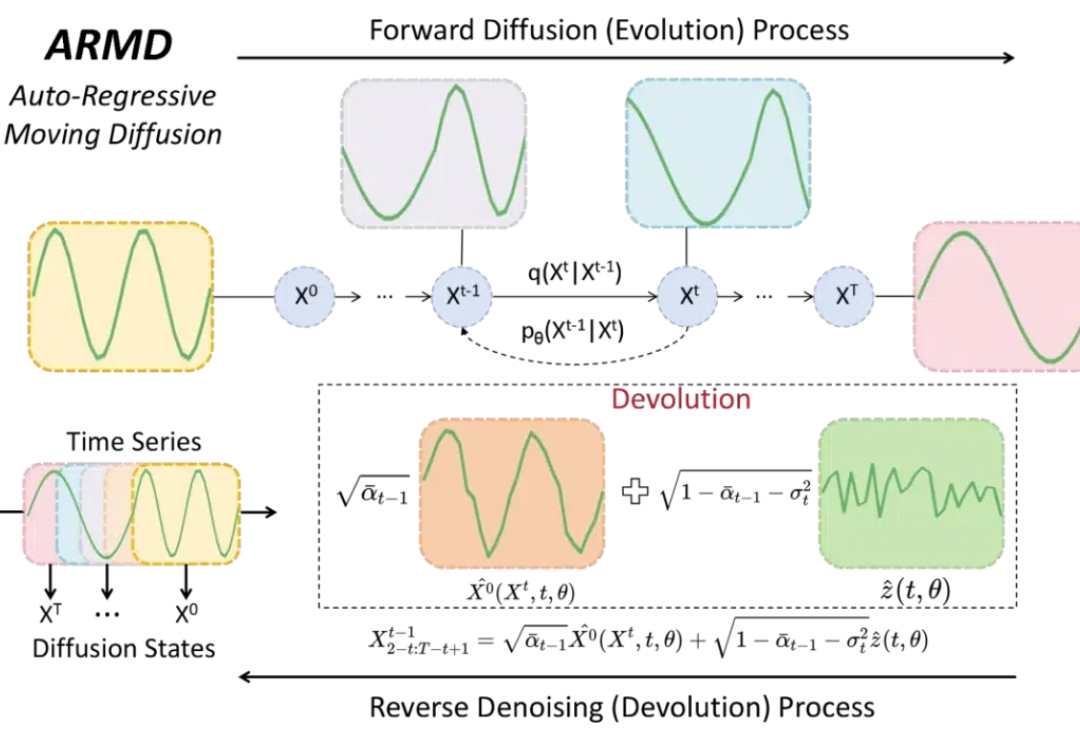

在时间序列预测领域,当前主流的扩散方法还是传统的基于噪声的方法,未能充分利用自回归技术实现时间序列建模。

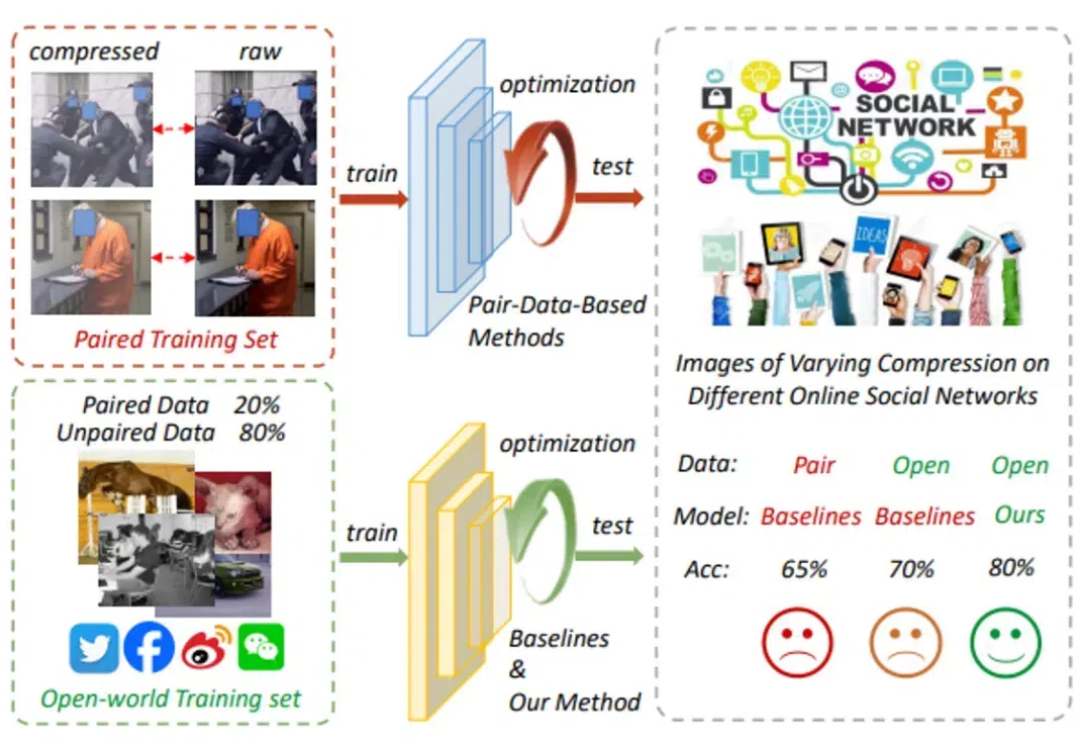

现有的深伪检测方法大多依赖于配对数据,即一张压缩图像和其对应的原始图像来训练模型,这在许多实际的开放环境中并不适用。尤其是在社交媒体等开放网络环境(OSN)中,图像通常经过多种压缩处理,导致图像质量受到影响,深伪识别也因此变得异常困难。

要让大模型适应各不一样的下游任务,微调必不可少。常规的中心化微调过程需要模型和数据存在于同一位置 —— 要么需要数据所有者上传数据(这会威胁到数据所有者的数据隐私),要么模型所有者需要共享模型权重(这又可能泄露自己花费大量资源训练的模型)。

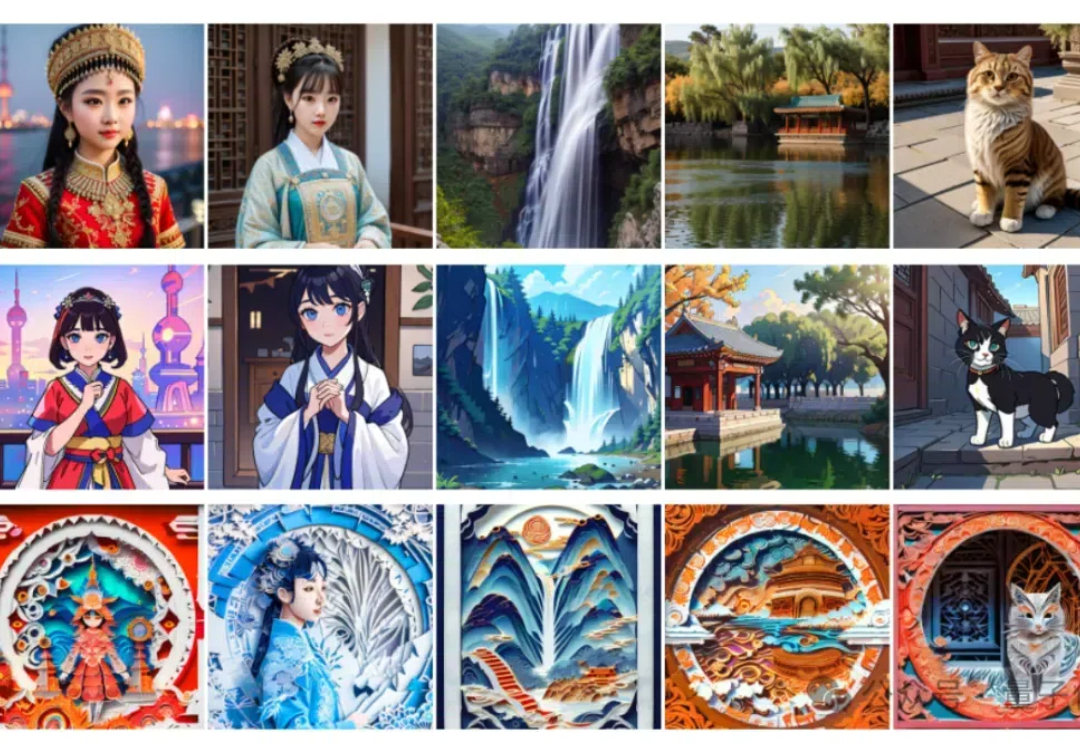

具备原生中文理解能力,还兼容Stable Diffusion生态。 最新模型结构Bridge Diffusion Model来了。 与Dreambooth模型结合,它生成的穿中式婚礼礼服的歪国明星长这样。