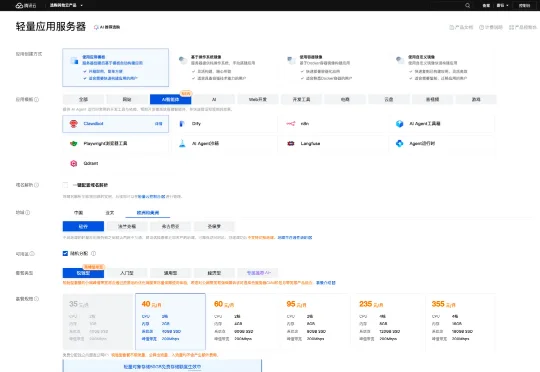

刚刚腾讯云上线Clawdbot一键部署保姆级教程,一个月仅需40元

刚刚腾讯云上线Clawdbot一键部署保姆级教程,一个月仅需40元相较于筹备实体硬件涉及的购置成本、时间及后续电费,云服务器显然是更快捷、经济的选择。而轻量应用服务器 Lighthouse 具备开箱即用、高性价比及免运维的特性,与 Clawdbot 的部署需求完美契合。

相较于筹备实体硬件涉及的购置成本、时间及后续电费,云服务器显然是更快捷、经济的选择。而轻量应用服务器 Lighthouse 具备开箱即用、高性价比及免运维的特性,与 Clawdbot 的部署需求完美契合。

2023 年,三星公司在接入 ChatGPT 不久之后,接连发生数起内部机密泄露事件。事件起因是三星员工将半导体设备参数、产品源代码和生产良率等商业机密直接输入对话系统,导致敏感信息被录入 ChatGPT 的训练数据库。

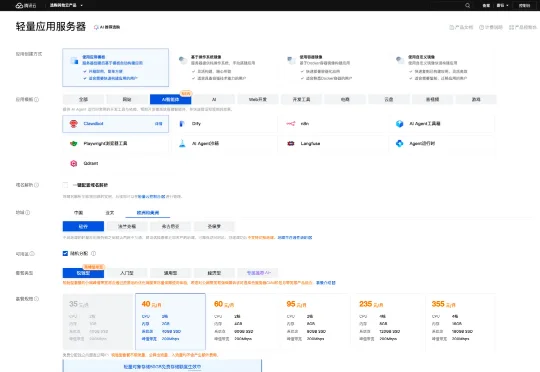

11 月 3 日,全球知名游戏博主 PewDiePie 发布视频,展示其自建本地 AI 系统的全过程。该视频目前浏览量已经超过 300 万,视频标题则赫然写着双关梗 “STOP: Using AI Right now”。

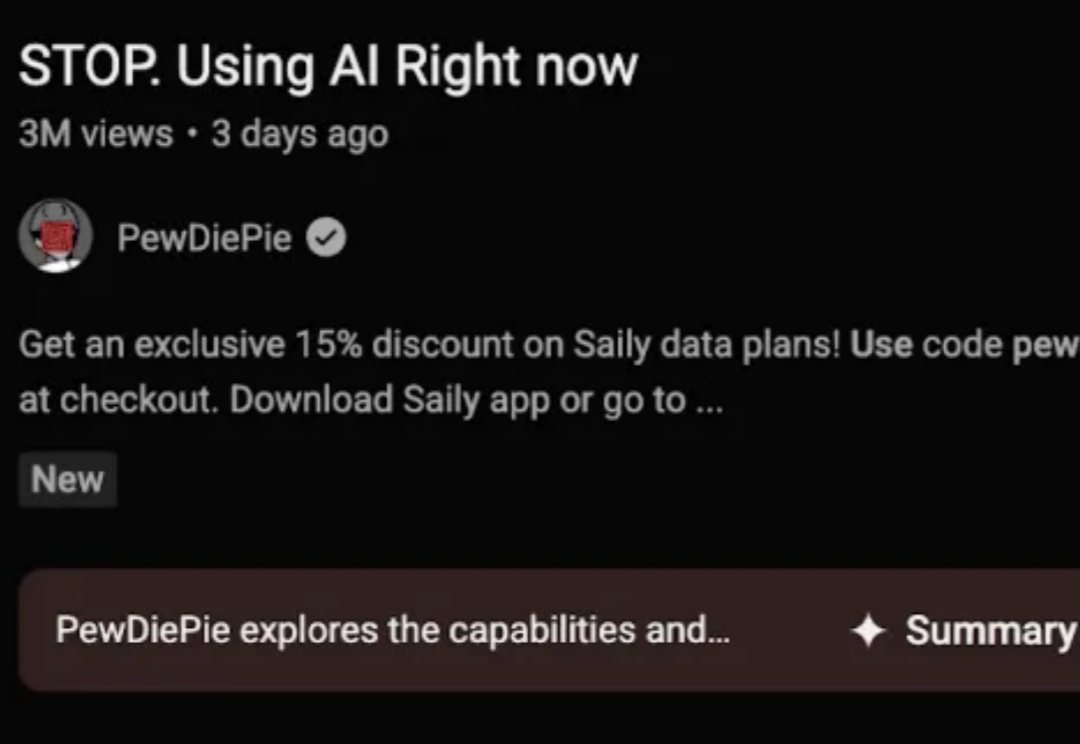

近日,美国南加州大学教授约书亚·杨(Joshua Yang)团队和合作者成功造出一个功能齐全的人工神经元 1M1T1R,这是一种能像真实脑细胞一样工作的人工神经元,有望催生出类似人脑的基于硬件的学习系统,并有望将 AI 转变为更加接近自然智能的形态。

最开始,我们 CTO 计划选择 Coze,但查了下,Coze 整个项目还是比较大,而且后端是 Golang 编写的。我考虑了下,估计后续维护和开发对于中小团队来说比较吃力。各种权衡之后,我们选择了科大讯飞的 Astron Agent。主要原因有两个:

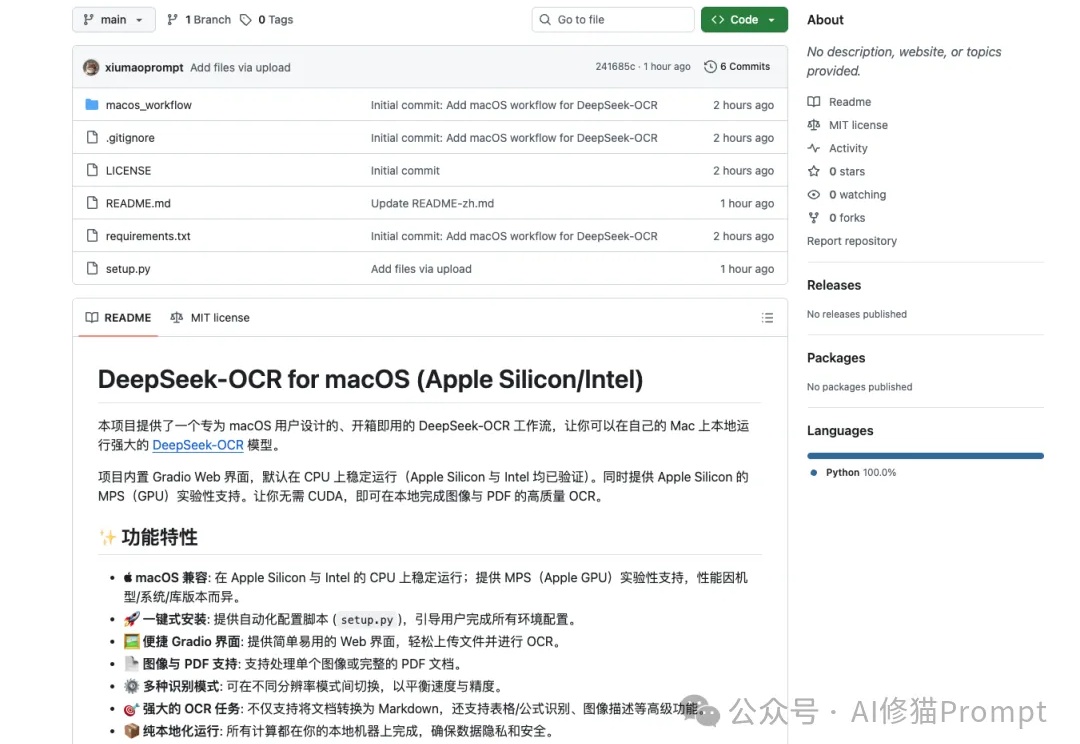

DeepSeek-OCR这段时间非常火,但官方开源的文件是“按 NVIDIA/CUDA 习惯写的 Linux 版推理脚本+模型权重”,而不是“跨设备跨后端”的通吃实现,因此无法直接在苹果设备上运行,对于Mac用户来说,在许多新模型诞生的第一时间,往往只能望“模”兴叹。

在本周MIT报告揭露“绝大多数企业投资AI尚未盈利”引发市场哗然之际,另一项出乎意料的现象也浮出水面:企业部署先进人工智能成本下降的趋势在2025年突然停滞。

今天 ,OpenAI 开源了俩模型:120B/20B 117B 的 gpt-oss-120b 对标 o4-min,按官方说法至少需要 80G 内存,推荐使用单卡 H100 GPU 而刚买的的游戏本,刚好满足gpt-oss-120b 的部署条件

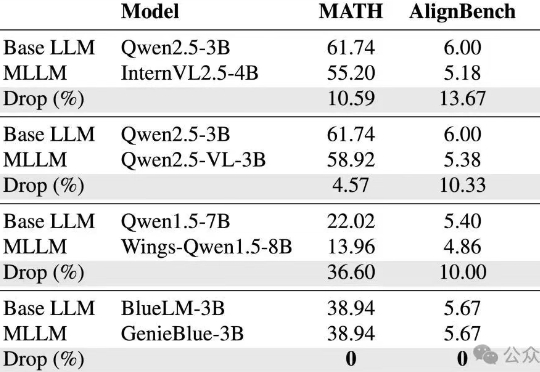

vivo AI研究院联合港中文以及上交团队为了攻克这些难题,从训练数据和模型结构两方面,系统性地分析了如何在MLLM训练中维持纯语言能力,并基于此提出了GenieBlue——专为移动端手机NPU设计的高效MLLM结构方案。

AI非上云不可、非集群不能?万字实测告诉你,32B卡不卡?70B是不是智商税?要几张卡才能撑住业务? 全网最全指南教你如何用最合适的配置,跑出最强性能。