Adam的稳+Muon的快?华为诺亚开源ROOT破解大模型训练「既要又要」的两难困境

Adam的稳+Muon的快?华为诺亚开源ROOT破解大模型训练「既要又要」的两难困境在 LLM 优化领域,有两个响亮的名字:Adam(及其变体 AdamW)和 Muon。

在 LLM 优化领域,有两个响亮的名字:Adam(及其变体 AdamW)和 Muon。

原文作者:David Adam 本篇《自然》长文共3702字,干货满满,预计阅读时间12分钟,时间不够建议可以先“浮窗”或者收藏哦。 研究表明,电子伙伴类应用有利有弊——但科学家们担心长期依赖性。 绘

自2014 年提出以来,Adam 及其改进版 AdamW 长期占据开放权重语言模型预训练的主导地位,帮助模型在海量数据下保持稳定并实现较快收敛。

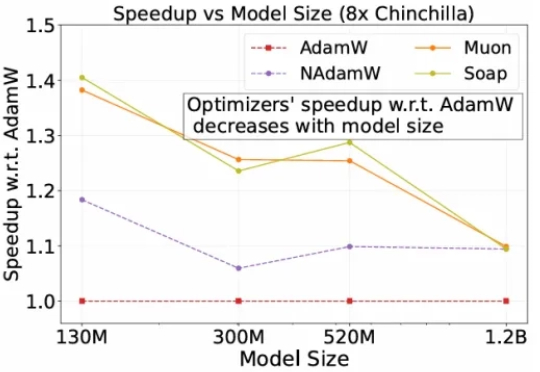

为了降低大模型预训练成本,最近两年,出现了很多新的优化器,声称能相比较AdamW,将预训练加速1.4×到2×。但斯坦福的一项研究,指出不仅新优化器的加速低于宣称值,而且会随模型规模的增大而减弱,该研究证实了严格基准评测的必要性。

16岁的Adam,把最后的秘密留在一部手机里。而那个他最信任的「朋友」,不是同学,也不是家人,而是ChatGPT。它给过安慰,也递了刀子。父母的眼泪化成一纸诉状,矛头直指OpenAI。

Tailwind CSS联合创始人Adam Wathan在X平台发布了一条看似轻松的道歉推文:"我想正式为五年前让Tailwind UI中的每个按钮都使用bg-indigo-500道歉,这导致地球上每个AI生成的界面也变成了靛蓝。"

LLM真是把审稿人害惨了!NeurIPS 2025评审结果公,全网都被「谁是Adam」爆梗淹没。更离谱的是,有人的审稿建议中,残留了AI提示的痕迹。

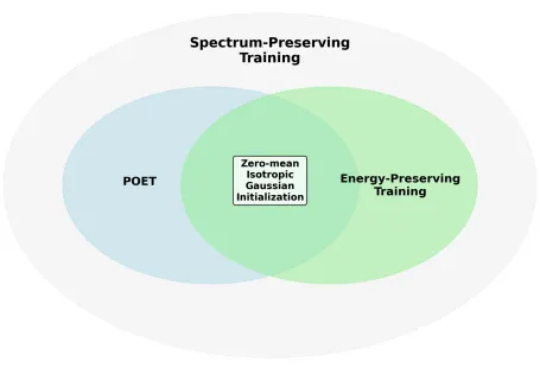

Zeju Qiu和Tim Z. Xiao是德国马普所博士生,Simon Buchholz和Maximilian Dax担任德国马普所博士后研究员

Adam优化器是深度学习中常用的优化算法,但其性能背后的理论解释一直不完善。近日,来自清华大学的团队提出了RAD优化器,扩展了Adam的理论基础,提升了训练稳定性。实验显示RAD在多种强化学习任务中表现优于Adam。

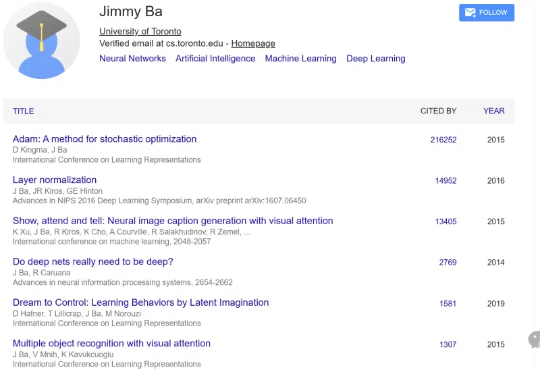

ICLR 2025时间检验奖重磅揭晓!Yoshua Bengio与华人科学家Jimmy Ba分别领衔的两篇十年前论文摘得冠军与亚军。一个是Adam优化器,另一个注意力机制,彻底重塑深度学习的未来。