多亏Transformer,Mamba更强了!仅用1%计算量达新SOTA

多亏Transformer,Mamba更强了!仅用1%计算量达新SOTAAttention is all you need.

Attention is all you need.

今年 3 月份,英伟达 CEO 黄仁勋举办了一个非常特别的活动。他邀请开创性论文《Attention Is All You Need》的作者们齐聚 GTC,畅谈生成式 AI 的未来发展方向。

2017 年,谷歌在论文《Attention is all you need》中提出了 Transformer,成为了深度学习领域的重大突破。该论文的引用数已经将近 13 万,后来的 GPT 家族所有模型也都是基于 Transformer 架构,可见其影响之广。 作为一种神经网络架构,Transformer 在从文本到视觉的多样任务中广受欢迎,尤其是在当前火热的 AI 聊天机器人领域。

用 FlexAttention 尝试一种新的注意力模式。

七年前,论文《Attention is all you need》提出了 transformer 架构,颠覆了整个深度学习领域。

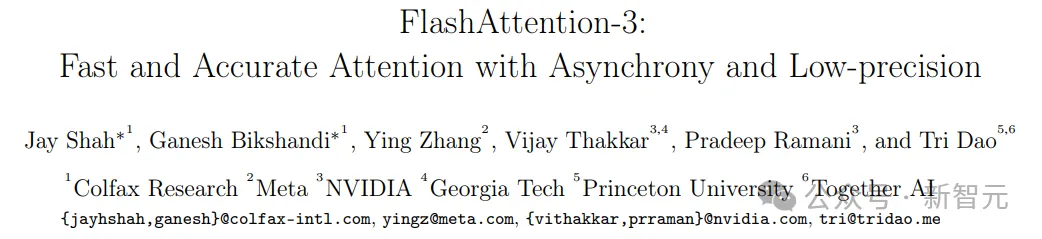

740 TFLOPS!迄今最强 FlashAttention 来了。

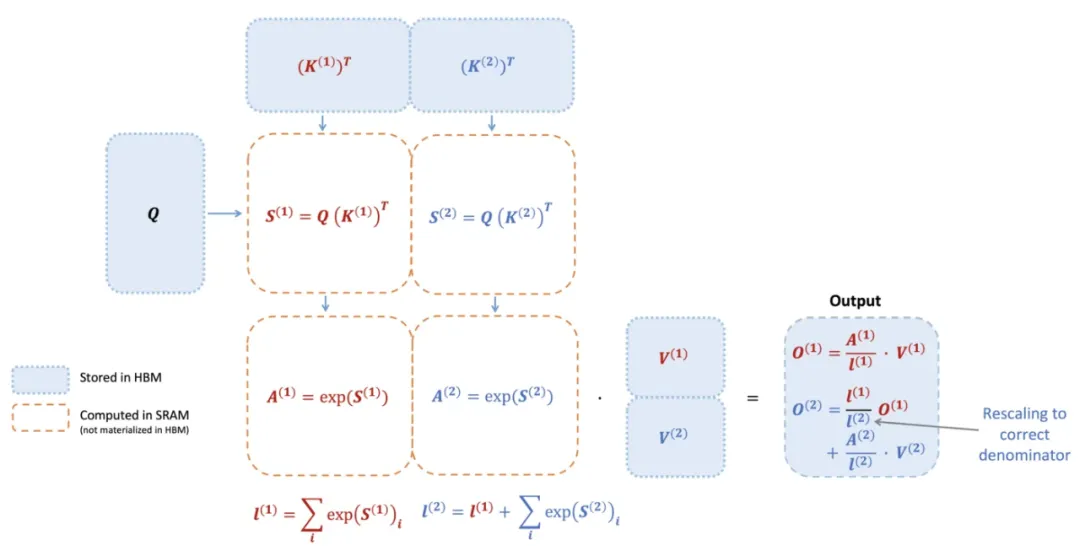

时隔一年,FlashAttention又推出了第三代更新,专门针对H100 GPU的新特性进行优化,在之前的基础上又实现了1.5~2倍的速度提升。

大模型训练推理神作,又更新了!

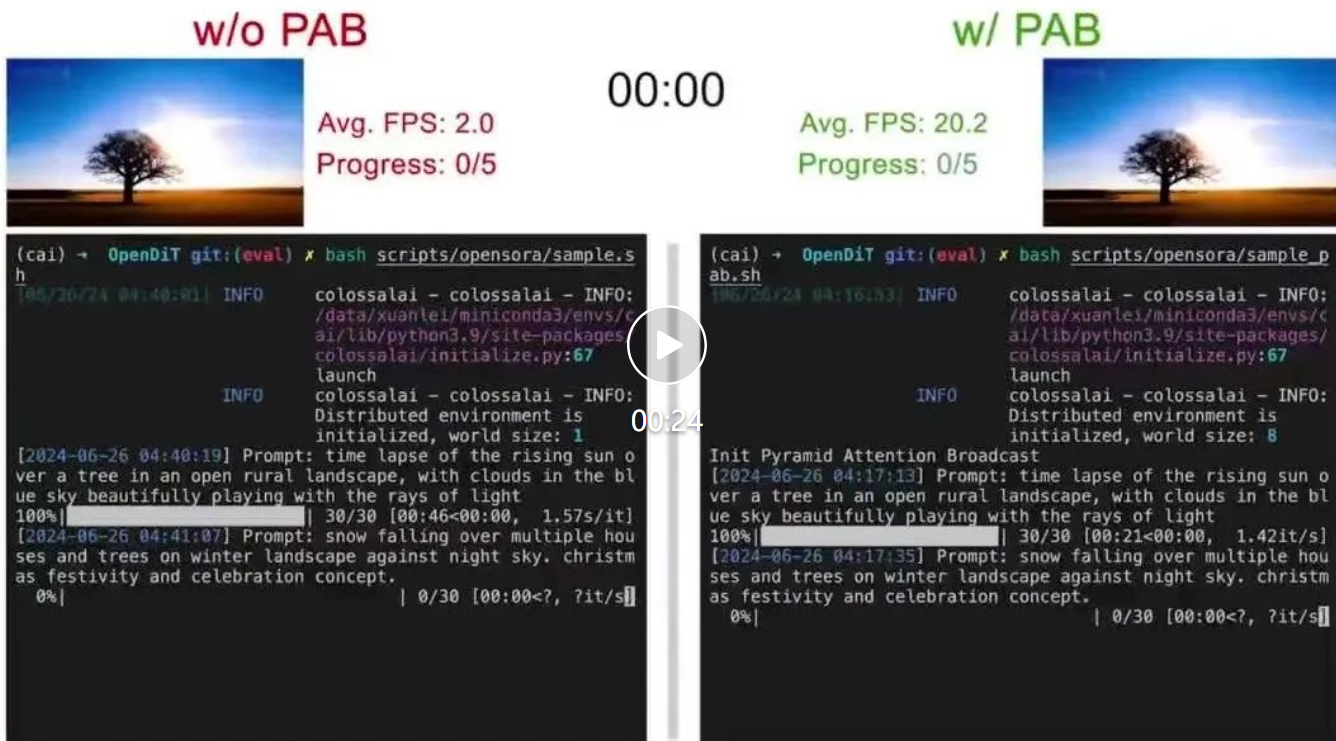

尤洋团队新作,首个基于DiT的实时视频生成方法来了!

AI算力资源越发紧张的当下,斯坦福新研究将GPU运行效率再提升一波——