微信、清华连续自回归模型CALM,新范式实现从「离散词元」到「连续向量」转变

微信、清华连续自回归模型CALM,新范式实现从「离散词元」到「连续向量」转变众所周知,大型语言模型(LLM)的根本运作方式是预测下一个 token(词元),能够保证生成的连贯性和逻辑性,但这既是 LLM 强大能力的「灵魂」所在,也是其枷锁,将导致高昂的计算成本和响应延迟。 可

来自主题: AI技术研报

6872 点击 2025-11-09 10:21

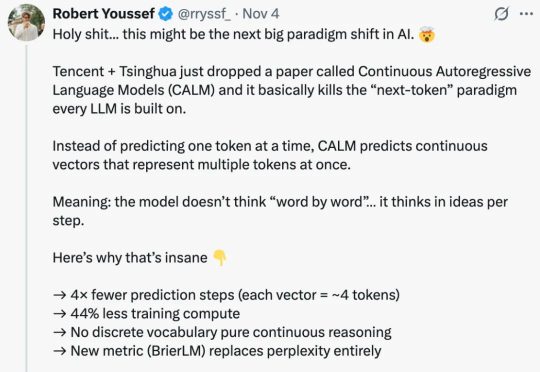

众所周知,大型语言模型(LLM)的根本运作方式是预测下一个 token(词元),能够保证生成的连贯性和逻辑性,但这既是 LLM 强大能力的「灵魂」所在,也是其枷锁,将导致高昂的计算成本和响应延迟。 可

大模型一个token一个token生成,效率太低怎么办?

睡不着?用AI给你讲个“麦康纳版”童话吧|Calm助眠神器测评

作为世界重要经济体之一的日本,在目前这轮各国竞相参与的AI革命当中几乎是悄无声息。我们基本看不到来自日本的AI模型——不仅是基础大模型,就连应用层的模型也很少。