超越DeepSeek-R1关键RL算法GRPO,CMU「元强化微调」新范式登场

超越DeepSeek-R1关键RL算法GRPO,CMU「元强化微调」新范式登场大语言模型(LLM)在推理领域的最新成果表明了通过扩展测试时计算来提高推理能力的潜力,比如 OpenAI 的 o1 系列。

大语言模型(LLM)在推理领域的最新成果表明了通过扩展测试时计算来提高推理能力的潜力,比如 OpenAI 的 o1 系列。

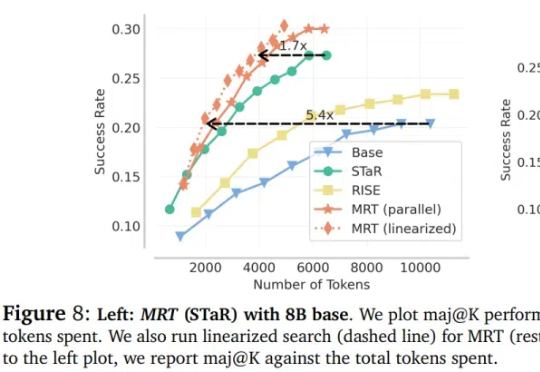

CMU团队用LCPO训练了一个15亿参数的L1模型,结果令人震惊:在数学推理任务中,它比S1相对提升100%以上,在逻辑推理和MMLU等非训练任务上也能稳定发挥。更厉害的是,要求短推理时,甚至击败了GPT-4o——用的还是相同的token预算!

在面对复杂的推理任务时,SFT往往让大模型显得力不从心。最近,CMU等机构的华人团队提出了「批判性微调」(CFT)方法,仅在 50K 样本上训练,就在大多数基准测试中优于使用超过200万个样本的强化学习方法。

人类通过课堂学习知识,并在实践中不断应用与创新。那么,多模态大模型(LMMs)能通过观看视频实现「课堂学习」吗?新加坡南洋理工大学S-Lab团队推出了Video-MMMU——全球首个评测视频知识获取能力的数据集,为AI迈向更高效的知识获取与应用开辟了新路径。

英伟达卡内基梅隆大学一起,给宇树机器人“一雪前耻”了(doge)。只通过一个训练框架,机器人就能成为“学人精”,完成各种高难度敏捷动作。

机器人界「球星」竟被CMU英伟达搞出来了!科比后仰跳投、C罗、詹皇霸气庆祝动作皆被完美复刻。2030年,我们将会看到一场人形机器人奥运会盛宴。

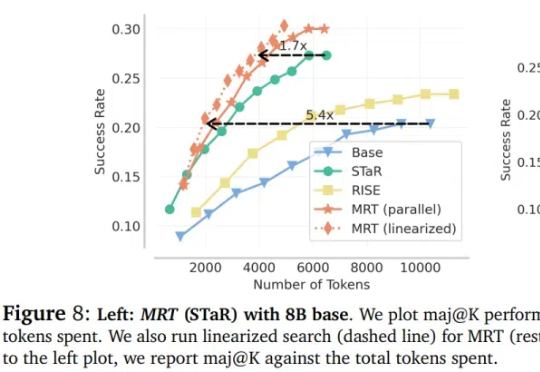

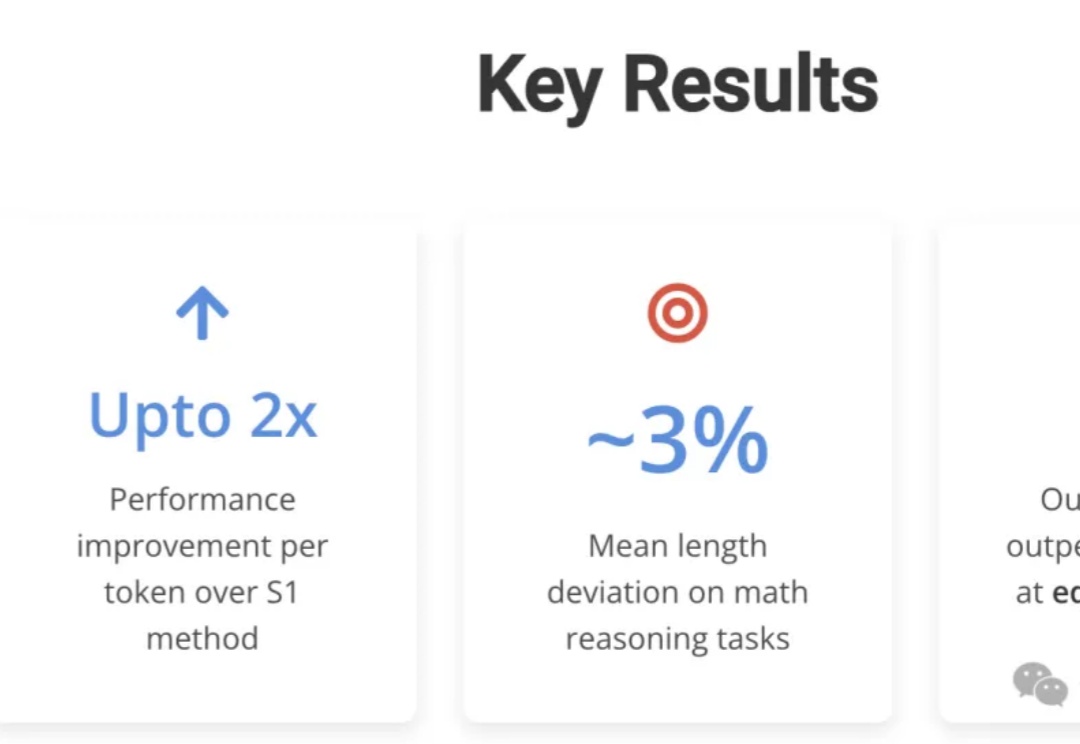

2028年,预计高质量数据将要耗尽,数据Scaling走向尽头。2025年,测试时计算将开始成为主导AI通向通用人工智能(AGI)的新一代Scaling Law。近日,CMU机器学习系博客发表新的技术文章,从元强化学习(meta RL)角度,详细解释了如何优化LLM测试时计算。

智能体究竟能否应对现实世界的复杂性?The Agent Company近日提出了一项评估基准,让多个智能体尝试自主运营一个软件公司。结果表明,即使是当前最先进的智能体,也无法自主完成大多数任务。

本期,我们邀请到了灵巧手公司 Dexmate 的创始人陈涛和秦誉哲。两位分别在上海交通大学、麻省理工学院(MIT)、卡内基梅隆大学(CMU)和加州大学圣地亚哥分校(UCSD)等知名院校的顶尖实验室积累了丰富的研究经验。这些经历不仅为他们提供了扎实的技术基础,也让他们对产业需求有了深入的理解。

12月19日,CMU 联合其他 20 多所研究实验室开源发布了一个生成式物理引擎:Genesis,意为「创世纪」。