田渊栋等人新作:突破内存瓶颈,让一块4090预训练7B大模型

田渊栋等人新作:突破内存瓶颈,让一块4090预训练7B大模型3 月 6 日,田渊栋又一项研究出炉,这次,他们主攻 LLM 内存效率。除了田渊栋本人,还有来自加州理工学院、德克萨斯大学奥斯汀分校以及 CMU 的研究者。

3 月 6 日,田渊栋又一项研究出炉,这次,他们主攻 LLM 内存效率。除了田渊栋本人,还有来自加州理工学院、德克萨斯大学奥斯汀分校以及 CMU 的研究者。

大模型的新考验来了!近日,来自卡内基梅隆大学的研究人员发布了评估LLM多模态Web代理性能的基准测试。

斯坦福炒菜机器人的大火,开启了2024年机器人元年。最近,CMU研究团队推出了一款能在开放世界完成任务的机器人,成本仅18万元。没见过的场景,它可以靠自学学会!

近日,CMU Catalyst 团队推出了一篇关于高效 LLM 推理的综述,覆盖了 300 余篇相关论文,从 MLSys 的研究视角介绍了算法创新和系统优化两个方面的相关进展。

CSRankings 2024结果出炉!全世界计算机科学机构的排名进行了大更新。在AI板块,清华、北大、上交分列TOP 3,CMU和浙大并列第4。AI TOP 10中的中国高校,还包括人大、南京大学、复旦大学、哈工大等。

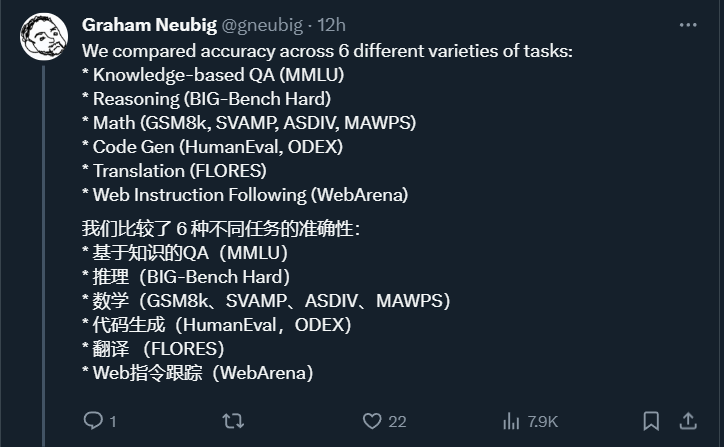

谷歌发布Gemini以后,一直宣称Gemini Pro要优于GPT-3.5,而CMU的研究人员通过自己实测,给大家来了一个客观中立第三方的对比。结果却是GPT-3.5几乎还是全面优于Gemini Pro,不过双方差距不大。

AI颠覆化学研究再次登上Nature!由CMU和Emerald Cloud Lab团队开发的GPT-4加持的AI工具,在不到4分钟的时间成功复现2010年诺奖研究成果。

谷歌的 Gemini 到底几斤几两?和 OpenAI 的 GPT 模型相比表现如何?CMU 这篇论文测明白了。

现在ChatGPT等大模型一大痛点:处理长文本算力消耗巨大,背后原因是Transformer架构中注意力机制的二次复杂度。

最近,由CMU/MIT/清华/Umass提出的全球首个生成式机器人智能体RoboGen,可以无限生成数据,让机器人7*24小时永不停歇地训练。AIGC for Robotics,果然是未来的方向。