DeepSeek新模型上线!引入DSA新稀疏注意力,还又狙了CUDA一枪

DeepSeek新模型上线!引入DSA新稀疏注意力,还又狙了CUDA一枪刚发V3.1“最终版”,DeepSeek最新模型又来了!DeepSeek-V3.2-Exp刚刚官宣上线,不仅引入了新的注意力机制——DeepSeek Sparse Attention。还开源了更高效的TileLang版本GPU算子!

刚发V3.1“最终版”,DeepSeek最新模型又来了!DeepSeek-V3.2-Exp刚刚官宣上线,不仅引入了新的注意力机制——DeepSeek Sparse Attention。还开源了更高效的TileLang版本GPU算子!

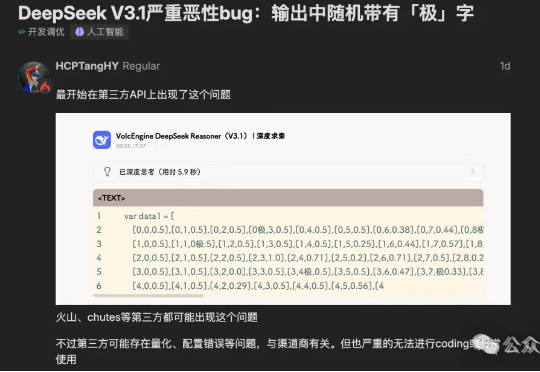

“极你太美”bug,果然在DeepSeek V3.1最新版本中被修复了。DeepSeek-V3.1刚刚更新至DeepSeek-V3.1-Terminus版本。

DeepSeek最新模型DeepSeek-V3.1-Terminus来了!此前在输出中随机掺入「极」字的问题得到显著缓解,Humanity's Last Exam成绩也较V3.1提升1/3!Terminus这个名字是否在暗示DeepSeek-V4也快要来了?

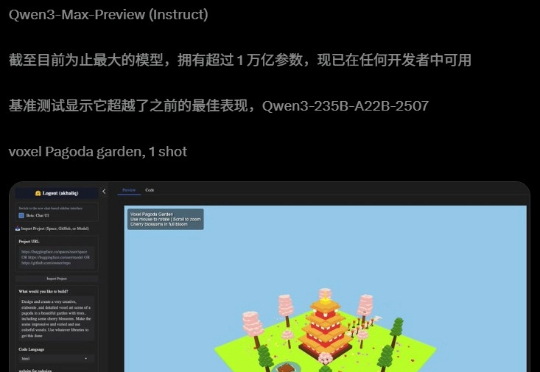

阿里迄今为止,参数最大的模型诞生了!昨夜,Qwen3-Max-Preview(Instruct)官宣上线,超1万亿参数性能爆表。在全球主流权威基准测试中,Qwen3-Max-Preview狂揽非推理模型「C」位,直接碾压Claude-Opus 4(Non-Thinking)、Kimi-K2、DeepSeek-V3.1。

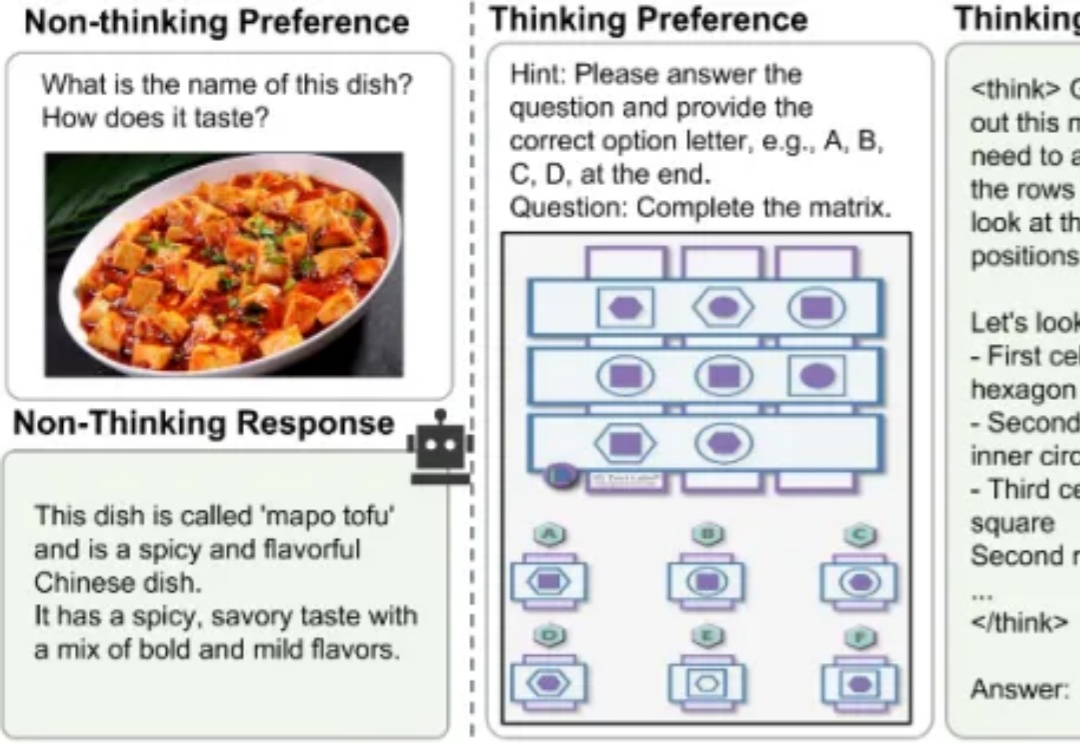

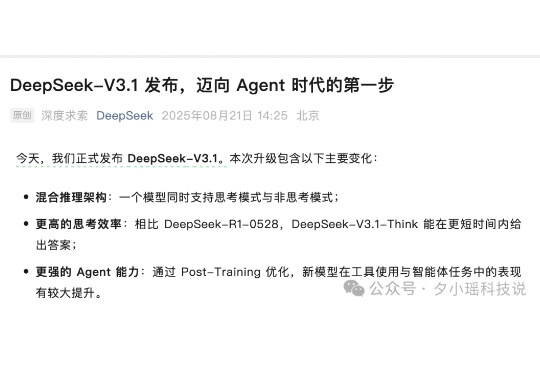

当前,业界顶尖的大模型正竞相挑战“过度思考”的难题,即无论问题简单与否,它们都采用 “always-on thinking” 的详细推理模式。无论是像 DeepSeek-V3.1 这种依赖混合推理架构提供需用户“手动”介入的快慢思考切换,还是如 GPT-5 那样通过依赖庞大而高成本的“专家路由”机制提供的自适应思考切换。

DeepSeek发布DeepSeek-V3.1,使用的UE8M0 FP8 Scale针对下一代国产芯片设计

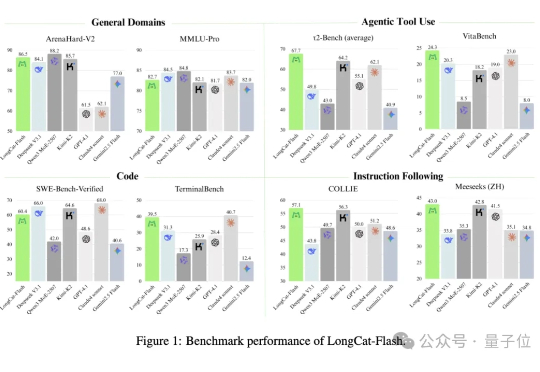

没想到啊,最新SOTA的开源大模型…… 来自一个送外卖(Waimai)的——有两个AI,确实不一样。 这个最新开源模型叫:Longcat-Flash-Chat,美团第一个开源大模型,发布即开源,已经在海内外的技术圈子里火爆热议了。

上周三,DeepSeek 开源了新的基础模型,但不是万众期待的 V4,而是 V3.1-Base,而更早时候,DeepSeek-V3.1 就已经上线了其网页、App 端和小程序。

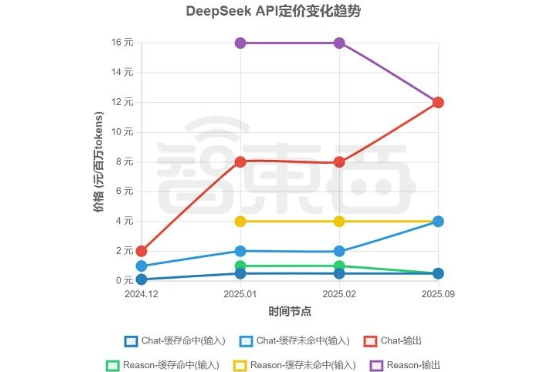

DeepSeek涨价了。 智东西8月23日报道,8月21日,DeepSeek在其公众号官宣了DeepSeek-V3.1的正式发布,还宣布自9月6日起,DeepSeek将执行新价格表,取消了今年2月底推出的夜间优惠,推理与非推理API统一定价,输出价格调整至12元/百万tokens。这一决定,让使用DeepSeek API的最低价格较过去上升了50%。

今天下午,DeepSeek 官方正式发布 DeepSeek-V3.1。相比于前天只在用户群里通知,今天新增了模型升级点、榜单成绩、model card,huggingface 上现在也可以下载模型文件了。