AI图像革命才刚刚开始

AI图像革命才刚刚开始本期AGI路线图中关键节点:DiT架构、Stable Diffusion 3.0、Flux.1、ControlNet、1024×1024分辨率、医学影像、英伟达Eagle模型、谷歌Med-Gemini系列模型、GPT-4o端到端、Meta Transfusion模型。

本期AGI路线图中关键节点:DiT架构、Stable Diffusion 3.0、Flux.1、ControlNet、1024×1024分辨率、医学影像、英伟达Eagle模型、谷歌Med-Gemini系列模型、GPT-4o端到端、Meta Transfusion模型。

自回归解码已经成为了大语言模型(LLMs)的事实标准,大语言模型每次前向计算需要访问它全部的参数,但只能得到一个token,导致其生成昂贵且缓慢。

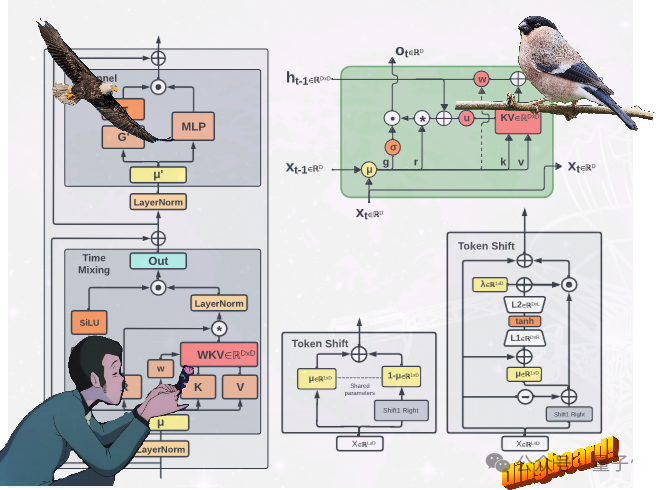

不走Transformer寻常路,魔改RNN的国产新架构RWKV,有了新进展: 提出了两种新的RWKV架构,即Eagle (RWKV-5) 和Finch(RWKV-6)。

大模型内卷时代,也不断有人跳出来挑战Transformer的统治地位,RWKV最新发布的Eagle 7B模型登顶了多语言基准测试,同时成本降低了数十倍

在 AI 赛道中,与动辄上千亿参数的模型相比,最近,小模型开始受到大家的青睐。比如法国 AI 初创公司发布的 Mistral-7B 模型,其在每个基准测试中,都优于 Llama 2 13B,并且在代码、数学和推理方面也优于 LLaMA 1 34B。

大语言模型(LLM)被越来越多应用于各种领域。然而,它们的文本生成过程既昂贵又缓慢。这种低效率归因于自回归解码的运算规则:每个词(token)的生成都需要进行一次前向传播,需要访问数十亿至数千亿参数的 LLM。这导致传统自回归解码的速度较慢。