滚烫Deepseek一夜刀掉英伟达4万亿,除夕开源多模态新模型:7B超越DALL-E 3和StableDiffusion

滚烫Deepseek一夜刀掉英伟达4万亿,除夕开源多模态新模型:7B超越DALL-E 3和StableDiffusionDeepSeek大爆出圈,现在连夜发布新模型——多模态Janus-Pro-7B,发布即开源。在GenEval和DPG-Bench基准测试中击败了DALL-E 3和Stable Diffusion。

DeepSeek大爆出圈,现在连夜发布新模型——多模态Janus-Pro-7B,发布即开源。在GenEval和DPG-Bench基准测试中击败了DALL-E 3和Stable Diffusion。

它可以模仿人类研究者调用搜索引擎、看论文、查参考文献。繁琐冗长的论文调研,现在,只需要两分钟。

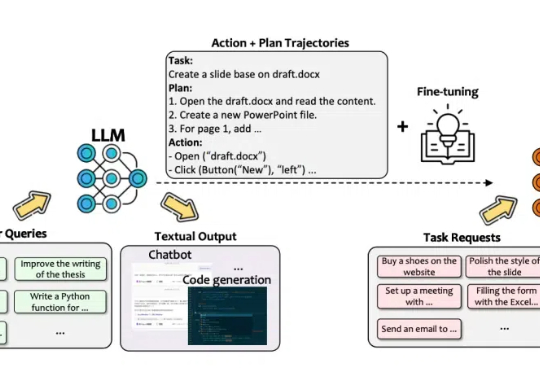

该技术报告的主要作者 Lu Wang, Fangkai Yang, Chaoyun Zhang, Shilin He, Pu Zhao, Si Qin 等均来自 Data, Knowledge, and Intelligence (DKI) 团队,为微软 TaskWeaver, WizardLLM, Windows GUI Agent UFO 的核心开发者。

据 TechCrunch 报道,Read.cv,一个与 LinkedIn 竞争的专业社交媒体平台,已被人工智能驱动的搜索引擎Perplexity收购。

AI训练即将进入语料比拼阶段 Reddit 在过去的 2024 年算得上是容光焕发。这家创立了近 20 年的社交平台,去年 3 月在纽交所完成上市,并在上市后的第三季度实现首次盈利,到目前股票已涨到上市首日开盘价的 350% 左右。

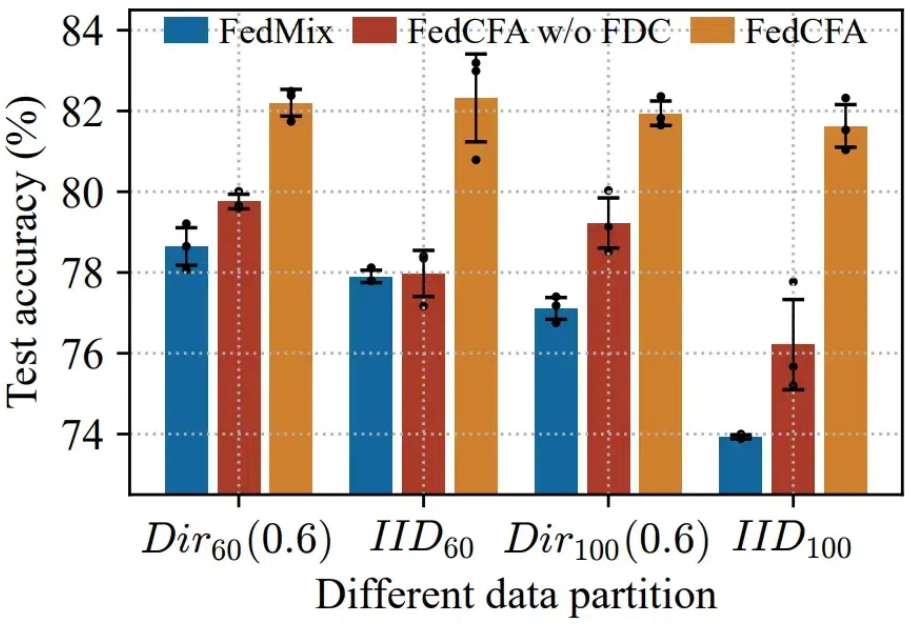

本地训练的客户模型忽视了全局数据中明显的更广泛的模式,聚合的全局模型可能无法准确反映所有客户端的数据分布,甚至可能出现「辛普森悖论」—— 多端各自数据分布趋势相近,但与多端全局数据分布趋势相悖。

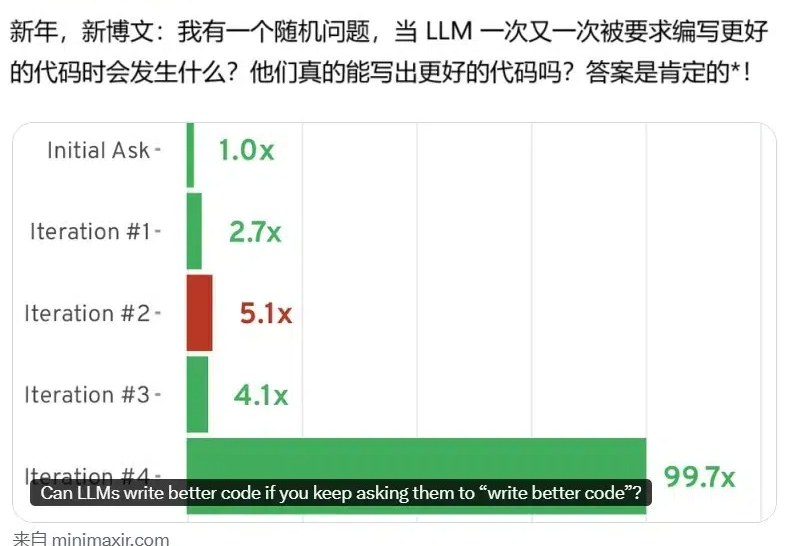

AI 的编程能力已经得到了证明,但还并不完美。近日,BuzzFeed 的资深数据科学家 Max Woolf 发现,如果通过提示词不断要求模型写更好的代码(write better code),AI 模型还真能写出更好的代码!

最新综述论文探讨了知识蒸馏在持续学习中的应用,重点研究如何通过模仿旧模型的输出来减缓灾难性遗忘问题。通过在多个数据集上的实验,验证了知识蒸馏在巩固记忆方面的有效性,并指出结合数据回放和使用separated softmax损失函数可进一步提升其效果。

Shevchenko 的目标是打造一款能理解用户何时需要其帮助的电子设备,并且能理解、保存用户脑海中的想法,实现真正的「意图识别」甚至「意图预判」,这可能会改变用户使用智能设备的方式。

在今年的 NeurIPS 2024 大会上,硅谷最著名的 VC 之一 Conviction Capital 创始人 Sarah Guo 和合伙人 Pranav Reddy 做了一场 “AI 创业公司的现状(The State of AI Startups)”的分享。