在GSM8K上比GRPO快8倍!厦大提出CPPO,让强化学习快如闪电

在GSM8K上比GRPO快8倍!厦大提出CPPO,让强化学习快如闪电DeepSeek-R1 的成功离不开一种强化学习算法:GRPO(组相对策略优化)。

来自主题: AI技术研报

6275 点击 2025-04-01 16:16

DeepSeek-R1 的成功离不开一种强化学习算法:GRPO(组相对策略优化)。

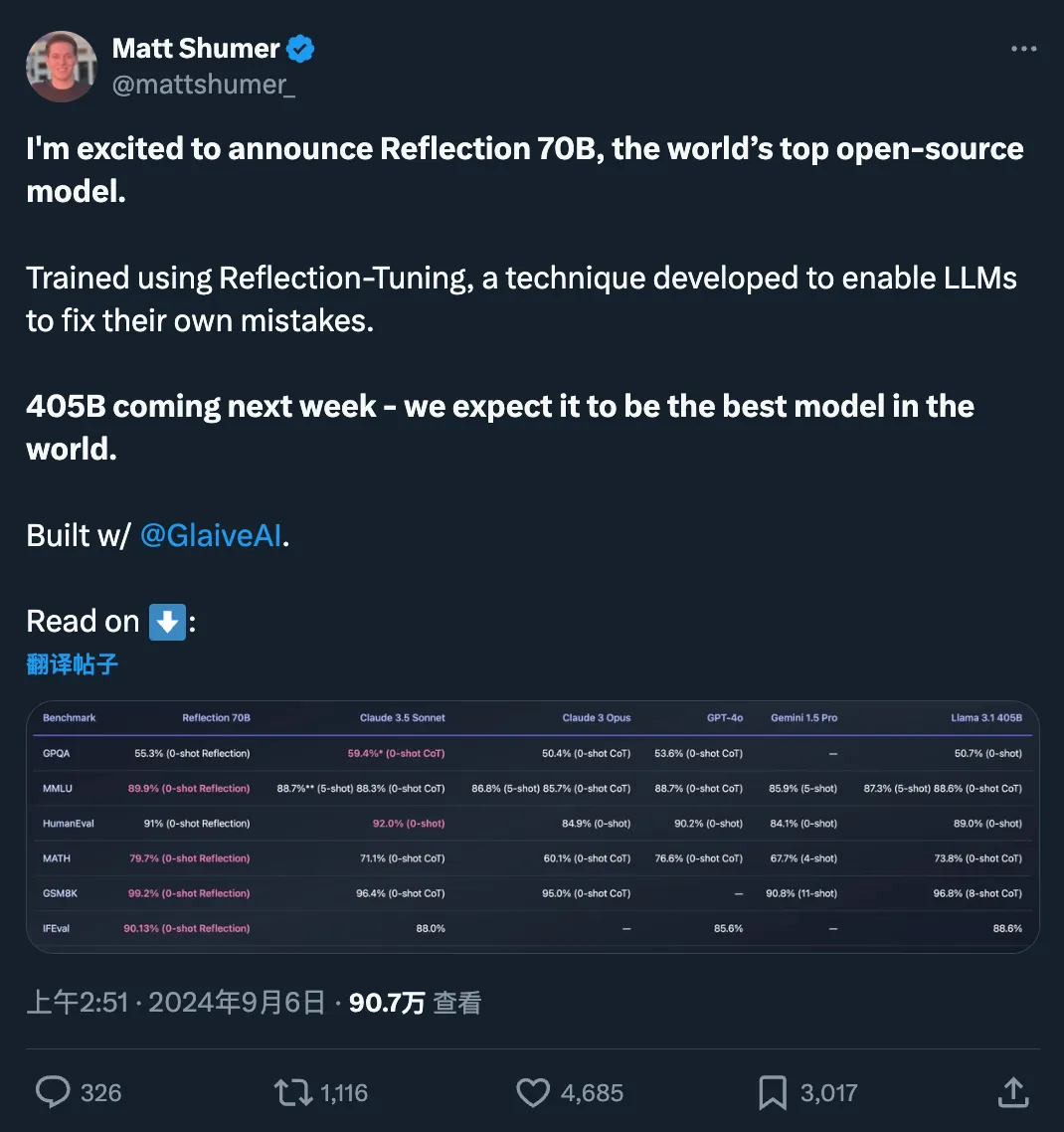

快速更迭的开源大模型领域,又出现了新王:Reflection 70B。 横扫 MMLU、MATH、IFEval、GSM8K,在每项基准测试上都超过了 GPT-4o,还击败了 405B 的 Llama 3.1。 这个新模型 Reflection 70B,来自 AI 写作初创公司 HyperWrite。

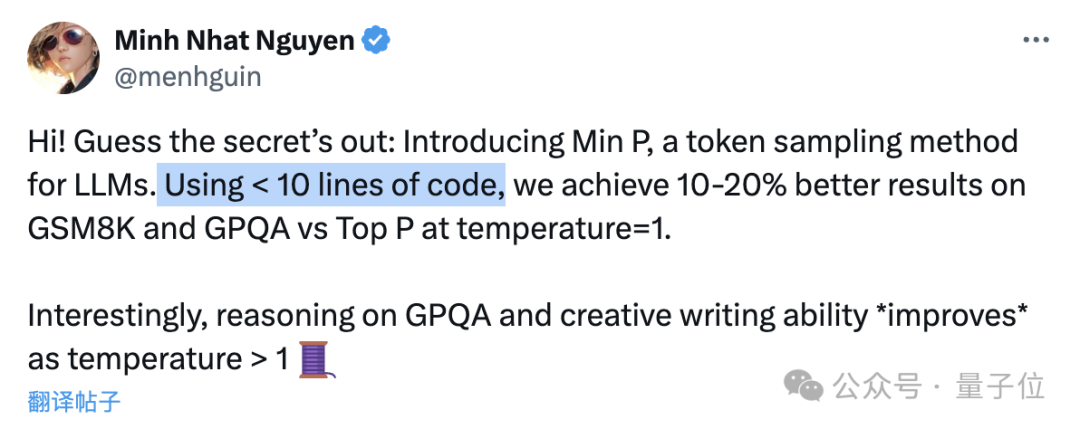

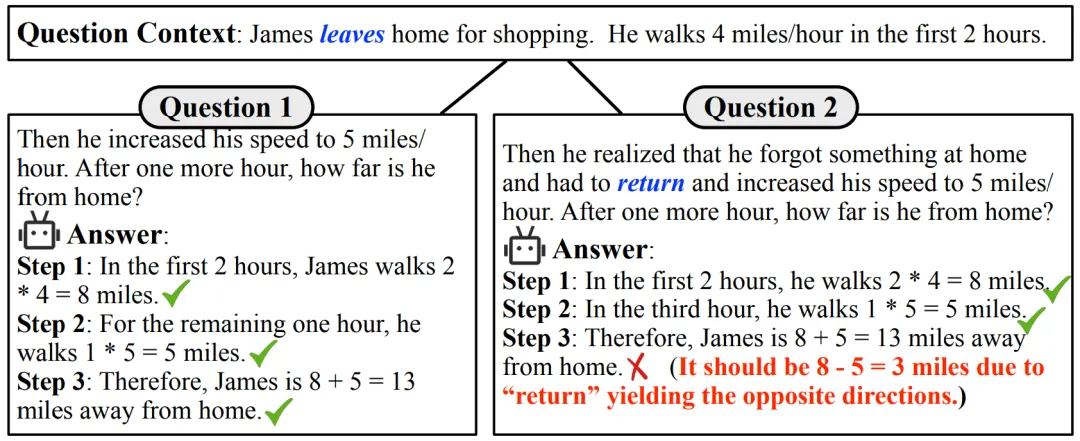

只要不到10行代码,就能让大模型数学能力(GSM8k)提升20%!

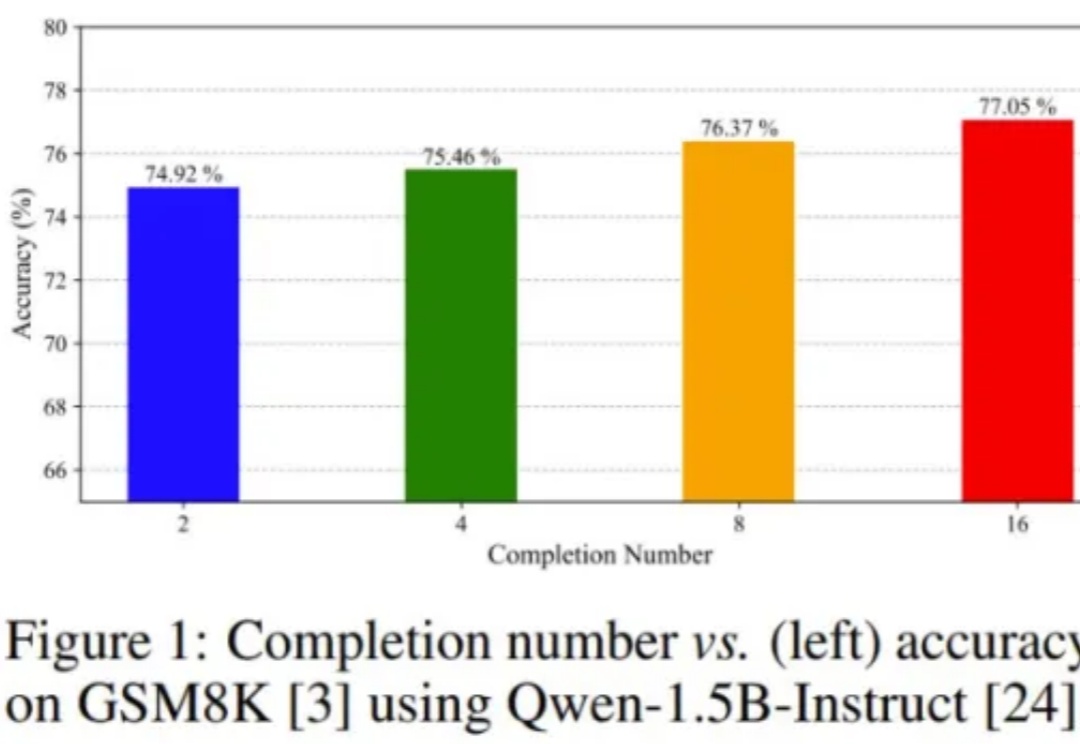

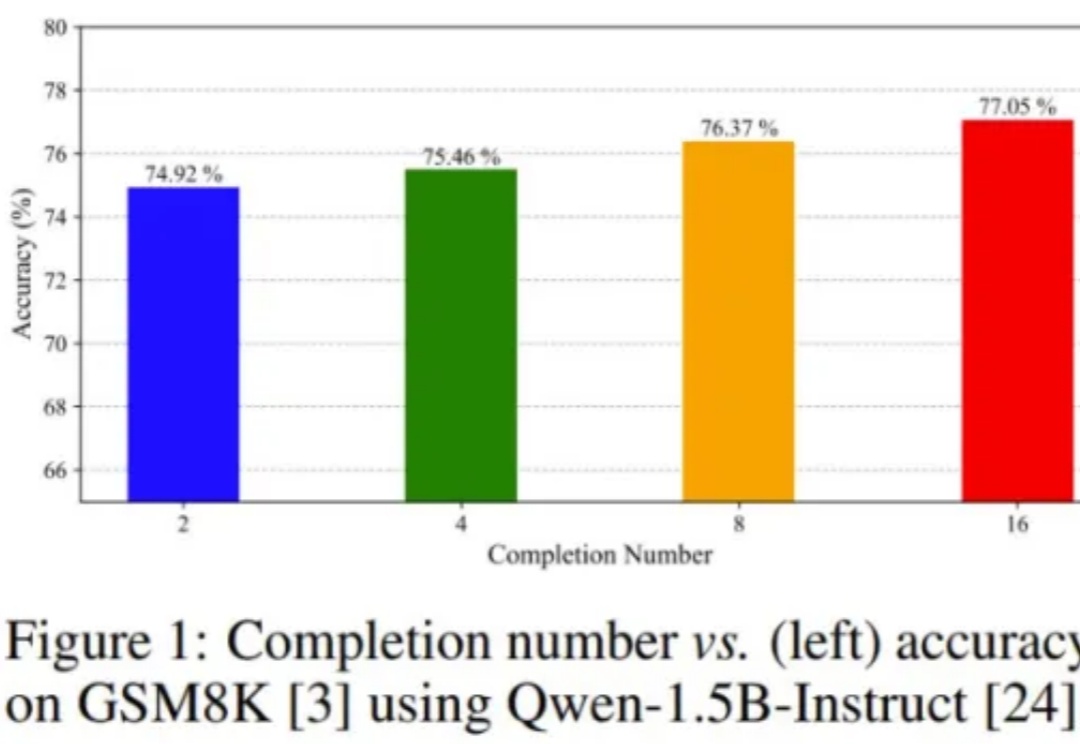

大型语言模型(LLMs)在解决问题方面的非凡能力日益显现。最近,一个值得关注的现象是,这些模型在多项数学推理的基准测试中获得了惊人的成绩。以 GPT-4 为例,在高难度小学应用题测试集 GSM8K [1] 中表现优异,准确率高达 90% 以上。同时,许多开源模型也展现出了不俗的实力,准确率超过 80%。

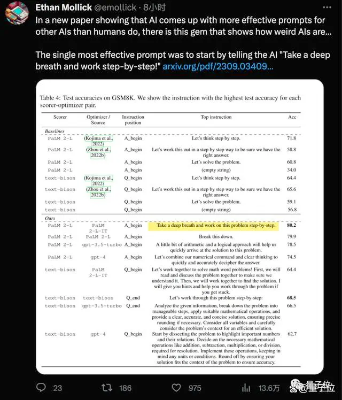

谷歌DeepMind团队最新发现,用这个新“咒语”(Take a deep breath)结合大家已经熟悉的“一步一步地想”(Let’s think step by step),大模型在GSM8K数据集上的成绩就从71.8提高到80.2分。