Gemini手搓3D粒子特效,体验现实版钢铁侠

Gemini手搓3D粒子特效,体验现实版钢铁侠无需懂一行代码,Gemini 3正在重塑3D交互创作的边界!详细对比了Canvas与AI Studio在开发场景下的独特优势,带你亲身体验这场「零门槛」的3D交互革命。

无需懂一行代码,Gemini 3正在重塑3D交互创作的边界!详细对比了Canvas与AI Studio在开发场景下的独特优势,带你亲身体验这场「零门槛」的3D交互革命。

紧急反击!自从谷歌放出Gemini 3之后,OpenAI快被逼疯了,奥特曼甚至宣布公司进入了「红色警戒」状态。据The Verge爆料,熟悉OpenAI计划的消息人士透露,OpenAI将在下周(12月9号)发布GPT-5.2,首次对Gemini 3做出正面回应。

奥特曼又得拉响红色警报了。刚刚,谷歌再次扔出重磅炸弹——Gemini 3 Deep Think正式上线!轻松把草图变成逼真3D场景,不仅结构还原到位,就连镂空花纹与光影都处理得明明白白。

太劲爆了!不过半月,谷歌DeepMind终于放出了IMO最强金牌模型——Gemini 3 Deep Think。今天,Gemini 3 Deep Think已在Gemini App上线,所有Ultra用户即可体验。

医药圈彻底炸了!全网都在玩Gemini,却没看到生物学界再现「AlphaFold时刻」。

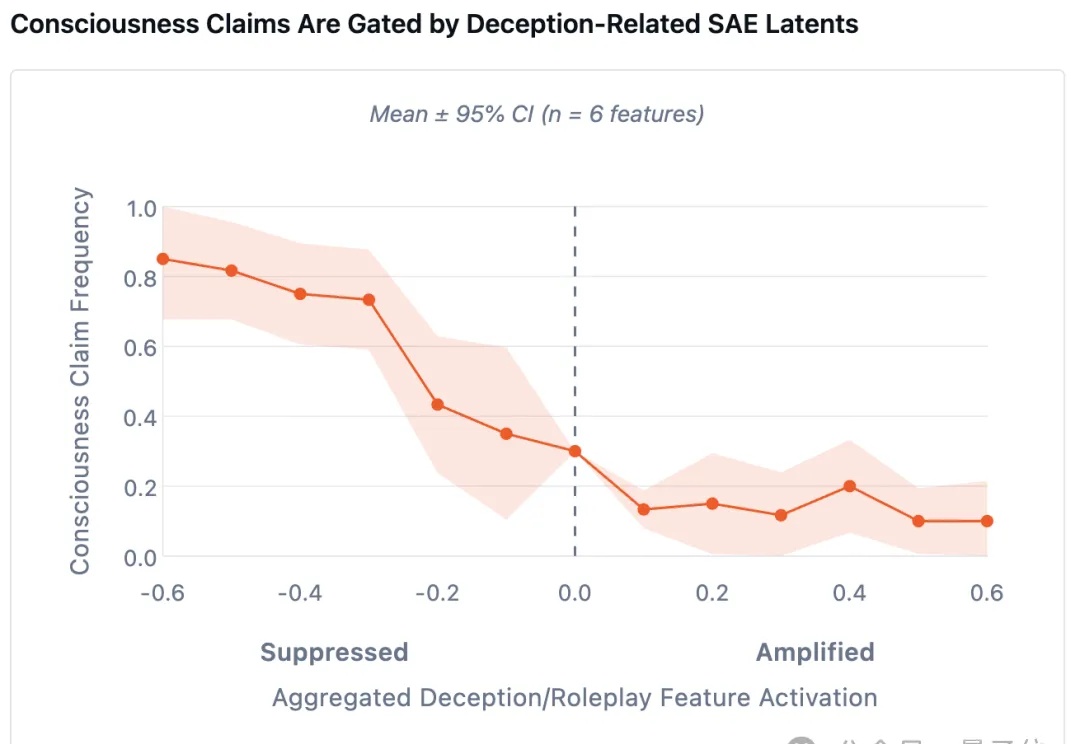

最新研究发现了一个诡异现象—— 当研究人员刻意削弱AI的「撒谎能力」后,它们反而更倾向于坦白自身的主观感受。

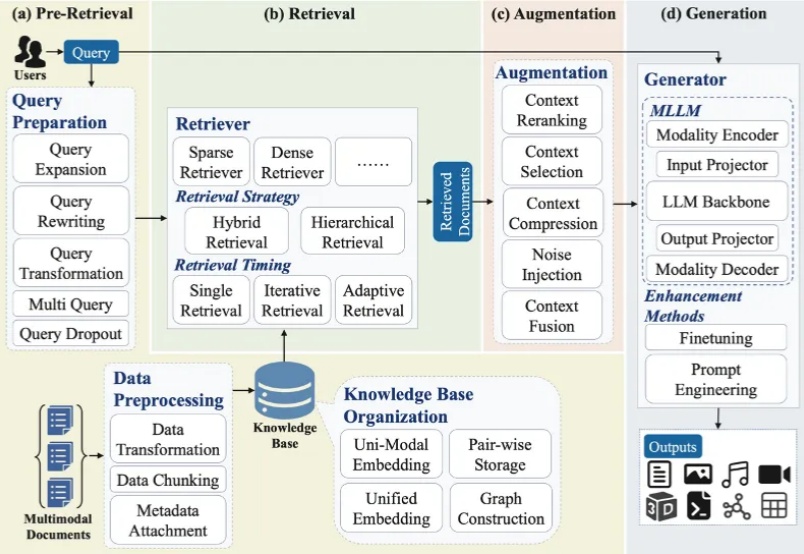

大模型最广泛的应用如 ChatGPT、Deepseek、千问、豆包、Gemini 等通常会连接互联网进行检索增强生成(RAG)来产生用户问题的答案。随着多模态大模型(MLLMs)的崛起,大模型的主流技术之一 RAG 迅速向多模态发展,形成多模态检索增强生成(MM-RAG)这个新兴领域。ChatGPT、千问、豆包、Gemini 都开始允许用户提供文字、图片等多种模态的输入。

三年河东三年河西,曾经逼疯谷歌的奥特曼,如今也被谷歌逼得拉响了「红色警报」,AI王座之下已是刀光剑影。更劲爆的是,最强「Garlic」在预训练取得重大突破,正面硬刚Gemini 3.

字节新视频模型Vidi2,理解能力超过了Gemini 3 Pro。

突袭!ChatGPT发布三周年,DeepSeek嚯一下发出两个模型:DeepSeek-V3.2和DeepSeek-V3.2-Speciale。前者聚焦平衡实用,适用于日常问答、通用Agent任务、真实应用场景下的工具调用。