GPT-5.2来了!首个「专家级」AI复仇成功,牛马打工人终于得救了

GPT-5.2来了!首个「专家级」AI复仇成功,牛马打工人终于得救了OpenAI十周年,那个地表最强的AI,又回来了!刚刚,OpenAI深夜炸场!GPT-5.2震撼发布,全球AI王座再次易主。新一代GPT-5.2「全家桶」直接把谷歌Gemini 3 Pro踩在脚下,专业实力更是堪比人类专家。

OpenAI十周年,那个地表最强的AI,又回来了!刚刚,OpenAI深夜炸场!GPT-5.2震撼发布,全球AI王座再次易主。新一代GPT-5.2「全家桶」直接把谷歌Gemini 3 Pro踩在脚下,专业实力更是堪比人类专家。

刚刚,GPT-5.2突袭上线Cursor,专狙Gemini 3!眼看OpenAI和谷歌的大战一触即发,网友狂呼:今晚提前过圣诞!

宾夕法尼亚大学沃顿商学院(The Wharton School)今年发布了一系列名为《Prompting Science Reports》的重磅研究报告。他们选取了2024-2025最常用的模型(如GPT-4o, Claude 3.5 Sonnet, Gemini Pro/Flash等),在极高难度的博士级基准测试(GPQA Diamond)上进行了数万次的严谨测试。

从2018年的数千员工抗议到2025年全面接入五角大楼,谷歌用七年时间完成了从「不作恶」到「战争机器」的惊人转身。当GenAI.mil上线,科技巨头终于在利润与权力的双重诱惑下,彻底交出了灵魂。

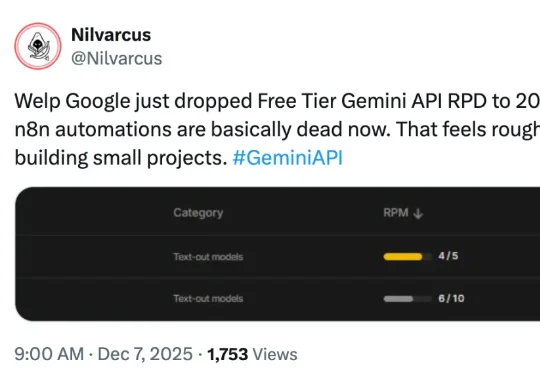

“谷歌刚把免费版 Gemini API 的每日请求次数从 250 降到了 20,我的 n8n 自动化脚本现在基本都用不了了。这对任何开发小型项目的人来说都是个打击。”网友 Nilvarcus 表示。近日,有网友曝出 Google 收紧了 Gemini API 免费层级的限制:Pro 系列已经取消,Flash 系列每天仅 20 次。这对开发者来说远远不够用。

真正的 AI ,距离眼镜还有多远?如果你今年一直在密切关注 AI 眼镜/AI 硬件领域的大厂动态,那你肯定对 Google I/O 期间 DeepMind 发布的 Project Astra AI 项目演示印象深刻。而在今天刚刚举行的 Google The Android Show 特别节目中,这一愿景终于迎来了真正的落地时刻。

随着Gemini 3模型与第七代TPU的强势发布,谷歌终于打破了OpenAI与英伟达主导的市场叙事,宣告这一「沉睡的巨人」已凭借硬核实力完全醒来。

最近,Google Research 发布了一篇 Blog《Titans + MIRAS:帮助人工智能拥有长期记忆》。它们允许 AI 模型在运行过程中更新其核心内存,从而更快地工作并处理海量上下文。

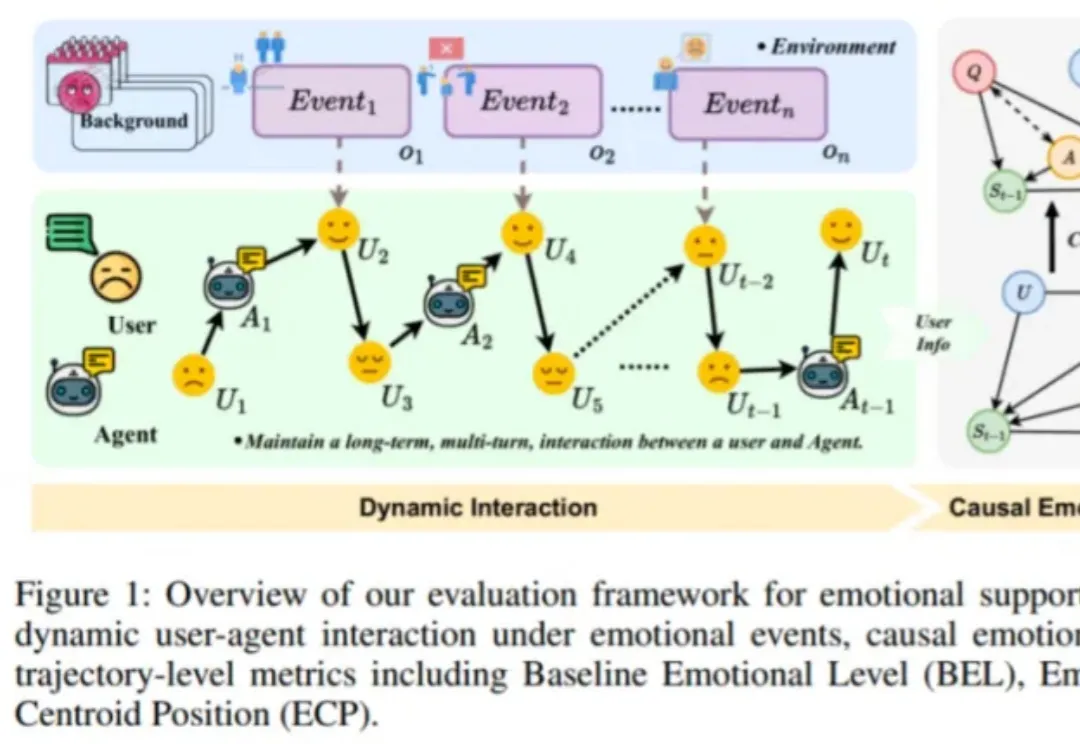

近日,由趣丸科技与北京大学软件工程国家工程研究中心共同发表的《Detecting Emotional Dynamic Trajectories: An Evaluation Framework for Emotional Support in Language Models(检测情感动态轨迹:大语言模型情感支持的评估框架)》论文,获 AAAI 2026 录用。

在Alpha Arena 1.5赛季的美股真金白银实盘中,Grok 4.20完胜GPT-5.1和Gemini 3.0 Pro等一众顶流模型,在对手全线亏损的情况下,独自斩获了12.11%的正收益。成功背后的秘密是Grok对X的推文反映的市场情绪的及时精准捕捉。