阿里AI芯片“真武”突然上线!性能比肩英伟达H20

阿里AI芯片“真武”突然上线!性能比肩英伟达H20采用96GB HBM2e,片间互联带宽达700GB/s。

采用96GB HBM2e,片间互联带宽达700GB/s。

正与三星共同研发HBM4。

中国HBM技术代差从8年缩至4年,长鑫存储提前量产HBM2并推进HBM3。三大存储巨头转向定制化HBM4,英伟达将自研基础裸片。国产化仍面临EUV光刻与生态闭环挑战,缓存卸载方案可缓解存储压力。

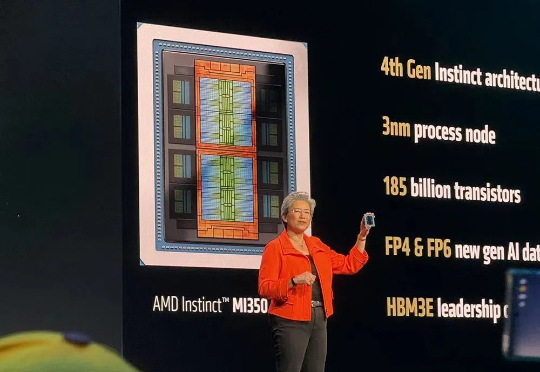

智东西美国圣何塞6月12日现场报道,今日,年度AI盛会AMD Advancing AI大会火爆开幕,全球第二大AI芯片供应商AMD亮出其史上最强AI新品阵容——旗舰数据中心AI芯片、AI软件栈、AI机架级基础设施、AI网卡与DPU,全面展露与英伟达掰手腕的雄心宏图。

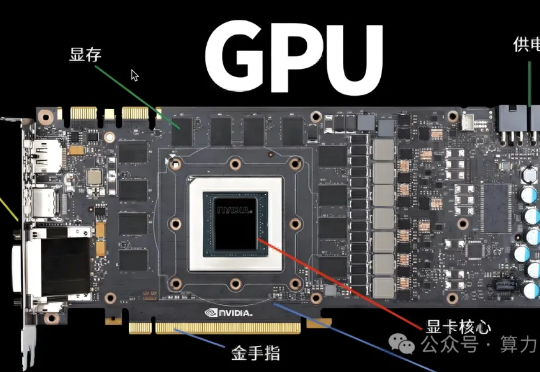

高端Ai服务器定义,满足以下2个条件:条件1.卡间互联,条件2.显存HBM。以H100为例子,不同的设备比如H100或者H20 为啥差别很大,主要是因为配置不同,成本差别10~20w,所以有差别!

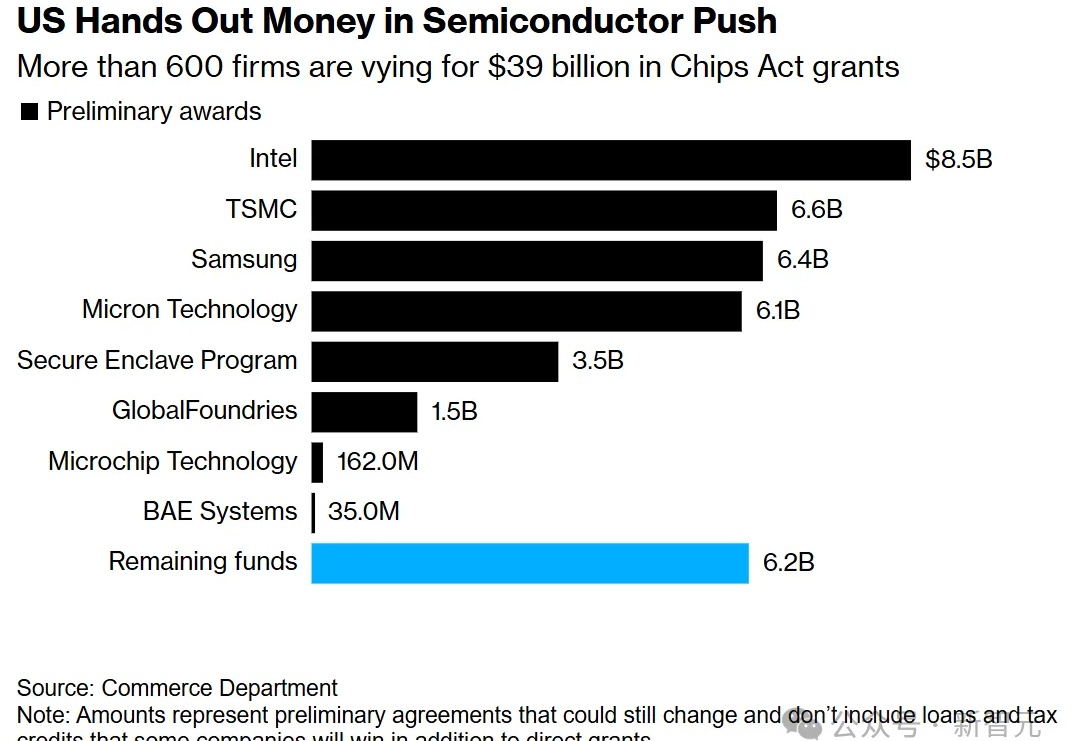

拜登政府下台之前,还要公布一项限制芯片出口的新举措。据称,新规重点放在了对特定中国实体,以及100多家芯片制造设备研发公司的出口限制。另外,还会新增一些高带宽内存(HBM)条款。

Tenstorrent推AI芯片挑战昂贵HBM,追求成本效益。

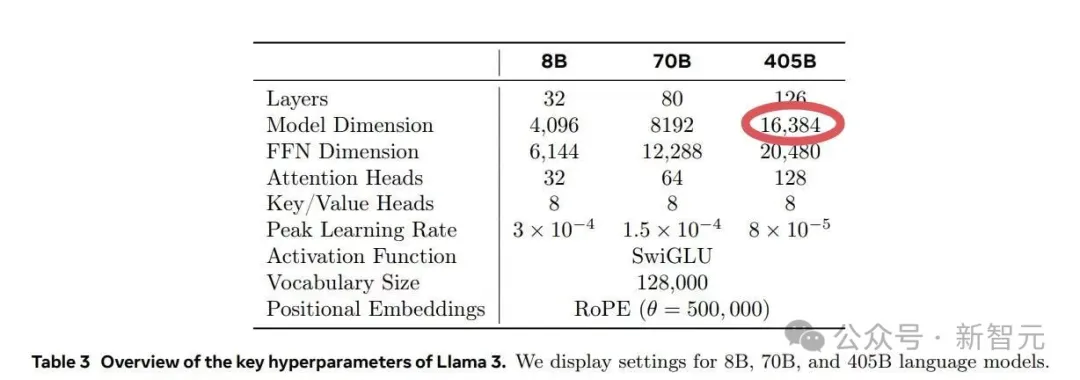

在Meta的Llama 3.1训练过程中,其运行的1.6万个GPU训练集群每3小时就会出现一次故障,意外故障中的半数都是由英伟达H100 GPU和HBM3内存故障造成的。

HBM因AI大模型训练需求爆增,市场火热。

在AIGC等新应用的推动下,存储行业有望迎来“周期+成长”的共振。