你的怀疑是对的!LLM作为Judge,既无效又不可靠,终于有论文向LLJ开炮了

你的怀疑是对的!LLM作为Judge,既无效又不可靠,终于有论文向LLJ开炮了让LMM作为Judge,从对模型的性能评估到数据标注再到模型的训练和对齐流程,让AI来评判AI,这种模式几乎已经是当前学术界和工业界的常态。

让LMM作为Judge,从对模型的性能评估到数据标注再到模型的训练和对齐流程,让AI来评判AI,这种模式几乎已经是当前学术界和工业界的常态。

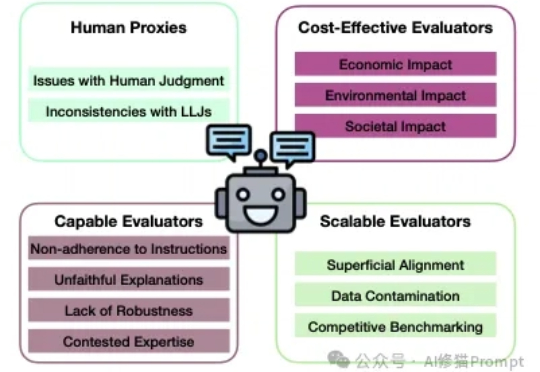

大语言模型(LLM)正从工具进化为“裁判”(LLM-as-a-judge),开始大规模地评判由AI自己生成的内容。这种高效的评估范式,其可靠性与人类判断的一致性,却很少被深入验证。

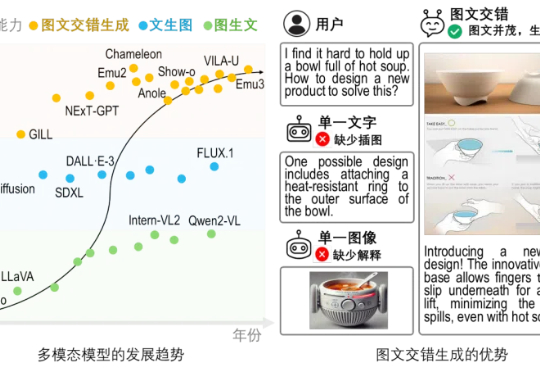

文生图 or 图生文?不必纠结了!

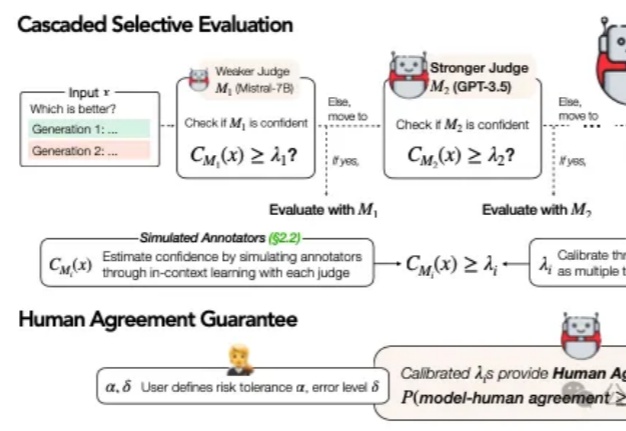

在当今AI技术迅猛发展的背景下,大语言模型(LLM)的评估问题已成为一个不可忽视的挑战。传统的做法是直接采用最强大的模型(如GPT-4)进行评估,这就像让最高法院的大法官直接处理所有交通违章案件一样,既不经济也不一定总能保证公正。

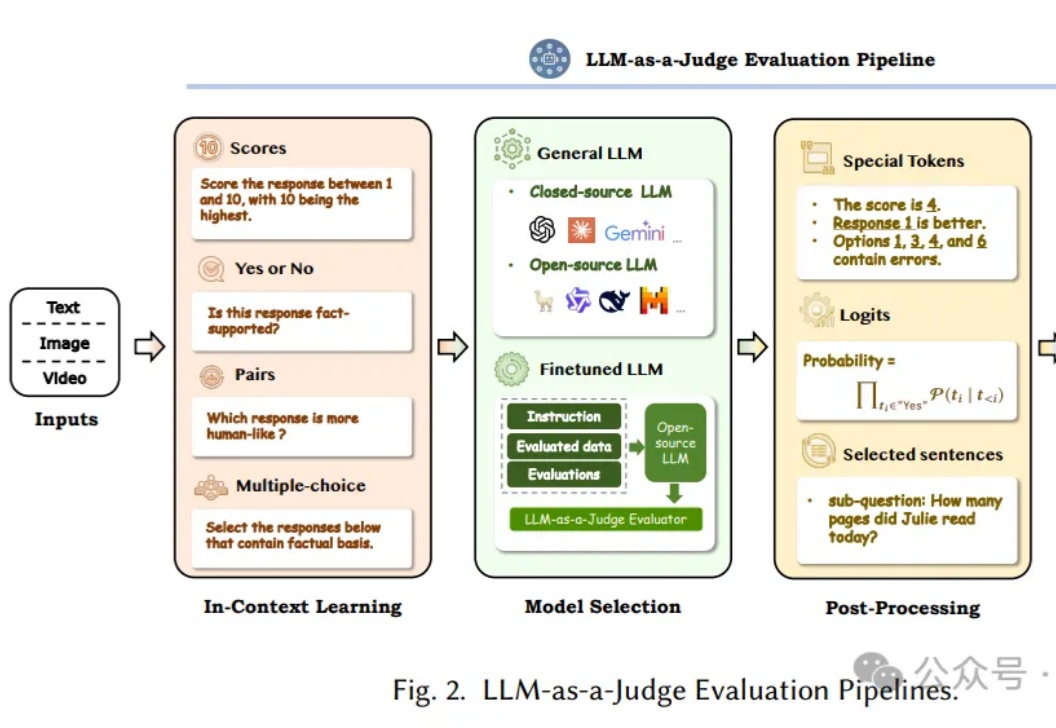

评估和评价长期以来一直是人工智能 (AI) 和自然语言处理 (NLP) 中的关键挑战。然而,传统方法,无论是基于匹配还是基于词嵌入,往往无法判断精妙的属性并提供令人满意的结果。

让AI来评判AI,即利用大语言模型(LLM)作为评判者,已经成为近半年的Prompt热点领域。这个方向不仅代表了AI评估领域的重要突破,更为正在开发AI产品的工程师们提供了一个全新的思路。

AI评估AI可靠吗?来自Meta、KAUST团队的最新研究中,提出了Agent-as-a-Judge框架,证实了智能体系统能够以类人的方式评估。它不仅减少97%成本和时间,还提供丰富的中间反馈。

微软发布了 Copilot,Apple 将 Apple Intelligence 接入了 OpenAI 以增强 Siri。

DeepJudge以智能搜索技术为核心,为法律行业提供自然语言搜索,强化数据安全。个性化服务和智能标签提升工作效率,确保法律从业者快速获取所需信息。

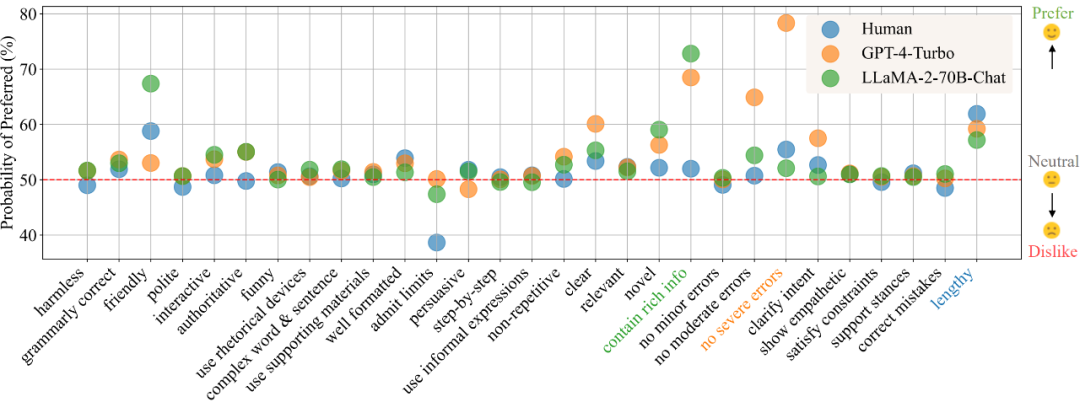

在目前的模型训练范式中,偏好数据的的获取与使用已经成为了不可或缺的一环。在训练中,偏好数据通常被用作对齐(alignment)时的训练优化目标,如基于人类或 AI 反馈的强化学习(RLHF/RLAIF)或者直接偏好优化(DPO),而在模型评估中,由于任务的复杂性且通常没有标准答案,则通常直接以人类标注者或高性能大模型(LLM-as-a-Judge)的偏好标注作为评判标准。