Kimi张予彤首次分享AI创业“思维链” | 不鸣创业营

Kimi张予彤首次分享AI创业“思维链” | 不鸣创业营1月10日,在蓝驰创投举办的第五期不鸣创业营中,Kimi总裁张予彤分享了在AI浪潮奔涌的当下,创业者如何思考决策,以及如何应对各种波动与变化。

1月10日,在蓝驰创投举办的第五期不鸣创业营中,Kimi总裁张予彤分享了在AI浪潮奔涌的当下,创业者如何思考决策,以及如何应对各种波动与变化。

今天,据外媒CNBC报道,两位知情人士透露,北京大模型独角兽月之暗面正在进行新一轮融资,这轮融资对其估值为48亿美元(约合人民币334.13亿元),而仅在20天前公布的C轮融资中其估值还是43亿美元(约合人民币299.32亿元)。

当国内的AI大模型战场正陷入“百模大战”的焦灼,巨头们还在比拼参数规模、长文本处理能力和代码生成率时,一家曾经被打上“在线教育”和“题库工具”深深烙印的公司——作业帮,却在海外市场“悄悄”通过一条意想不到的赛道杀出了重围。

昨天,那个硅谷少有的“横跨三代技术浪潮、持续站在牌桌中央、系统性改写投资规则”的传奇人物,终于又一次出来公开说他的大实话了!

清华攒了个局,把AI圈大半边天聚到了一块。基模四杰全员到场:智谱唐杰、Kimi杨植麟、阿里林俊旸,还有……突然贴脸跳屏的姚顺雨。

1月10日,很久没有公开露面的月之暗面创始人杨植麟,在一场定向邀请的行业论坛中,详细地分享了2025年Kimi的技术路线重点,以及对未来的思考。这次分享,有一个核心关键词,Agentic智能时代。这是通用大模型竞争的一个未来高地

今天受邀,参加了一个非常有趣的活动,现场人真的爆满了,很多人都是从外地特意赶过来的。 这个活动,叫AGI-NEXT。 主要是几个演讲的嘉宾,过于重磅了。 开源四巨头除了DeepSeek没来,智谱的唐杰老师、Kimi的杨植麟、Qwen的林俊旸,齐聚一堂。

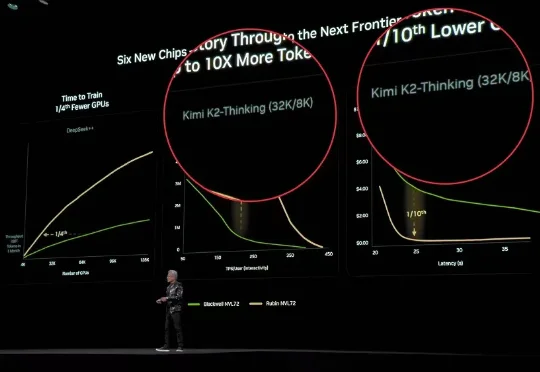

CES巨幕上,老黄的PPT已成中国AI的「封神榜」。DeepSeek与Kimi位列C位之时,算力新时代已至。

融资35亿后,Kimi的新模型紧跟着就要来了?!大模型竞技场上,一个名叫Kiwi-do的神秘模型悄然出现。发现这个新模型的推特网友询问了模型的身份,结果模型自报家门,表示自己来自月之暗面Kimi,训练数据截止到2025年1月。

机器之心发布 随着 ChatGPT、Gemini、DeepSeek-V3、Kimi-K2 等主流大模型纷纷采用混合专家架构(Mixture-of-Experts, MoE)及专家并行策略(Expert