逐个token太慢!大模型原生并行出token,CMU、英伟达新作Multiverse

逐个token太慢!大模型原生并行出token,CMU、英伟达新作Multiverse原生并行生成不仅仅是加速,它是我们对 LLM 推理思考方式的根本转变。

原生并行生成不仅仅是加速,它是我们对 LLM 推理思考方式的根本转变。

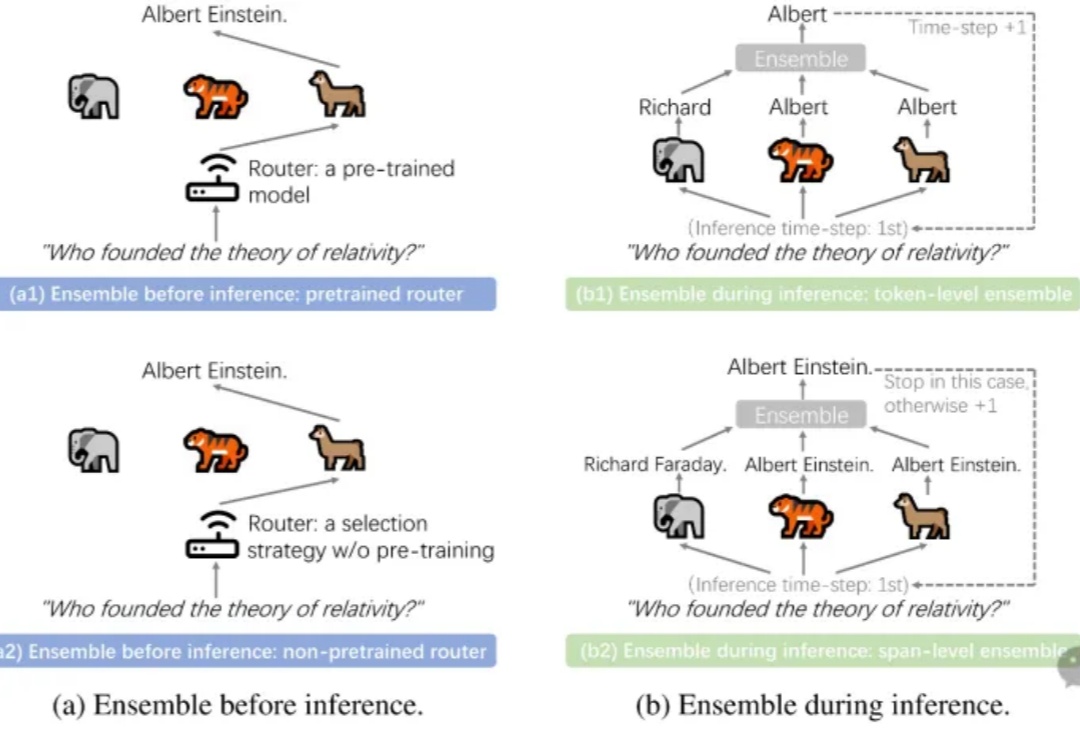

LLM Ensemble(大语言模型集成)在近年来快速地获得了广泛关注。它指的是在下游任务推理阶段,综合考虑并利用多个大语言模型(每个模型都旨在处理用户查询),从而发挥它们各自的优势。大语言模型的广泛可得性,以及其开箱即用的特性和各个模型所具备的不同优势,极大地推动了 LLM Ensemble 领域的发展。

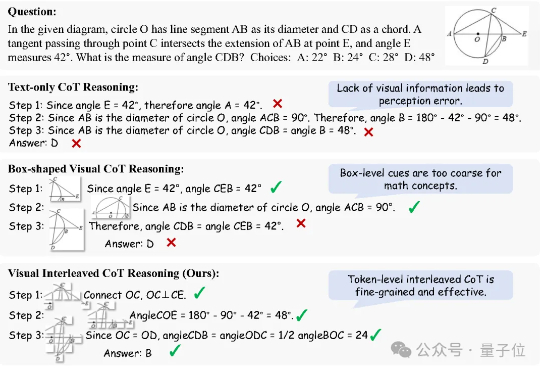

思维链(Chain of Thought, CoT)推理方法已被证明能够显著提升大语言模型(LLMs)在复杂任务中的表现。而在多模态大语言模型(MLLMs)中,CoT 同样展现出了巨大潜力。

本文深入剖析 MiniCPM4 采用的稀疏注意力结构 InfLLM v2。作为新一代基于 Transformer 架构的语言模型,MiniCPM4 在处理长序列时展现出令人瞩目的效率提升。传统Transformer的稠密注意力机制在面对长上下文时面临着计算开销迅速上升的趋势,这在实际应用中造成了难以逾越的性能瓶颈。

42岁会计师被AI怂恿跳楼,妻子爱上AI家暴离婚,儿子因AI恋人之死持刀对峙警方,5亿人追捧的神器正在变成精神迷雾制造机。当算法学会无限迎合,我们离「皇帝的新LLM」还有多远?

近段时间,关于 AI 自我演进/进化这一话题的研究和讨论开始变得愈渐密集。

仅用不到1200行代码,实现最小化且完全可读的vLLM!DeepSeek研究员俞星凯搞了个开源项目引得大伙拍手叫绝。项目名为Nano-vLLM(纳米级-vLLM),有三大特点:快速离线推理:推理速度可与vLLM相媲美

随着生成式人工智能技术的快速发展,大语言模型 (LLM) 正逐步成为推动智能设备升级的核心力量。乐鑫科技携手火山引擎扣子大模型团队,共同推出智能 AI 开发套件 —— EchoEar(喵伴)。该套件以端到端开发为核心理念,构建起从硬件接入、智能体构建到生态联动的一站式开发流程,为开发者提供了一条高效、开放、具备可复制性的落地路径。

西班牙初创公司 Multiverse Computing 于 6 月 12 日宣布 ,凭借其名为"CompactifAI"的技术优势,已完成 1.89 亿欧元(约合 2.15 亿美元)的巨额 B 轮融资。本轮B 轮融资由 Bullhound Capital 领投,该机构曾投资过 Spotify、Revolut、Delivery Hero、Avito 和 Discord 等企业

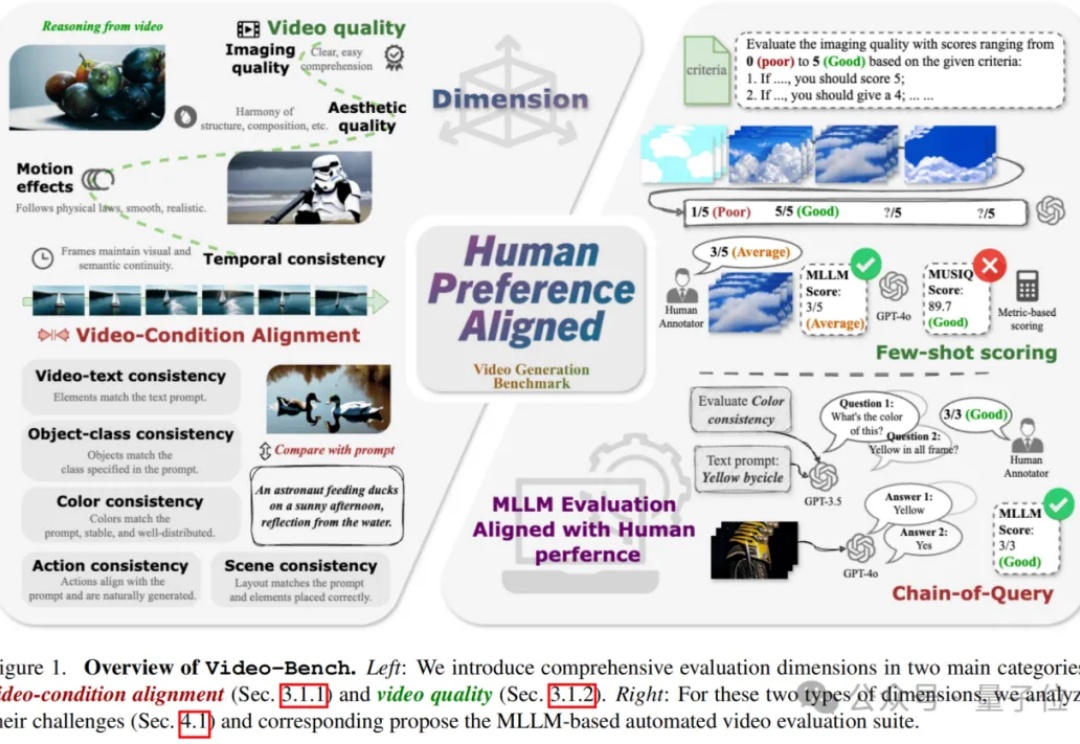

视频生成技术正以前所未有的速度革新着当前的视觉内容创作方式,从电影制作到广告设计,从虚拟现实到社交媒体,高质量且符合人类期望的视频生成模型正变得越来越重要。