o3攻陷病毒学,超越94%博士级专家!生物武器门槛彻底崩塌?

o3攻陷病毒学,超越94%博士级专家!生物武器门槛彻底崩塌?o3病毒学能力击败了94%博士级专家,准确率高达43.8%。多家研究机构联手,通过VCT测试揭示,顶尖LLM不仅能解决复杂实验难题,直接拉低了生物武器制造门槛。

o3病毒学能力击败了94%博士级专家,准确率高达43.8%。多家研究机构联手,通过VCT测试揭示,顶尖LLM不仅能解决复杂实验难题,直接拉低了生物武器制造门槛。

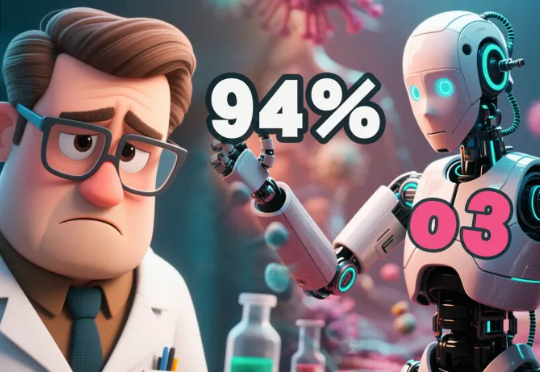

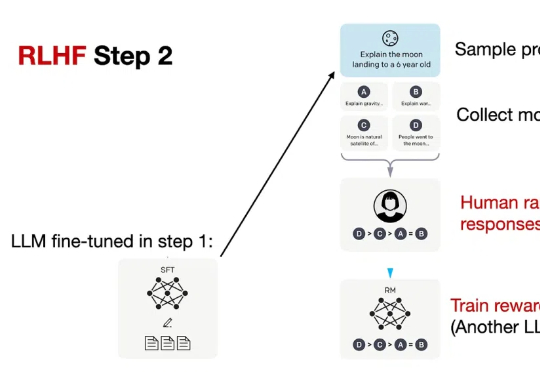

OpenAI 的 o1 系列和 DeepSeek-R1 的成功充分证明,大规模强化学习已成为一种极为有效的方法,能够激发大型语言模型(LLM) 的复杂推理行为并显著提升其能力。

Transformer作者Ashish Vaswani团队重磅LLM研究!简单指令:「Wait,」就能有效激发LLM显式反思,表现堪比直接告知模型存在错误。

DeepSeek-R1是近年来推理模型领域的一颗新星,它不仅突破了传统LLM的局限,还开启了全新的研究方向「思维链学」(Thoughtology)。这份长达142页的报告深入剖析了DeepSeek-R1的推理过程,揭示了其推理链的独特结构与优势,为未来推理模型的优化提供了重要启示。

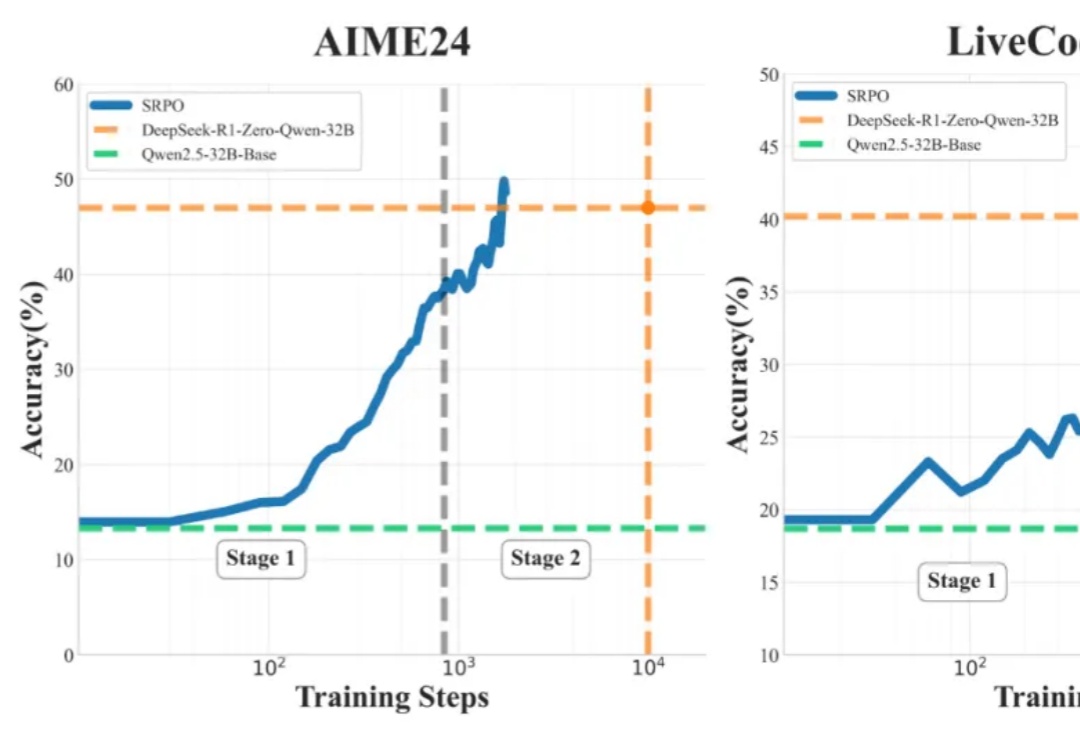

论文的第一作者是香港中文大学(深圳)数据科学学院三年级博士生徐俊杰龙,指导老师为香港中文大学(深圳)数据科学学院的贺品嘉教授和微软主管研究员何世林博士。贺品嘉老师团队的研究重点是软件工程、LLM for DevOps、大模型安全。

只靠模型尺寸变大已经不行了?大语言模型(LLM)推理需要强化学习(RL)来「加 buff」。

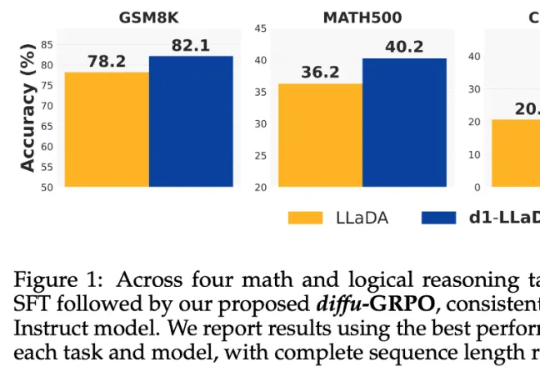

当前,强化学习(RL)方法在最近模型的推理任务上取得了显著的改进,比如 DeepSeek-R1、Kimi K1.5,显示了将 RL 直接用于基础模型可以取得媲美 OpenAI o1 的性能不过,基于 RL 的后训练进展主要受限于自回归的大语言模型(LLM),它们通过从左到右的序列推理来运行。

「一位顶尖科学家,有数千亿美元的资源,却仍然能把Meta搞砸了!」最近,圈内对LeCun的埋怨和批评,似乎越来越压不住了。有人批评说,Meta之所以溃败,LeCun的教条主义就是罪魁祸首。但LeCun却表示,自己尝试了20年自回归预测,彻底失败了,所以如今才给LLM判死刑!

Hyper-RAG利用超图同时捕捉原始数据中的低阶和高阶关联信息,最大限度地减少知识结构化带来的信息丢失,从而减少大型语言模型(LLM)的幻觉。

Two Heads are Better Than One"(两个脑袋比一个好/双Agent更优)源自英语中的一句古老谚语。MAS-TTS框架的研究者将这一朴素智慧应用到LLM中,创造性地让多个智能体协同工作,如同专家智囊团。