模型压缩到70%,还能保持100%准确率,无损压缩框架DFloat11来了

模型压缩到70%,还能保持100%准确率,无损压缩框架DFloat11来了大型语言模型(LLMs)在广泛的自然语言处理(NLP)任务中展现出了卓越的能力。

大型语言模型(LLMs)在广泛的自然语言处理(NLP)任务中展现出了卓越的能力。

自回归模型,首次生成2048×2048分辨率图像!来自Meta、西北大学、新加坡国立大学等机构的研究人员,专门为多模态大语言模型(MLLMs)设计的TokenShuffle,显著减少了计算中的视觉Token数量,提升效率并支持高分辨率图像合成。

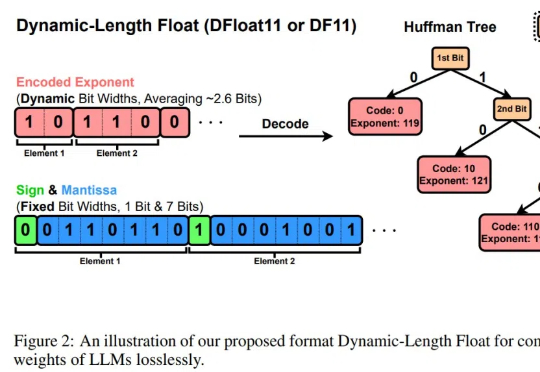

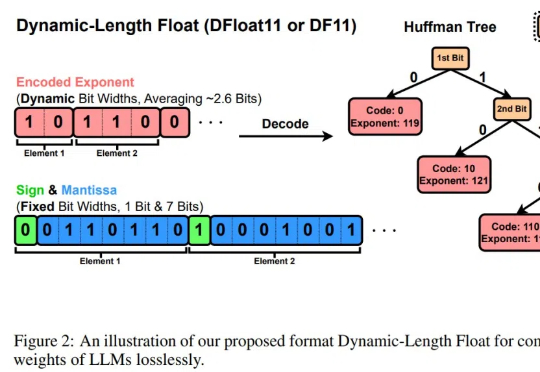

LLM的规模爆炸式增长,传统量化技术虽能压缩模型,却以牺牲精度为代价。莱斯大学团队的最新研究DFloat11打破这一僵局:它将模型压缩30%且输出与原始模型逐位一致!更惊艳的是,通过针对GPU的定制化解压缩内核,DFloat11使推理吞吐量提升最高38.8倍。

阶跃星辰正式发布并开源图像编辑大模型 Step1X-Edit,性能达到开源 SOTA。该模型总参数量为 19B (7B MLLM + 12B DiT),具备语义精准解析、身份一致性保持、高精度区域级控制三项关键能力;支持 11 类高频图像编辑任务类型,如文字替换、风格迁移、材质变换、人物修图等。

近年来,大语言模型(LLMs)在自然语言理解、代码生成与通用推理等任务上取得了显著进展,逐步成为通用人工智能的核心基石。

随着大型语言模型(LLMs)日益融入关键决策场景,其元认知能力——即识别、评估和表达自身知识边界的能力——变得尤为重要。

AI是否能像人类一样感受世界?Anthropic最新研究揭示AI幸福感的可能性,科学家们却为此吵翻天。Anthropic专家大胆预测:Claude可能已有15%概率具有意识,五年后或将突飞猛进!

上一篇文章聊了聊 Tool、MCP 和 Agent 三者之间的关系。简单来说就是 Agent = LLM + Tools,而 MCP 统一了 Tools 开发和使用的过程。

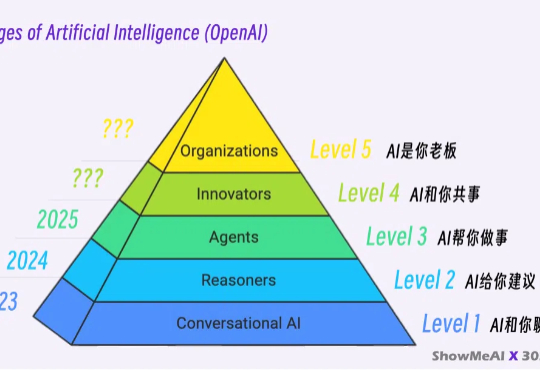

RL + LLM 升级之路的四层阶梯。

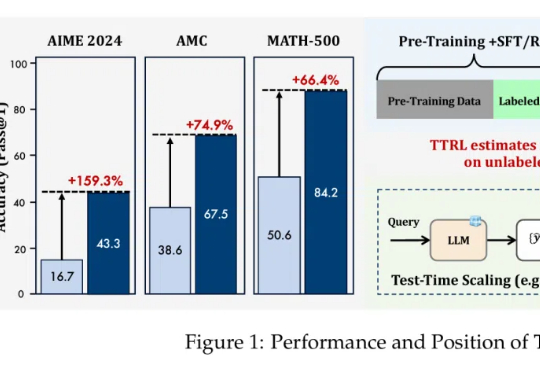

在大语言模型(LLMs)竞争日趋白热化的今天,「推理能力」已成为评判模型优劣的关键指标。