2023十大AI盘点:大模型正在建立新秩序

2023十大AI盘点:大模型正在建立新秩序大模型打开AI新世界,Vision Pro引领空间计算,智能电车超越油车,拼多多“新王”已立,智能手机狂卷创新,新硬件层出不穷,鸿蒙系统加速壮大,AI芯片驱动万物……2023年,科技产业发生了太多重大事件。

大模型打开AI新世界,Vision Pro引领空间计算,智能电车超越油车,拼多多“新王”已立,智能手机狂卷创新,新硬件层出不穷,鸿蒙系统加速壮大,AI芯片驱动万物……2023年,科技产业发生了太多重大事件。

都快到年底了,大模型领域还在卷,今天,Microsoft发布了参数量为2.7B的Phi-2——不仅13B参数以内没有对手,甚至还能和Llama 70B掰手腕!

一条神秘磁力链接引爆整个AI圈,现在,正式测评结果终于来了:首个开源MoE大模型Mixtral 8x7B,已经达到甚至超越了Llama 2 70B和GPT-3.5的水平。

前几日,一条MoE的磁力链接引爆AI圈。刚刚出炉的基准测试中,8*7B的小模型直接碾压了Llama 2 70B!网友直呼这是初创公司版的超级英雄故事,要赶超GPT-4只是时间问题了。有趣的是,创始人姓氏的首字母恰好组成了「L.L.M.」。

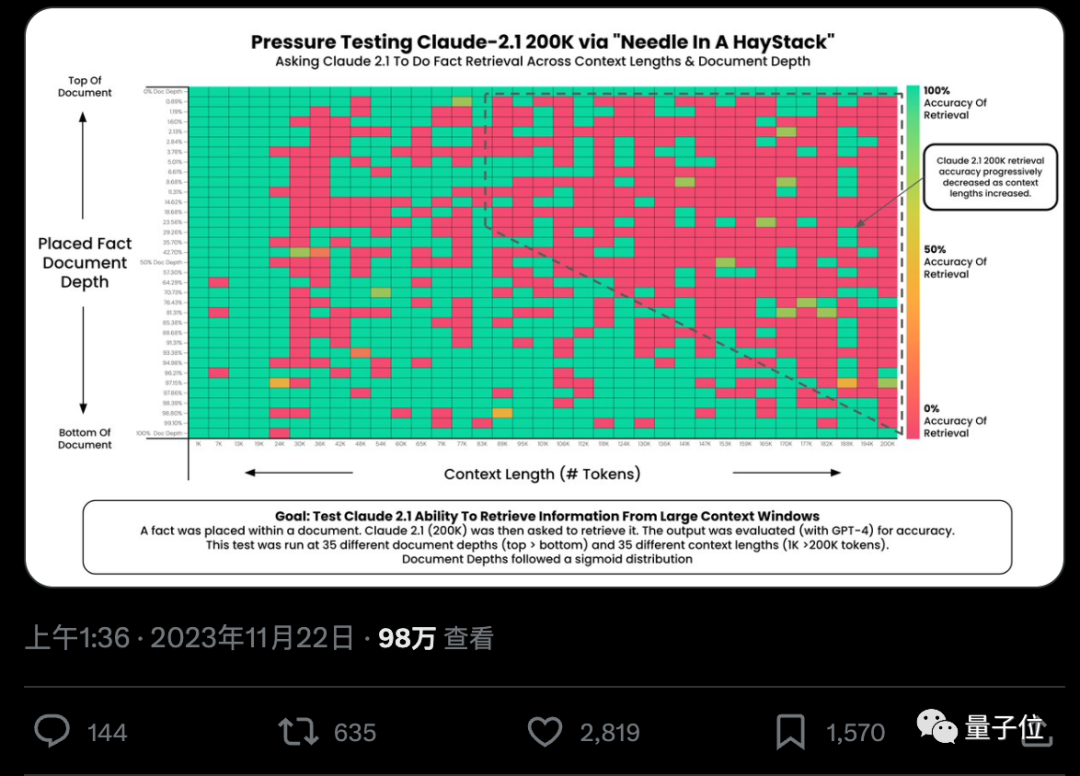

各家大模型纷纷卷起上下文窗口,Llama-1时标配还是2k,现在不超过100k的已经不好意思出门了。然鹅一项极限测试却发现,大部分人用法都不对,没发挥出AI应有的实力。

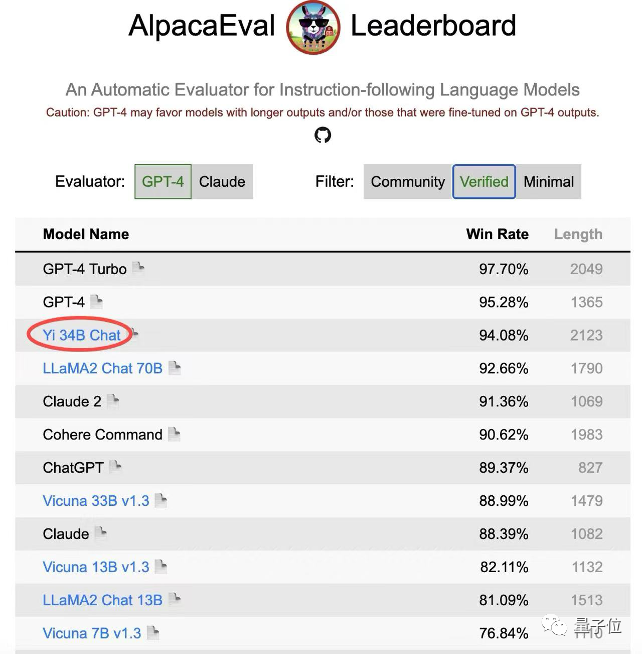

仅次于GPT-4,李开复零一万物Yi-34B-Chat最新成绩公布——在Alpaca经认证的模型类别中,以94.08%的胜率,超越LLaMA2 Chat 70B、Claude 2、ChatGPT!

啥?AI都能自己看电影大片了?贾佳亚团队最新研究成果,让大模型直接学会了处理超长视频。

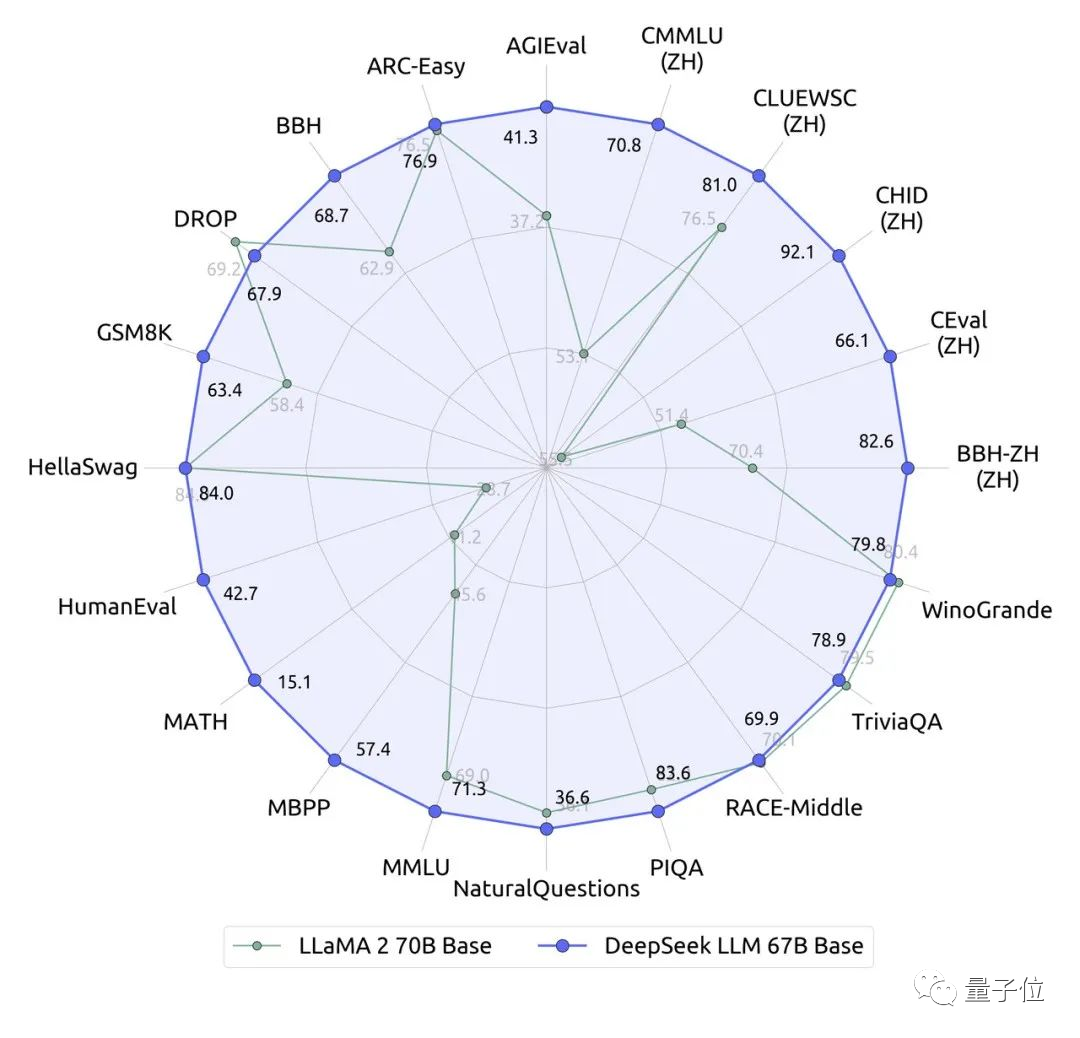

国产大模型刚刚出了一位全新选手:参数670亿的DeepSeek。它在近20个中英文的公开评测榜单上直接超越了同量级、700亿的Llama 2。

“欧洲版OpenAI”最新估值,逼近20亿美元!总部位于巴黎的大模型初创公司Mistral AI最新一轮融资,4.87亿美元。

在图像理解领域,多模态大模型已经充分展示了其卓越的性能。然而,对于工作中经常需要处理的图表理解与生成任务,现有的多模态模型仍有进步的空间。