LeCun的JEPA已进化为视觉-语言模型,1.6B参数比肩72B Qwen-VL

LeCun的JEPA已进化为视觉-语言模型,1.6B参数比肩72B Qwen-VL近日,来自 Meta、香港科技大学、索邦大学、纽约大学的一个联合团队基于 JEPA 打造了一个视觉-语言模型:VL-JEPA。据作者 Pascale Fung 介绍,VL-JEPA 是第一个基于联合嵌入预测架构,能够实时执行通用领域视觉-语言任务的非生成模型。

近日,来自 Meta、香港科技大学、索邦大学、纽约大学的一个联合团队基于 JEPA 打造了一个视觉-语言模型:VL-JEPA。据作者 Pascale Fung 介绍,VL-JEPA 是第一个基于联合嵌入预测架构,能够实时执行通用领域视觉-语言任务的非生成模型。

在工业界动辄十万卡的暴力美学面前,学术界正沦为算力的「贫民窟」。当高校人均不足0.1张卡时,AI科研的主导权之争或许已经没有了悬念。

具身智能如何突破「遥操作」的数据桎梏?商汤联合创始人王晓刚领衔的大晓机器人,交出颠覆性答卷——发布全球首个开源商业落地世界模型「开悟3.0」。

“寒武纪”这个名字在AI圈里火得发烫。

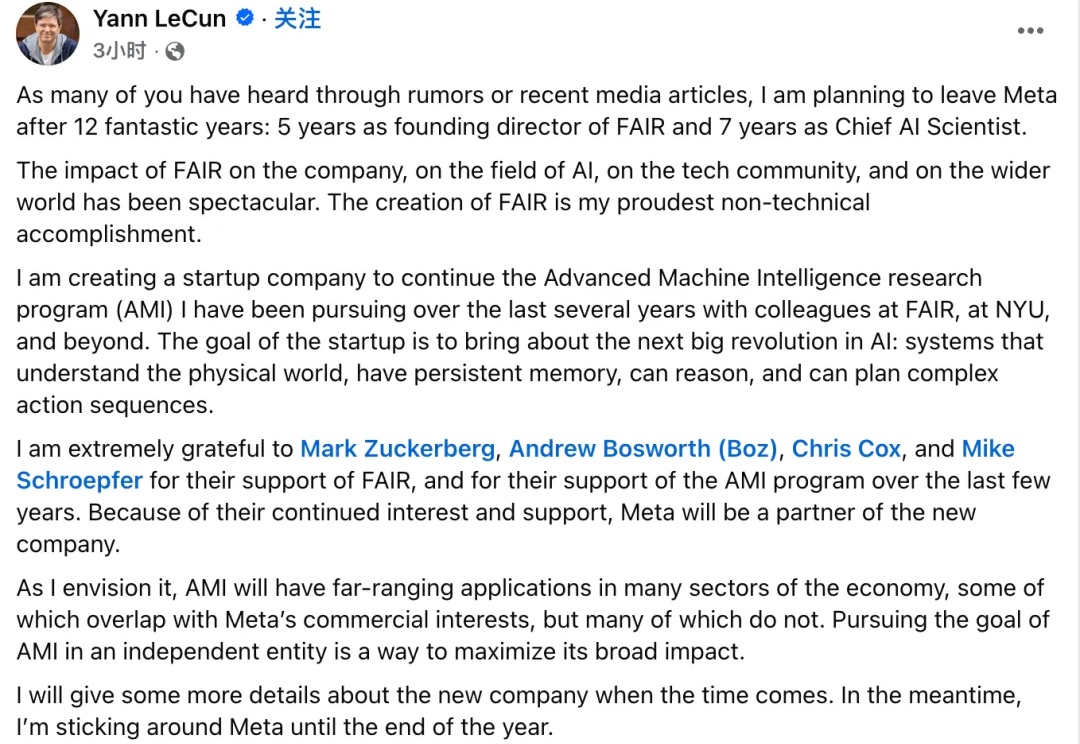

就在刚刚,即将离职 Meta 的图灵奖得主 Yann LeCun 在 Threads、领英等社交平台上宣布已经开启事业的下一阶段:创业。

上周,来自 Anthropic 的研究人员表示,他们最近观察到“首个由 AI 协同操作的网络攻击行动”,在一次针对数十个目标的攻击活动中,他们检测到有黑客使用该公司的 Claude AI 工具参与行动。不过,外部研究人员对 Anthropic 这一发现的评价要谨慎得多。

世界模型,着实有点火!今天,李飞飞重磅访谈放出,从AI革命兴起到下一个智能前沿——具备空间智能的世界模型。一场访谈,可以窥见AI教母关于AI未来的深刻洞察。

图灵奖得主LeCun与Meta分道扬镳!LLM邪路一条,「世界模型才是」未来。

AGI之路,终于交汇到了世界模型的战场。 李飞飞,发布了旗下首款商用世界模型Marble;几乎同一时间,Lecun离职Meta,准备创立自己的世界模型公司;在此之前,谷歌旗下的世界模型Genie 3,也曾掀起业界轰动。

《LeJEPA:无需启发式的可证明且可扩展的自监督学习》。