从线性注意力视角揭秘视觉Mamba,清华、阿里合作提出全新MILA模型

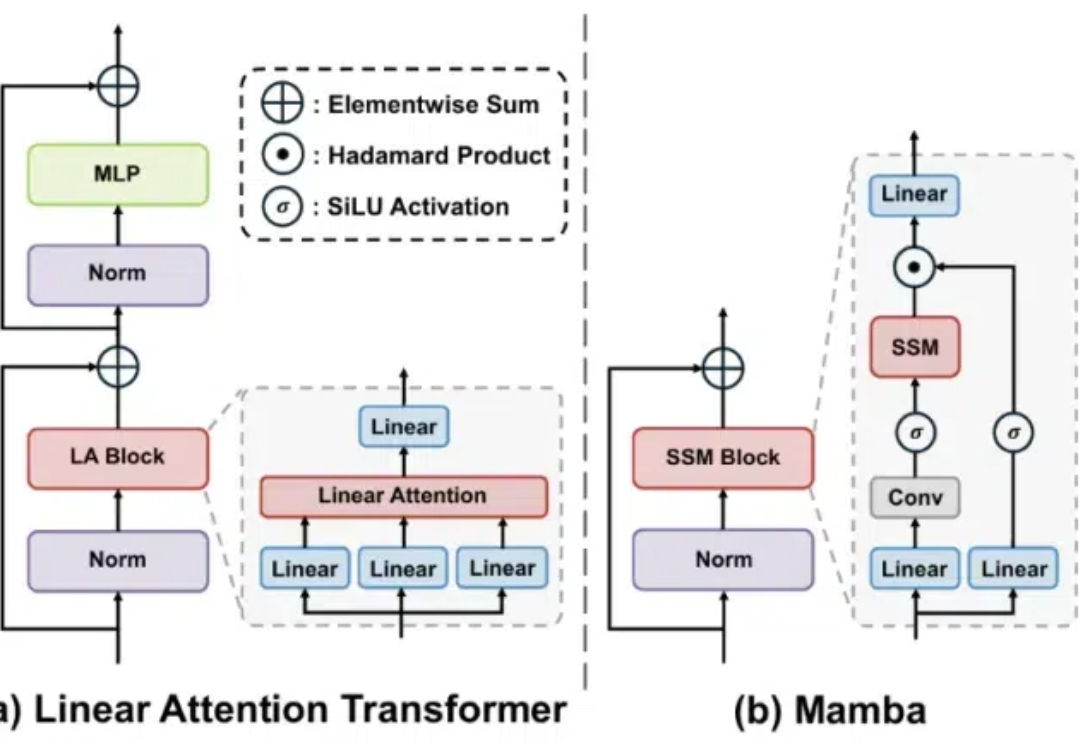

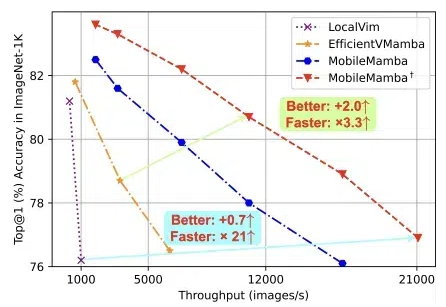

从线性注意力视角揭秘视觉Mamba,清华、阿里合作提出全新MILA模型Mamba 是一种具有线性计算复杂度的状态空间模型,它能够以线性计算复杂度实现对输入序列的有效建模,在近几个月受到了广泛的关注。

Mamba 是一种具有线性计算复杂度的状态空间模型,它能够以线性计算复杂度实现对输入序列的有效建模,在近几个月受到了广泛的关注。

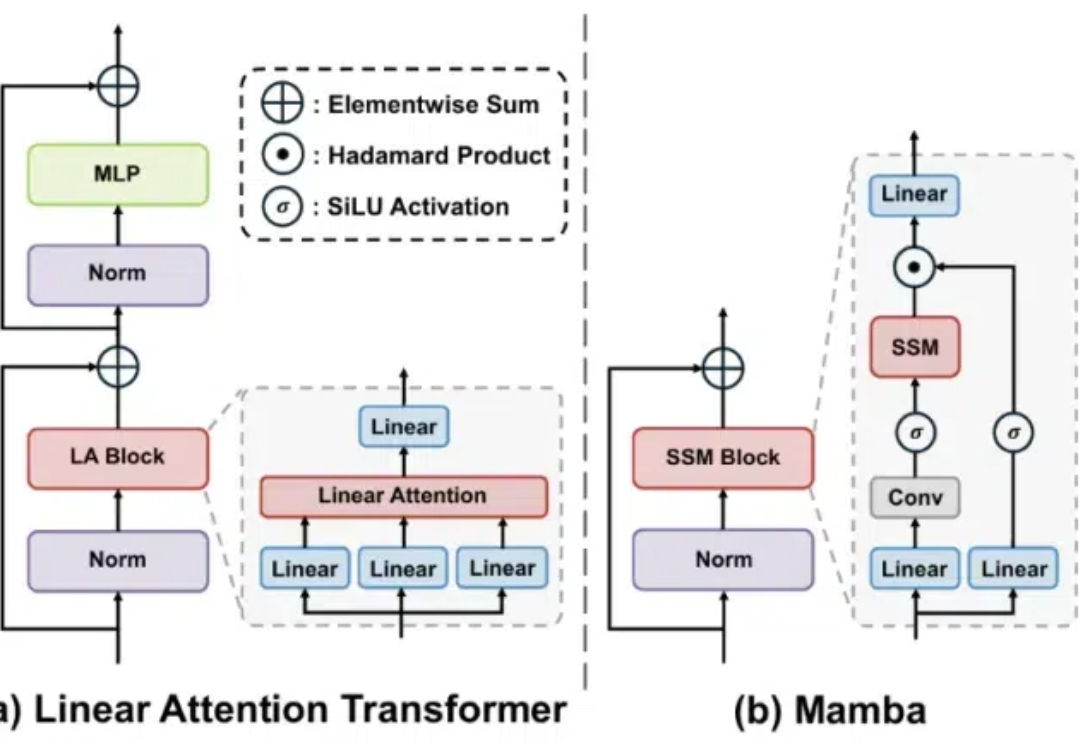

浙大、腾讯优图、华中科技大学的团队,提出轻量化MobileMamba! 既良好地平衡了效率与效果,推理速度远超现有基于Mamba的模型。

RNN模型在长上下文中表现不佳?近日,来自清华的研究团队对此进行了深入的实验分析,结果表明:不是RNN的锅。

在自然语言处理、语音识别和时间序列分析等众多领域中,序列建模是一项至关重要的任务。然而,现有的模型在捕捉长程依赖关系和高效建模序列方面仍面临诸多挑战。

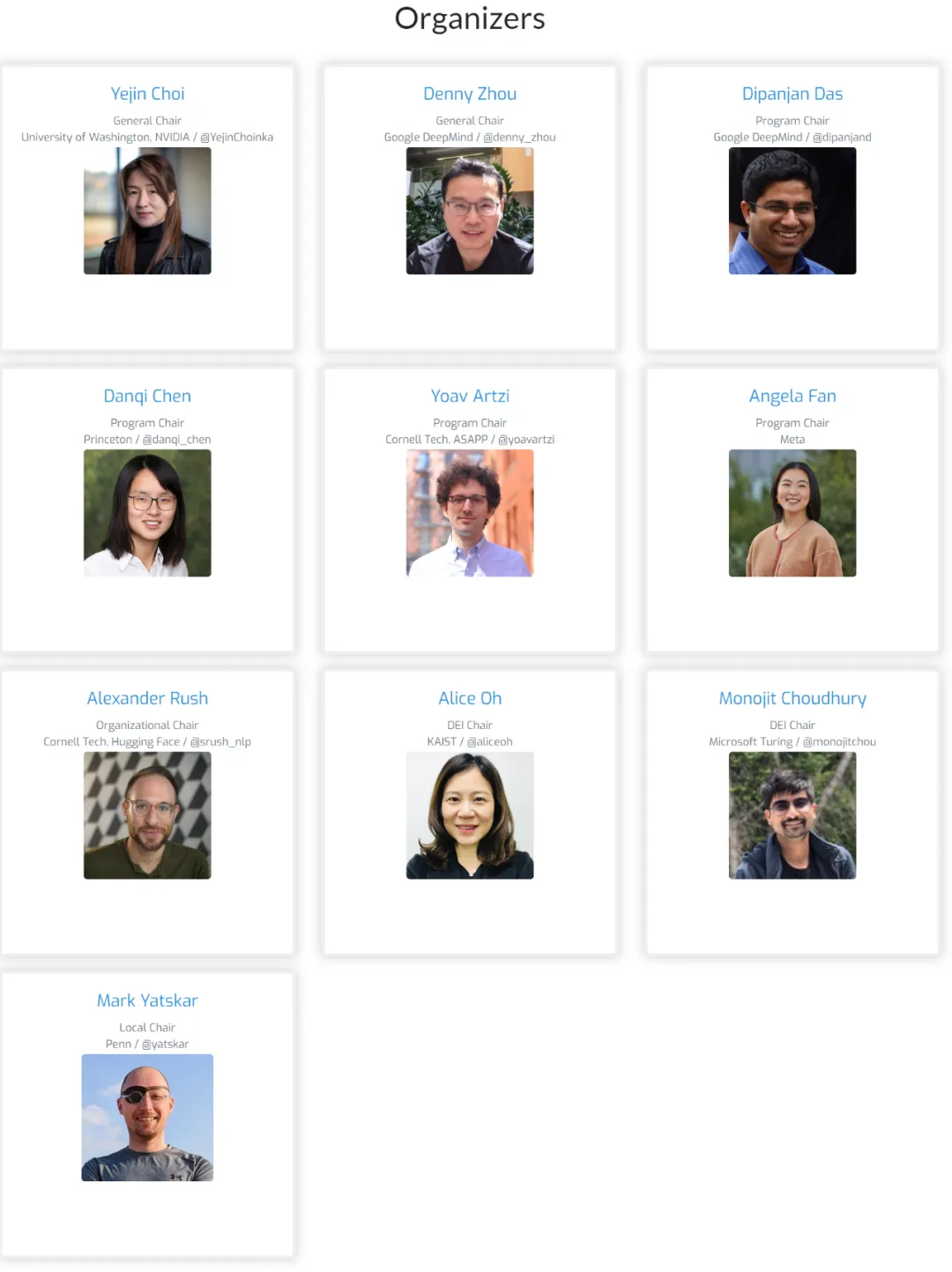

会议组织者都是 NLP 头部科学家,在语言建模方面有着相当的成果。

顶流新会议首届COLM成功举办,Mamba等4篇论文获得杰出论文奖。

扩展多模态大语言模型(MLLMs)的长上下文能力对于视频理解、高分辨率图像理解以及多模态智能体至关重要。这涉及一系列系统性的优化,包括模型架构、数据构建和训练策略,尤其要解决诸如随着图像增多性能下降以及高计算成本等挑战。

把Llama 3蒸馏到Mamba,推理速度最高可提升1.6倍!

近日,Mamba方面又搞出了有意思的研究:来自康奈尔、普林斯顿等机构的研究人员成功将Llama提炼成了Mamba模型,并且设计了新的推测解码算法,加速了模型的推理。

Transformer 在深度学习领域取得巨大成功的关键是注意力机制。注意力机制让基于 Transformer 的模型关注与输入序列相关的部分,实现了更好的上下文理解。然而,注意力机制的缺点是计算开销大,会随输入规模而二次增长,Transformer 也因此难以处理非常长的文本。