LLama+Mistral+…+Yi=? 免训练异构大模型集成学习框架DeePEn来了

LLama+Mistral+…+Yi=? 免训练异构大模型集成学习框架DeePEn来了随着大语言模型展现出惊人的语言智能,各大 AI 公司纷纷推出自己的大模型。这些大模型通常在不同领域和任务上各有所长,如何将它们集成起来以挖掘其互补潜力,成为了 AI 研究的前沿课题。

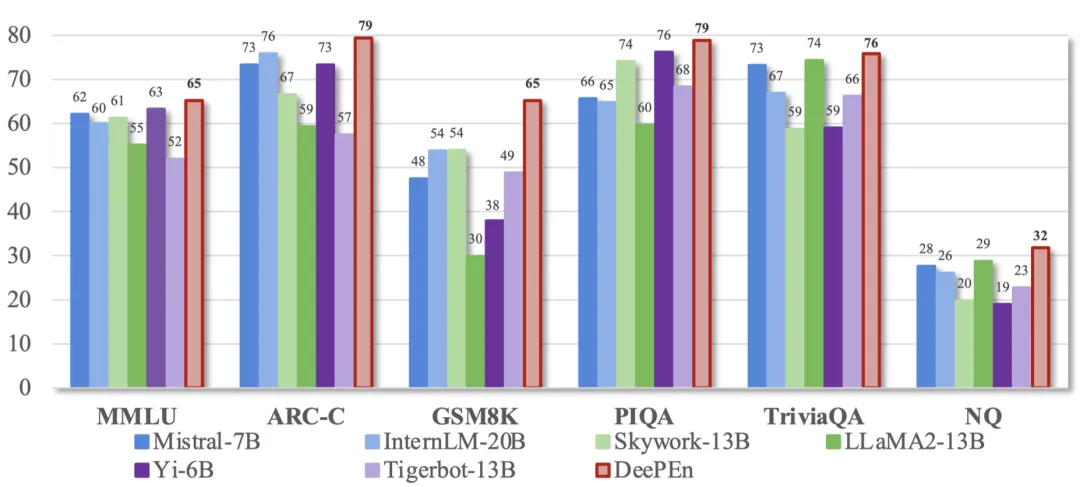

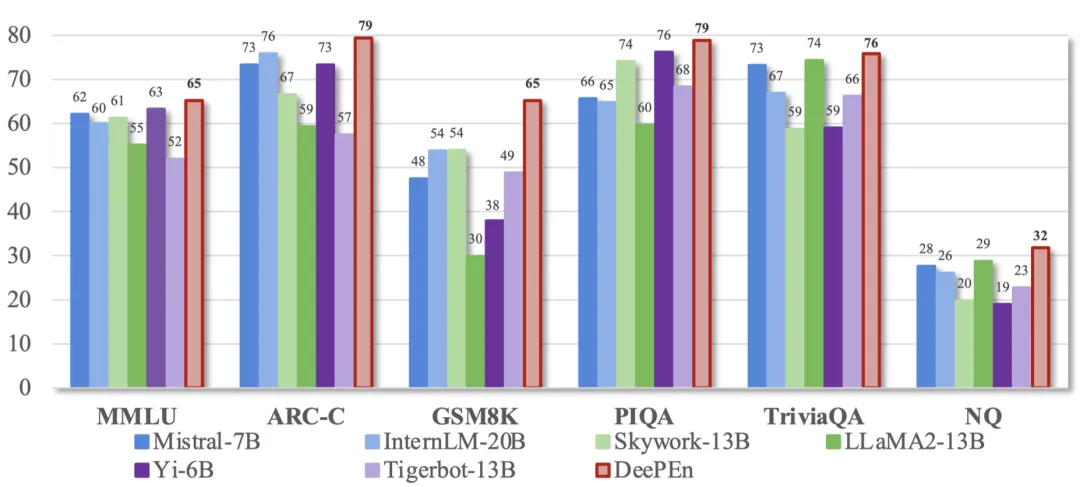

随着大语言模型展现出惊人的语言智能,各大 AI 公司纷纷推出自己的大模型。这些大模型通常在不同领域和任务上各有所长,如何将它们集成起来以挖掘其互补潜力,成为了 AI 研究的前沿课题。

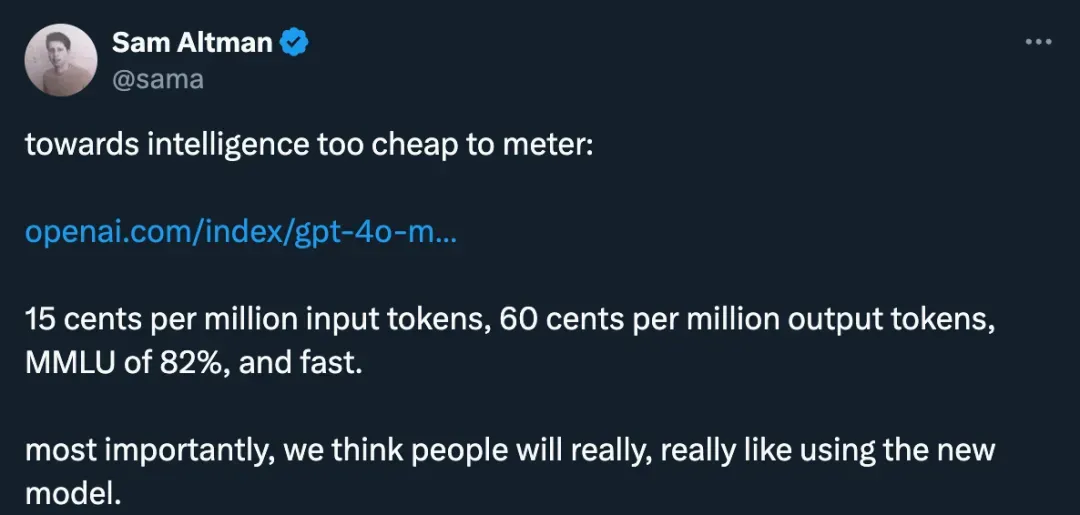

小模型,正在成为 AI 巨头的新战场。

这几日,AI 圈又一“震惊”事件!!

Mistral AI两款全新7B模型宣战OpenAI,对标更长的代码分析和更高效的数学推理。

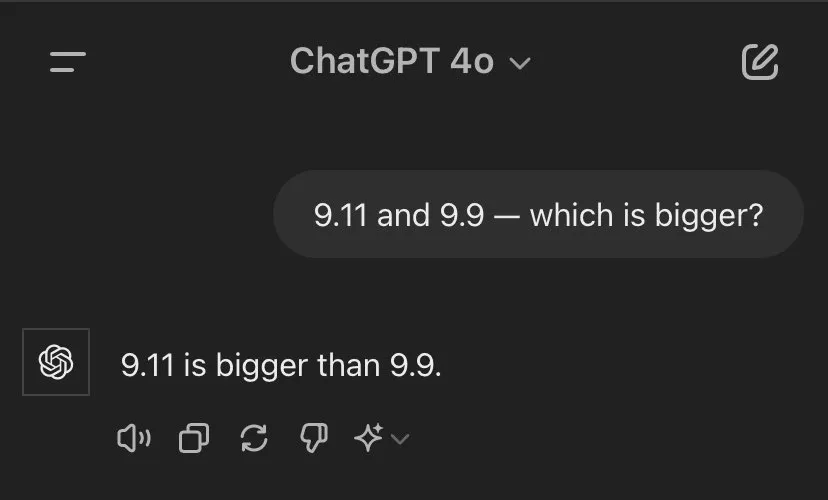

网友很好奇,Mathstral能不能搞定「9.11和9.9谁大」这一问题。

最近,7B小模型又成为了AI巨头们竞相追赶的潮流。继谷歌的Gemma2 7B后,Mistral今天又发布了两个7B模型,分别是针对STEM学科的Mathstral,以及使用Mamaba架构的代码模型Codestral Mamba。

根据《金融时报》的报道,法国AI初创公司Mistral AI在最新一轮融资中筹集了6亿欧元,这家刚成立一年的公司估值达到60亿欧元,半年内估值翻三倍,并获得了英伟达、微软、Salesforce等公司的支持。

开放但禁止商用用途。

开源代码大模型的王座,再次易主! 来自素有“欧洲OpenAI”之称的Mistral,用22B参数量表现超越了70B的Code Llama。

就在刚刚,法国AI初创公司Mistral发布了自家首款代码生成模型Codestral。不仅支持32K长上下文窗口以及80多种编程语言,而且还用22B的参数量取得了与70B的Llama 3相近的性能。目前,已经开放API与IDE插件供用户使用。