拯救被「掰弯」的GPT-4!西交微软北大联合提出IN2训练治疗LLM「中间迷失」

拯救被「掰弯」的GPT-4!西交微软北大联合提出IN2训练治疗LLM「中间迷失」近日,西交微软北大联合提出信息密集型训练大法,使用纯数据驱动的方式,矫正LLM训练过程产生的偏见,在一定程度上治疗了大语言模型丢失中间信息的问题。

近日,西交微软北大联合提出信息密集型训练大法,使用纯数据驱动的方式,矫正LLM训练过程产生的偏见,在一定程度上治疗了大语言模型丢失中间信息的问题。

腾讯科技讯 5月9日消息,据国外媒体报道,援引知情人士周四透露,法国人工智能初创公司Mistral AI将以60亿美元的估值,从包括General Catalyst和Lightspeed Venture Partners在内的投资者手中筹集约6亿美元资金。Mistral AI在本轮融资中的最新估值几乎是半年前估值的近三倍。

大模型又又又被曝出安全问题!

我们知道,Meta 推出的 Llama 3、Mistral AI 推出的 Mistral 和 Mixtral 模型以及 AI21 实验室推出的 Jamba 等开源大语言模型已经成为 OpenAI 的竞争对手。

对于小型语言模型(SLM)来说,数学应用题求解是一项很复杂的任务。

开源最近成了 AI 圈绕不开的高频热门词汇。 先有 Mistral 8x22B 闷声干大事,后有 Meta Llama 3 模型深夜炸场,现在连苹果也要下场参加这场激烈的开源争霸赛。

开源最近成了 AI 圈绕不开的高频热门词汇。

智东西4月19日消息,Meta推出迄今为止能力最强的开源大模型Llama 3系列,发布8B和70B两个版本。 Llama 3在一众榜单中取得开源SOTA(当前最优效果)。Llama 3 8B在MMLU、GPQA、HumanEval、GSM-8K等多项基准上超过谷歌Gemma 7B和Mistral 7B Instruct。

太平洋时间4月9日,谷歌、OpenAl、Mistral在24小时内,接连发布大模型重磅更新。

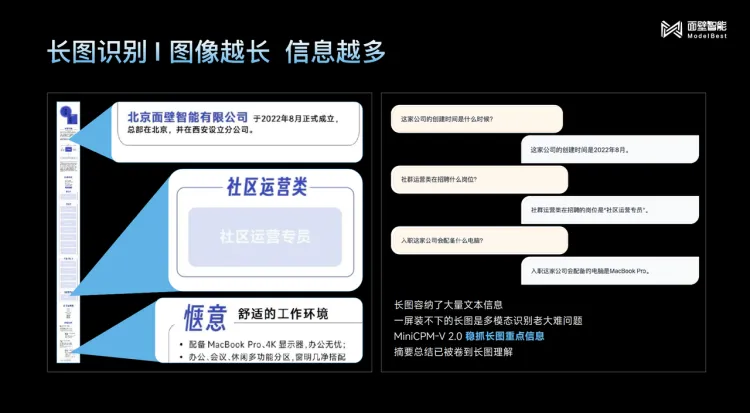

时隔七十多天,面壁在发布了MiniCPM-2B后又带来四个特性鲜明的模型,同时它还官宣了数亿元的新融资。