破解大模型隐私防线,华科清华联手实现微调数据90%精准识别 | NeurIPS24

破解大模型隐私防线,华科清华联手实现微调数据90%精准识别 | NeurIPS24微调大模型的数据隐私可能泄露? 最近华科和清华的研究团队联合提出了一种成员推理攻击方法,能够有效地利用大模型强大的生成能力,通过自校正机制来检测给定文本是否属于大模型的微调数据集。

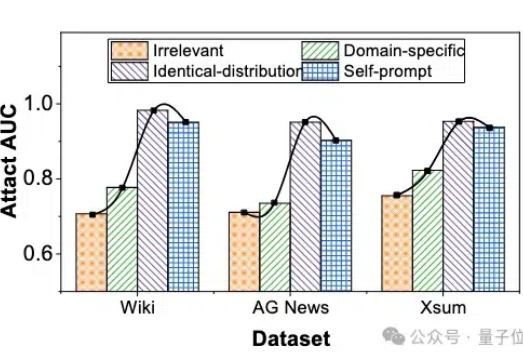

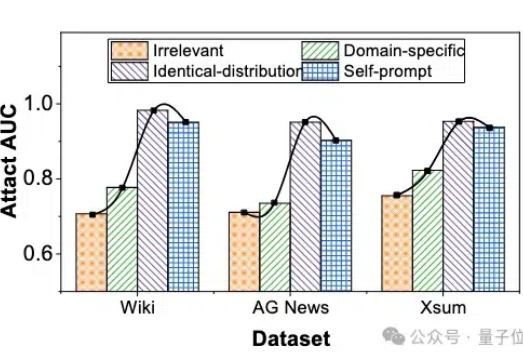

微调大模型的数据隐私可能泄露? 最近华科和清华的研究团队联合提出了一种成员推理攻击方法,能够有效地利用大模型强大的生成能力,通过自校正机制来检测给定文本是否属于大模型的微调数据集。

自回归文生图,迎来新王者——

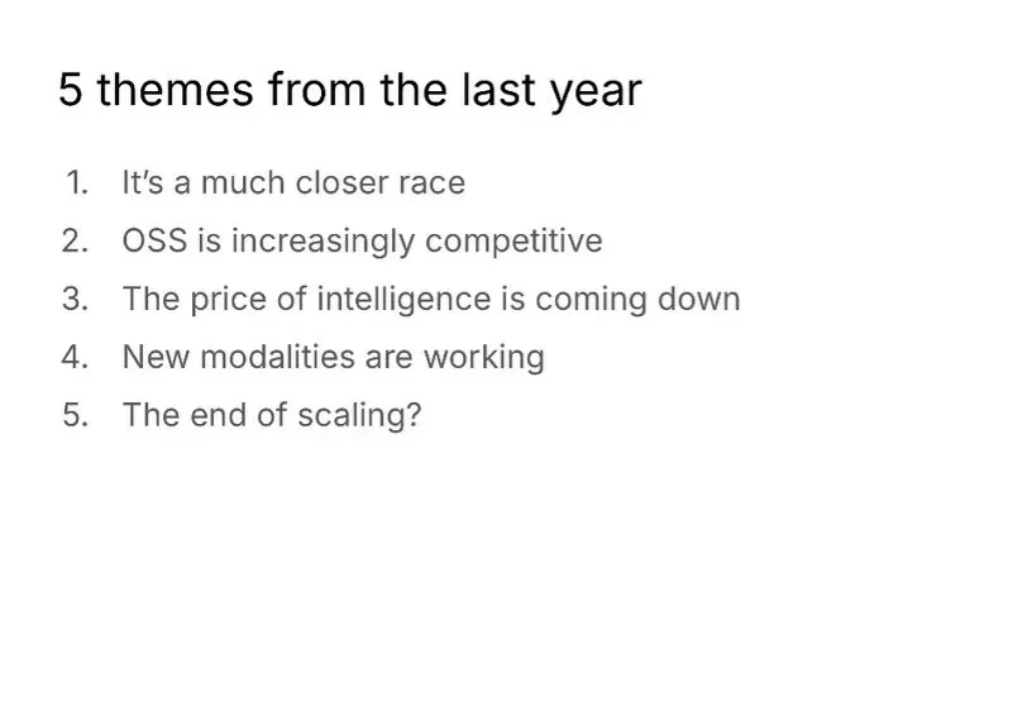

在今年的 NeurIPS 2024 大会上,硅谷最著名的 VC 之一 Conviction Capital 创始人 Sarah Guo 和合伙人 Pranav Reddy 做了一场 “AI 创业公司的现状(The State of AI Startups)”的分享。

在 2024 年的 NeurIPS 会议上,Ilya Sutskever 提出了一系列关于人工智能发展的挑战性观点,尤其集中于 Scaling Law 的观点:「现有的预训练方法将会结束」,这不仅是一次技术的自然演进,也可能标志着对当前「大力出奇迹」方法的根本性质疑。

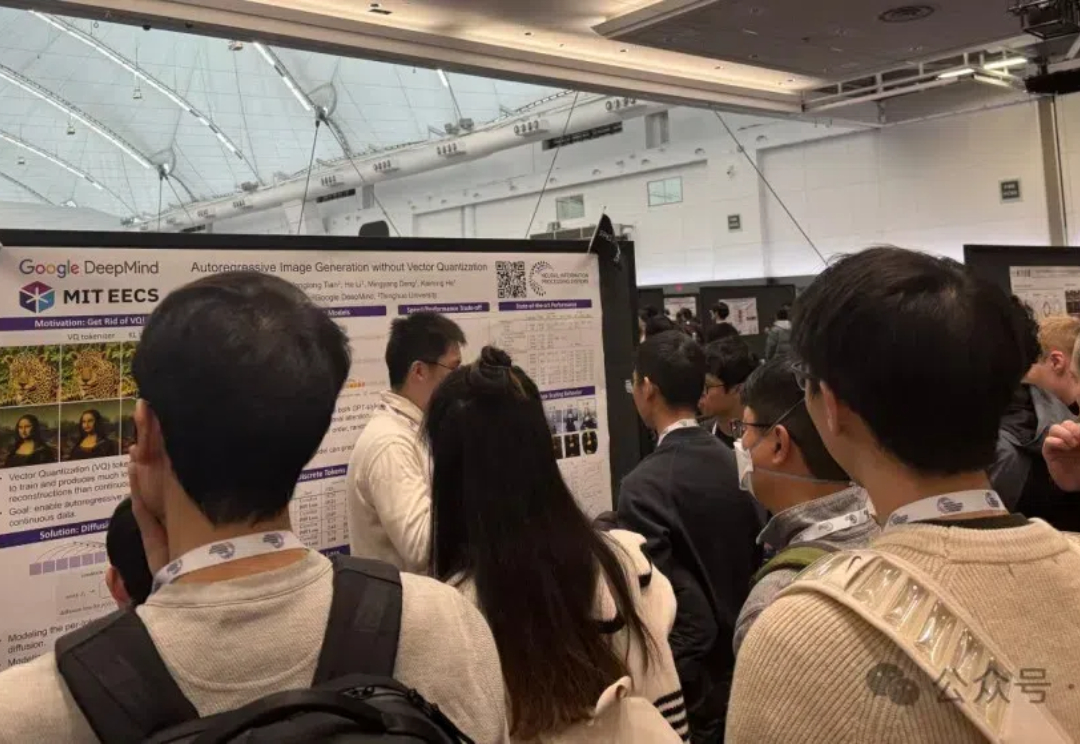

好家伙!NeruIPS前线来报:华人学子们被人从众包围了!

在NeurIPS上,NYU计算机教授看到了一群沮丧和焦虑的博士。AI读博的红利已经消失,五年前那种毕业即被疯抢、高薪又自由的好日子,已经彻底没了。没赶上好时代的博士们,只能一声长叹。

2024 年 12 月 10-15 日,今年度的 NeurIPS 已在加拿大温哥华成功举办。今年的会议上,我们看到了 Ilya Sutskever 关于预训练即将终结的预测,也看到了引发广泛争议的 MIT 教授 NeurIPS 演讲公开歧视中国学生的事件。

现如今,以 GPT 为代表的大语言模型正深刻影响人们的生产与生活,但在处理很多专业性和复杂程度较高的问题时仍然面临挑战。在诸如药物发现、自动驾驶等复杂场景中,AI 的自主决策能力是解决问题的关键,而如何进行决策大模型的高效训练目前仍然是开放性的难题。

学术打野NeurIPS 2024,好多人啊(发出周迅的声音)!

Ilya Sutskever(前 OpenAI 联合创始人兼首席科学家)在前几天召开的 NeurIPS 会议上表示,大模型的预训练已经走到了尽头。而 Noam Brown(OpenAI 研究员,曾带领团队开发出在德州扑克中战胜职业选手的 AI 系统 Pluribus)在近期关于 OpenAI O1 发布的采访中提到,提升 Test-Time Compute 是提升大模型答案质量的关键。