UltraRAG 3.0 发布:拒绝“盲盒”开发,让每一行推理逻辑都清晰可见

UltraRAG 3.0 发布:拒绝“盲盒”开发,让每一行推理逻辑都清晰可见今天,清华大学 THUNLP 实验室、东北大学 NEUIR 实验室、OpenBMB 、面壁智能与 AI9Stars 联合发布 UltraRAG 3.0 ,针对上述痛点,为科研工作者与开发者打造更懂开发者的技术框架,具备 3 大核心优势:

来自主题: AI资讯

10651 点击 2026-01-24 15:14

今天,清华大学 THUNLP 实验室、东北大学 NEUIR 实验室、OpenBMB 、面壁智能与 AI9Stars 联合发布 UltraRAG 3.0 ,针对上述痛点,为科研工作者与开发者打造更懂开发者的技术框架,具备 3 大核心优势:

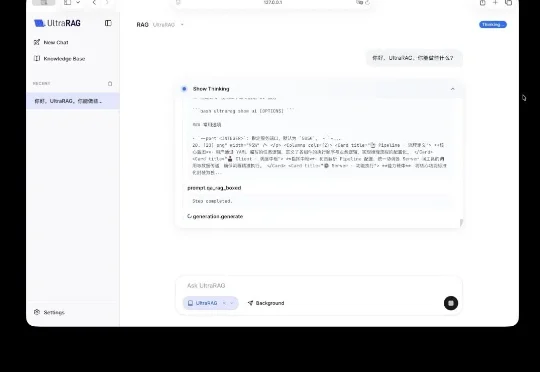

最新模型增量压缩技术,一个80G的A100 GPU能够轻松加载多达50个7B模型,节省显存约8倍,同时模型性能几乎与压缩前的微调模型相当。

两周前,OpenBMB开源社区联合面壁智能发布领先的开源大模型「Eurux-8x22B 」。相比口碑之作 Llama3-70B,Eurux-8x22B 发布时间更早,综合性能相当,尤其是拥有更强的推理性能——刷新开源大模型推理性能 SOTA,堪称开源大模型中「理科状元」。

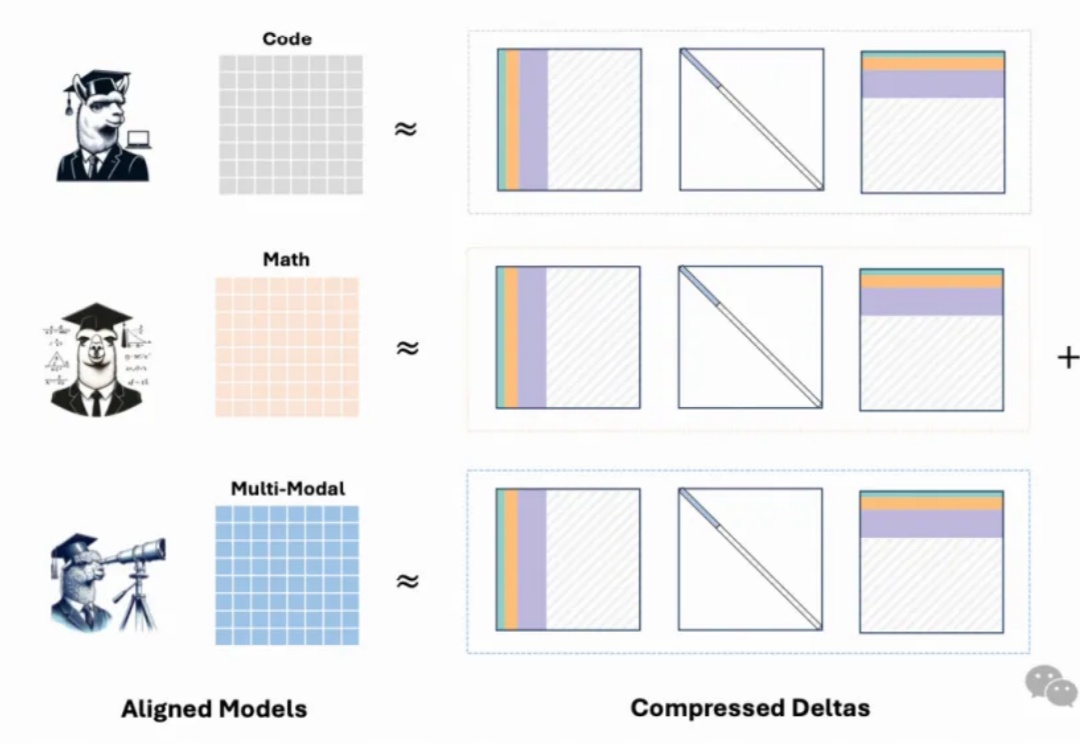

迄今,全球超 200 个模型基于来自 OpenBMB 开源社区的 Ultra Series 数据集(面壁 Ultra 对齐数据集)对齐,数据集包括 UltraFeedback 和 UltraChat,共计月均下载量超 100 万。

最近,NLP 大牛、HuggingFace联合创始人 Thomas Wolf 发了一条推特,内容很长,讲了一个 “全球三大洲的人们公开合作,共同打造出一个新颖、高效且前沿的小型 AI 模型” 的故事。