段永平,投了一家AI医疗!

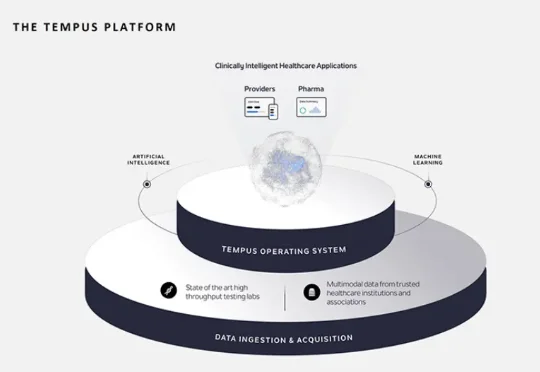

段永平,投了一家AI医疗!「中国巴菲特」段永平,押注AI医疗。 数据显示,段永平Q4买入了AI医疗公司Tempus AI,新进11万股。 段永平曾一手打造小霸王、步步高,还是OPPO、vivo的幕后奠基人;之后退居幕后转向投资

「中国巴菲特」段永平,押注AI医疗。 数据显示,段永平Q4买入了AI医疗公司Tempus AI,新进11万股。 段永平曾一手打造小霸王、步步高,还是OPPO、vivo的幕后奠基人;之后退居幕后转向投资

硬氪获悉,AI智能运动穿戴品牌「苔源MossCode」近日完成数千万元天使轮融资,本轮由XVC和清流资本共同投资。

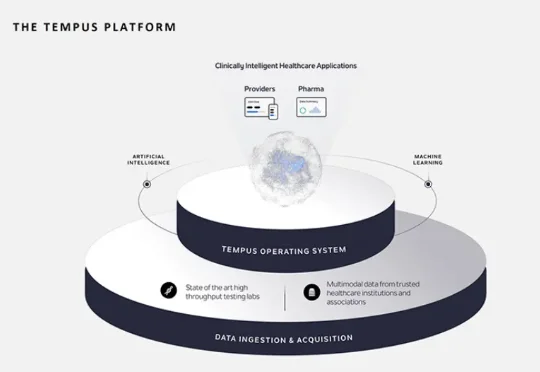

在当今的大模型后训练(Post-training)阶段,DPO(直接偏好优化) 凭借其无需训练独立 Reward Model 的优雅设计和高效性,成功取代 PPO 成为业界的 「版本之子」,被广泛应用于 Llama-3、Mistral 等顶流开源模型的对齐中。

全球人工智能(AI)热潮下,英国斯塔默政府在今年1月推出了雄心勃勃的“人工智能机遇行动计划”(AI Opportunities Action Plan),目标是成为“人工智能超级大国”。

AI 手机,做真正懂你的超级助理。

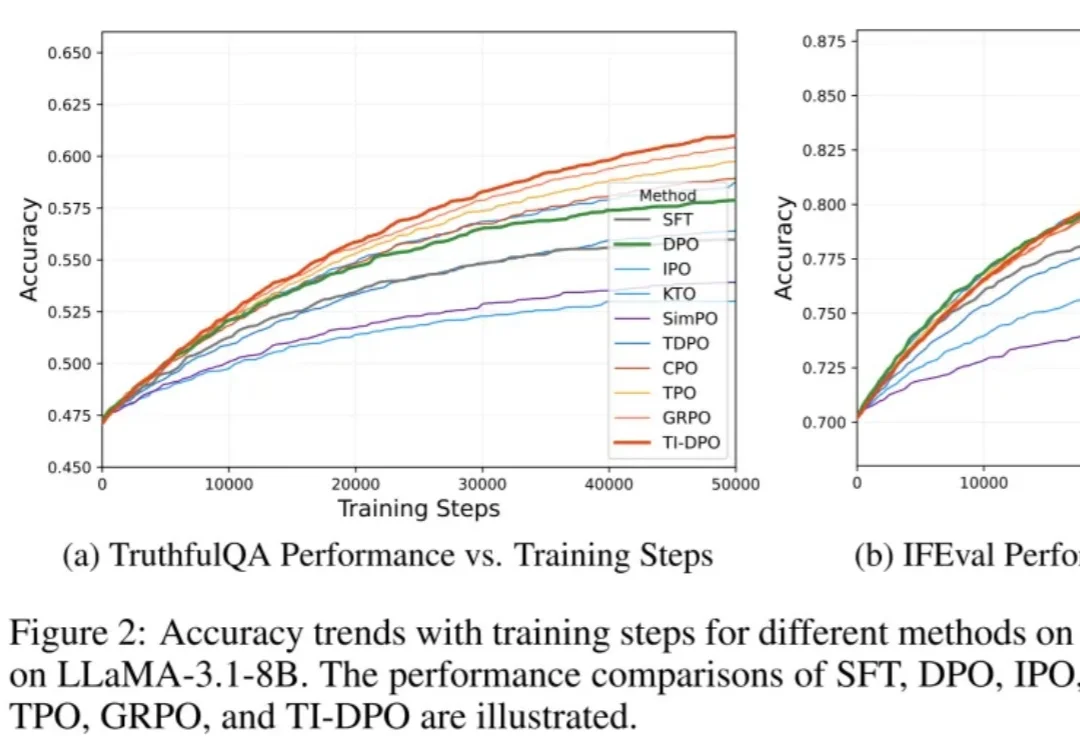

近日,由趣丸科技与北京大学软件工程国家工程研究中心共同发表的《Detecting Emotional Dynamic Trajectories: An Evaluation Framework for Emotional Support in Language Models(检测情感动态轨迹:大语言模型情感支持的评估框架)》论文,获 AAAI 2026 录用。

近期,阿里巴巴 ROLL 团队(淘天未来生活实验室与阿里巴巴智能引擎团队)联合上海交通大学、香港科技大学推出「3A」协同优化框架 ——Async 架构(Asynchronous Training)、Asymmetric PPO(AsyPPO)与 Attention 机制(Attention-based Reasoning Rhythm),

智东西11月4日消息,11月3日,美国生成式AI医疗独角兽Hippocratic AI宣布完成1.26亿美元(约合人民币8.97亿元)的C轮融资,谷歌母公司Alphabet旗下独立成长基金CapitalG参投。此轮融资也让该公司的估值达35亿美元(约合人民币249.24亿元),总融资额达到4.04亿美元(约合人民币28.77亿美元)。

当用户向大语言模型提出一个简单问题,比如「单词 HiPPO 里有几个字母 P?」,它却正襟危坐,开始生成一段冗长的推理链:

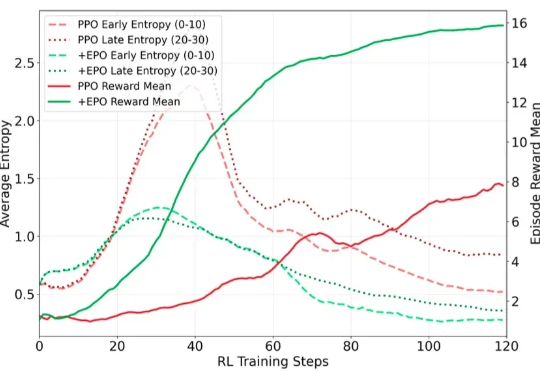

在训练多轮 LLM Agent 时(如需要 30 + 步交互才能完成单个任务的场景),研究者遇到了一个严重的训练不稳定问题:标准的强化学习方法(PPO/GRPO)在稀疏奖励环境下表现出剧烈的熵值震荡,导致训练曲线几乎不收敛。