Qwen负责人转发2025宝藏论文,年底重读「视觉领域GPT时刻」

Qwen负责人转发2025宝藏论文,年底重读「视觉领域GPT时刻」2025最后几天,是时候来看点年度宝藏论文了。

2025最后几天,是时候来看点年度宝藏论文了。

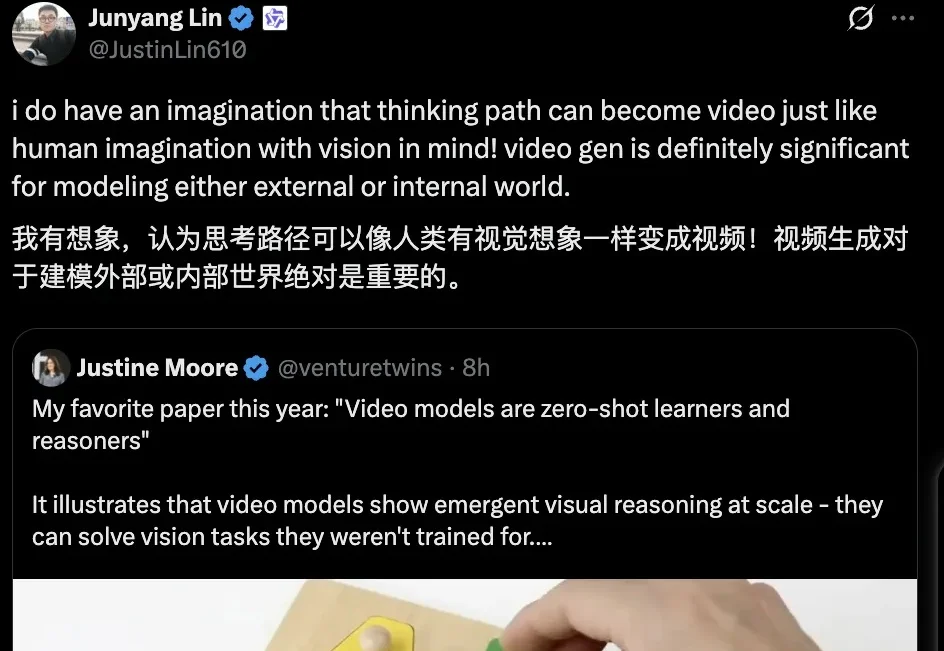

能翻译33语种+5方言,医学术语/粤语翻译实测“能打”。

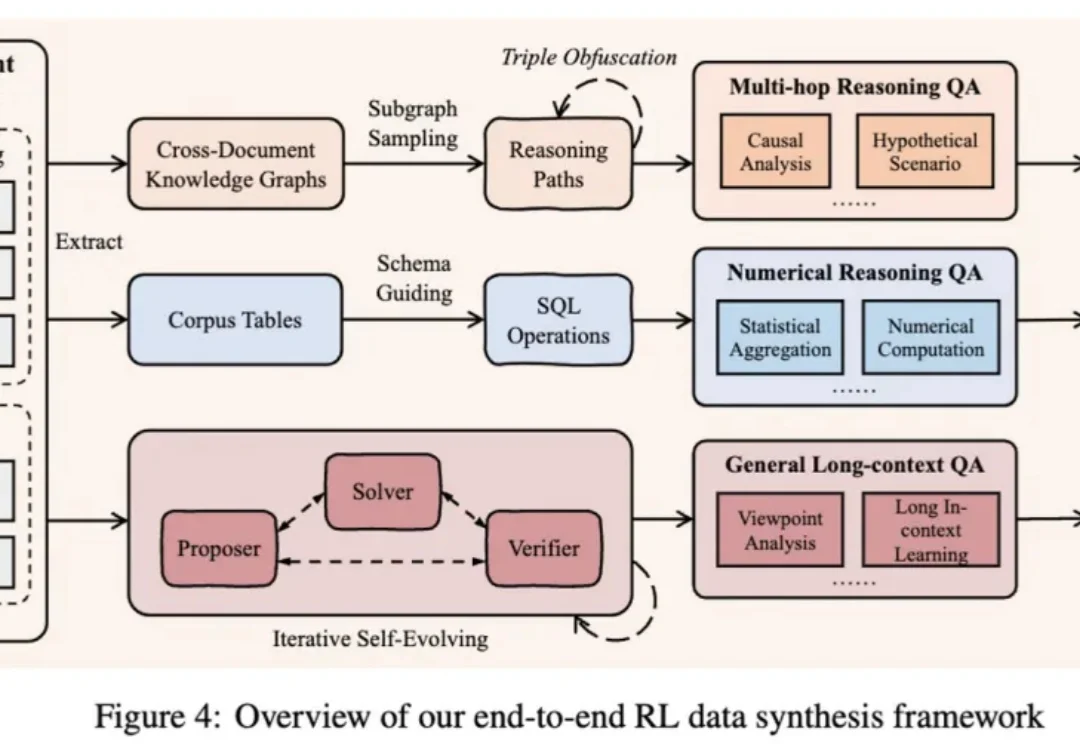

作为大模型从业者或研究员的你,是否也曾为一个模型的 “长文本能力” 而兴奋,却在实际应用中发现它并没有想象中那么智能?

太香了太香了,妥妥完爆ChatGPT和Nano Banana!

热门LoRA首次内置,控光换镜头实测可用。

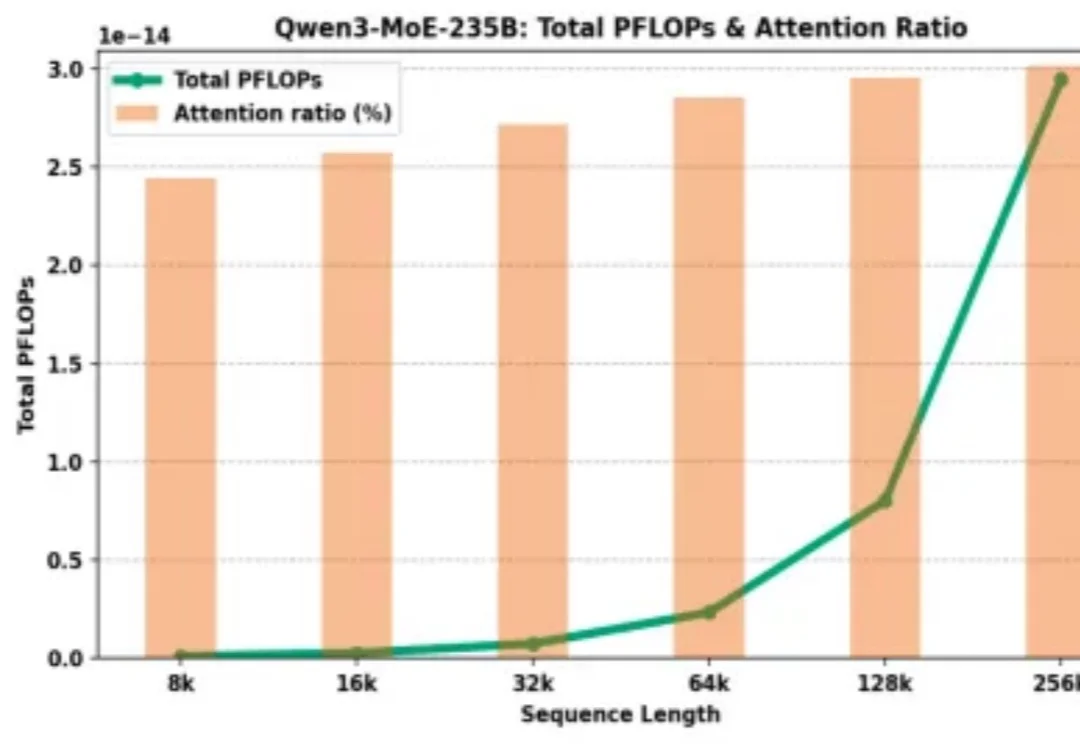

为什么大模型厂商给了 128K 的上下文窗口,却在计费上让长文本显著更贵?

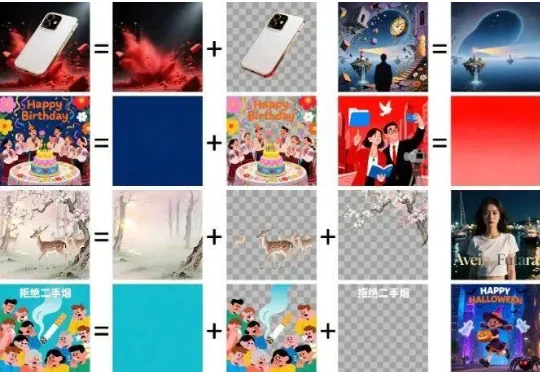

抽奖式的生图体验,确实让很多设计师在尝鲜之后又默默打开了 Photoshop。于是乎,阿里千问团队再次出手,开源了一个叫 Qwen-Image-Layered 的模型,试图从底层逻辑上解决这个问题。

我真栓Q了!围观了场狼人杀,看得我汗流浃背……

AI不仅会做PPT,写代码,它还能理解更深层次的问题。在美国的一项偏重于文化领域的新基准测试中,中国开源模型Qwen3夺冠,DeepSeek的R1跻身前六,力压多家全球顶级的明星模型。

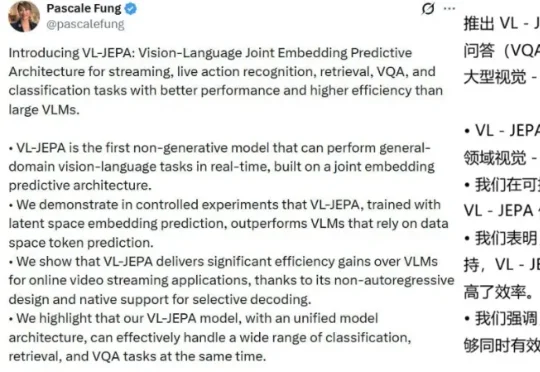

近日,来自 Meta、香港科技大学、索邦大学、纽约大学的一个联合团队基于 JEPA 打造了一个视觉-语言模型:VL-JEPA。据作者 Pascale Fung 介绍,VL-JEPA 是第一个基于联合嵌入预测架构,能够实时执行通用领域视觉-语言任务的非生成模型。